Die Wahl der richtigen Datenbankplattform gehört zu den wichtigsten Entscheidungen in der Softwareentwicklung und dem Betrieb moderner Anwendungen. In den letzten Jahren haben verteilte SQL-Datenbanken wie CockroachDB aufgrund ihrer Fähigkeit zur horizontalen Skalierung und hohen Verfügbarkeit deutlich an Popularität gewonnen. Doch speziell bei Unternehmen, deren Anforderungen sich im Laufe der Zeit verändern, können solche Systeme auch Nachteile mit sich bringen, etwa höhere Kosten oder Performance-Einbußen bei bestimmten Abfragen. Die Migration zurück zu klassischeren relationalen Datenbanken wie PostgreSQL wird deshalb für viele Unternehmen zu einer attraktiven Alternative. Ein exemplarischer Erfahrungsbericht eines Tech-Startups zeigt, worauf es bei so einem Wechsel wirklich ankommt und welche Aspekte besonders kritisch sind.

Der Start mit CockroachDB erfolgte für das Unternehmen Motion im Jahr 2022. Die Hauptgründe für diese Auswahl waren die nahtlose horizontale Skalierbarkeit, die hohe Verfügbarkeit vor allem in Multi-Region-Setups – ein nicht zu unterschätzendes Thema angesichts Datenschutzanforderungen wie der DSGVO – und eine SQL-kompatible Schnittstelle. Anfangs war man überzeugt, dass gerade bei künftig notwendigen regionalen Datenlokalisierungen die Vorteile eines verteilten Systems überwiegen würden. Mit dem Wachstum der Nutzerzahlen und gesteigerten Datenbankaktivitäten zeigte sich jedoch bald, dass die Kosten und einige technische Schwachstellen die Vorteile zunehmend überschatten.Bis 2024 hatte sich die Datenbankkostenrechnung verfünffacht und war in den mittleren sechsstelligen Bereich gestoßen.

Dabei war das Unternehmen bislang weit entfernt von der eigentlich angedachten Multi-Region-Strategie, denn alle Operationen fanden in einer einzigen Region statt und die Transaktionsvolumina waren moderat. Dies führte zwangsläufig zu der Frage: Warum die teurere, komplexere verteilte Datenbank weiterhin betreiben, wenn die Anforderungen auch mit einer traditionellen SQL-Datenbank abgedeckt werden können? Die Antwort lag in der Vielfalt der alltäglichen Probleme, die mit CockroachDB verbunden waren, insbesondere in Verbindung mit dem eingesetzten ORM Prisma.Migrationsprozesse gestalteten sich zunächst als zeitintensiv und fehleranfällig. Häufig kam es beim Ausführen von Schema-Migrationen zu Timeouts, weshalb viele Änderungen manuell auf der Datenbankebene eingespielt werden mussten. Diese manuelle Vorgehensweise blockierte nicht nur Deployments für Stunden, sondern führte auch zu angespannten Situationen in der Entwicklerteamarbeit.

Das Operations-Team musste zunehmend Kompromisse eingehen, um System-Locks und Ausfälle zu verhindern – teils wurden sicherheitsrelevante Best Practices missachtet, um den Betrieb aufrechtzuerhalten. Darüber hinaus erschwerte diese Situation selbst produktrelevante Updates der CockroachDB-Software, die noch auf einer veralteten und nicht mehr unterstützten Version verharrte.Auch im Bereich der ETL-Prozesse (Extract, Transform, Load) gab es erhebliche Probleme. Airbyte, eine wichtige Open-Source-ETL-Lösung, unterstützte CockroachDB zwar mit einem Connector, dieser war jedoch noch im Alpha-Stadium, instabil und litt unter einem Memory-Leak, der die Datenpipelines regelmäßig zum Erliegen brachte. Die Folge waren verzögerte oder ausgefallene Datenübertragungen sowie lange Downtimes und Performanceprobleme.

Ein zuverlässiges ETL-Ökosystem ist jedoch essenziell für moderne datengetriebene Unternehmen, was den Druck, eine stabilere Lösung zu finden, erhöhte.Interessant war die Beobachtung unterschiedlicher Query-Performances. Während einige Abfragen dank des CockroachDB-Query-Optimierers schneller ausgeführt wurden als unter PostgreSQL, litten viele gängige, komplexere Abfragen unter hohen Latenzen. Insbesondere die vom ORM Prisma generierten, oft convoluten SQL-Statements führten zu ineffizienten Full-Table-Scans, die bei CockroachDB noch stärker ins Gewicht fielen. Einzelne reale Abfragen zeigten dabei bis zu 20-fache Geschwindigkeitsvorteile unter PostgreSQL.

Die inzidente Überkomplexität der generierten Queries war ein häufig unterschätzter Faktor, der zu der Entscheidung beitrug, zurück auf PostgreSQL zu migrieren.Auch im Bereich der Entwicklererfahrung und des Managements traten Probleme auf. Das Monitoring und die Empfehlungssysteme von CockroachDB zeigten häufiger falsche oder unnötige Indizes an, was zu Verwirrung und suboptimalen Eingriffen führte. Das Abbrechen von laufenden Abfragen war komplizierter, weil in einem verteilten Cluster mehrere Knoten koordiniert werden müssen. Zudem gestaltete sich der Supportprozess umständlich, da verschiedene Portale nicht nahtlos integriert waren und Reaktionszeiten teilweise sehr lange dauerten.

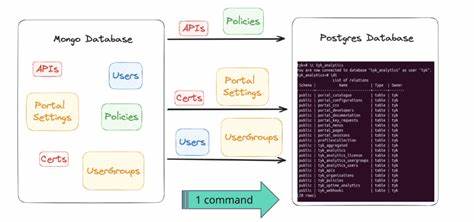

Netzwerkprobleme mit Tailscale und der direkten Anbindung an CockroachDB-Cluster führten zu sporadischen Verbindungsabbrüchen, die sich nicht zufriedenstellend beheben ließen.Der tatsächliche Migrationsprozess stellte eine Herausforderung dar, vor allem wegen der Größe der Datenbank. Mit rund 100 Millionen Datensätzen in der größten Tabelle war ein klassischer Daten-Dump und Restore durch ETL-Werkzeuge aufgrund der Instabilität der CockroachDB-Anbindungen nicht möglich. Die Eigenentwicklung einer maßgeschneiderten ETL-Lösung auf Basis von Bun, einer relativ neuen JavaScript-Laufzeit, bot eine praktikable Alternative. Dabei wurden Daten zunächst tabellenweise in CSV-Dateien exportiert, anschließend parallel pro Tabelle weiterverarbeitet, transformiert und in PostgreSQL eingespielt.

Ein entscheidendes Detail war die Berücksichtigung unterschiedlicher Kodierungen insbesondere bei JSON- und Array-Datentypen, die von CockroachDB anders gehandhabt werden als in PostgreSQL. Das erforderte eine individuelle Transformationslogik, um Datenkonsistenz sicherzustellen.Der finale Cutover wurde außerhalb der Hauptgeschäftszeiten durchgeführt, indem der Dienst in den Wartungsmodus versetzt wurde. Die eigentliche Migration verlief dabei überraschend schnell, ganze 15 Millionen Datensätze konnten innerhalb von rund 15 Minuten übertragen werden. Die kurze Downtime wurde bewusst großzügig bemessen, um unerwartete Probleme zu vermeiden und die Wiederanlaufphase kontrolliert zu gestalten.

Am Ende stand ein Datenbankbetrieb auf PostgreSQL, der sich durch unmittelbare Performanceverbesserungen auszeichnete. Die durchschnittliche Latenzzeit bei Kundenanfragen sank binnen kurzer Zeit um ein Drittel. Darüber hinaus konnten dank erweiterter Werkzeuge wie PGAnalyze zahlreiche ineffiziente Abfragen identifiziert und optimiert werden. Neben der technischen Verbesserung wirkte sich der Wechsel auch finanziell positiv aus: Die laufenden Kosten wurden um jährlich über 110.000 US-Dollar reduziert, was bei weiterem Wachstum potentiell noch stärker ins Gewicht fällt.

Dieser Praxisbericht zeigt exemplarisch, dass auch heutzutage und trotz aller Vorteile verteilter Datenbanklösungen klassische relationale Systeme wie PostgreSQL vielfach die bessere Wahl sein können. Insbesondere wenn der Fokus auf Stabilität, Kostenkontrolle, Entwicklerproduktivität und umfassendem Tooling liegt, lohnt sich eine genaue Überprüfung der eingesetzten Datenbanktechnologie. Darüber hinaus wird klar, dass ein erfolgreicher Wechsel nicht nur technisches Know-how, sondern auch eine sorgfältige Planung, maßgeschneiderte Migrationsstrategien und umfassende Tests erfordert. Unternehmen, die vor ähnlichen Herausforderungen stehen, finden hier eine wertvolle Orientierungshilfe und können von den Erkenntnissen profitieren.Abschließend lässt sich sagen, dass der Umstieg von CockroachDB auf PostgreSQL in vielen Fällen zu spürbaren Verbesserungen führen kann – sowohl in technischer als auch in wirtschaftlicher Hinsicht.

Die Migration ist kein trivialer Prozess, aber mit den richtigen Werkzeugen und einem klaren Vorgehen durchaus gut umsetzbar. Moderne SQL-ORMs, flexible ETL-Lösungen und ein wachsendes Ökosystem um PostgreSQL schaffen beste Voraussetzungen, damit Unternehmen auch bei steigenden Anforderungen langfristig performant, sicher und kosteneffizient arbeiten können. Die gewonnenen Erfahrungen zeigen zudem, dass eine bewusste und pragmatische Entscheidung für die richtige Datenbanktechnologie ein entscheidender Wettbewerbsfaktor sein kann.