In der heutigen Softwareentwicklung nimmt die asynchrone Programmierung einen immer wichtigeren Platz ein. Dies liegt hauptsächlich daran, dass moderne Anwendungen häufig auf I/O-Operationen angewiesen sind – sei es beim Zugriff auf Datenbanken, Netzwerkkommunikation oder Dateisysteme. Während die Hardware stetig schneller wird, bestehen diese Interaktionen meist aus Wartezeiten, die durch physikalische Grenzen wie Latenzen entstehen. Daher gewinnt die effiziente Handhabung von Wartephasen zunehmend an Bedeutung, um Systeme ressourcenschonend und performant zu gestalten. Traditionell läuft Code sequenziell innerhalb eines einzelnen Threads.

Wenn jedoch beispielsweise eine Festplatte gelesen wird oder eine Netzwerkanfrage gestellt wird, verbringt ein Thread oft viel Zeit in einem Zustand, in dem er scheinbar nichts tut – er wartet auf das Ende der jeweiligen Operation. Klassische Methoden, wie das explizite Aufrufen von Thread.sleep(), blockieren dabei den Thread für eine bestimmte Zeitspanne, was unnötige Ressourcen bindet und die Anwendungsperformance beeinträchtigen kann. Um diese Ineffizienz zu umgehen, setzen Programmierer häufig auf parallele Verarbeitung mittels Threads und Thread-Pools. Während einzelne Threads lange blockieren würden, erlauben Thread-Pools, die Anzahl der gleichzeitig laufenden Threads zu kontrollieren und vermeidbare Kosten durch ständiges Erzeugen und Zerstören von Threads zu minimieren.

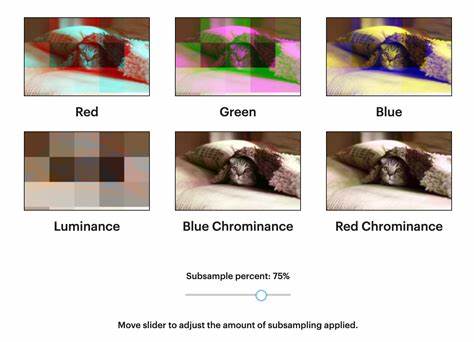

Dennoch gibt es weiterhin eine Grenze, da bei jeder blockierenden Operation ein Thread unnötig belegt wird – was insbesondere bei einer großen Anzahl gleichzeitiger asynchroner Operationen problematisch wird. Hier kommt das Konzept der Event Loops ins Spiel, welches vor allem aus der Welt der asynchronen Frameworks bekannt ist. Event Loops ermöglichen es, Operationen nichtblockierend ablaufen zu lassen, indem sie Wartezustände nicht durch Stillstand eines Threads, sondern durch das Registrieren von Callback-Events oder Nachrichten modellieren. Eine zentrale Idee ist die Trennung zwischen reaktiven Event-Handlern, die nur dann aktiv werden, wenn ein Ereignis eintritt, und der abwartenden Infrastruktur, die in der Zwischenzeit keine CPU-Zeit verbraucht. Auf Betriebssystemebene werden für diese Art von Wartezeiten oft spezielle Systemaufrufe wie epoll_wait oder io_uring genutzt, die einen Thread effizient blockieren und erst bei bestimmten Ereignissen wie dem Eintreffen einer Nachricht oder dem Abschluss einer Netzwerkoperation wieder aufwecken.

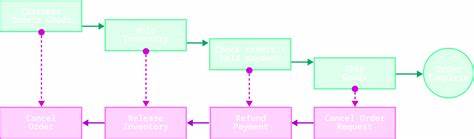

Dadurch reduziert sich der Energieverbrauch und die CPU-Ressourcen können für andere Aufgaben freigegeben werden. Bei hohen Lasten oder komplexen Anwendungen entstehen jedoch weitere Herausforderungen: Entwickler müssen die Logik der Verknüpfung und Koordination der asynchronen Operationen sorgfältig gestalten. Rechnerische Operationen, Netzwerkzugriffe und Speicheroperationen müssen orchestriert werden, ohne dass durch verschachtelte Callbacks oder komplizierte Rückrufketten der Code unleserlich wird. In der Java-Welt wurde dafür das Future-Konzept etabliert. Es bietet eine abstrahierte Schnittstelle, die es erlaubt, „zukünftige“ Ergebnisse asynchron zu liefern und darauf zu reagieren.

Entwickler können mit Futures Callback-Funktionen registrieren oder Ergebnisse blockierend abfragen – letzteres sollte jedoch möglichst vermieden werden, um eine Entwicklung hin zu vollständig nichtblockierenden Systemen zu fördern. Die Handhabung von Futures bringt dank Konzepten wie CompletableFuture mehr Flexibilität, doch der Code bleibt oftmals komplex und verschachtelt, was die Wartbarkeit erschwert. Scala versuchte dieses Problem mit sogenannten for-Comprehensions zu adressieren. Diese abstrakte Syntax ermöglicht es, asynchrone Operationen nahezu wie sequenzielle Abläufe zu schreiben und so die Lesbarkeit zu verbessern. Trotzdem bleiben einige Einschränkungen bestehen: Bedingte Abläufe, frühe Rückgaben oder elegante Fehlerbehandlung sind weiterhin schwierig umzusetzen, da die asynchrone Struktur des Codes der grundlegenden Sprachebene angepasst werden muss.

Das Verstehen und Schreiben asynchroner Logik bleibt daher eine Herausforderung. Ein bedeutender Fortschritt in der asynchronen Programmierung kommt durch die Einführung von Coroutinen, wie sie insbesondere in der Programmiersprache Kotlin umgesetzt wurden. Coroutinen sind leichtgewichtige, vom Runtime verwaltete Ausführungseinheiten, die im Gegensatz zu Betriebssystem-Threads nicht vom Scheduler präemptiv unterbrochen, sondern kooperativ ausgeführt werden. Das bedeutet, dass sie selbst bestimmen, wann sie die Ausführung unterbrechen und einem anderen Codeblock die Kontrolle übergeben. Dabei integriert Kotlin Coroutinen tief in das Sprachdesign.

Mit der Schlüsselwortfunktion suspend können Entwickler asynchrone Operationen wie reguläre sequenzielle Logik schreiben. Dabei wird der Code im Hintergrund so aufgeteilt und ausgeführt, dass der eigentliche ausführende Thread während Wartezeiten nicht blockiert wird. Dies führt zu sehr lesbarem und wartbarem Code, der dennoch hoch performant arbeitet und die Vorteile von Event Loops und nicht blockierenden Operationen nutzt. Durch Coroutinen entfällt der Einsatz komplexer Callback-Ketten oder der manuelle Umgang mit Futures für viele Anwendungsfälle. Außerdem bieten Coroutinen flexible Möglichkeiten zur Steuerung von Parallelität und Nebenläufigkeit.

So erlaubt Kotlin neben der sequentiellen Asynchronität – bei der Operationen nacheinander, aber nicht blockierend ausgeführt werden – auch explizite parallele Ausführung mittels spezieller Konstrukte wie async/await. Damit wird es für Entwickler möglich, situationsbedingt zwischen unterschiedlichen Ausführungsmodi zu wählen, je nachdem, ob möglichst viele Operationen schnell hintereinander abgearbeitet werden sollen oder ob eine parallele Verarbeitung erforderlich ist. Dabei erfolgt die Steuerung auf hohem Abstraktionsniveau, was die Entwicklung vereinfacht und Fehlerquellen verringert. Einen Schritt weiter geht das Konzept der impliziten Parallelität. Hierbei können theoretisch unabhängige Operationen gleichzeitig gestartet und in beliebiger Reihenfolge abgearbeitet werden, ohne dass die Programmlogik dies explizit anordnet.

Die zugrunde liegende Laufzeitumgebung übernimmt selbstständig die optimale Verteilung und Synchronisation. Allerdings bringt dieses Modell auch Risiken wie unerwartete Race Conditions mit sich, sodass Entwickler besondere Vorsicht walten lassen müssen. Im Moment ist implizite Parallelität noch nicht weit verbreitet und bedarf einer gründlichen Prüfung, bevor sie großflächig eingesetzt wird. Neben Kotlin sind auch andere Sprachen und Frameworks ihren eigenen Weg gegangen, um asynchrone Programmierung zu verbessern. Die bekannte JavaScript-Welt bietet zum Beispiel async/await an, das viele Herausforderungen der Verschachtelung löst und asynchronen Code fast so einfach lesbar macht wie synchronen.

Sprachen wie Go nutzen Goroutinen, die ähnlich zu Coroutinen sind, aber etwas anderes Runtime-Verhalten besitzen und eine einzigartige Kombination aus Systemintegration und Nutzerfreundlichkeit bieten. Ebenfalls spielt Rust mit Tokio eine immer größer werdende Rolle bei hochperformanten und sicheren asynchronen Anwendungen. Was alle diese Entwicklungen eint, ist das Ziel, die immer längeren Wartezeiten durch Netzwerk oder I/O bei moderner Software effizienter zu nutzen und für Entwickler gleichzeitig eine nahtlose und fehlerarme Programmiererfahrung zu schaffen. Die Evolution von einfachen Threads hin zu komplexen Event-Loop-Systemen und flexiblen Sprachfeatures zeigt, wie stark sich Programmierparadigmen an die Bedürfnisse moderner Hardware- und Softwareinfrastrukturen anpassen. Insgesamt lässt sich feststellen, dass asynchrone Programmierung heute nicht mehr nur eine Möglichkeit zur Effizienzsteigerung darstellt, sondern ein elementarer Bestandteil moderner Softwarearchitektur ist.

Entwicklern steht eine breite Palette von Werkzeugen und Ansätzen zur Verfügung – vom klassischen Future-Modell über Event Loops bis hin zu Coroutinen und impliziter Parallelität –, die je nach Anwendungsszenario geschickt kombiniert werden können. Dabei wird der Trend zu immer höherer Abstraktion bei gleichzeitiger Leistungsfähigkeit weiter voranschreiten. Für Softwareingenieure und Entwickler bedeutet dies, dass ein fundiertes Verständnis der zugrunde liegenden Konzepte sowie die Kenntnis moderner Sprachfeatures unverzichtbar sind, um zukunftsfähige Anwendungen zu realisieren. Wer die Herausforderungen der asynchronen Programmierung meistert und die neuesten Paradigmen anwendet, kann Software schreiben, die nicht nur performant, sondern auch wartbar und skalierbar ist – und dabei die volle Leistungsfähigkeit moderner Systeme optimal ausnutzt.