Die Forschung im Bereich der Künstlichen Intelligenz hat in den letzten Jahren enorme Fortschritte gemacht, insbesondere durch die Entwicklung großer Sprachmodelle. Modelle wie GPT-3 haben mit ihrer Fähigkeit, auf beeindruckende Weise menschenähnlichen Text zu erzeugen, weltweit für Aufsehen gesorgt. Obwohl GPT-3 selbst noch keine Allgemeine Künstliche Intelligenz (AGI) ist, markiert es einen bedeutenden Schritt in Richtung eines Systems, das nicht nur für spezifische Aufgaben, sondern in vielen Bereichen denkbar flexibel und mächtig agieren kann. AGI beschreibt eine Maschine, die in der Lage ist, intellektuelle Aufgaben zu bewältigen, die Menschen ausführen, und dabei flexibel und adaptiv auf verschiedene Situationen reagiert. Der Schlüssel zu dieser Vision liegt im Verständnis und der Nachbildung komplexer Weltmodelle, die auch menschliches Denken und Verhalten erfassen können.

Das besondere Potenzial von Sprachmodellen liegt darin, dass natürliche Sprache als äußerst ausdrucksstarke Darstellung der realen Welt fungiert. Während spezialisierte KI-Systeme wie AlphaGo oder Deep Blue in nur einem sehr engen Aufgabenfeld außergewöhnlich gut sind, offenbaren Sprachmodelle aufgrund der enormen Bandbreite und Tiefe der Sprachinformationen ein umfassenderes Weltverständnis. Die Fähigkeit, Sprache zu verstehen und vorherzusagen, eröffnet ein Fenster, um implizites Wissen und logische Zusammenhänge zu modellieren, die Menschen in ihrer Kommunikation verwenden. Ein zentrales Element bei der Entwicklung von Sprachmodellen ist die Optimierung der Vorhersagegenauigkeit für das nächste Wort in einem Text. Dieses Ziel mag auf den ersten Blick simpel erscheinen, doch dahinter verbirgt sich eine Herausforderung, die von der reinen Rechtschreibung über grammatikalische Korrektheit bis hin zu tief greifenden semantischen und logischen Konsistenzen reicht.

Je mehr Modelle darin trainiert werden, diese Feinheiten der Sprache zu erfassen, desto weiter entfernen sie sich von oberflächlichen Textmustern hin zu einem echten Verständnis der Inhalte und der Welt, die darin beschrieben wird. Der Verlustwert eines Modells, der beschreibt, wie präzise es Vorhersagen treffen kann, nähert sich mit steigender Modellgröße und Trainingsdatenmenge theoretisch dem sogenannten Shannon-Entropie-Limit. Dieses Limit stellt die minimale Zahl an Bits dar, die im Durchschnitt benötigt wird, um natürliche Sprache präzise zu beschreiben, da Sprache eine gewisse inherente Unvorhersehbarkeit besitzt. Werden Modelle immer größer und besser darin, die statistischen Eigenschaften von Sprache zu erfassen, entfalten sie zugleich eine immer genauere Repräsentation der Welt, wie sie in Texten reflektiert wird. Diese Entwicklung unterstreicht, dass das eigentliche Lernen über Grammatik und Einfachstruktur hinausgeht und sich hin zu echten Weltmodellen erweitert, die Vorhersagen und logisches Denken einschließen.

Dennoch ist das Erreichen dieses Ideals keine leichte Aufgabe. Trotz beeindruckender Leistungen ist GPT-3 noch nicht perfekt in der Modellierung komplexer Kausalzusammenhänge oder bei der konsequenten Nachverfolgung von Zielen über längere Dialoge oder Interaktionsketten hinweg. Kritiker weisen darauf hin, dass der bloße Ausbau von Parametern nicht zwangsläufig zu einer signifikanten Verbesserung in allen Aspekten führt. Die Prognose, dass mit bahnbrechenden Modellen mit einer Billion von Parametern und mehr eine erhebliche Verbesserung einsetzt, bleibt eine Vermutung, die sich erst empirisch bestätigen muss. Sollte dies allerdings eintreten, könnten solche Modelle tatsächlich Fähigkeiten entwickeln, die das menschliche durchschnittliche Verständnis über verschiedene Themen hinweg erreichen oder sogar übertreffen.

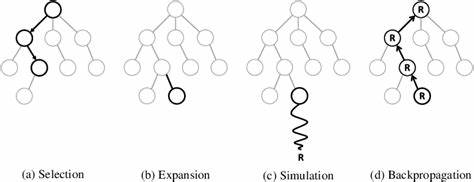

Um aus einem bloßen Weltmodell einen echten Agenten zu machen, ist es notwendig, nicht nur zu wissen, wie die Welt funktioniert, sondern auch Ziele zu verfolgen und Handlungsschritte zu planen, die diese Ziele voranbringen. In klassischen KI-Systemen wird dies oft durch sogenannte Ziel- oder Belohnungsfunktionen umgesetzt. Die Herausforderung besteht darin, dass reine Sprachmodelle dann nicht nur Wahrscheinlichkeiten für das nächste Wort vorhersagen, sondern auch Strategien entwickeln müssen, um erwünschte Resultate in der realen Welt zu erzielen. Indem man das Weltmodell fragt, welche Handlungen unter gegebenen Bedingungen möglich sind, und wie sich verschiedene Handlungsfolgen auf die Zielerreichung auswirken, kann man eine Art Entscheidungssystem aufbauen, das Aktionen bewertet und auswählt. Dieses Vorgehen erinnert an Techniken wie Monte Carlo Tree Search, die in der Spieltheorie und Entscheidungsfindung verwendet werden, um durch das Simulieren möglicher Folgen den optimalen nächsten Schritt zu bestimmen.

Sprachmodelle eignen sich aufgrund ihrer Flexibilität besonders gut, komplexe, abstrakte sowie hierarchisch strukturierte Handlungspläne zu erzeugen und diese in kleinere Teilziele zu untergliedern. Auf diese Weise kann ein Agent sehr komplexe Tätigkeiten ausführen, indem er sie in verständliche, nacheinander auszuführende Einzelschritte zerlegt. Die Darstellung des aktuellen Zustands eines Agenten erfolgt ebenfalls über natürliche Sprache, was den Vorteil hat, dass die Informationen leicht komprimiert, interpretiert und angepasst werden können. So kann das Modell wichtige Fakten zusammenfassen und Unwichtiges ausblenden, um die begrenzte Kapazität optimal zu nutzen. Ein wichtiger Aspekt ist die Einbindung vielfältiger Inputquellen in den Agenten.

Während Sprachmodelle ursprünglich nur mit Text funktionieren, sind Erweiterungen denkbar, die visuelle Informationen über Systeme wie iGPT oder andere multimodale Ansätze in Textform übersetzen, sodass der Agent auch mit Bildern, Webseiteninhalten oder anderen Formen von Daten umgehen kann. Ebenso vielfältig sind die Möglichkeiten für Ausgabemodalitäten, die sich von reinen Textantworten über ausführbaren Code bis hin zu Tastatureingaben oder Systembefehlen erstrecken. All diese Technologien schaffen ein Framework, das eine ganzheitliche Interaktion mit der realen Welt ermöglicht. Trotz all dieser theoretischen Möglichkeiten befindet sich die Forschung rund um das Thema AGI und Sprachmodelle derzeit noch im experimentellen Stadium. Die meisten Konzepte fußen auf mehreren Annahmen, vor allem, dass zukünftige Modelle durch Skalierung tatsächlich signifikante Verbesserungen in der Weltmodellierung erzielen können.

Sollte dies nicht der Fall sein, sind alternative Ansätze oder ergänzende Methoden nötig, um AGI zu erreichen. Gleichwohl bietet die Idee, natürliche Sprache als universelles Medium zu nutzen, um komplexe Weltzustände und Entscheidungen zu modellieren, eine realistische und vielversprechende Perspektive. Sprachmodelle könnten somit zu den Kernkomponenten der nächsten KI-Generation zählen und ein konkreter Weg hin zu proto-AGI-Systemen sein – Agenten, die bereits Vorstufen allgemeiner Intelligenz besitzen und für vielfältige Aufgaben anwendbar sind. In der Zukunft könnte der Fortschritt in der Sprachmodellierung erhebliche gesellschaftliche Veränderungen bewirken, angefangen bei optimierten virtuellen Assistenten über automatisiertes wissensbasiertes Arbeiten bis hin zu autonomen Systemen mit adaptiven, proaktiven Fähigkeiten. Abschließend lässt sich sagen, dass die Verbindung von Sprachmodellen und Weltwissen eine zentrale Rolle in der Vision der AGI spielt.

Indem Sprache als Schnittstelle fungiert, über die komplexe Informationen kodiert und angewendet werden können, eröffnet sich der Weg zu Agenten, die nicht nur menschliche Sprache imitieren, sondern auch tiefgehendes Verständnis entwickeln und zielgerichtet handeln können – ein Meilenstein auf dem Weg zur Allgemeinen Künstlichen Intelligenz.