In der digitalen Ära sind Computer und Software nahezu allgegenwärtig, und der Umgang mit Zahlen bildet einen essenziellen Teil fast aller Anwendungen. Dabei spielt die sogenannte Floating-Point-Mathematik eine bedeutende Rolle. Obwohl sie grundlegend für die Berechnung mit Dezimalzahlen in Computern ist, führt sie häufig zu unerwarteten und manchmal verblüffenden Ergebnissen. Viele Programmierer stoßen auf das berühmte Problem, dass 0,1 plus 0,2 nicht genau 0,3 ergibt, sondern ein minimal abweichendes Ergebnis, wie 0,30000000000000004. Dieses Phänomen ist keine Fehlfunktion der Programmiersprache, sondern das Ergebnis der zugrundeliegenden Art und Weise, wie Computer Zahlen speichern und berechnen.

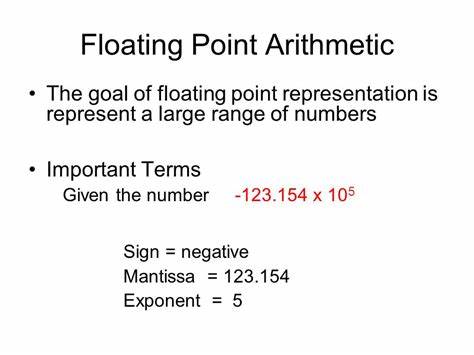

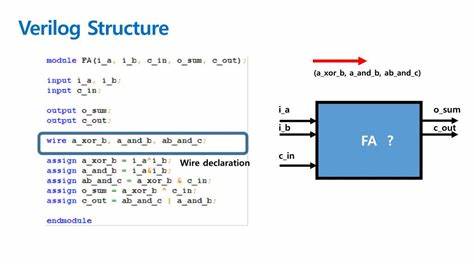

Um diese Problematik zu verstehen, lohnt sich ein genauer Blick auf die Grundlagen der Floating-Point-Arithmetik und ihre Implikationen für Entwickler und technikbegeisterte Nutzer. Computer speichern Zahlen in einem binären System, das auf den Ziffern 0 und 1 basiert. Im Gegensatz zum menschlichen Dezimalsystem mit Basis 10 verwenden Maschinen das Binärsystem mit Basis 2. Diese Umstellung bringt gewisse Herausforderungen mit sich, insbesondere wenn es um die Darstellung von Brüchen geht. Im Dezimalsystem können Brüche, deren Nenner ausschließlich die Primfaktoren 2 und 5 enthalten, exakt dargestellt werden, wie zum Beispiel 1/2, 1/5 oder 1/10.

Andere Brüche wie 1/3 oder 1/7 erscheinen hingegen als unendliche, periodische Dezimalzahlen, welche abgekürzt werden müssen. Im binären System jedoch ist lediglich die Primzahl 2 als Faktor gültig, weshalb z.B. 1/2, 1/4 oder 1/8 exakt repräsentiert werden können, während Brüche wie 1/5 oder 1/10 wieder unendliche periodische binäre Brüche erzeugen. Diese Eigenschaft führt dazu, dass viele Zahlen, die wir als einfache Dezimalzahlen kennen und wahrnehmen, im Computer intern nicht exakt gespeichert werden können.

Stattdessen werden Näherungswerte abgelegt, die sehr präzise, aber eben nicht vollkommen exakt sind. Wenn der Rechner nun mathematische Operationen durchführt, wie etwa die Addition von 0,1 und 0,2, summieren sich die kleinen Ungenauigkeiten zu einem Ergebnis, das minimal vom exakten Wert abweicht. Diese sogenannten Rundungsfehler sind jedoch in den meisten praktischen Anwendungen vernachlässigbar, da die Differenzen meistens erst ab der 15. bis 17. Nachkommastelle auftreten – eine Präzision, die weit über die Anforderungen vieler Programme hinausgeht.

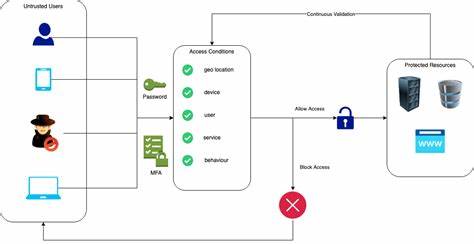

Der internationale Standard IEEE 754 definiert das Vorgehen bei Floating-Point-Arithmetik für die meisten modernen Computersysteme. Dieses Regelwerk beschreibt nicht nur das Format zur Speicherung von Gleitkommazahlen (Floating-Point-Zahlen), sondern auch die Art der Rundung und Sonderfälle wie Unendlichkeiten oder die Darstellung von NaN (Not a Number). Dank dieses Standards können Entwickler und Hardwarehersteller sicher sein, dass grundlegende Operationen auf verschiedenen Plattformen vergleichbare Ergebnisse liefern. Dennoch bleibt das grundlegende Problem der begrenzten Repräsentation bestehen. Um den Umgang mit Fließkommazahlen in der Praxis zu erleichtern, bieten viele Programmiersprachen erweiterte Datentypen und Bibliotheken an.

Beispielsweise existieren in Sprachen wie C# oder Python Datentypen für dezimale Zahlen, die eine exaktere Darstellung insbesondere für monetäre Berechnungen ermöglichen. Der Unterschied zu den üblichen Fließkommazahlen besteht darin, dass diese Dezimaltypen nicht binär, sondern auf einer Basis von zehn arbeiten und so die üblichen „krummen“ Werte vermeiden können. Somit sind Rechenoperationen präziser, wenn der Anwendungsfall eine hohe Genauigkeit bei Dezimalstellen erfordert. Programmiersprachen und Frameworks haben teilweise unterschiedliche Herangehensweisen ans Problem. Während JavaScript beispielsweise nur den Datentyp Number verwendet, der auf zweifacher Genauigkeit (double precision) basiert und damit ähnliche Rundungsfehler aufweist, bieten Sprachen wie C# oder Java mit BigDecimal bzw.

Decimal präzisere Alternativen. Diese sind allerdings meistens mit einem höheren Rechenaufwand verbunden, da die Umsetzung softwareseitig erfolgt und nicht direkt auf Hardwareebene unterstützt wird. Entwickler müssen sich dieser Grenzen bewusst sein, vor allem wenn es um sicherheitskritische oder finanzielle Anwendungen geht. Einige Strategien zur Vermeidung von Fehlern bei Floating-Point-Berechnungen umfassen das Runden auf eine bestimmte Anzahl von Dezimalstellen, das Verwenden von Ganzzahlarithmetik (zum Beispiel Berechnungen in Cent statt Euro) oder das Arbeiten mit rationalen Zahlen, die exakt als Brüche dargestellt werden können. Für wissenschaftliche Berechnungen wiederum sind Floating-Point-Arithmetik und die zugrunde liegenden Grenzen akzeptierte Standards, und Experten gleichen eventuelle Abweichungen mittels spezieller Algorithmen und Fehlerabschätzungen aus.

Die Faszination der Floating-Point-Mathematik liegt auch daran, dass sie tief in der Zahlentheorie und den Eigenschaften von Zahlensystemen verwurzelt ist. Das Verständnis, warum manche Zahlen im Computer „nicht sauber“ dargestellt werden, eröffnet Perspektiven auf die Grundlagen der Informationsverarbeitung. Die Tatsache, dass einfache Operationen wie 0,1 plus 0,2 zu überraschenden Ergebnissen führen können, hat auch eine pädagogische Wirkung und sensibilisiert Programmierer dazu, sich eingehender mit der Datenrepräsentation ihrer Programme auseinanderzusetzen. Außerdem haben sich im Laufe der Jahrzehnte viele nützliche Tools, Bibliotheken und Hilfsmittel entwickelt, die Floating-Point-Probleme adressieren. Universitäten, Forschungsgruppen und die Open-Source-Community haben unzählige Lösungen bereitgestellt, die von einfacher Rundung bis hin zu exakten rationalen Zahlentypen reichen.

Programmiersprachen wie Haskell, Rust oder Julia bieten standardmäßig oder über Bibliotheken Unterstützung für rationale und multipräzise Berechnungen an und erweitern damit die Möglichkeiten der Datenverarbeitung. Trotz der mathematischen Grundlagen darf man nicht vergessen, dass Floating-Point-Mathematik ein Produkt technischer Entwicklung ist, welches eine Balance zwischen Mächtigkeit und Performance darstellt. Ein vollständig exaktes Dezimalsystem in der Computerkunst wäre für die meisten Anwendungen zu langsam und ressourcenintensiv. Die aktuellen Fließkommazahlen sind daher ein pragmatischer Kompromiss, der für die breite Masse der Anwendungen optimal geeignet ist. Zusammenfassend lässt sich sagen, dass Floating-Point-Mathematik ein unverzichtbares Konzept in der Programmierung und Computertechnik darstellt.

Die Besonderheiten und Limitationen sind tief mit dem Binärsystem und der Repräsentation von Zahlen verbunden. Programmierer sollten die Auswirkungen kennen und passende Techniken anwenden, um unerwartete Resultate zu vermeiden oder korrekt zu interpretieren. Die ständige Weiterentwicklung der Programmiersprachen und Rechenmodelle zeigt, wie relevant dieses Thema für die Zukunft der digitalen Welt ist. Durch ein solides Verständnis der Floating-Point-Arithmetik gelangt man zu saubereren, sichereren und verlässlicheren Anwendungen, die den Anforderungen moderner Softwareentwicklung gerecht werden.