In der heutigen digitalen Welt, in der Cloud-Dienste und datenintensive Anwendungen zunehmend an Bedeutung gewinnen, rückt ein flexibles und transparentes Abrechnungsmodell für Unternehmen immer mehr in den Fokus. Ein nutzungsbasiertes Abrechnungssystem bietet hier eine Möglichkeit, die Kosten exakt an den tatsächlichen Verbrauch von Ressourcen anzupassen. Dieses Modell trägt nicht nur zur Kosteneffizienz bei, sondern schafft auch Vertrauen zwischen Anbieter und Kunde, indem klare, nachvollziehbare Preise mit der tatsächlichen Nutzung verknüpft werden. Die Implementierung eines solchen Systems ist jedoch mit erheblichen technischen und organisatorischen Herausforderungen verbunden, die es zu bewältigen gilt. Im Folgenden werden die wesentlichen Aspekte eines nutzungsbasierten Abrechnungssystems eingehend beleuchtet, um sowohl technische Fachleute als auch Entscheidungsträger bei der erfolgreichen Umsetzung zu unterstützen.

Ein zentrales Element eines nutzungsbasierten Abrechnungssystems ist die präzise Erfassung der relevanten Nutzungsmetriken. Bei datenbankenbasierten Systemen stehen oft die Anzahl der Lese- und Schreiboperationen sowie der belegte Speicherplatz im Mittelpunkt. Die Messung dieser Kennzahlen muss in Echtzeit oder zumindest mit hoher Aktualität erfolgen, um eine möglichst genaue Abrechnung zu gewährleisten und Kunden eine verlässliche Kostenvorhersage zu ermöglichen. Der Ansatz, den die innovative Datenbanklösung Chroma verfolgt, zeigt exemplarisch, wie sich diese Anforderungen technisch realisieren lassen. Dabei wird der Verbrauch auf drei Hauptdimensionen abgebildet: Reads, Writes und Storage.

Reads umfassen die Menge an Daten, die aus dem Speicher geladen und über Abfragen zurückgegeben werden. Writes beziehen sich auf das Volumen der geschriebenen Daten, während Storage die tatsächlich belegte Speicherkapazität über die Zeit misst, meist in GB-Monaten. Die Herausforderung besteht darin, eine Methode zu entwickeln, die selbst bei komplexen und hochskalierenden Architekturen eine genaue und effiziente Erfassung der Nutzung sicherstellt. Bei Chroma wurden dafür beispielsweise sogenannte Events eingeführt, die jede nutzbare Aktion exakt dokumentieren. Diese Events enthalten Metadaten darüber, wer welche Ressource wann und in welchem Umfang verwendet hat.

Durch Aggregation dieser Daten lässt sich anschließend der Gesamtverbrauch über definierte Zeiträume zuverlässig bestimmen. Technisch wird diese Erfassung durch eine kontinuierliche Verarbeitung dieser Events unterstützt, die schließlich in einem zentralen Objektspeicher gesammelt werden, von wo aus sie für die Abrechnung weiterverarbeitet werden. Die Messung der Reads und Writes erfolgt dabei auf der API-Ebene, wo jede Kundenanfrage detailliert protokolliert wird. Neben dem Zeitpunkt der Anfrage werden Informationen über die betroffene Datenbank, die Größe der übertragenen Daten sowie der jeweilige Kunde erfasst. Durch eine effiziente Zwischenspeicherung und regelmäßiges Schreiben aggregierter Daten in den zentralen Speicher wird die Leistung des Systems optimiert und gleichzeitig die Kosten für Speicherzugriffe reduziert.

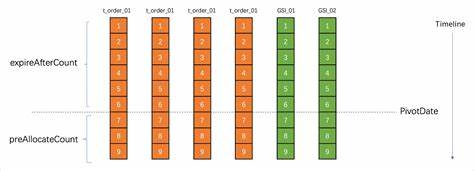

Diese Aggregation und Zwischenspeicherung ist essenziell, da sie hohe Lasten und Millionen von parallelen Anfragen handhabbar macht. Das Messen der genutzten Speicherkapazität ist hingegen ein komplexeres Unterfangen. In einer Systemwelt, in der tausende Kunden jeweils Millionen von Collections und Vektoren verwalten, müssen sowohl Skalierbarkeit als auch Genauigkeit gewährleistet sein. Eine naive Abfrage aller Datensätze zur Ermittlung des Speicherverbrauchs ist angesichts enormer Datenmengen und der hohen Aktualisierungsrate weder praktikabel noch performant. Die Lösung von Chroma basiert daher auf Change Data Capture (CDC), einer Methode, die Änderungen am Datenbestand direkt aus dem Write-Ahead-Log der zugrunde liegenden Postgres-Datenbank ausliest und in Echtzeit an eine Datenverarbeitung weiterleitet.

Dadurch können Speicheränderungen unmittelbar erkannt und erfasst werden, ohne das Hauptdatenbanksystem zu belasten. Ein besonderes Problem bei der Speicherabfrage stellt der sogenannte Heartbeat dar. Dieser Begriff bezeichnet die Notwendigkeit, auch dann regelmäßig Speicherverbrauchsdatensätze zu übermitteln, wenn sich einzelne Collections nicht verändern, diese aber dennoch weiter Speicher belegen und somit abgerechnet werden müssen. Ohne eine solche periodische Auffrischung könnten Bestandteile des Speichers fälschlicherweise nicht berücksichtigt und somit Kunden unter- oder überberechnet werden. Die Architektur setzt hierzu auf eine Metadatenebene, die auf Datenbankebene aggregiert und verwaltet wird.

Dies reduziert die Anzahl der zu verarbeitenden Einheiten von Milliarden Collections auf eine weit geringere Zahl an Datenbanken, was das System skalierbarer macht und dennoch präzise Abrechnungen ermöglicht. Um die Genauigkeit und Verlässlichkeit der Abrechnungsdaten sicherzustellen, sind verschiedene Maßnahmen implementiert. Die Verarbeitung von Change Data Capture Events erfolgt sequenziell, teilweise mit Sharding nach Datenbank-UUID, um Reihenfolge und Konsistenz zu garantieren. Darüber hinaus wird Idempotenz gewährleistet, sodass bei Wiederholungen oder Fehlern im Verarbeitungssystem keine doppelten oder falschen Abrechnungsereignisse entstehen. Durch ausgeklügelte Zeitverzögerungen bei der Verarbeitung der Heartbeats wird zudem sichergestellt, dass alle relevanten Updates erfasst wurden, bevor eine Abrechnungsinformation endgültig erstellt wird.

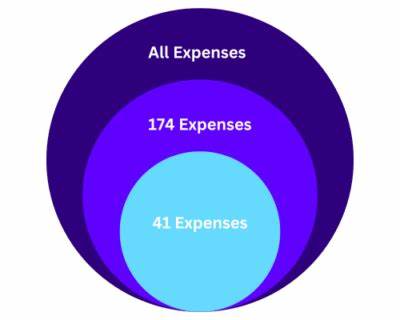

Die getrennte Behandlung von Metering und Billing als eigenständige Prozesse bietet zudem enorme Vorteile. Während das Metering für die technische Erfassung und Aggregation der Nutzungsdaten verantwortlich ist, erfolgt die eigentliche Preiskalkulation, Rechnungsstellung und Zahlungsabwicklung in separaten Systemen. Ein Beispiel hierfür ist die Partnerschaft mit dem Platform-Anbieter Orb, der über eine umfassende API, Benutzeroberfläche und flexible Preisgestaltungsmöglichkeiten verfügt. Durch diese Entkopplung können sich die Entwickler und Betreiber der Datenbanklösung auf die korrekte Messung der Nutzung konzentrieren und gleichzeitig von bewährten Lösungen für das Finanzmanagement profitieren. Das nutzungsbasierte Abrechnungsmodell bringt nicht nur Vorteile für die Anbieter, die transparent ihre Infrastrukturkosten abbilden können.

Für Kunden ergibt sich aus dieser Flexibilität ein großer Mehrwert, da sie je nach Nutzung exakt zahlen und ihre Kosten somit optimal planen können. Gleichzeitig erhalten sie die Freiheit, ihre Datenmengen und Anfragen flexibel zu skalieren, ohne sich auf eine festgelegte Kapazität oder teure Vorkosten einzustellen. Dieses Pay-as-you-go-Modell fördert somit Effizienz, vermeidet Verschwendung und stärkt das Vertrauen in die Dienstleistung. Zusammenfassend erfordert der Aufbau eines hochskalierenden, genauen und transparenten nutzungsbasierten Abrechnungssystems zahlreiche sorgfältig aufeinander abgestimmte technische Komponenten und Architekturmuster. Von Echtzeit-Messungen über die intelligente Aggregation von Events bis hin zur entkoppelten Abwicklung von Abrechnungsvorgängen entstehen komplexe, aber effiziente Systeme, die moderne Cloud- und Datenbankanwendungen wirtschaftlich und kundenorientiert gestalten.

Die vorgestellten Strategien zeigen, wie technische Herausforderungen gemeistert und gleichzeitig ein kundenfreundliches Modell geschaffen werden kann, das die Grundlage für langfristiges Wachstum und Innovation schafft.