Die Entscheidung, eine bestehende Datenbanklösung zu wechseln, ist für viele Unternehmen ein strategischer Wendepunkt, der weitreichende technische und wirtschaftliche Konsequenzen mit sich bringt. Besonders bei der Migration weg von verteilten Systemen wie CockroachDB hin zu einer bewährten relationalen Datenbank wie Postgres, gibt es zahlreiche Faktoren zu bedenken. Die Geschichte eines Unternehmens, das diesen Weg gegangen ist, zeigt eindrucksvoll, warum Postgres in vielen Szenarien die bessere Wahl darstellt und wie eine gut geplante Umstellung Kosten reduziert und die Performance verbessert. Die Herausforderung moderner Datenbanklandschaften besteht darin, dass sie einerseits hohe Verfügbarkeit und Skalierbarkeit bieten müssen, andererseits aber auch wirtschaftlich sinnvoll und performant im Alltagsbetrieb bleiben sollen. Anfangs setzte das Unternehmen Motion auf CockroachDB.

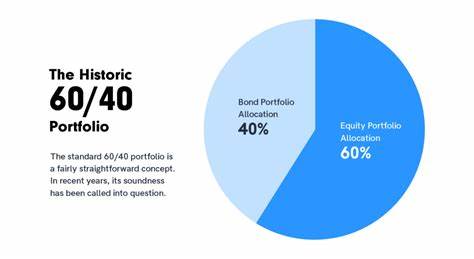

Die Wahl fiel auf diese verteilte SQL-Datenbank vor allem wegen ihrer mühelosen horizontalen Skalierung, die speziell bei Multi-Region-Setups angesichts regulatorischer Anforderungen wie der DSGVO von großem Vorteil ist. Zudem punktete Cockroach mit beinahe ununterbrochener Verfügbarkeit und einem SQL-kompatiblen Interface. Doch das wahre Wachstum und die steigenden Anforderungen förderten auch Schwachstellen zutage. Trotz noch nicht notwendiger Multi-Region-Verteilung stiegen die Kosten für CockroachDB drastisch an – auf mittlere sechsstellige Beträge jährlich, was das Unternehmen vor die Frage stellte, ob für simplere transaktionale Anfragen wirklich ein derart komplexes verteiltes System benötigt wird. Mit Hilfe eines Object-Relational Mappers (ORM) ließ sich schnell ein direkter Vergleich bei Migrationsprozessen zwischen CockroachDB und Postgres ziehen.

Dabei offenbarte sich ein entscheidender Unterschied: Während CockroachDB bei Migrationsvorgängen häufig an Timeout-Limits stieß, die zu stundenlangen Ausfallzeiten und manuellen Eingriffen führten, vollzog Postgres selbst bei großen Datenmengen Änderungen in Sekunden. Diese Migrationsproblematik begann sich zunehmend störend auszuwirken. Entwickler waren gezwungen, operative Abkürzungen einzulegen, Datenbanklocking zu vermeiden und damit potenziell Risiken einzugehen, die langfristig Systemstabilität beeinträchtigen. Darüber hinaus führte das Problem auch dazu, dass Versionsupdates von CockroachDB ausblieben, was den Support verschlechterte und bekannte Fehler mit sich brachte. Das Unternehmen blieb daher lange Zeit auf einer mittlerweile veralteten Version 22 „hängen“.

Neben Migrationen waren auch ETL-Prozesse (Extract, Transform, Load) ernsthaft betroffen. Die Streaming-Synchronisation zwischen CockroachDB und üblichen ETL-Tools wie Airbyte war durch begrenzte Konnektorunterstützung und schwerwiegende Unzulänglichkeiten geprägt. Regelmäßige Timeouts und Performanceeinbußen führten zu häufigen Alarmmeldungen außerhalb der regulären Arbeitszeit. Zusätzlich stellte sich heraus, dass nahezu keine etablierten ETL-Lösungen eine stabile, effiziente Replikation von CockroachDB-Datenbanken gewährleisteten. Interessant gestaltete sich auch der direkte Leistungsvergleich von Abfragen zwischen CockroachDB und Postgres.

Zwar gab es Fälle, in denen Cockroach durch seinen komplexen Optimizer Abfragen schneller verarbeitete, vor allem bei Aggregationen bestimmter Daten. Doch der Großteil der realen Anwendungsfälle litt unter kompliziert generiertem SQL, wie es der eingesetzte ORM Prisma erzeugte. Diese Abfragen führten durch übermäßige Joins und Spaltenauswahlen dazu, dass CockroachDB gezwungen war, vollständige Tabellenscans durchzuführen und somit deutlich höhere Latenzen aufwies. Im konkreten Beispiel konnte eine Abfrage in Postgres zwanzigmal schneller ausgeführt werden als in CockroachDB, was unter anderem auch für die Nutzererfahrung im Interface relevant war. Neben der reinen Datenbankperformance zeigten sich praktische Unterschiede im Umgang mit der Datenbankumgebung.

So konnte man bei Postgres laufende Abfragen in gängigen SQL-Clients einfach abbrechen, während Cockroach durch seine verteilte Architektur einen deutlich komplexeren und fehleranfälligeren Vorgang erforderte. Probleme bei der Sichtbarkeit nicht genutzter Indizes sowie verwirrende Empfehlungen durch Cockroach führten zu zusätzlicher Verwirrung im Entwicklerteam. Auch der Support war in kritischen Situationen nur schwer und langsam erreichbar – ein nicht zu unterschätzendes Risiko beim produktiven Betrieb. Nicht gering einzuschätzen waren ebenfalls die VPC- (Virtual Private Cloud) und Netzwerkprobleme, die das Team bei CockroachDB häufig plagten. Unzuverlässige DNS-Auflösungen und zeitweise Nichterreichbarkeit der Datenbank führten zu Verbindungsabbrüchen und beeinträchtigten Arbeitsabläufe sowohl in der lokalen als auch in der CI/CD-Umgebung.

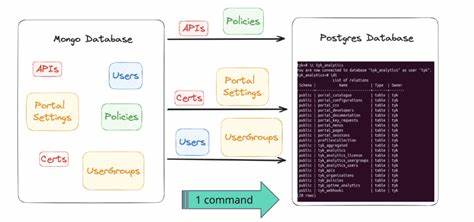

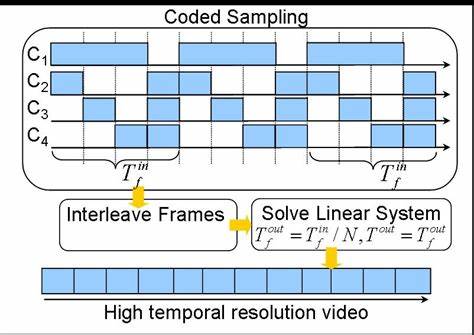

Angesichts dieser Herausforderungen entwickelte das Unternehmen eine individuelle ETL-Lösung auf Basis der aufstrebenden JavaScript-Laufzeit Bun. Dieser Ansatz erlaubte es, Datenschemata auszulesen, alle Tabelleninhalte in CSV-Dateien zu exportieren und anschließend parallel gestreamt in die Postgres-Datenbank zu importieren. Trotz anfänglicher Schwierigkeiten, insbesondere aufgrund unterschiedlicher Bytekodierungen bei JSON- und Array-Datentypen zwischen Cockroach und Postgres, konnte die Migration in einer nächtlichen Wartungsphase innerhalb einer Stunde erfolgreich abgeschlossen werden – ohne Datenverlust und mit minimaler Ausfallzeit. Der unmittelbare Effekt war eine nachhaltige Leistungssteigerung und eine Reduktion der durchschnittlichen Antwortzeiten um rund ein Drittel. Mit Unterstützung fortschrittlicher Tools wie PGAnalyze ließen sich anschließend zahlreiche unoptimierte Abfragen identifizieren und zeitnah verbessern, wodurch das System noch robuster und schneller wurde.

Neben technischer Exzellenz sparte das Unternehmen durch den Wechsel auch erheblich – über 110.000 US-Dollar jährlich, gerechnet auf das bestehende Verkehrsvolumen, das zukünftig wegen wachsender Kundenzahlen weiter steigen dürfte. Die Fallstudie verdeutlicht, dass der Einsatz einer verteilten Datenbank zwar bei bestimmten Anforderungen unverzichtbar sein kann, in vielen Fällen jedoch eine klassische, relationale Datenbank wie Postgres effektiver und kosteneffizienter agiert. Moderne ORM-Tools, leistungsfähige Analysemechanismen und ein umfangreiches Ökosystem machen den Umstieg nicht nur technisch machbar, sondern auch geschäftlich sinnvoll. Für Unternehmen, die vor ähnlichen Herausforderungen stehen, empfiehlt sich eine gründliche Analyse der tatsächlichen Anforderungen an Datenverfügbarkeit, geografische Verteilung und Anfragearten.

Die Erkenntnisse aus echten Migrationen zeigen, dass eine „einfachere“ Architektur nicht zwangsläufig Einschränkungen bedeutet, sondern im Gegenteil Stabilität, Performance und wirtschaftliche Vorteile bringen kann. Sowohl Entwickler als auch Management sollten bei der Auswahl der Datenbankarchitektur deshalb eine ausgewogene Sicht einnehmen und neben technischen Features vor allem auch Kostenstrukturen, Supportqualität und betriebliche Erfahrungen berücksichtigen. Postgres hat sich über Jahrzehnte als leistungsfähige, zuverlässige und vielfältig einsetzbare Datenbanklösung etabliert. Die breite Community, regelmäßige Updates und eine Vielzahl an Tools helfen dabei, Probleme schnell zu erkennen und zu beheben. Die Migration von komplexen verteilten Systemen zu Postgres stellt zwar eine Herausforderung dar, ist aber gut planbar und kann innerhalb kurzer Zeit umgesetzt werden.

Dabei spielt die Verfügbarkeit vielseitiger Programmiersprachen-Bindings, ETL-Anbindungen und Verwaltungs-Interfaces eine wichtige Rolle. Letztlich führt die intelligente Wahl der Datenbanktechnologie zu besseren Nutzererfahrungen, reduziertem Kostenaufwand und höherer Entwicklungsgeschwindigkeit. Wer heute auf der Suche nach robusten, skalierbaren und wirtschaftlich sinnvollen Backend-Lösungen ist, sollte Postgres daher unbedingt in Betracht ziehen – ganz gleich, ob als erste Datenbank oder bei der Migration von komplexen Systemen wie CockroachDB. Die Erfahrungen von Motion und anderen Unternehmen zeigen, dass Planung, Tests und iterative Verbesserung entscheidend sind, um das volle Potenzial von Postgres auszuschöpfen und langfristig Wettbewerbsvorteile zu sichern.