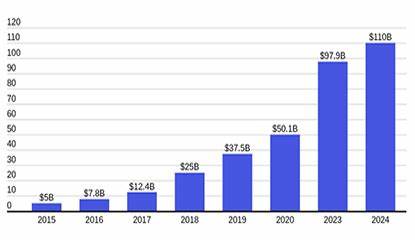

Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren enorm an Aufmerksamkeit gewonnen. Modelle wie GPT von OpenAI oder ähnliche neuronale Netzwerke haben das Potenzial, zahlreiche Aufgaben in der Textverarbeitung, Codeerstellung und kreativen Arbeit zu übernehmen. Trotz ihrer beeindruckenden Fähigkeiten zeigt sich in der Praxis immer wieder, dass diese KI-Systeme ohne explizite und klare Eingabeaufforderung nur begrenzt nutzbar sind. Diese Erkenntnis wirft wichtige Fragen auf, wie wir mit der Technologie interagieren und welche Erwartungen realistisch sind. Zu Beginn ist es wichtig zu verstehen, dass große Sprachmodelle auf Wahrscheinlichkeiten basieren.

Sie erzeugen Text, indem sie Wortfolgen vorhersagen, die in ihrem Trainingsdatensatz häufig vorkommen. Das bedeutet, dass sie stark davon abhängig sind, wie genau und präzise die Eingaben formuliert sind. Eine unklare oder vage Eingabe kann dazu führen, dass das Modell generische oder sogar falsche Antworten generiert. Dies erschwert die Anwendung gerade in komplexen oder spezialisierten Aufgaben, wie etwa der Erstellung von wartbarem Code oder der Beantwortung tiefgehender technischer Fragen. Ein grundlegendes Problem ist, dass diese KI-Modelle keine echte Selbstkorrekturfähigkeit besitzen.

Wenn eine erste Antwort fehlerhaft oder unverständlich ist, neigen sie dazu, in einer sogenannten „Schleife der Fehlinformation“ weiter ungenaue Texte zu generieren. Ohne konkretes Feedback oder eine explizite Umformulierung der Anfrage gibt es für das Modell keine Möglichkeit, den Fehler eigenständig zu erkennen oder zu beheben. Das führt zu einer Verschlimmerung der Problematik, bei der Nutzer viel Zeit aufwenden müssen, um die gewünschten Informationen oder Ergebnisse trotzdem zu erzielen. Sprachmodelle zeigen sich auch bei der Erstellung von Code nicht immer zuverlässig. Während sie durchaus Codefragmente generieren können, mangelt es oft an Struktur, Wartbarkeit und Best Practices.

Ohne klare Vorgaben, was beispielsweise modulare Architektur, Kommentierung oder Fehlerbehandlung betrifft, liefern die Modelle häufig nur oberflächliche oder „hackige“ Lösungen. Diese sind für professionelle Entwickler oft nicht sofort nutzbar und müssen deutlich überarbeitet werden. Dies unterstreicht die Bedeutung einer präzisen und detaillierten Eingabeaufforderung, die dem Modell hilft, qualitativ hochwertigen und verständlichen Code zu produzieren. Die Herausforderung liegt also nicht nur im Modell selbst, sondern vor allem in der Kommunikation zwischen Mensch und Maschine. Menschen sind es gewohnt, in Meetings oder Projektbesprechungen ihr Ziel und ihre Anforderungen klar zu definieren.

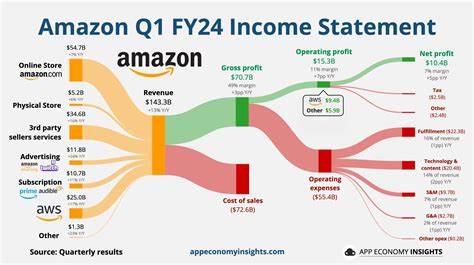

Nur so ist eine koordinierte Zusammenarbeit möglich. Im Gegensatz dazu erwarten viele Anwender von LLMs, dass diese ohne explizite Anweisungen bereits wissen, was zu tun ist. Diese Erwartung ist letztlich zu hoch angesetzt und verkennt derzeitige technische Grenzen. Aktuelle Forschungsarbeiten zeigen auch, dass die Genauigkeit großer Sprachmodelle für komplexe und langwierige Aufgaben stark von der vorhandenen Rückmeldung abhängt. Ohne kontinuierliches Monitoring und Korrekturschleifen bleiben Fehler und Inkonsistenzen häufig unerkannt.

Experten schätzen, dass es in den nächsten Jahren noch mehrere Iterationen und Anpassungen braucht, bis Modelle zuverlässig komplexe Projektphasen meistern können. Insbesondere für Aufgaben wie nachhaltige Softwarearchitektur, bei der langfristige Planung und Wartung essenziell sind, sind die heutigen LLMs noch nicht ausreichend ausgeprägt. Dies bedeutet aber nicht, dass LLMs nutzlos sind. Im Gegenteil, sie können hervorragende Werkzeuge zur Unterstützung sein, wenn man ihre Grenzen kennt und gezielt mit ihnen arbeitet. Eine bewusste und explizite Formulierung der Eingabeaufforderung sowie eine klare Definition des gewünschten Ergebnisses sind dabei essenziell.

Wer diese Prinzipien berücksichtigt, kann die Stärken der Modelle ausspielen und qualitativ hochwertige Ergebnisse erzielen – sei es beim Schreiben von Texten, der Codegenerierung oder bei der Ausführung von Routineaufgaben. Ein weiterer wichtiger Aspekt ist die Entwicklung von besseren Schnittstellen und Benutzerführung für LLMs. Aktuelle Trends im Bereich Prompt Engineering zeigen, wie durch kluge Gestaltung der Eingaben und dialogorientierte Interaktion signifikante Verbesserungen bei der Qualität der Ausgaben erzielt werden können. Dabei geht es nicht nur um Wortwahl, sondern auch um Struktur, Kontext und Wiederholung relevanter Informationen. Zusammenfassend lässt sich sagen, dass große Sprachmodelle ohne konkrete und explizite Eingabeaufforderung heute nicht ihr volles Potenzial entfalten können.

Die Kombination aus fehlender Selbstkorrekturfähigkeit, Abhängigkeit von gut formulierten Prompts und mangelnder Fähigkeit zur selbstständigen Strukturierung führt dazu, dass Anwender gezielt und verantwortungsbewusst mit den Funktionen umgehen müssen. Die Zukunft verspricht zwar Fortschritte im Bereich KI, doch bis dahin bleibt der Mensch unverzichtbar, um LLMs effizient und zielgerichtet einzusetzen.