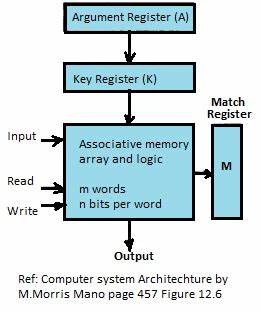

In der heutigen digitalen Ära steigt die Menge an Daten exponentiell. Große Datenmengen effizient zu speichern, zu verarbeiten und intelligent zu nutzen, stellt eine der größten Herausforderungen für die Informatik dar. Eine vielversprechende Technologie, die in diesem Kontext zunehmend an Bedeutung gewinnt, ist die sogenannte Associative-Tokenized Memory. Diese Form des Speichers revolutioniert die Art und Weise, wie Informationen gespeichert und abgerufen werden, und bietet eine intelligente, schnelle und kontextbasierte Alternative zu herkömmlichen Speichermethoden. Associative-Tokenized Memory lässt sich als eine Speicherarchitektur verstehen, die nicht nur einfache Daten ablegt, sondern diese in Form von assoziativen Token organisiert.

Tokens sind dabei kleinste Informationseinheiten, die gezielt miteinander verknüpft werden können. Durch diese Querverbindungen entsteht ein Netz aus Bedeutungen und Zusammenhängen, das es dem System ermöglicht, beim Abruf nicht nur einzelne Datenpunkte zu finden, sondern kontextsensitive Informationen und Muster zu erkennen. Dieses Verfahren orientiert sich an der Funktionsweise des menschlichen Gehirns, das Erinnerungen und Wissen ebenfalls stark assoziativ verwaltet. Die Bedeutung der Associative-Tokenized Memory liegt vor allem darin, dass sie Suchprozesse drastisch beschleunigt und vereinfacht. Anstatt Daten durch lineare oder hierarchische Strukturen zu organisieren und jedes Element einzeln zu durchsuchen, ermöglicht diese Methode einen direkten Zugriff auf assoziativ verknüpfte Informationen.

Dies kann zum Beispiel im Bereich von künstlicher Intelligenz eine entscheidende Rolle spielen, da Maschinen durch diese Speicherform ein besseres Verständnis für Zusammenhänge und Kontexte entwickeln können. Dadurch verbessern sich nicht nur Antwortzeiten, sondern auch die Qualität der Datenverarbeitung und die Genauigkeit von Modellen. Ein weiterer wichtiger Aspekt dieser Technologie ist die Flexibilität und Skalierbarkeit. Associative-Tokenized Memory lässt sich je nach Anwendungsfall erweitern und anpassen. Ob in kleinen eingebetteten Systemen oder in groß angelegten Rechenzentren, die grundlegende Architektur bleibt gleich, wobei durch die Tokenisierung eine modulare Struktur entsteht, die sich dynamisch weiterentwickeln kann.

Dies macht sie besonders attraktiv für zukunftsorientierte Anwendungen, die Agilität und Anpassungsfähigkeit fordern. Die Anwendungsmöglichkeiten von Associative-Tokenized Memory sind vielfältig. Im Bereich der Verarbeitung natürlicher Sprache ermöglicht sie beispielsweise eine semantisch tiefere Analyse von Texten, da die Token zusammenhängende Bedeutungen erfassen. In der Bildverarbeitung können komplexe Muster schneller erkannt und in Beziehung gesetzt werden. Auch in intelligenten Assistenzsystemen, die eine schnelle und präzise Kontextualisierung benötigen, kommt diese Speicherform zum Einsatz.

Die Integration in Datenbanken verbessert Suchanfragen und erleichtert das Handling von unstrukturierten Daten enorm. Technisch gesehen basiert die Associative-Tokenized Memory auf fortschrittlichen Algorithmen, die sowohl Assoziationen zwischen Tokens herstellen als auch deren Wechselwirkungen dynamisch aktualisieren können. Dabei spielen neuronale Netzwerke und weitere maschinelle Lernverfahren eine zentrale Rolle, weil sie die Mustererkennung und den automatischen Aufbau von Token-Verknüpfungen unterstützen. Im Hintergrund sorgen effiziente Speichermedien und schnelle Kommunikationsschnittstellen dafür, dass die Verarbeitung in Echtzeit erfolgen kann. Herausforderungen bestehen jedoch auch.

Die Komplexität der Tokenassoziationen muss sorgfältig gesteuert werden, um Überfrachtungen zu vermeiden, die die Systemleistung beeinträchtigen könnten. Außerdem erfordert die Implementierung solche Systeme ein hohes Maß an Expertenwissen und eine präzise Abstimmung von Hardware und Software. Dennoch sind die Vorteile dieser Technologie so überzeugend, dass immer mehr Forschungs- und Entwicklungsprojekte auf der ganzen Welt diese Richtung verfolgen. Zusammenfassend lässt sich sagen, dass Associative-Tokenized Memory den Weg zu einer neuen Generation von Speichersystemen weist, die intelligenter, schneller und anpassungsfähiger sind als herkömmliche Konzepte. Durch die Verknüpfung von Daten in assoziativen Netzwerken und die Nutzung von Token als verarbeitbare Einheiten wird ein effektives „Gedächtnis“ geschaffen, das insbesondere in der künstlichen Intelligenz, Datenanalyse und in komplexen computergestützten Anwendungen deutliche Vorteile bringt.

Diese Technologie wird dabei helfen, den Umgang mit exponentiell wachsenden Datenmengen zu bewältigen und neue Standards in der Informationsverarbeitung zu setzen.