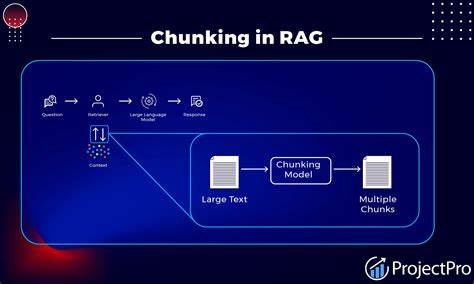

Die Welt der künstlichen Intelligenz entwickelt sich rasant, und Retrieval-Augmented Generation (RAG) ist eine der spannendsten Innovationen, die Unternehmen und Entwickler dabei unterstützt, komplexe textbasierte Systeme zu optimieren. RAG kombiniert klassische Retrieval-Methoden mit leistungsstarken Sprachmodellen, doch um das volle Potenzial auszuschöpfen, ist die Aufteilung der zugrundeliegenden Daten – das sogenannte Chunking – von zentraler Bedeutung. Doch wie bewertet man eigentlich Chunking-Strategien effektiv und wählt die beste Methode für ein bestimmtes Projekt aus? Dieser Leitfaden bietet tiefgehende Einblicke, praktische Ansätze und eine fundierte Erklärung der wichtigsten Aspekte, die bei der Evaluation von Chunking-Strategien für RAG-Systeme eine Rolle spielen. Chunking ist die Praxis, Dokumente oder große Textmengen in kleinere, handhabbare Einheiten zu zerlegen, die dem RAG-Modell präsentiert werden. Obwohl viele Anwender hoffen, dass moderne große Sprachmodelle mit umfangreichen Kontextfenstern die Notwendigkeit zur Chunking-Strategie überflüssig machen, zeigt die Forschung klar, dass durchdachtes Chunking immer noch eine entscheidende Rolle für Effizienz und Genauigkeit von RAG-Systemen spielt.

Die Sinnhaftigkeit hinter Chunking liegt darin, die Dokumente so zu strukturieren, dass die Relevanz der zurückgegebenen Informationen maximiert und zugleich die Rechenressourcen optimal genutzt werden. Wenn die Chunks zu groß oder zu klein sind, leidet entweder die Performance oder die Qualität der gefundenen Antworten. Die Herausforderung bei der Bewertung von Chunking-Strategien liegt darin, verschiedene Methoden systematisch zu vergleichen, ohne sich nur auf Vermutungen oder vereinzelte Tests zu stützen. Es gibt mehrere verbreitete Strategien, von denen einige im Folgenden erläutert werden. Recursive Character Splitting basiert auf der Idee, Texte an logischen Stellen wie Absätzen oder Satzzeichen zu teilen.

Dies sorgt für klare und konsistente Textabschnitte, die vom Modell leicht verarbeitet werden können. Diese Methode ist einfach umzusetzen und benötigt keine komplexe semantische Analyse, kann aber inhaltliche Verbindungen über Chunk-Grenzen hinweg ignorieren. Semantic Chunking hingegen nutzt Sprachmodelle und NLP-Techniken, um den Text anhand seiner Bedeutung zu segmentieren. Dabei werden zusammenhängende Konzepte und Themenblöcke identifiziert, sodass die Chunks eine inhaltliche Relevanz besitzen. Diese Methode ist anspruchsvoller, bietet aber oft bessere Ergebnisse hinsichtlich der Suchgenauigkeit und Kontextbeibehaltung.

Eine weitere Herangehensweise ist Agentic Chunking, welches mit Hilfe von Agenten oder automatisierten Systemen gezielt die besten Schnittstellen punktiert, um die Effizienz in der Wissensabfrage und Antwortgenerierung zu maximieren. Diese Technik ist fortschrittlich und verlangt mehr Ressourcen, bietet aber hohe Präzision. Clustering schließlich bietet eine kostengünstige Alternative, bei der ähnliche Dokumentteile gruppiert werden, um schnell relevante Informationen zu liefern, jedoch kann die Semantik hinter den Clustern variieren und die Genauigkeit leiden darunter. Die wichtigsten Faktoren, die bei der Bewertung von Chunking-Strategien berücksichtigt werden müssen, umfassen die Größe der Chunks, die inhaltliche Kohärenz, die Auswirkungen auf die Modellperformance, die Komplexität der Umsetzung und die Rechenintensität. Zudem ist es entscheidend, den spezifischen Anwendungsfall und die Anforderungen des Projekts im Auge zu behalten.

Ein universeller Ansatz für das Chunking gibt es nicht, denn die beste Strategie hängt stark von der Art der Dokumente, der verwendeten Sprache, den Zielen der Wissensabfrage und den eingesetzten Backend-Systemen ab. Um eine Chunking-Strategie wirklich fundiert zu bewerten, empfiehlt es sich, eine Kombination aus quantitativen und qualitativen Metriken zu verwenden. Die Messung der Retrieval-Genauigkeit ist eine der zentralen Kenngrößen: Hierbei wird überprüft, wie präzise und relevant die durch das Chunking gewonnenen Textabschnitte vom System identifiziert und wiedergegeben werden. Dabei sollten sowohl Trefferquoten als auch Fehlerraten betrachtet werden. Ergänzend sollte die Antwortqualität im Kontext des RAG-Modells evaluiert werden.

Das bedeutet, die generierten Antworten werden auf Korrektheit, Vollständigkeit und Kontexttreue analysiert. Nur wenn die Chunks dem Modell passende und ausreichend Informationen liefern, wird die Antwortqualität hoch sein. Performance-Aspekte wie Geschwindigkeit und Ressourcenverbrauch sind ebenfalls relevant, insbesondere wenn das System skaliert betrieben oder in Echtzeit-Anwendungen eingesetzt werden soll. Je nachdem wie effektiv die Chunking-Strategie Daten verarbeitet, beeinflusst dies unmittelbar das Nutzererlebnis. Praktisch empfiehlt es sich, mehrstufige Tests mit echter Anwendungseinbindung durchzuführen.

Dabei werden verschiedene Chunking-Methoden in kontrollierten Testumgebungen mit identischen Dokumentensätzen und Fragen verglichen. Metriken wie Retrieval Precision, Recall, F1-Score und subjektive Nutzerbewertungen geben wichtige Hinweise. Darüber hinaus geben experimentelle Analysen Aufschluss, wie Chunking-Strategien in Kombination mit unterschiedlichen Vektor-Datenbanken oder Sprachmodellen funktionieren. Die Integration von semantischem Wissen in den Chunking-Prozess gewinnt zunehmend an Bedeutung, um das Auffinden relevanter Inhalte aus großen Datenmengen zu erleichtern. Ontologien, Embeddings oder Transformer-basierte Modelle können hier unterstützend wirken.

Ein weiterer interessanter Ansatz ist die adaptive Chunk-Größenbestimmung, bei der die Länge oder thematische Kohärenz der Chunks dynamisch angepasst wird, um sowohl Winzigkeit als auch Überschneidungen zu vermeiden. In der Praxis ist es ratsam, die Chunking-Strategien über mehrere Releases hinweg zu überwachen und iterativ zu optimieren, um den sich verändernden Dokumentenstrukturen und Nutzeranforderungen gerecht zu werden. Die Kombination aus automatisierten Metriken und menschlichem Feedback führt dabei zu nachhaltigen Verbesserungen. Wichtig ist, dass im gesamten Prozess der Chunking-Bewertung stets die Balance zwischen Komplexität, Performance und inhaltlicher Qualität gewahrt bleibt. Zu viel Aufwand oder zu starr fokussiertes Chunking kann genauso schaden wie eine lieblos gewählte Strategie.

Zusammenfassend lässt sich festhalten, dass Chunking ein unverzichtbarer Bestandteil moderner RAG-Architekturen ist, der signifikanten Einfluss auf die Systemqualität hat. Die Auswahl der geeigneten Chunking-Strategie sollte systematisch und datengetrieben erfolgen. Dazu gehört die Berücksichtigung der Anwendungsfälle, technischer Rahmenbedingungen und der zugrundeliegenden Dokumententypen. Ein iterativer Evaluationsprozess mit einer Kombination aus semantischer Analyse, quantitativen Metriken und Nutzerfeedback ist der Schlüssel zum Erfolg. Nur so gelingt es, das maximale Potenzial der Retrieval-Augmented Generation auszuschöpfen und wirklich intelligente, kontextbewusste Antworten in anspruchsvollen Anwendungen bereitzustellen.

Die Zukunft der KI-gestützten Wissensverarbeitung wird stark von solchen präzise abgestimmten Methodiken profitieren, wodurch intelligente Systeme nicht nur leistungsfähiger, sondern auch vertrauenswürdiger und effektiver werden.