Die Entwicklung von KI-Agenten hat in den letzten Jahren enorme Fortschritte gemacht. Systeme wie OpenAI's GPT-Modelle, Devin von Cognition oder AutoGen zeigen, wie künstliche Intelligenz zunehmend komplexere Aufgaben bewältigen kann. Doch trotz dieser rasanten Entwicklungen stehen Forscher und Entwickler vor zahlreichen Herausforderungen, die die Weiterentwicklung und praktische Anwendung von KI-Agenten in den nächsten ein bis zwei Jahren maßgeblich beeinflussen werden. Diese Engpässe gilt es zu verstehen, um effektive Lösungen zu entwickeln und das volle Potenzial von KI-Agenten auszuschöpfen. Ein zentraler Engpass ist nach wie vor die Verfügbarkeit und Qualität der Daten.

KI-Modelle sind darauf angewiesen, in unterschiedlichen Domänen mit umfangreichen und vielfältigen Datensätzen trainiert zu werden. In vielen Anwendungsbereichen sind die notwendigen Daten entweder nur unzureichend vorhanden oder von minderer Qualität. Dies erschwert es, KI-Agenten zu entwickeln, die in spezifischen Kontexten zuverlässig und präzise agieren können. Gerade Bereiche mit komplexen, nicht standardisierten Informationen, wie das Gesundheitswesen oder juristische Fragestellungen, stellen große Herausforderungen dar, da dort oft Datenschutzbestimmungen und regulatorische Hürden den Zugriff auf relevante Daten erschweren. Neben der Datenproblematik stellen die aktuellen Grenzen in der reasoning-Fähigkeit der KI-Agenten einen weiteren wichtigen Flaschenhals dar.

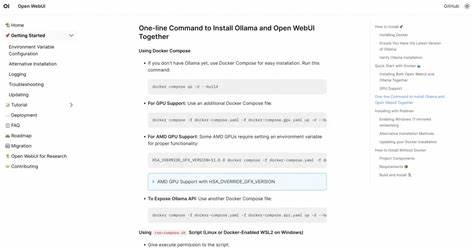

Obwohl moderne Sprachmodelle zunehmend in der Lage sind, komplexere Aufgaben zu verstehen und auszuführen, fehlt es ihnen oft an robusten Mechanismen für tiefgehendes logisches Denken und langfristige Planung. Diese Fähigkeit ist jedoch entscheidend, um AI-Agenten tatsächlich autonome, mehrstufige Aufgaben bearbeiten zu lassen, die über einfache Frage-Antwort-Szenarien hinausgehen. Der Fortschritt in diesem Bereich erfordert neue Ansätze in der Modellarchitektur und im Training, die speziell auf symbolische und kombinatorische Reasoning-Aufgaben ausgerichtet sind. Darüber hinaus wird die Integration von KI-Agenten in bestehende Toolchain-Ökosysteme oft unterschätzt. Für viele Anwendungsfälle ist es notwendig, dass KI nicht isoliert funktioniert, sondern mit etablierten Softwarelösungen, APIs und Datenbanken nahtlos zusammenarbeitet.

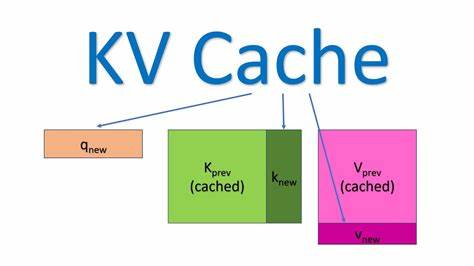

Aktuell fehlen standardisierte, robuste Schnittstellen und Frameworks, die eine einfache und effiziente Verbindung zwischen KI-Agenten und den unterschiedlichsten Tools gewährleisten. Die Herausforderung liegt hierbei nicht nur in der technischen Implementierung, sondern auch in der Gewährleistung von Sicherheit und Datenschutz über diese Schnittstellen hinweg. Ein weiterer limitierender Faktor ist die Latenz und Übertragungsgeschwindigkeit zwischen menschlichem Gehirn und KI-Agenten. Mehrere Stimmen aus der KI-Community haben darauf hingewiesen, dass die Fähigkeit, Gedanken und Kontext schnell an die KI zu übermitteln, einen erheblichen Einfluss auf die Produktivität des Zusammenspiels von Mensch und Maschine haben wird. Zwar ist diese Schnittstelle aktuell noch unterentwickelt und liegt außerhalb des unmittelbaren technischen Horizonts der kommenden zwei Jahre, doch langfristig wird die Verbesserung der Gesamtkommunikation zwischen Nutzer und KI einen zentralen Schwerpunkt darstellen.

Neben den technologischen Herausforderungen spielt auch die energieeffiziente Skalierung von KI-Modellen eine immer größere Rolle. Die Rechenleistung, die große Sprachmodelle benötigen, ist enorm und verursacht sowohl hohe finanzielle Kosten als auch relevante ökologische Auswirkungen. Die Entwicklung von energieeffizienteren Algorithmen, sparsamen Hardwarelösungen und optimierten Trainingsprocedere wird zu den dringlichsten Aufgaben gehören, um KI-Agenten auf breiter Ebene nutzbar und wirtschaftlich zu machen. Auch ethische und regulatorische Fragestellungen bilden einen bedeutenden Engpass für die Weiterentwicklung von KI-Agenten. Der zunehmende Einsatz von autonomen Systemen wirft Fragen bezüglich Verantwortung, Kontrolle und Transparenz auf, die sowohl rechtlich als auch gesellschaftlich beantwortet werden müssen.

Entwickler stehen vor der Herausforderung, zuverlässige Mechanismen zur Erkennung und Vermeidung von Bias, Datenschutzverletzungen und Missbrauchsmöglichkeiten zu implementieren, um Vertrauen in KI-Systeme zu schaffen. Für Entwickler und Unternehmen, die im Bereich KI-Agenten tätig sind oder einsteigen möchten, ist es wichtig, diese Engpässe frühzeitig zu adressieren. Investitionen in high-quality Datensammlungen, Forschung an reasoning-fokussierten Modellen und die Entwicklung modularer Schnittstellen für Toolintegration sind wichtige Ansätze, die kurz- bis mittelfristig wertvolle Fortschritte erzielen können. Zudem sollte die Zusammenarbeit mit ethischen Experten und die Einhaltung rechtlicher Standards integraler Bestandteil jeder Entwicklung sein. Zusammenfassend lässt sich sagen, dass die wichtigsten Flaschenhälse für die Entwicklung von KI-Agenten in den nächsten ein bis zwei Jahren in der Datenverfügbarkeit, begrenzten reasoning-Fähigkeiten, Herausforderungen bei der Toolintegration, Schnittstellenoptimierung sowie der Energieeffizienz und ethischen Umsetzung liegen.

Nur durch koordinierte Anstrengungen in diesen Bereichen wird es möglich sein, KI-Agenten zu schaffen, die komplexe, autonome Aufgaben zuverlässig ausführen und dabei sicher, effizient und vertrauenswürdig bleiben. Der Blick auf die kommenden Jahre zeigt eine spannende und dynamische Phase in der KI-Forschung und -Anwendung. Unternehmen, die diese Herausforderungen frühzeitig erkennen und gezielt darauf eingehen, werden ihre Wettbewerbsfähigkeit erheblich steigern können und eine Schlüsselrolle bei der Gestaltung der Zukunft künstlicher Intelligenz einnehmen.