Die rasante Entwicklung in der künstlichen Intelligenz hat in den letzten Jahren vor allem durch neuronale Netzwerke große Fortschritte erzielt. Diese Netze sind inspiriert von der Funktionsweise des menschlichen Gehirns und dienen hauptsächlich als universelle Funktionsapproximationen. Trotz ihres Erfolgs und ihrer Vielseitigkeit bringen sie einige entscheidende Nachteile mit sich, die vor allem Effizienz, Modellgröße und Komplexität betreffen. Für viele Anwendungen, gerade wenn Ressourcen begrenzt sind, beispielsweise auf mobilen Geräten oder in eingebetteten Systemen, ist es essenziell, schnelle und kompakte Modelle zu verwenden. Hier wird Transformation-Based Learning (TBL) als vielversprechende Alternative immer relevanter.

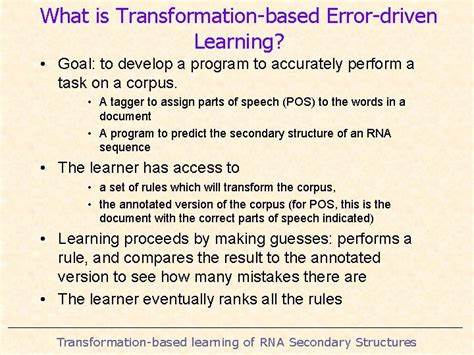

TBL bietet eine einfache und zugleich effektive Herangehensweise an natürliche Sprachverarbeitung und andere maschinelle Lernaufgaben, die traditionelle neuronale Netzwerke in gewissen Bereichen übertrifft. Die Methode basiert auf einem klar strukturierten Prozess, der auf menschlich verständlichen Regeln und klaren Transformationen zwischen den Zuständen eines Modells beruht. Ein entscheidender Vorteil dieser Technik ist die niedrigere Entropie der Modelle, was bedeutet, dass sie sehr viel leichter komprimierbar sind und dadurch bedeutend weniger Rechenressourcen benötigen. Somit passen sie ideal in Architekturen wie Harper, die es sich zum Ziel gesetzt haben, schnelle und kleine Modelle zu realisieren, die nahtlos auf unterschiedlichsten Plattformen laufen können. Im Kern der Transformation-Based Learning Methode steht ein simples Modell, das zunächst eine grobe, meist stochastische Klassifizierung vornimmt.

Diese erste Klassifizierung erzeugt einen grundlegenden Output, der als Ausgangspunkt dient. Anschließend werden die Fehler zwischen diesem Ausgang und den korrekten Zielzuweisungen systematisch identifiziert. Dieser Fehleranalyse folgend generiert das System mithilfe vordefinierter Templates eine Menge möglicher Transformationen oder Regeln, die das ursprüngliche Modell verbessern könnten. Jede dieser Regeln wird auf den aktuellen Output angewandt, um zu prüfen, ob sich die Genauigkeit erhöht. Funktionierende Regeln werden gespeichert und erhöhen sukzessive die Modellqualität.

Dieses Verfahren führt zu Modellen, die nicht nur leicht zu interpretieren sind, sondern auch über eine imposante Genauigkeit verfügen, ohne die Komplexität und Größe neuronaler Netze zu erreichen. Die Anwendbarkeit von TBL ist vielfältig, wobei eine der klassischen Herausforderungen in der Sprachverarbeitung das Part-of-Speech (POS) Tagging darstellt. POS Tagging ist die Aufgabe, jedem Wort in einem Satz seine grammatikalische Wortart zuzuweisen, etwa Nomen, Verb, Adjektiv und so weiter. Während neuronale Netzwerke heute oft beachtet werden, um POS Tagging mit hoher Genauigkeit durchzuführen, zeigt sich in der Praxis, dass Transformation-Based Learning hierfür eine ebenso robuste und effizientere Lösung bieten kann. Der Fortschritt in TBL-basiertem POS Tagging zeigt, wie mit vergleichsweise einfachen Mitteln große Qualitätsschritte erzielt werden können.

Ein weiteres spannendes Anwendungsfeld ist das sogenannte Nominal Phrase Chunking, also das Erkennen und Abgrenzen nominaler Phrasen in Sätzen. Diese Fähigkeit ist besonders wertvoll in Anwendungen wie Grammatikprüfungen, Textzusammenfassungen oder bei der automatischen Textextraktion. Während POS Tagger einzelne Wörter klassifizieren, muss ein Nominal Phrase Chunker zusammengehörige Wortgruppen erkennen und als Einheit behandeln. Das ist besonders wichtig, wenn es um komplexere sprachliche Konstruktionen geht, wie zum Beispiel die korrekte Verwendung von Kommas in Aufzählungen. Ein einfaches Beispiel zeigt die Herausforderung: Im Satz „Ich mag Äpfel, Bananen und Orangen“ kann ein POS Tagger die Wörter korrekt klassifizieren.

Sobald jedoch Attribute hinzukommen – „Ich mag grüne Äpfel, köstlich giftige Bananen und frische Orangen“ –, wird die Erkennung der korrekten Phrase schwieriger. Genau an dieser Stelle zeigt sich die Stärke eines TBL-basierten Chunkers, der anhand definierter Regeln und der Analyse von Fehlern die Phrasen besser zusammensetzen kann. Ein basaler Ansatz besteht darin, zunächst alle Nomen als Teil einer nominalen Phrase zu markieren. Dieser einfache Ansatz versagt meist bei der Erkennung von Begleitern und Adjektiven, die Teil der Phrase sind. Durch iterative Verbesserung mittels TBL können solche Fehler deutlich reduziert und die Genauigkeit gesteigert werden.

Die Einbindung von sogenannten Universal Dependencies Treebanks, annotierten Datensätzen mit umfassender syntaktischer Struktur, ermöglicht zudem eine objektive Evaluierung und Optimierung des Modells. Bereits erreichte Genauigkeiten von 90 Prozent sind ein starker Beweis für das Potenzial der Methode, wobei noch weitere Verbesserungen durch Datenbereinigung und feinere Regeldefinitionen möglich erscheinen. Dabei stellt das Training der Modelle nicht nur eine Frage der Modellarchitektur dar, sondern auch des effizienten Datenmanagements und der Pipeline-Optimierung. Die Kombination aus klaren, leicht verständlichen Regeln und menschlicher Expertise bei der Regelgestaltung hilft dabei, die Modelle zielgerichtet und effektiv zu gestalten. Die TBL-Methodik zeichnet sich zudem durch ihre Nachvollziehbarkeit aus.

Anders als bei vielen neuronalen Netzen, die oft als Black Box wahrgenommen werden, lassen sich bei TBL die einzelnen Regeln nachvollziehen und überprüfen. Das ermöglicht es Forschern und Entwicklern, gezielt Anpassungen vorzunehmen und so das Modell kontinuierlich zu verbessern. Neben der konkreten Verbesserung von Sprachverarbeitungsaufgaben wie POS Tagging und Nominal Phrase Chunking erinnert die Erforschung und Weiterentwicklung von Transformation-Based Learning auch an den Ursprung vieler Sprachmodelle. Vor der Ära tief lernender neuronaler Netze wurden statistische Modelle wie Markov Chains als erste Ansätze zur Sprachmodellierung genutzt. Diese mathematischen Modelle basieren auf der Wahrscheinlichkeit der Wortfolge und ermöglichen einfache Autovervollständigungssysteme.

Die Verbindung zur heutigen TBL-Methode liegt in der Nutzung von Wahrscheinlichkeiten und statistischer Analyse als Basis für gezielte Transformationen. Ein interessanter Aspekt der Entwicklung ist auch die persönliche Arbeitsweise der Entwickler. Regelmäßiges Selbstgespräch und kritische Reflexion sind wichtige Instrumente, um komplexe Probleme zu durchdringen und neue Ideen hervorzubringen. Die Erkenntnis, dass handschriftliche Notizen für viele nicht funktionierten, unterstreicht zudem, wie wichtig es ist, individuelle Arbeitsmethoden zu finden, die wirklich produktiv sind. Zusammenfassend steht Transformation-Based Learning als Methode für eine effiziente, flexible und skalierbare Alternative zu schwerfälligen neuronalen Netzen.

Die Fähigkeit, mit vergleichsweise einfachen Mitteln gute Ergebnisse zu erzielen, macht TBL besonders attraktiv in Szenarien, in denen Ressourcen knapp sind oder Interpretierbarkeit eine hohe Rolle spielt. Die stetige Optimierung der Modellpipelines, die gezielte Nutzung von annotierten Daten sowie die Integration menschlicher Expertise gewährleisten, dass diese Methode auch zukünftig eine wichtige Rolle in der maschinellen Sprachverarbeitung und darüber hinaus spielen wird. Unternehmen und Entwickler, die auf der Suche nach schlanken, transparenten und robusten Lösungen sind, sollten Transformation-Based Learning als eine vielversprechende Technologie genau betrachten.