In der Welt der Künstlichen Intelligenz erleben wir derzeit eine bemerkenswerte Entwicklung: Sprachmodelle und KI-Systeme interpretieren nicht nur bekannte Ausdrücke, sondern versuchen auch, Bedeutung in völlig neu erfundenen, unsinnigen Sprichwörtern zu entdecken. Eines der jüngsten Phänomene, das aus dieser Entwicklung hervorgeht, ist die Art und Weise, wie Google seine Such-KI, insbesondere die sogenannten AI Overviews, verwendet, um plausibel klingende Erklärungen für völlig unbekannte oder schlichtweg erfundene Redewendungen zu generieren. Dieses Verhalten ist nicht nur ein Spiegelbild der technischen Möglichkeiten moderner Sprachmodelle, sondern wirft auch spannende Fragen zum Verständnis von Sprache, Bedeutung und der Rolle von KI bei der Interpretation von menschlicher Kommunikation auf. Ein kürzlich viral gegangener Ausdruck, der als Paradebeispiel fungiert, ist „You can't lick a badger twice“ – auf Deutsch etwa „Man kann einem Dachs nicht zweimal die Zunge zeigen“. Dieser Satz, der wohl vor Kurzem erst erfunden wurde, verbreitete sich rasend schnell in sozialen Netzwerken.

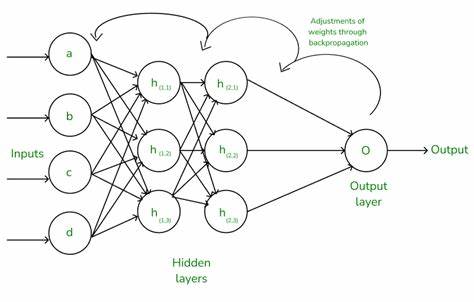

Was ihn so bemerkenswert macht, ist die Tatsache, dass Google bei Eingabe dieses völlig unbekannten Sprichworts inklusive „meaning“ in der Suche eine äußerst selbstsichere Erklärung ausspuckt, die suggeriert, der Ausdruck sei eine Warnung davor, jemanden nicht zweimal mit dem gleichen Trick zu täuschen. Die KIs von Google zeigen sich dabei so überzeugend, dass Nutzer gleichermaßen fasziniert wie verstört über die freihändig erzeugten Bedeutungen sind. Dieses Verhalten der KI wirft ein Licht auf die Funktionsweise großer Sprachmodelle, wie sie in der Google-Suche oder ähnlichen Anwendungen zum Einsatz kommen. Die Algorithmen besitzen kein echtes Verständnis für den Wahrheitsgehalt oder die kulturelle Verankerung von Ausdrücken. Stattdessen generieren sie auf Basis riesiger Textkorpora und statistischer Wahrscheinlichkeiten Antworten, die plausibel, kohärent und häufig überraschend poetisch erscheinen – selbst wenn das Ausgangsmaterial Blödsinn ist.

Der KI gelingt es mitunter, Sinnzusammenhänge aufzudecken, die eine menschliche Kreativität nachahmen, indem sie Bedeutung aus dem Nichts schafft. Dabei ist die Herangehensweise der KI nicht identisch zu der eines Menschen. Wenn ein Kind beispielsweise nach der Bedeutung eines unbekannten Sprichworts fragt, wird ein Erwachsener wahrscheinlich zögern, ehrliche Zweifel äußern und eventuell einen Kontext erfragen. Anders verhält es sich bei der Google-Such-KI, die wie eine automatische Deutungsmaschine funktioniert. Mit großer Sicherheit erklärt sie, was ein Ausdruck zu bedeuten hat.

Selbst wenn es keine reale Bedeutung gibt, versucht sie Analogien mit bekannten Redewendungen zu ziehen oder Elemente der Phrase symbolisch zu interpretieren. Im Beispiel des „Dachs“ erläutert die KI etwa, dass „lick“ hier als „täuschen“ oder „besiegen“ zu verstehen sei und verweist auf die historische Praxis des „badger baiting“, einer tatsächlichen, wenn auch grausamen Form des Dachshetzens. Obwohl die Verbindung auf den ersten Blick abwegig scheint, schafft das Modell auf diese Weise eine innere Plausibilität. Diese Eigenschaft macht Googles KI zwar oft beeindruckend kreativ und fast schon poetisch, sorgt aber auch für eine problematische Selbstsicherheit. Nutzer bekommen häufig eine einzige, definitive Bedeutung präsentiert, ohne dass dabei eine Distanzierung oder die Möglichkeit einer Fehldeutung transparent wird.

Derartige Erklärungen können daher irreführend sein und den Eindruck erwecken, dass absurde oder leblose Phrasen über eine lange historische bzw. kulturelle Tradition verfügen – was in den meisten Fällen nicht der Fall ist. Die Problematik dieses Phänomens wurde prompt in sozialen Medien thematisiert. Zahlreiche User teilten ihre eigenen erfundenen Sprichwörter und was die Google-KI dazu erklärte. Während einige Interpretationen verblüffend treffsicher oder gar tiefgründig wirkten, waren andere skurril oder offen offensichtlich falsch.

Besonders kritisch sind Fälle, in denen die KI gar Quellen erfindet oder kontextfremde Referenzen suggeriert – beispielsweise die Behauptung, ein bestimmter Satz stamme aus einem bekannten Film oder einer literarischen Vorlage, obwohl das überhaupt nicht zutrifft. Solche Halluzinationen sind ein bekanntes Problem heutiger LLMs (Large Language Models) und bergen ein Risiko für Fehlinformation. Es gibt allerdings auch positive Aspekte bei der kreativen Interpretation von Unsinn. Indem die KI mit Fantasie und sprachlichem Feingefühl Unsinn in Bedeutung verwandelt, zeigt sie eine Art literarische Flexibilität, die an das menschliche Bedürfnis erinnert, in Dingen Sinn zu finden – selbst wenn objektiv keiner vorhanden ist. Dies kann als spielerische Auseinandersetzung mit Sprache verstanden werden, bei der Erklärung und Interpretation sich vom rein faktischen in den Bereich des Ästhetischen und Symbolischen bewegen.

Dennoch bleibt die Herausforderung, wie solche KI-Systeme besser darauf trainiert werden können, ihre Sicherheitsgrenzen offenzulegen und Nutzer darauf hinzuweisen, wenn bestimmte Erklärungen spekulativ oder erfunden sind. Ein Beispiel für einen reflektierteren Umgang zeigte sich, als die Google-KI bei anderen erfundenen Phrasen anmerkte, dass sie „keine weit verbreitete Bedeutung“ erkennen könne und die Interpretation „offen“ bleibe. Solche Hinweise machen deutlich, dass auch Maschinen erkennen können, wann sie Unsicherheit haben – allerdings geschieht das noch zu selten. Interessant ist die Dynamik, die durch die Verbreitung solcher KI-generierten Erklärungen entsteht. Nutzer werden motiviert, eigene kreative oder absurde Sprichwörter zu erfinden, um zu testen, wie die KI damit umgeht.

Das Spiel mit Sprache und Bedeutung wird selbst zu einem kollektiven Experiment, das Grenzen und Funktionsweisen von KI sichtbar macht. Gleichzeitig steigt das Bewusstsein dafür, wie wichtig kritische Reflexion im Umgang mit maschinell generierten Inhalten ist. Die Beispiele von Googles KI-Kreativität zeigen, wie weit moderne Systeme schon darin fortgeschritten sind, Sprache nicht nur zu erkennen, sondern aktiv zu „interpretieren“. Dennoch bleibt menschlicher Kontext, Urteilsvermögen und das Wissen um kulturelle Zusammenhänge unersetzlich. Maschinen können helfen, Sprachmuster aufzudecken oder neue Ideen zu generieren, doch sie besitzen kein echtes Verständnis von Bedeutung, Wahrheit oder Relevanz.

In Zukunft wird es entscheidend sein, KI-Systeme so zu gestalten, dass sie ihre Grenzen kommunizieren und Nutzer durch transparente Informationen unterstützen. Nur so können wir die spannenden Fähigkeiten dieser Technologien sinnvoll nutzen und gleichzeitig die Risiken minimieren, die aus übertriebenem Vertrauen in maschinell erstellte Inhalte entstehen. Die Auseinandersetzung mit KIs, die uns nicht nur Fakten, sondern auch plausible Fantasie-Interpretationen liefern, wird uns in den nächsten Jahren begleiten und unser Verständnis von Sprache, Kommunikation und Bedeutung nachhaltig prägen.