Die Welt der Künstlichen Intelligenz erlebt eine rasante Entwicklung, besonders im Bereich der großen Sprachmodelle, bekannt als Large Language Models (LLMs). Diese Modelle, die auf Milliarden von Parametern basieren, revolutionieren die Art und Weise, wie Maschinen menschliche Sprache verstehen, generieren und nutzen können. Im Jahr 2024 sind Hunderttausende von Forschern weltweit intensiv daran beteiligt, neue Grenzen des Machbaren zu verschieben, von effizienter Modellarchitektur bis hin zur Optimierung von Alignment-Techniken und multimodalen Fähigkeiten. Die jüngsten sorgfältig kuratierten wissenschaftlichen Arbeiten geben dabei einen faszinierenden Einblick in den Stand der Forschung und zeigen auf, wie sich diese Technologien weiterentwickeln und in verschiedensten Anwendungsgebieten etablieren. Große Fortschritte wurden insbesondere im Bereich der Modellarchitektur und Effizienz erzielt.

Die Forschung beleuchtet innovative Ansätze zur Skalierung von Sprachmodellen, um nicht nur die Größe der Parameter zu erhöhen, sondern vor allem die Effizienz in Rechenleistung und Energieverbrauch signifikant zu verbessern. Neuartige Designs wie hybride Modelle, die Zustandsraummodelle mit Transformer-Strukturen kombinieren, verdeutlichen, wie Architekturinnovationen zur Beschleunigung und Optimierung der Verarbeitung beitragen können. Ein weiteres zukunftsträchtiges Thema ist die Erweiterung des Kontextfensters von LLMs. Die Fähigkeit, längere Texte, komplexe Dokumente oder ausgedehnte Dialoge kontextuell zu erfassen, stellt eine wesentliche Herausforderung dar. Die neuesten Studien beschäftigen sich mit selbstverlängernden Kontextfenstern oder adaptiven Mechanismen, die es ermöglichen, den Kontext eines Sprachmodells ohne erneutes Training drastisch zu vergrößern.

Dies eröffnet neue Möglichkeiten für Anwendungen, die tiefere und langanhaltendere Konversationen oder umfangreiche Dokumentenanalyse erfordern. Parallel dazu gewinnt die Optimierung der Präferenzen und der Ausrichtung von Sprachmodellen durch Methoden wie Reinforcement Learning with Human Feedback (RLHF) zunehmend an Bedeutung. Da LLMs zunehmend in kritischen Bereichen eingesetzt werden, rückt die ethische und wertorientierte Steuerung der Modelle in den Vordergrund. Durch gezieltes Training mit menschlichem Feedback versuchen Forscher, nicht nur die Genauigkeit der Modelle zu verbessern, sondern auch deren Verhalten im Sinne von gesellschaftlichen Normen, Sicherheit und Vermeidung von toxischen oder falschen Inhalten auszurichten. Untersuchungen zu direkten Präferenzoptimierungsalgorithmen verdeutlichen hierbei neue Wege, die Effizienz und Qualität des Ausrichtungsprozesses zu steigern.

Die Integration multimodaler Daten wie Bilder, Audio und Text ist eine weitere Schlüsselkomponente in der aktuellen Forschung. Modelle, die in der Lage sind, mehrere Modalitäten simultan zu verstehen und zu generieren, erweitern die Einsatzmöglichkeiten enorm – von der automatisierten Bildbeschreibung bis hin zu komplexen multi-sensorischen Schnittstellen. Neue Forschungsergebnisse zeigen verbesserte Methoden zur Verschmelzung und zum Training solcher multimodaler Modelle, was sie vielseitiger und leistungsfähiger macht. Die Effizienzsteigerung bei der Speicherung und Verarbeitung bleibt ein konstantes Thema. Techniken wie Quantisierung, Kompression und Parameter-Effizienz gewinnen an Bedeutung, um große Modelle auf realistische Hardwarebedingungen herunterzubrechen und deren Zugänglichkeit auch für kleinere Organisationen oder sogar für mobile Endgeräte zu erleichtern.

Besonders der Übergang zu Low-Bit- und 1-Bit-Modellen, aber auch hybride Ansätze, erforschen das Potenzial, die Speicherkosten drastisch zu senken, ohne dabei wesentliche Qualitätseinbußen hinzunehmen. Die Evaluation von Sprachmodellen und die Entwicklung von Benchmarks nehmen im Forschungsfeld einen zentralen Platz ein. Neue Metriken und standardisierte Prüfverfahren helfen dabei, die Fähigkeiten der LLMs objektiv zu beurteilen und Unterschiede zwischen Modellen transparent zu machen. Dabei wird zunehmend der Fokus auf realitätsnahe, anspruchsvolle Aufgaben gelegt, da die reine Leistung bei einfachen Testsets inzwischen nur noch begrenzte Aussagekraft hat. In diesem Kontext gewinnen auch Bewertungen anhand von Nutzerfeedback und interaktiven Szenarien an Relevanz.

Instruction Tuning und die Feinabstimmung von Sprachmodellen auf spezifische Aufgaben gehören ebenfalls zu den besonders dynamischen Forschungsgebieten. Je besser Modelle auf menschliche Instruktionen und spezifische Anforderungen angepasst werden können, desto vielfältiger und präziser sind ihre Einsatzmöglichkeiten in Bereichen wie Medizin, Recht, Softwareentwicklung oder Kundensupport. Der Trend geht zunehmend zu skalierbaren und daten-effizienten Methoden, die auch kleinere Modelle zu beeindruckenden Ergebnissen führen können. Interessierte Forscher und Praktiker profitieren von mehreren umfangreichen Übersichtsarbeiten und Meta-Analysen, die den aktuellen Stand des Wissens zusammenfassen. Solche Arbeiten bieten nicht nur eine Orientierung, sondern heben auch offene Fragen und Herausforderungen hervor, die zukünftige Forschungen antreiben.

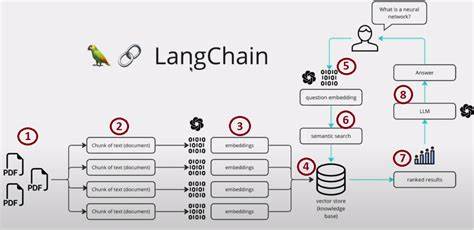

Betrachtet man die praktischen Anwendungen, so zeigen Studien aus verschiedensten Branchen, wie LLMs schon heute reale Prozesse transformieren. Von der automatisierten Codierung und juristischen Beratung bis hin zu medizinischer Bildverarbeitung und kreativer Texterstellung – die Anwendungsfälle scheinen grenzenlos. Insbesondere der Einsatz von LLMs in Kombination mit Retrieval-Systemen (RAG – Retrieval-Augmented Generation) gewinnt an Bedeutung, da dadurch Modelle direkten Zugriff auf große Wissensbasen erhalten und somit detailliertere und genauere Antworten liefern können. Zusammenfassend lässt sich sagen, dass die aktuelle Forschungslandschaft im Bereich großer Sprachmodelle von großer Dynamik und Vielfalt geprägt ist. Die zunehmende Zahl hochqualitativer Publikationen aus dem Jahr 2024 verdeutlicht, wie intensiv und breit gefächert das Interesse an der Weiterentwicklung von LLMs ist.

Die fortschreitende Verbesserung in Architektur, Training, Ausrichtung sowie multimodalen Fähigkeiten verspricht eine rasche Integration dieser Modelle in immer mehr Lebensbereiche. Es bleibt spannend zu beobachten, wie sich diese Technologien weiterentwickeln und welche neuen Möglichkeiten und Herausforderungen damit einhergehen. Wer sich mit den neuesten Erkenntnissen vertraut macht, findet in den zahlreichen Forschungsarbeiten eine wertvolle Inspirationsquelle und eine Grundlage für innovative Entwicklungen in der KI-Branche.