Die rasante Entwicklung der digitalen Welt bringt immer komplexere Anforderungen an Computersysteme mit sich. Anwendungen wie maschinelles Lernen, Genomanalyse, Graphverarbeitung und Datenanalytik erzeugen eine beispiellose Menge an Daten, die verarbeitet und gespeichert werden müssen. In diesem Kontext zeigt sich ein grundlegendes Dilemma: Die Speicherarchitektur moderner Computer ist zum Flaschenhals geworden. Das sogenannte Speicherproblem stellt eine der größten Herausforderungen für Leistung, Energieverbrauch, Kosten und Zuverlässigkeit dar. Herkömmliche Systeme basieren auf einem prozessorzentrierten Design, bei dem der Speicher als passives und reines Datenspeicherinstrument fungiert.

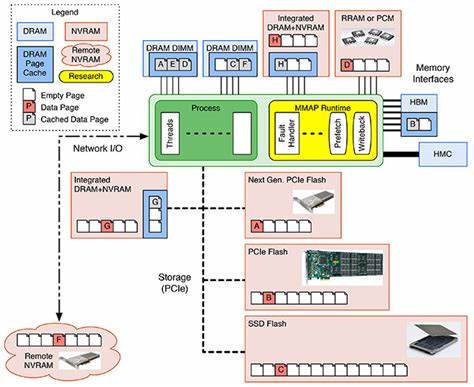

Dieses Paradigma stößt zunehmend an seine Grenzen, weshalb die Speicherzentrierte Computerarchitektur als vielversprechender Lösungsansatz immer mehr Aufmerksamkeit erhält. Die aktuelle Speicherlandschaft innerhalb von Computersystemen ist durch eine Vielzahl unterschiedlicher Technologien geprägt, die auf verschiedenen Ebenen miteinander kombiniert werden. Von schnellen, aber limitierten Speichermedien wie CPU-Cache und DRAM bis hin zu langsameren, aber größeren Speichern wie Festplatten und SSDs erstreckt sich das Spektrum. Trotz Verbesserungen bei Speicherkapazität und -geschwindigkeit zehren vor allem die langen Zugriffszeiten und der hohe Energieverbrauch des Speichers an der Systemleistung. Das Hauptproblem liegt darin, dass der Prozessor und der Speicher physisch getrennt sind und die Daten zwischen ihnen hin- und herbewegt werden müssen – eine Kombination, die zeitliche Verzögerungen, Energieverschwendung und Engpässe verursacht.

Die Kernkritik am prozessorzentrierten Design ist, dass der Speicher passiv bleibt und keinerlei eigene Rechenkapazitäten besitzt. Dabei gibt es mit Fehlermustern wie RowHammer, Datenretention oder Variable Read Disturbance eine Vielzahl von Speicher-basierten Problemen, die durch das bloße Speichern und Abrufen von Daten entstehen und sich mit zunehmender Skalierung verschärfen. Diese Phänomene führen zu instabilen Systemen, Datenverlust und erhöhtem Wartungsaufwand. Vor allem bei immer weiter schrumpfenden Speicherzellen und höheren Integrationsdichten trifft das herkömmliche Management an physikalische Grenzen. Das Konzept der speicherzentrierten Computerarchitektur verfolgt daher die Idee, den Speicher selbst aktiv und intelligent werden zu lassen.

Anstatt die Daten ständig hin und her zwischen Prozessor und Speicher zu verschieben, sollen Teile der Datenverarbeitung direkt im Speicher stattfinden. Dadurch verringert sich nicht nur der Datenverkehr, sondern auch die mit der Datenübertragung verbundene Latenz und der Energieverbrauch. Dieses Prinzip wird als „Processing in Memory“ (PIM) bezeichnet und markiert einen Paradigmenwechsel in der Systemarchitektur. Die Integration von Rechenelementen in Speicherchips ermöglicht es, einfache bis komplexe Operationen ortsnah zu Daten durchzuführen, wodurch die Gesamtsystemperformance signifikant gesteigert werden kann. Ein weiterer Vorteil der speicherzentrierten Architektur liegt in der autonomen Speicherverwaltung.

Im Gegensatz zum traditionellen Design, bei dem die Prozessoren für Speicheroperationen, Fehlerkorrekturen und Wartung verantwortlich sind, soll der Speicher durch integrierte Intelligenz selbständig Problembehandlung, Fehlerdiagnose und Selbstheilungsprozesse durchführen können. Dies trägt zu einer höheren Robustheit und Zuverlässigkeit bei, reduziert den manuellen Eingriff und ermöglicht effizientere Fehlervermeidung, sogar bei den neuen und noch unbekannten Hardware-Problemen, die mit weiterem Speicherskalieren einhergehen. Die gestiegenen Leistungsanforderungen der Datenverarbeitungstechnik können somit durch eine Kombination aus innovativer Speichertechnologie und architektonischer Neuausrichtung adressiert werden. Beispielsweise profitiert maschinelles Lernen stark von der parallelen Datenverarbeitung direkt im Speicher, da typische Operationen wie Matrixmultiplikationen und Vektoradditionen lokal ausgeführt werden können. Das reduziert nicht nur die benötigte Bandbreite zwischen Speicher und Prozessor, sondern ermöglicht auch eine drastische Verringerung des Energiebedarfs.

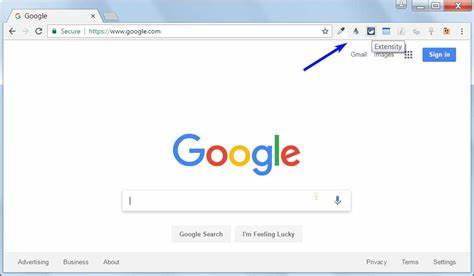

Ähnlich profitieren Anwendungen in der Bioinformatik und Graphanalyse von der direkten Speicherintegration, da viele Algorithmen datenintensiv und stark speicherabhängig sind. Trotz dieser vielversprechenden Potenziale steht die breite Adoption speicherzentrierter Konzepte vor einigen Herausforderungen. Die Integration von Recheneinheiten im Speicher erfordert neue Hardwareschnittstellen, Kompatibilität mit bestehenden Software-Stacks und eine grundlegende Anpassung bekannter Programmiermodelle. Auch die Entwicklung geeigneter Speicherchips mit Rechenfähigkeiten ist technisch komplex und erfordert enge Zusammenarbeit zwischen Hardwareherstellern und Softwareentwicklern. Darüber hinaus sind Kompatibilitäts- und Sicherheitsaspekte zu berücksichtigen, da neue Angriffsmöglichkeiten entstehen können, wenn Speicher mehr als nur passive Datencontainern wird.

Der Übergang zu speicherzentrierten Systemen ist daher als evolutionärer Prozess zu verstehen. Schrittweise Implementierungen und hybride Systeme, die traditionelle und neuartige Konzepte kombinieren, können einen sanften Übergang ermöglichen. Forschungsprojekte und industrielle Pilotprojekte legen erste Grundlagen, die in Zukunft weiter ausgebaut werden. Parallel entwickeln sich neue Speichermaterialien und Technologien, die das Potenzial haben, die Speicherarchitektur noch grundsätzlicher zu verändern, wie z. B.

nichtflüchtiger Speicher mit hoher Leistungsfähigkeit und geringer Energieaufnahme. Insgesamt steht das Feld der Speicherarchitektur an einer Weggabelung. Fortschritte in der Hardwareentwicklung, kombiniert mit innovativen architektonischen Konzepten, schaffen eine neue Ära im Computing, in der der Speicher nicht mehr als Flaschenhals, sondern als aktiver Partner im Rechenprozess betrachtet wird. Speicherzentrierte Computing-Methoden versprechen nicht nur eine signifikante Steigerung der Performance, sondern auch einen nachhaltigen Umgang mit der ständig wachsenden Datenflut und den damit verbundenen Anforderungen an Energieeffizienz und Zuverlässigkeit. Für Unternehmen und Entwickler, die zukunftssichere IT-Lösungen schaffen wollen, bietet die speicherzentrierte Architektur eine attraktive Alternative zu den bisherigen Denkmodellen.

Durch intensiven Erfahrungsaustausch zwischen Forschung und Industrie sowie gezielte Förderung innovativer Projekte kann der Weg zu einer neuen Speicherära geebnet werden, die den Herausforderungen moderner Datenverarbeitung gerecht wird.