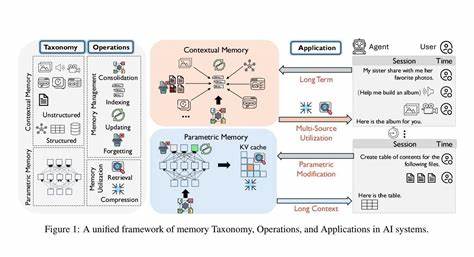

Das Thema Gedächtnis in der Künstlichen Intelligenz (KI) gewinnt zunehmend an Bedeutung, denn es stellt eine der zentralen Komponenten moderner KI-Systeme dar. Insbesondere bei großen Sprachmodellen, auch bekannt als Large Language Models (LLMs), ist das Gedächtnis nicht nur essenziell für das Verarbeiten und Speichern von Informationen, sondern auch maßgeblich für die Fähigkeit, auf Kontext und vergangene Interaktionen zuzugreifen. Ein tieferes Verständnis der Gedächtnisdynamiken in KI-Systemen eröffnet neue Möglichkeiten für Forschung und Anwendung, die weit über die bisher dominanten Personalisierungsansätze von Gedächtnis in Konversationsagenten hinausgehen.Grundlegend lässt sich das Gedächtnis in KI-Systemen in zwei Hauptkategorien unterteilen: parametrisches und kontextuelles Gedächtnis. Parametrisches Gedächtnis beinhaltet jenes Wissen, das direkt in den Modellparametern verankert ist, also in den Gewichten und Strukturen des Modells selbst.

Dieses Gedächtnis ist fest integriert und wird während des Trainingsprozesses aufgebaut. Kontextuelles Gedächtnis dagegen bezieht sich auf Informationen, die dynamisch während der Laufzeit verarbeitet und temporär gespeichert werden. Hierbei handelt es sich beispielsweise um kontextuelle Hinweise aus einer laufenden Unterhaltung oder externen Wissensquellen, die während der Interaktion abgerufen werden können.Das Verständnis und die Klassifizierung verschiedener Gedächtnisoperationen ist ebenso essentiell, um den komplexen Prozess der Informationsverarbeitung und -anforderung in KI-Systemen zu beschreiben. Sechs grundlegende Operationen bilden das Fundament der Gedächtnisdynamik: Konsolidierung, Aktualisierung, Indexierung, Vergessen, Abruf und Kompression.

Jede dieser Operationen erfüllt eine spezifische Funktion und trägt dazu bei, wie Speicherinhalte gepflegt, verändert und effektiv genutzt werden.Konsolidierung beschreibt den Prozess, durch den temporäre Informationen in eine langfristigere Speicherform überführt werden. Diese Operation ist vergleichbar mit dem menschlichen Mechanismus, bei dem flüchtige Erinnerungen in dauerhafte Erfahrungen umgewandelt werden – ein essenzieller Schritt für die Stabilität von Wissen im System. Die Aktualisierung hingegen ist die Fähigkeit, gespeicherte Informationen zu modifizieren, um neue Erkenntnisse einzubeziehen oder Fehler zu korrigieren. Dies ist gerade in dynamischen Anwendungsfällen wichtig, in denen sich das zugrunde liegende Wissen ständig verändert.

Die Indexierung spielt eine entscheidende Rolle für die Organisation und schnelle Zugänglichkeit der gespeicherten Daten. Durch eine effiziente Indexstruktur können relevante Informationen zielgerichtet und in kurzer Zeit gefunden werden. Das Konzept des Vergessens ist dagegen ein oft unterschätztes Element, das aber maßgeblich zur Vermeidung von Speicherüberlastungen und zur Erhaltung der Relevanz beiträgt. Es ermöglicht KI-Systemen, unwichtige oder veraltete Informationen ausgelagert zu haben, um den Speicherplatz effizient zu nutzen.Der Abruf ist die Operation, die den Zugriff auf gespeicherte Informationen ermöglicht.

Dieser Schritt steht oft im Fokus von Forschung und Entwicklung, da ein schneller und genauer Abruf essentiell für die Performanz von LLM-basierten Agenten ist. Schließlich trägt die Kompression dazu bei, Speicherplatz zu minimieren, ohne den Informationsgehalt wesentlich zu verlieren. Durch gezielte Reduktion der Daten können KI-Modelle effizienter arbeiten und behalten gleichzeitig die für Entscheidungen notwendigen Details bei.Projektübergreifend lassen sich diese Operationen auf mehrere relevante Forschungsthemen und Anwendungsbereiche übertragen. Dazu zählen langfristiges Gedächtnis, das auf dauerhafte Wissensspeicherung abzielt, langkontextuelles Gedächtnis, das vor allem die Verarbeitung großer Informationsmengen innerhalb eines Kontextfensters ermöglicht, parametrixhe Modifikationen, also Änderungen direkt an den Modellparametern, und Multi-Source-Gedächtnis, das unterschiedliche Datenquellen integriert und miteinander verknüpft.

Das langfristige Gedächtnis stellt eine fundamentale Herausforderung dar, da LLMs traditionell auf kurzfristige Kontextfenster beschränkt sind, was das Bewahren und Nutzen von Wissen über längere Zeiträume hinweg erschwert. Forschungen streben daher danach, Mechanismen zu entwickeln, die den langfristigen Erhalt und die flexible Nutzung von Wissen gewährleisten. Langkontextuelles Gedächtnis arbeitet an der Verbesserung der Kontextfenster-Limits, um umfassendere und vielschichtigere Dialoge oder Verarbeitungen zu ermöglichen.Parametrische Modifikationen zielen auf das gezielte Verändern von Modellparametern ab, um Wissen einzufügen, zu löschen oder zu adaptieren, ohne den gesamten Trainingsprozess neu durchführen zu müssen. Dies erweitert die Anpassungsfähigkeit der KI-Systeme erheblich und erlaubt schnellere Reaktionen auf veränderte Anforderungen oder neue Fakten.

Das Multi-Source-Gedächtnis wiederum verbindet heterogene Datenströme, sei es strukturierte Datenbanken, unstrukturierte Texte oder multimodale Informationen, um kontextuell reichere und informiertere Antworten zu generieren.Die sorgfältige Analyse und das Reframing von Gedächtnis in KI unter Berücksichtigung dieser Operationen und Speicherrepräsentationen eröffnen neue Horizonte für Forschung und praktische Anwendungen. Es entsteht eine strukturierte Sichtweise, die die dynamische Natur von Gedächtnissystemen klar herausstellt und deren Zusammenspiel verständlich macht – gerade im Zusammenspiel mit LLM-basierten Agenten. Durch solche Perspektiven lässt sich nicht nur die Funktionalität heutiger KI-Lösungen besser interpretieren, sondern auch der Grundstein für innovative Entwicklungen in der Zukunft legen.Mit Blick auf zukünftige Forschungsrichtungen zeichnen sich mehrere spannende Ansatzpunkte ab.

Die Weiterentwicklung von Langzeitgedächtnis-Verfahren, die Integration von adaptiven Vergessensmechanismen zur Verbesserung der Effizienz und die verbesserte Verzahnung verschiedender Gedächtnistypen stehen im Fokus. Auch die Schaffung standardisierter Benchmarks, Datensätze und Werkzeuge zur Evaluierung und Vergleichbarkeit von Gedächtnisoperationen wird an Bedeutung gewinnen. Darüber hinaus sind interdisziplinäre Ansätze gefragt, die kognitive Wissenschaften, Neurowissenschaften und KI-Entwicklung miteinander verbinden, um biologisch inspirierte Gedächtnismodelle zu realisieren.Zusammenfassend lässt sich festhalten, dass das Gedächtnis in der KI weit mehr ist als eine einfach zu lösende Speicherfrage. Es ist ein komplexes, dynamisches System, dessen effiziente Gestaltung und Steuerung den Fortschritt von KI-Systemen maßgeblich prägen werden.

Die Betrachtung aus der Perspektive von Taxonomie, grundlegenden Operationen und zeitgemäßen Forschungsthemen bietet eine solide Grundlage, um die Herausforderungen der Zukunft erfolgreich zu meistern und die Fähigkeiten von KI bis hin zu intelligenten, erinnerungsfähigen Agenten weiter zu verbessern.