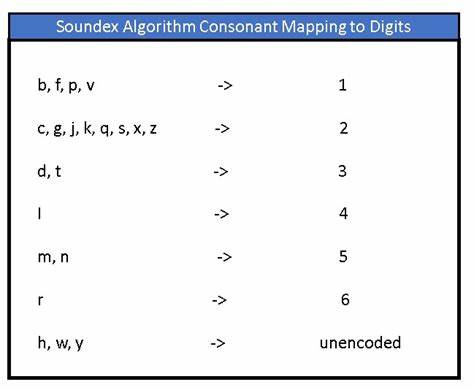

Die Verarbeitung und Bereinigung von Daten ist eine der größten Herausforderungen in der heutigen digitalen Welt. Insbesondere wenn es um die Identifikation und den Abgleich von Namen, Begriffen oder Bezeichnungen geht, wird die korrekte Erkennung von Ähnlichkeiten zu einem entscheidenden Faktor. Klassische Algorithmen wie Soundex kommen hier seit Jahrzehnten zum Einsatz, um phonetische Ähnlichkeiten von Wörtern zu erkennen – ein Verfahren, das bei einzelnen Wörtern hervorragende Resultate liefert, aber bei Kombinationen aus mehreren Wörtern beziehungsweise bei gewandelten Wortfolgen deutliche Schwächen zeigt. Die Notwendigkeit einer präziseren und flexibel anwendbaren Methode führte zu einer innovativen Weiterentwicklung des Soundex-Verfahrens, die diese Probleme gezielt angeht und so eine bedeutende Verbesserung im Bereich der Datenbereinigung und -analyse bietet. Soundex wurde ursprünglich entwickelt, um ähnlich klingende Wörter oder Namen anhand ihrer Aussprache zu kodieren.

Dabei werden die Wörter in eine spezifische Zeichenfolge umgewandelt, die phonetische Ähnlichkeiten abbildet. Das Problem entsteht, sobald man sich von einzelnen Wörtern wegbewegt: Mehrteilige Namen, zusammengesetzte Begriffe oder gar die Umstellung der Wortreihenfolge führen zu Inkonsistenzen oder falschen Übereinstimmungen. Ein Beispiel dafür ist der Vergleich der Namen „John Doe“ und „Doe Jonny“. Ein klassischer Soundex-Algorithmus wandelt diese Strings getrennt um und vergleicht die Ergebnisse, doch aufgrund unterschiedlicher Wortordnungen und variierender Schreibweisen ist das Ergebnis oft falsch oder irreführend. Die Weiterentwicklung des Soundex-Algorithmus setzt genau hier an.

Ziel ist es, Mehrwort-Strings nicht nur einfach zu kodieren, sondern sie so aufzubereiten, dass auch Umstellungen oder leichte Abweichungen verlässlich erkannt werden können. Dabei wird eine zusätzliche Verarbeitungsschicht eingeführt, die den ursprünglichen Soundex-Code neu anordnet oder in ein Format bringt, das flexibler mit verschiedenen Wortkombinationen umgehen kann. Diese Modifikation erlaubt es, dass „John Doe“ und „Doe Jonny“ in ihrer phonetischen Nähe besser erfasst werden, obwohl sie unterschiedliche Wortfolgen und einen leicht abgewandelten Namen enthalten. Eine wesentliche Herausforderung bei derartigen Optimierungen liegt darin, den Balanceakt zwischen Genauigkeit und Performance zu meistern. Denn insbesondere bei der Analyse umfangreicher Datensätze oder in Echtzeit-Anwendungen darf die Rechenzeit nicht signifikant steigen.

Die Lösung besteht darin, nur minimale und vor allem effiziente Zusatzschritte hinzuzufügen, ohne die Grundlogik von Soundex grundlegend zu verändern oder dessen etablierte Stärken zu verlieren. Das Ziel ist, eine nahtlose Integration der verbesserten Technik in bestehende Prozesse und Werkzeuge zu ermöglichen. In der Praxis bedeutet diese Verbesserung für Anwender vor allem eine deutlich zuverlässigere automatisierte Datenbereinigung. Gerade in Unternehmen, die auf adressbasierte Massenkorrekturen, Kundendatenbankpflege oder Lieferantenvergleiche angewiesen sind, führt das zu einem spürbar höheren Grad an Datenqualität. Fehlerhafte Doppeleinträge, durch veränderte Namen oder Tippfehler entstanden, lassen sich deutlich leichter erkennen und effizient entfernen.

Auch Prozesse wie das Zusammenführen unterschiedlicher Datenquellen profitieren davon, wenn mehrdeutige Wortkombinationen besser abgeglichen werden können. Ein weiteres Anwendungsfeld liegt im sogenannten Fuzzy Matching. Hierbei werden nicht exakt gleiche, aber ähnliche Daten erkannt und berücksichtigt. Die verbesserte Soundex-Variante macht es möglich, komplexere Übereinstimmungen herzustellen, selbst wenn die Daten teilweise unterschiedlich kodiert oder gestaltet sind. Für Suchmaschinen- oder Filterfunktionen, die natürliche Sprache verarbeiten, eröffnet dies ganz neue Möglichkeiten, Suchanfragen besser zu verstehen und relevantere Ergebnisse anzuzeigen.

Darüber hinaus vereinfacht die neue Methode das Extrahieren einzigartiger Werte aus großen, heterogenen Datensätzen. Dadurch können Unternehmen und Entwickler effizienter arbeiten und weniger Zeit in manuelle Nachkontrollen investieren. Besonders in Zeiten großer Datenmengen ist Automatisierung und hohe Algorithmen-Qualität von entscheidendem Vorteil. Ein anschauliches Beispiel dafür stellt die Nutzung in Google Sheets dar, einer der meistverwendeten Plattformen für einfache bis mittlere Datenverarbeitung. Mit dem neuen Flookup Data Wrangler Add-On, das auf der verbesserten Soundex-Variante basiert, können Nutzer ohne Programmierkenntnisse umfangreiche Datenreinigungsaufgaben bewältigen.

Funktionen wie das Markieren und Zusammenführen doppelter Einträge oder das Aufspüren ungewöhnlicher Schreibweisen werden dadurch stark vereinfacht und beschleunigt. Neben der Technologie selbst ist der offene Austausch und die kontinuierliche Weiterentwicklung von Algorithmen wie Soundex ein wesentlicher Aspekt in der Data-Science-Community. Projekte, bei denen Entwickler und Anwender ihre Erkenntnisse und Anpassungen teilen, fördern ein besseres Verständnis und sorgen für Innovationen, die wiederum breitere Anwendung finden und mehr Probleme lösen können. Die verbesserte Soundex-Methode beweist, dass klassische Algorithmen keineswegs veraltet sind, sondern durch gezielte Anpassung an heutige Anforderungen modernisiert und zukunftssicher gemacht werden können. Durch die Kombination aus tiefer phonologischer Analyse und smarter Nachbearbeitung flexibler Formate tragen solche Innovationen entscheidend dazu bei, Datenqualität auf ein neues Level zu heben und den Umgang mit komplexen Datensätzen radikal zu verbessern.

Abschließend lässt sich sagen, dass eine verbesserte Soundex-Lösung, die mehrteilige und neu angeordnete Strings kompetent handhabt, im Bereich der Datenbereinigung, Analyse und Verarbeitung zum unverzichtbaren Werkzeug wird. Sie adressiert grundlegende Schwächen herkömmlicher Ansätze, reduziert Fehlerquellen und schafft die Voraussetzung für effizientere und automatisierte Arbeitsprozesse. Für alle, die regelmäßig mit großen oder heterogenen Datenmengen arbeiten, stellt die Beschäftigung mit solchen Innovationen einen wesentlichen Schritt Richtung smarter Datenverarbeitung dar. Die Zukunft der Datenqualität und phonetischen Erkennung bewegt sich damit auf einem spannenden und hochrelevanten Kurs.

![What Every Computer Scientist Should Know About Floating-Point Arithmetic [pdf]](/images/69156BFE-5D72-4044-A59E-1C207FE961AA)