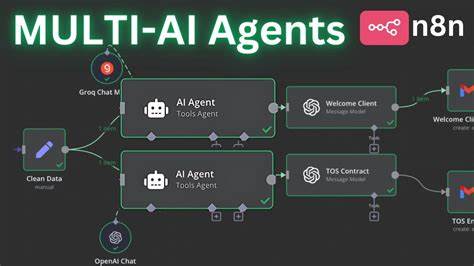

Die rasante Entwicklung großer Sprachmodelle (LLMs) hat neue Möglichkeiten für künstliche Intelligenz eröffnet. Insbesondere im Bereich der KI-Agenten, die komplexe Aufgaben eigenständig bearbeiten können, erkennt man eine große Vielfalt an Ansätzen. Dennoch zeigt sich aus der Praxis deutlich, dass der Trend hin zu Multi-Agenten-Systemen vielfach auf Schwierigkeiten stößt und häufig nicht die erhoffte Zuverlässigkeit bietet. Anstatt blind auf Mehrfachagenten zu setzen, sollten Entwickler und Unternehmen zunächst verstehen, warum diese Architektur so problematisch ist – und wie der Weg zu effektiveren und stabileren KI-Agenten aussehen kann. Die zentrale Herausforderung bei der Nutzung von Multi-Agenten besteht im Umgang mit Kontext und der Kommunikation zwischen untergeordneten Agenten.

Wenn eine Hauptaufgabe in mehrere Teilaufgaben aufgeteilt wird, die von unterschiedlichen Subagenten parallel bearbeitet werden, entstehen oft Missverständnisse und Inkonsistenzen. Jeder Subagent interpretiert seine Aufgabe basierend auf einem fragmentierten Kontext, was zu Konflikten bei den Ergebnissen führt. So kann beispielsweise bei der Entwicklung eines Spiels ein Subagent einen Hintergrund im Stil von Super Mario Bros. erstellen, während ein anderer Agent einen Vogel inklusive Bewegungslogik entwirft, der weder dem Spielkonzept noch der Ästhetik des Hintergrunds entspricht. Dieses Problem ist kein Einzelfall, sondern spiegelt die Fragilität dieser Architektur wider.

Diese fehlende Konsistenz entsteht vor allem wegen der fehlenden gemeinsamen Wissensbasis. Multi-Agenten teilen oft nur einzelne Nachrichten untereinander, nicht jedoch den vollständigen Entscheidungspfad oder die gesamte Kontext-Historie. Ohne gegenseitiges Verständnis der bereits getroffenen Entscheidungen wirken die Aktionen der Subagenten wie isolierte Puzzleteile, die nicht zusammenpassen. Dies ist eine fundamentale Schwäche, da jede Handlung implizite Entscheidungen mit sich bringt. Werden diese unter verschiedenen Agenten nicht abgestimmt, führt das schnell zu widersprüchlichen Ergebnissen und beeinträchtigt massiv die Zuverlässigkeit.

Kontext-Engineering ist deshalb eine Schlüsselkompetenz bei der Entwicklung von langlebigen und robusten KI-Agenten. Anstelle isolierter Subagenten sollte der gesamte Verlauf der Aufgabenbearbeitung für alle beteiligten Prozesse zugänglich sein. Im Optimalfall erhalten alle Teilakteure gleichzeitig Zugang zu den gesammelten Informationen, damit die getroffenen Entscheidungen auf einer einheitlichen Wissensbasis beruhen. Bei langen Gesprächen oder komplexen Task-Sequenzen bedeutet das, dass frühere Aktionen, Überlegungen und Entscheidungen stets als Grundlage für die nächsten Schritte dienen. Ohne dieses Prinzip droht ein exponentielles Anwachsen von Fehlerquellen, das sich über den Prozess hinweg kaum mehr kontrollieren lässt.

Aus technischer Sicht ist es heute noch schwierig, extrem lange Kontextfenster abzubilden. Die meisten großen Sprachmodelle haben begrenzte Kapazitäten, wie viele Tokens gleichzeitig verarbeitet werden können. Dennoch zeigen neuere Ansätze, dass es möglich ist, durch gezielte Kompression und Zusammenfassung von Konversationen die wichtigsten Ereignisse und Entscheidungen herauszufiltern und so die für den Agenten relevanten Informationen langfristig im „Gedächtnis“ zu behalten. Ein dedizierter kleinerer Komprimierungsmodell kann dabei helfen, irrelevante Details zu reduzieren, ohne dass der Sinn der Aufgabe verloren geht. Solche Strategien verbessern die Leistungsfähigkeit langfristiger, zusammenhängender Agenten-Aufgaben erheblich.

Ein weiterer entscheidender Punkt ist die Strukturierung der Agentenarchitektur. Der Verzicht auf parallellaufende Subagenten zugunsten eines single-threaded oder linear aufgebauten Agentenflusses kann die Fehleranfälligkeit deutlich reduzieren. Solche Agenten bearbeiten die Aufgaben Schritt für Schritt, wobei jede neue Aktion auf dem vollständigen, aktuellen Kontext aufbaut. Auch wenn das den vermeintlichen Nachteil hat, weniger parallele Arbeitsschritte zu ermöglichen, überzeugt diese Vorgehensweise durch eine höhere Verlässlichkeit und bessere konsistente Ergebnisse. Berühmte Beispiele zeigen den Nutzen dieses Ansatzes.

Claude Code etwa arbeitet mit Subagenten, die nur nacheinander und meist für gut definierte Rückfragen eingesetzt werden. Diese Subagenten übernehmen keine komplexen parallelen Arbeiten, sondern unterstützen den Hauptagenten, ohne den Kontext der Gesamtautomatisierung zu verlieren. Eine solche Maßnahme widerspricht zwar dem idealisierten Bild von autonomen, vernetzten Subagenten, ist aber ein bewährter Weg, die Probleme der Kontext-Bruchstücke zu umgehen. Ähnlich verhält es sich bei Edit-Apply-Modelle, die in der Programmierunterstützung eingesetzt werden. Früher wurden große Modelle verwendet, um Änderungsanweisungen zu formulieren, die dann an kleinere Modelle weitergegeben wurden, um den eigentlichen Code zu ändern.

Der Nachteil war eine erhöhte Fehlerquote, da Missverständnisse zwischen den Modellen zu falschen Änderungen führten. Heute erledigt ein großes Modell oft die komplette Arbeit – vom Verstehen bis zur Anwendung der Änderung – in einer einzigen, zusammenhängenden Aktion. Diese Vereinfachung verbessert die Zuverlässigkeit und reduziert Fehlerraten. Trotz Verlockung, parallele Prozesse durch mehrere kommunizierende Agenten zu realisieren – ähnlich wie menschliche Teams in Meetings – sind heutige KI-Agenten dafür noch nicht reif. Ein zuverlässiger Austausch und eine produktive Auseinandersetzung zwischen mehreren Agenten über viele Konversationsrunden hinweg setzen ein genaues, gemeinsames Verständnis aller relevanten Informationen voraus, eine Fähigkeit, die aktuellen KI-Systemen fehlt.

Zwar hat die Forschung verschiedene Systeme ausprobiert, in denen mehrere Agenten interagieren, doch die daraus resultierenden Systeme sind meistens zerbrechlich und konfliktanfällig. Dies liegt daran, dass Lieferungen von Informationen, Entscheidungen und Kontexten zwischen Agenten sowohl technisch wie auch kognitiv äußerst anspruchsvoll sind. Durch die oft unzureichenden Kommunikationsmechanismen entstehen widersprüchliche Annahmen und Aktionen. Die Folge sind ineffiziente oder falsche Resultate, die das gesamte System in Verruf bringen können. Vor allem in produktiven Umgebungen, in denen Verlässlichkeit und Nachvollziehbarkeit entscheidend sind, sind solche Multi-Agenten-Modelle daher oft nicht praktikabel.

Ein Grundpfeiler für die Zukunft liegt daher darin, die Fähigkeiten einzelner Agenten zu verbessern – einschließlich ihrer Fähigkeit, komplexe, lange Kontextketten zu verstehen und konsistent zu handeln – bevor versucht wird, mehrere voneinander unabhängige Agenten zu vereinen. Die Forschung und Entwicklung sollte sich vermehrt darauf konzentrieren, das Kontextverständnis und die Entscheidungsnachvollziehbarkeit einzelner Agenten auszubauen, da sich so der Overhead durch Mehrfachagenten vermeiden lässt. Die Herausforderung, arbiträr lange und komplexe Kontexte zu verwalten, gilt als eine der schwierigsten im Bereich der KI-Agenten. Neue Methoden zur Kompression, zur extraktiven Zusammenfassung und zur kontextsensitiven Informationsselektion befinden sich in Entwicklung, und es ist wahrscheinlich, dass Fortschritte in diesen Bereichen den Weg für stabilere, langlebigere KI-Agenten ebnen werden. Die Philosophie hinter etablierten Technologien wie React im Webbereich zeigt, wie wichtig Konzepte wie Reaktivität und Modularität sind.

Genauso benötigt die Entwicklung von KI-Agenten ein solches klar definiertes, optimiertes Paradigma, bei dem Informationen gezielt, präzise und ganzheitlich gehandhabt werden. Aktuell weist der Trend eher auf ein „Roher HTML“-Zeitalter im Agentenbau hin – viele Experimente, große Vielfalt, aber wenig Standardisierung und immer wiederkehrende Fehlerquellen. Abschließend lässt sich sagen, dass Entwickler und Unternehmen, die KI-Agenten in der Praxis einsetzen möchten, gut beraten sind, klassische Multi-Agenten-Systeme kritisch zu hinterfragen oder ganz zu vermeiden. Stattdessen sollten sie den Schwerpunkt auf robustes Kontext-Engineering und den Aufbau konsistenter, linear arbeitender Agenten legen. Diese Strategie gewährt mehr Stabilität, bessere Nachvollziehbarkeit und letztlich bessere Ergebnisse in realen Anwendungen.

Nur so können KI-Agenten langfristig zuverlässig bleiben und ihr volles Potenzial entfalten.