Die rasante Entwicklung künstlicher Intelligenz hat in den letzten Jahren zahlreiche Durchbrüche hervorgebracht, doch OpenAI setzt mit der Einführung der Unterstützung für Reinforcement Fine-Tuning eine neue Benchmark. Reinforcement Fine-Tuning, oft als eine Mischung aus Reinforcement Learning und der traditionellen Feinabstimmung von Modellen beschrieben, stellt eine revolutionäre Methode dar, um KI-Systeme noch effektiver und anpassungsfähiger zu machen. Der Schritt von OpenAI zielt darauf ab, sowohl die Leistungsfähigkeit als auch die Anpassungsfähigkeit von Modellen wie GPT-4 oder zukünftigen Iterationen zu verbessern. Um die Tragweite dieser Entwicklung zu verstehen, ist es wichtig, den Begriff Reinforcement Fine-Tuning im Detail zu betrachten. Reinforcement Learning basiert auf der Idee, Systeme durch Belohnungen zu trainieren, sodass sie lernen, optimale Entscheidungen zu treffen.

Die Feinabstimmung hingegen ist ein Prozess, bei dem ein vortrainiertes Modell durch zusätzliche Trainingsdaten an spezifische Aufgaben angepasst wird. Die Verbindung dieser beiden Ansätze ergibt ein Verfahren, bei dem ein KI-Modell nicht nur anhand statischer Daten lernt, sondern aktiv aus seinem Verhalten und den Rückmeldungen in seiner Umgebung verbessert wird. OpenAI setzt mit der Unterstützung von Reinforcement Fine-Tuning einen starken Fokus darauf, Modelle zu entwickeln, die flexibler auf komplexe Anforderungen reagieren können. Dies ist besonders relevant, da KI-Anwendungen immer vielfältiger und spezialisierter werden. Beispielsweise können Chatbots durch RFT gezielter auf Nutzereingaben eingehen, indem sie kontinuierlich aus Interaktionen lernen und ihre Antworten verbessern.

Für Unternehmen bedeutet dies einen deutlichen Mehrwert, da KI-Lösungen individueller auf Kundenbedürfnisse und dynamische Veränderungen reagieren können. Ein weiterer wichtiger Vorteil von Reinforcement Fine-Tuning ist die Effizienzsteigerung im Trainingsprozess. Traditionelle Feinabstimmungsprozesse benötigen oft große Mengen an gekennzeichneten Daten, was kostenintensiv und zeitaufwendig ist. Durch den Einsatz von Belohnungsmechanismen kann das Modell in vielen Fällen mit weniger direkten Anweisungen lernen, da es selbst durch Erfolgs- oder Misserfolgssignale lernt, seine Strategien anzupassen. Dies macht die Entwicklung und den Einsatz von KI-Technologien auch für kleinere Unternehmen und Projekte zugänglicher.

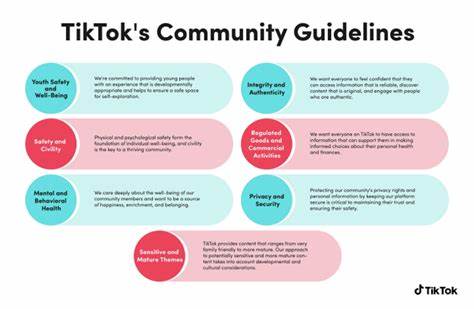

Die Kombination von OpenAIs leistungsfähigen vortrainierten Modellen mit der Flexibilität von Reinforcement Fine-Tuning eröffnet neue Horizonte für die KI-Forschung. Forscher können damit Hypothesen testen, Modelle in simulierten Umgebungen optimieren oder sogar KI-Systeme trainieren, Herausforderungen in Echtzeit zu bewältigen. Dies ist ein entscheidender Schritt hin zu selbstlernenden Systemen, die nicht nur auf statischen Daten basieren, sondern sich dynamisch weiterentwickeln. Darüber hinaus trägt die Einführung von Reinforcement Fine-Tuning bei OpenAI zur Verbesserung der KI-Sicherheit und Kontrolle bei. Durch die Möglichkeit, Belohnungsmechanismen speziell zu definieren, können Entwickler unerwünschtes Verhalten besser eindämmen und das Modell so trainieren, dass es ethische und regulatorische Standards einhält.

Gerade in Zeiten, in denen die gesellschaftliche Debatte über KI-Einsatz und -Verantwortung intensiv geführt wird, ist ein solcher Fortschritt von großer Bedeutung. Im wirtschaftlichen Kontext ermöglicht Reinforcement Fine-Tuning Unternehmen, schneller auf Marktveränderungen zu reagieren. Kundenfeedback kann unmittelbar in das Training der KI einfließen, wodurch Produkte und Dienstleistungen kontinuierlich optimiert werden. Dies führt zu einer verbesserten Kundenzufriedenheit und kann einen Wettbewerbsvorteil schaffen. Zudem fördert die Methode Innovationen, indem experimentelle Produktansätze direkt im laufenden Betrieb getestet und angepasst werden können.

Die technische Umsetzung der Unterstützung von Reinforcement Fine-Tuning bei OpenAI basiert auf einer Kombination von fortgeschrittenen Optimierungsalgorithmen und skalierbarer Infrastruktur. Dank der leistungsstarken Cloud-Dienste von OpenAI ist es möglich, große Mengen an Trainingsdaten in Echtzeit auszuwerten und das Modell laufend anzupassen. Dies bedeutet auch, dass Unternehmen keine umfangreichen eigenen KI-Infrastrukturen aufbauen müssen, sondern auf bewährte und sichere Systeme zurückgreifen können. Im Bildungssektor bietet die neue Möglichkeit, Modelle durch Reinforcement Fine-Tuning zu verbessern, Chancen für personalisiertes Lernen. Lernsysteme können sich individuell an die Bedürfnisse von Schülern und Studierenden anpassen und dynamisch auf deren Fortschritte reagieren.

Hierdurch entstehen neue Lernkonzepte, die den Lernerfolg nachhaltig unterstützen und zugleich das Engagement fördern. Die Ankündigung von OpenAI zur Unterstützung von Reinforcement Fine-Tuning ist somit ein Meilenstein, der vielfältige Auswirkungen auf verschiedene Branchen und Anwendungen haben wird. Sie zeigt, wie sich die künstliche Intelligenz weiterentwickelt und immer stärker in den Alltag integriert wird. Für Entwickler, Unternehmen und Nutzer eröffnet sich damit eine neue Welt von Möglichkeiten, die auf effizienteren, sichereren und flexibleren KI-Systemen basieren. Abschließend lässt sich festhalten, dass OpenAIs Schritt nicht nur eine technische Innovation darstellt, sondern auch die Zukunft der Mensch-Maschine-Interaktion prägen wird.

Die Fähigkeit der KI, durch belohnungsbasiertes Lernen kontinuierlich zu verbessern, führt zu intelligenteren, empathischeren und hilfreichen Systemen. Während die Diskussionen um ethische Richtlinien und Datenschutz weiterlaufen, zeigt OpenAI, wie verantwortungsbewusste Innovation im Bereich der künstlichen Intelligenz aussehen kann. Es bleibt spannend zu beobachten, wie sich Reinforcement Fine-Tuning in der Praxis bewährt und welche neuen Anwendungen und Forschungsansätze dieser Ansatz möglich macht. Für alle, die sich mit KI beschäftigen oder von ihr profitieren wollen, bietet OpenAIs Ankündigung eine wichtige Perspektive auf die Zukunft der Technologie.