Am 10. Juni 2025 begann um 6:00 Uhr UTC eine massive Störung im Heroku-Dienst, die viele Kunden weltweit für bis zu 24 Stunden in ihrer Arbeit stark beeinträchtigte. Heroku, eine weitverbreitete Platform as a Service (PaaS), die es Unternehmen ermöglicht, Applikationen in der Cloud schnell zu entwickeln, bereitzustellen und zu skalieren, war durch einen Fehler in der Produktionsinfrastruktur betroffen. Diese Störung war nicht das Resultat eines Sicherheitsvorfalls, und selbstverständlich ging kein Kundendatenverlust damit einher. Dennoch veranschaulicht diese Episode eindrücklich, wie selbst hochentwickelte Cloud-Dienste durch vermeidbare Systemschwächen aus der Bahn geworfen werden können und welche Lehren daraus gezogen werden sollten.

Der Ausfall begann mit unerwarteten Änderungen im System, die durch ein automatisiertes Update ausgelöst wurden. Dieses Update aktivierte eine Komponente, die eigentlich deaktiviert sein sollte, und führte dazu, dass der Netzwerkdienst auf den betroffenen Host-Systemen neugestartet wurde. Was zunächst harmlos wirkte, entpuppte sich als verhängnisvoll, denn der Neustart brachte eine kritische Schwachstelle im Netzwerkservice zum Vorschein. Das System nutzte eine veraltete Skriptlogik, die nach einem Neustart nicht korrekt sämtliche Routing-Regeln anwendete. Infolge dessen verloren alle auf diesen Hosts laufenden Dynos ihre ausgehende Netzwerkverbindung, was den Zugriff auf das Internet und somit den Betrieb vieler Anwendungen zum Erliegen brachte.

Zu komplizieren war die Situation dadurch, dass auch interne Werkzeuge von Heroku und insbesondere die Statusseite von diesem Fehler betroffen waren. Die Statusseite ist normalerweise der zentrale Anlaufpunkt für Kunden, um bei Störungen aktuelle Informationen zur Lage einzuholen. Da diese jedoch auf der gleichen betroffenen Infrastruktur lief, waren die Kommunikationswege stark eingeschränkt, was die Verwirrung und den Frust bei Anwendern weiter verstärkte. Heroku selbst hätte somit Schwierigkeiten, zeitnah über den Ausfall zu informieren und entsprechende Maßnahmen einzuleiten. Dies ist ein klassisches Beispiel für die Bedeutung von Redundanz in kritischen Kommunikationssystemen.

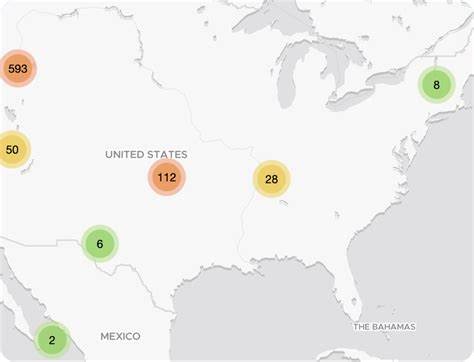

Die erste Phase des Ausfalls reichte von 6:00 bis etwa 8:26 UTC. Innerhalb dieses Zeitfensters stellte das Heroku-Team die massiven Leistungseinbußen und Verbindungsprobleme fest. Kunden meldeten sich mit Symptomen wie intermittierenden Login-Problemen, was einen weitreichenden Einfluss auf diverse Anwendungen hatte, die auf der Plattform liefen. Der Fokus lag zunächst darauf, herauszufinden, ob es sich um eine Netzwerkausfall bei einem Zulieferer handelte. Schnell wurde jedoch klar, dass das Problem innerhalb der eigenen Infrastruktur von Heroku lag.

Im zweiten Abschnitt der Störung, von 8:27 bis 13:42 UTC, konzentrierte sich die Ursachenforschung auf betroffene Hosts und deren Netzwerkzugänglichkeit. Dabei wurde herausgefunden, dass die Routing-Informationen, die für die Kommunikation der Dynos mit dem Internet notwendig sind, fehlten. Erst gegen 13:11 Uhr konnte ein unerwarteter Neustart eines Netzwerkdienstes als Ursache identifiziert werden, und um 13:42 Uhr wurde schließlich das automatisierte Upgrade eines Systempakets als Auslöser bestätigt. Dieses Upgrade war weder geplant noch abgestimmt und wurde aufgrund unzureichender Kontrollmechanismen zugelassen. Die dritte Phase umfasste Maßnahmen zur Minderung der Auswirkungen und Wiederherstellung des Betriebs.

Bereits ab 12:56 Uhr starteten Teams mit dem Neustart interner Instanzen, um zumindest Teile der Infrastruktur zu entlasten und eine Teilwiederherstellung zu erreichen. Gegen 13:58 Uhr wurde ein Workaround implementiert, mit dem Updates und Statusmeldungen über den Twitter-Account @herokustatus veröffentlicht werden konnten – ein Beleg für die Notwendigkeit unabhängiger Kommunikationskanäle bei großen Störungen. Über den Tag hinweg arbeiteten die Teams unermüdlich daran, den automatisierten Update-Prozess zu stoppen. So wurde der Token bei einem Zulieferer ungültig gemacht, was zwischen 17:30 und 19:18 Uhr endgültig verhinderte, dass weitere Hosts betroffen wurden. Gegen 20:59 Uhr war das Dashboard von Heroku wieder vollständig funktionstüchtig und schließlich wurde um 22:01 Uhr eine nahezu flächendeckende Neuinitialisierung aller Dynos durchgeführt, um einen stabilen Zustand der Plattform herzustellen.

Der nachfolgende Zeitraum bis zum Morgen des 11. Juni war geprägt von einer umfangreichen Nacharbeit. Die langfristigen Auswirkungen wie ausstehende Statusmails, Daten-Synchronisationen sowie Releases mussten abgearbeitet werden. Erst um 5:50 Uhr erklärte Heroku den Vorfall offiziell als beendet, nachdem die Stabilität umfassend überprüft worden war. Im Nachgang identifizierte Heroku drei zentrale Schwachstellen, die den Ausfall überhaupt ermöglicht hatten.

Der erste Aspekt betrifft die fehlenden Kontrollmechanismen, welche eine ungeplante Änderung an der Produktivumgebung zuließen. Neben fehlenden Sicherungen bezüglich der Unveränderlichkeit von Systemumgebungen wurde auch die Abhängigkeit von veralteten Netzwerkskripten kritisiert, die bei Neustart nicht korrekt funktionierten. Zweitens wurde die Kommunikation als unzureichend eingestuft. Der Umstand, dass die interne Statusseite selbst Teil der betroffenen Infrastruktur war, zeigt auf, wie wichtig externe und unabhängige Kommunikationsmittel sind, um in Krisenzeiten Transparenz und Kundeninformation aufrechtzuerhalten. Drittens wurde der Wiederherstellungsprozess als zu langsam und unkoordiniert eingeschätzt.

Unzulänglichkeiten in den diagnostischen Werkzeugen und fehlende Prozesse verzögerten die Fehlerbehebung und damit die Rückkehr zur Normalität. Heroku reagierte rasch und stellte konkrete Maßnahmen vor, um ähnliche Vorfälle in Zukunft zu verhindern. Die wichtigste Maßnahme ist das Einführen von strengen Unveränderlichkeitskontrollen in der Produktionsumgebung, um automatische, ungeplante Änderungen auszuschließen. Zudem sollen alle Basis-Images entsprechend geprüft und überarbeitet werden, damit Netzwerkroutinen auch bei Neustarts robust funktionieren. Besonders wichtig ist auch der Aufbau unabhängiger Kommunikationskanäle, die im Notfall eine unmittelbare und transparente Kundeninformation ermöglichen.

Darüber hinaus werden die Diagnose- und Wiederherstellungsprozesse modernisiert. Heroku investiert in neue Werkzeuge, die es Teams erlauben, Probleme schneller zu erkennen und die komplette Infrastruktur effektiv zu überwachen. Zudem werden Notfallprotokolle überarbeitet, um im Krisenfall eine schnelle Handlungsfähigkeit sicherzustellen. Die Ereignisse rund um den Heroku-Ausfall am 10. Juni 2025 sind ein prägnantes Beispiel dafür, wie vielschichtig technische Probleme in großen Cloud-Plattformen sein können und wie wichtig Prävention, Kommunikation und schnelle Reaktion sind.

Für jeden Nutzer von Cloud-Diensten sind diese Erfahrungen wertvoll, da sie zeigen, welche Risiken trotz modernster Technologie immer bestehen und wie Anbieter die Zuverlässigkeit und das Vertrauen durch kontinuierliche Verbesserungen hochhalten müssen. In einer immer stärker digitalisierten Welt, in der Geschäftskritische Anwendungen zunehmend in der Cloud laufen, unterstreicht dieser Vorfall zudem die Notwendigkeit, bei der Wahl von Cloud-Partnern auf deren Sicherheits- und Ausfallsicherheitskonzepte zu achten. Heroku hat mit seinen bereits angekündigten Verbesserungen den richtigen Weg eingeschlagen, um das Vertrauen seiner Kunden zurückzugewinnen und künftige Herausforderungen besser zu meistern. Die ständige Weiterentwicklung der Plattform und der internen Prozesse ist ein Muss, um den hohen Erwartungen an Verfügbarkeit, Performance und Sicherheit gerecht zu werden. Zusammenfassend lässt sich sagen, dass der Heroku-Ausfall vom 10.

Juni 2025 trotz aller Schwierigkeiten ein Anlass ist, aus Fehlern zu lernen und durch gezielte technische und organisatorische Maßnahmen die Resilienz moderner Cloud-Dienste zu erhöhen. Anbieter, Nutzer und die gesamte IT-Community profitieren davon, wenn Transparenz, schnelle Problemlösung und präventive Strategien Hand in Hand gehen.