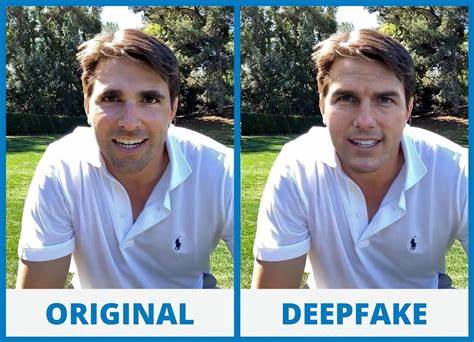

In der heutigen digitalen Ära ist die Authentizität von Stimmen und Anrufen zunehmend gefährdet. Deepfake-Technologien, die ursprünglich zur Unterhaltung oder für experimentelle Zwecke entwickelt wurden, haben sich zu einem mächtigen Werkzeug für Kriminelle entwickelt. Diese können täuschend echte Audioaufnahmen erzeugen, die es Betrügern ermöglichen, Personen oder Unternehmen zu imitieren und damit massiven Schaden anzurichten. Die Sorge um Stimme als Identitätsnachweis wächst, denn wenn sogar unsere Ohren uns täuschen können, stellt sich die Frage, wie man sich noch sicher fühlen kann. Es sind keine Science-Fiction-Szenarien mehr, sondern Realität: Deepfake-Anrufe, die so echt klingen, dass sie selbst geübte Ohren verwirren.

Der Bedarf an wirksamen Abwehrmechanismen wird immer größer, und hier kommt eine innovative Lösung ins Spiel – Spectrogram AI. Diese KI-basierte Technologie nutzt Spektrogramm-Analysen, um selbst die feinsten Unregelmäßigkeiten in der Audioaufnahme zu erkennen und so echte Stimmen von gefälschten zu unterscheiden. Die Verbreitung von Deepfake-Anrufen hat in den letzten Jahren rapide zugenommen. Laut Berichten entstehen durch Stimm-Imitationen allein jährlich Verluste in Milliardenhöhe. Besonders betroffen sind Branchen, die stark auf telefonische Kommunikation setzen, etwa Finanzdienstleister, Kundenservice-Zentren, Telekommunikationsanbieter oder das Gesundheitswesen.

Ein prominentes Beispiel zeigt, wie ein Unternehmen Opfer eines Betrugs wurde, bei dem der Stimmklon des Finanzvorstands verwendet wurde, um eine Transaktion über Millionen zu autorisieren. Diese Vorfälle verdeutlichen die Dringlichkeit, nicht nur traditionelle Sicherheitsmaßnahmen zu verbessern, sondern auch neue Technologien in den Kampf gegen Deepfake-Bedrohungen zu integrieren. Spectrogram AI ist eine solche hochmoderne Methode, die auf der Analyse von Mel-Spektrogrammen basiert. Spektrogramme sind visuelle Darstellungen der Frequenzspektren eines Audio-Signals über die Zeit. Sie ermöglichen es, Muster und Charakteristika zu erkennen, die menschlichen Ohren oft verborgen bleiben, insbesondere wenn Audio manipuliert oder synthetisch erzeugt wurde.

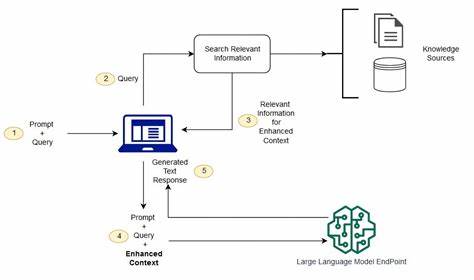

Durch den Einsatz von KI können diese Spektrogramme systematisch untersucht und verdächtige Merkmale identifiziert werden, die auf eine Fälschung hindeuten. Ein wesentlicher Vorteil dieser Herangehensweise besteht darin, dass sie nicht nur auf offensichtliche Artefakte achtet, sondern auch subtile Verfälschungen erkennt, die beim Abspielen in Echtzeit kaum wahrnehmbar sind. Um eine zuverlässige Detektion zu gewährleisten, ist eine ausgewogene und umfassende Datengrundlage von enormer Wichtigkeit. Spectrogram AI nutzt sowohl reale als auch synthetisch generierte Audio-Datensätze – darunter das renommierte ASV Spoof 2019 Dataset sowie eigens erzeugte Aufnahmen mit Deepfake-Tools wie Orpheus. Diese Kombination erlaubt es, das System an sehr unterschiedliche Szenarien und Angriffsmethoden zu gewöhnen.

Allerdings ist die Bereinigung und Aufbereitung dieser Datensätze ein komplexer Prozess. Es gilt, die Balance zwischen echten und gefälschten Audiodateien sicherzustellen, um Verzerrungen im Training zu vermeiden. Zusätzlich kommen verschiedene Datenaugmentierungstechniken wie Zeitverschiebung, Rauschüberlagerung, Pitch-Verschiebung und Verstärkungsanpassungen zum Einsatz, um die Modelle resistenter gegen unterschiedlichste Angriffssituationen zu machen. Die Audio-Daten werden anschließend in Mel-Spektrogramme umgewandelt und durch so genannte Maskierungstechniken ergänzt. Diese maskieren zufällige Bereiche im Zeit- oder Frequenzbereich des Spektrogramms und simulieren so verschiedene Verschlechterungen oder Störungen im Audio.

Dies hilft dem Modell, allgemeinere und robustere Muster zu erkennen und nicht nur auf bestimmte Artefakte zu achten. Die Programmierung dieser Funktionen erfolgt meist mit modernen Deep-Learning-Frameworks wie PyTorch und dem Audio-Toolkit Torchaudio. Die Entwickler haben eine praktische Audio Utility Class entwickelt, die neben dem Laden und Resamplen der Dateien auch verschiedene Augmentierungsfunktionen bereitstellt. Dazu zählen unter anderem das Zuschneiden oder Auffüllen der Audiodaten auf eine einheitliche Dauer, Zufallsverschiebungen, das Hinzufügen von Rauschen sowie Tonhöhenveränderungen. Diese Methoden tragen entscheidend zur Qualität des Trainings bei und ermöglichen eine bessere Generalisierung des Modells auf neue, bislang unbekannte Audioaufnahmen.

In der Trainingsphase kommen oft neuronale Netzwerke wie ResNet18 kombiniert mit bi-direktionalen Gated Recurrent Units (Bi-GRU) zum Einsatz. Diese Architektur erlaubt es, sowohl lokale Merkmale der Audiodaten (durch ResNet) als auch zeitliche Muster (durch GRU) zu erfassen, was bei linguistischen und akustischen Signalen von zentraler Bedeutung ist. Die Einsatzszenarien für Spectrogram AI sind vielfältig: Unternehmen können beispielsweise telefonisch eingehende Kundenanrufe in Echtzeit prüfen, um betrügerische Stimmen zu identifizieren, bevor sensible Daten preisgegeben oder Transaktionen autorisiert werden. In Contact Centern könnten Mitarbeitende zusätzlich durch eine Warnung unterstützt werden, wenn eine gefälschte Stimme erkannt wird. Auch für Privatpersonen gibt es Potenziale, etwa durch Apps, die Anrufe auf Deepfake-Anomalien scannen.

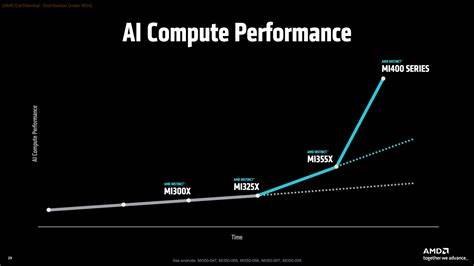

Die Zukunft der Deepfake-Erkennung basiert stark auf der Kombination verschiedener Ansätze. Spectrogram AI stellt einen wichtigen Baustein dar, der durch seine Spektrogramm-basierte Analyse viele Schwachstellen traditioneller Erkennungsmethoden aushebelt. Doch die Technologie muss stetig weiterentwickelt werden, um mit immer raffinierteren Deepfake-Techniken Schritt halten zu können. Dabei spielt auch die Zusammenarbeit mit Expertinnen und Experten aus den Bereichen Künstliche Intelligenz, Cybersecurity und Audiotechnik eine entscheidende Rolle. In diesem Zusammenhang sind Offenheit und Austausch innerhalb der Community unverzichtbar, um Wissen zu bündeln und neu entstehende Bedrohungen frühzeitig zu erkennen und abzuwehren.

Es ist abzusehen, dass Deepfake-Betrügereien keine einmaligen Ausnahmen bleiben, sondern sich zu einer systematischen Bedrohung mit steigendem Schadenspotential entwickeln. Nur durch den Einsatz innovativer Technologien wie Spectrogram AI in Verbindung mit sorgfältiger Datenvorbereitung und kluger Modellarchitektur kann diesen Risiken wirksam begegnet werden. Neben den technischen Mitteln sind auch Aufklärung und Sensibilisierung von Nutzern zentral, damit die Gesellschaft die Gefahren von manipulativen Audio-Technologien besser versteht und angemessen reagiert. Zusammenfassend steht die Entwicklung von Spectrogram AI sinnbildlich für den zukunftsweisenden Kampf von Mensch und Maschine gegen eine wachsende digitale Täuschungsgefahr. Indem solche Systeme in den Alltag integriert werden, schaffen sie eine zusätzliche Sicherheitsbarriere, die Vertrauen in die Telefonkommunikation und andere sprachbasierte Identitätsnachweise stärkt.

Die Kombination aus exzellenter Datengrundlage, intelligenten Audioaugmentierungen und modernster KI-Architektur macht Spectrogram AI zu einem vielversprechenden Werkzeug im Spiel gegen Täuschung durch Deepfake-Anrufe – ein notwendiger Schritt in Richtung eines sichereren digitalen Zusammenlebens.