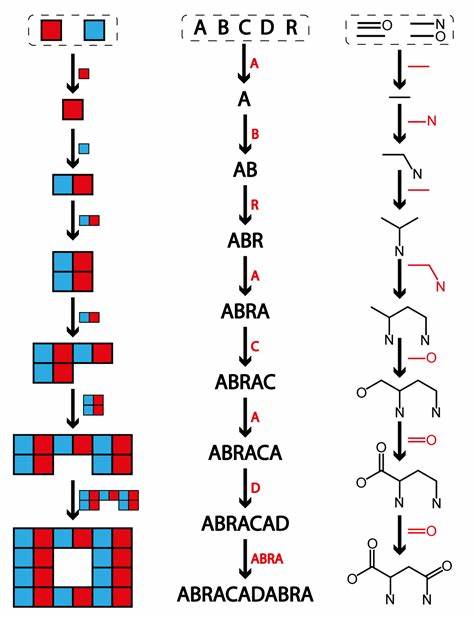

Die Fähigkeit, den nächsten Wortvorschlag in einem Satz präzise vorherzusagen, hat die Art und Weise verändert, wie Menschen mit digitalen Geräten interagieren. Von Smartphones über Sprachassistenten bis hin zu komplexen Chatbots: Die Technologie hinter der Vorhersage des nächsten Wortes basiert auf tiefgreifenden Lernalgorithmen, die den Kontext und die gelernten Muster verstehen. Die Herausforderung liegt in der Komplexität menschlicher Sprache, die von Grammatik, Semantik bis zu kulturellen und situativen Hintergründen geprägt ist. Daher ist es essenziell, dass intelligente Systeme neben isolierten Wörtern auch den gesamten Kontext berücksichtigen, um relevante Vorhersagen zu ermöglichen. Kontextualisierung ist der Schlüssel zur effizienten Wortvorhersage.

Dies bedeutet, dass das System die bisherige Wortfolge analysiert und daraus Rückschlüsse zieht, welcher Begriff als nächstes folgen könnte. Hierzu werden umfangreiche Datenmengen benötigt, die als Trainingsgrundlage für die Algorithmen dienen. Das Training erfolgt meist anhand von großen Textkorpora, die vielfältige Sprachmuster und Formulierungen beinhalten. Durch maschinelles Lernen kann das System Zusammenhänge erkennen, Wahrscheinlichkeiten berechnen und somit mit zunehmender Datenmenge immer genauere Ergebnisse liefern. Ein weitverbreitetes Modell, das für diese Aufgabe eingesetzt wird, ist das sogenannte neuronale Netzwerk, genauer gesagt rekurrente neuronale Netzwerke (RNN) und neuere Varianten wie Transformer-Modelle.

Diese Netzwerke sind darauf ausgelegt, sequenzielle Daten zu verarbeiten und können daher den Fluss von Wörtern in einem Satz nachvollziehen. Durch Schichten von Neuronen, die miteinander verbunden sind, wird jeder Eingabewert transformiert, sodass immer komplexere Sprachmuster erfasst werden können. Transformermodelle, angeführt von Technologien wie BERT und GPT, haben die Qualität der nächsten Wortvorhersage deutlich verbessert, indem sie längere Kontextfenster berücksichtigen und so feinere Nuancen erfassen. Die Bedeutung der Wortvorhersage geht weit über einfache Textergänzung hinaus. Im Alltag erleichtert sie Tippfehlerkorrekturen und beschleunigt die Kommunikation.

Für Menschen mit motorischen Einschränkungen kann die präzise Vorhersage die Barrierefreiheit verbessern und eine natürliche Interaktion ermöglichen. Auch in der professionellen Welt eröffnet sie neue Möglichkeiten, von der automatischen Erstellung von Texten bis hin zur intelligenten Analyse großer Dokumentenmengen. Innerhalb der Forschung wird die Technologie weiterentwickelt, um nicht nur das nächste Wort, sondern ganze Sätze und sogar komplexe Dialoge vorherzusagen, die auf priorisiertem Kontext basieren. Eine große Herausforderung ist zudem die Qualität der aufgenommenen Trainingsdaten. Sprache ist dynamisch und variiert stark in Dialekten, Fachjargon und kreativen Neuschöpfungen.

Um diese Vielfalt abzubilden, müssen die Trainingsdaten breit gefächert und laufend aktualisiert werden. Gleichzeitig gilt es, Verzerrungen zu vermeiden, die durch unfaire oder einseitige Daten entstehen könnten. Die Optimierung der Algorithmen beinhaltet deshalb auch Regularisierungsmaßnahmen, die Überanpassung verhindern und das Modell generalisierbar halten. Der Code, der hinter der Wortvorhersage steckt, ist oft hochkomplex. Er enthält annotationsreiche Kommentare, die den Lernprozess, die Datenvorverarbeitung und die konkrete Vorhersagelogik verständlich machen.

Entwicklern helfen solche Dokumentationen, die Mechanismen der Wortvorhersage besser zu durchdringen und das System an spezifische Anforderungen anzupassen. Das Annotationssystem ermöglicht eine nachvollziehbare Entwicklung, in der sowohl der Kontext der Eingabedaten als auch die Funktionen der einzelnen Module klar definiert sind. Neben der Kernlogik spielen auch technische Aspekte eine Rolle. Beispielsweise ist die Optimierung der Rechenleistung unerlässlich, um Wortvorhersagen in Echtzeit zu ermöglichen. Durch den Einsatz von GPUs und spezialisierter Hardware können komplexe Modelle schneller trainiert und eingesetzt werden.

Zudem gibt es Frameworks und Programmbibliotheken, die die Implementierung erleichtern, indem sie standardisierte Module für neuronale Netze und Datentransformationen bereitstellen. Die Zukunft der nächsten Wortvorhersage sieht vielversprechend aus. Mit fortschreitender Rechenleistung und immer besseren Algorithmen wird die Genauigkeit weiter zunehmen. Zusätzlich bieten multimodale Ansätze neues Potenzial, bei denen neben Text auch Audio, Bilder oder Kontextinformationen berücksichtigt werden, um Vorhersagen noch natürlicher und situationsbezogener zu gestalten. So könnten intelligente Systeme zukünftig nicht nur Wörter, sondern ganze Ideen oder Stimmungen vorhersehen und verarbeiten.