In einer Welt, die zunehmend von Künstlicher Intelligenz (KI) durchdrungen wird, wächst auch der Bedarf an Systemen, die nicht nur Entscheidungen treffen, sondern diese auch nachvollziehbar und transparent erklären können. Erklärbare Künstliche Intelligenz, auch bekannt als Explainable AI (XAI), ist ein bedeutendes Forschungsfeld, das genau dieses Ziel verfolgt: die Black-Box-Modelle der KI zu öffnen und für Menschen verständlich zu machen. Die Entwicklung von XAI ist dabei von zentraler Bedeutung, um Vertrauen, Sicherheit und Akzeptanz für KI-Technologien in verschiedensten Anwendungsbereichen zu fördern. Doch was verbirgt sich genau hinter dem Begriff der erklärbaren KI, welche Techniken kommen zum Einsatz und welche Herausforderungen bestehen? Dieser Beitrag widmet sich all diesen Aspekten und gibt einen tiefgreifenden Einblick in die Welt der erklärbaren künstlichen Intelligenz. Erklärbare Künstliche Intelligenz ist ein Bereich innerhalb der KI, der sich mit der Verbesserung der Nachvollziehbarkeit und Transparenz von KI-Systemen beschäftigt.

Während viele moderne Machine-Learning-Modelle, insbesondere solche auf Basis tief neuronaler Netze, hervorragende Leistungen erzielen, bleiben ihre Entscheidungswege für Menschen oft unzugänglich – man spricht in diesem Zusammenhang von sogenannten Black-Box-Modellen. Diese Modelle liefern zwar Ergebnisse oder Prognosen, doch der Prozess, wie sie zu diesen gekommen sind, ist häufig nicht verständlich. Hier setzt XAI an, um Mechanismen, Entscheidungsgründe und Einflussfaktoren sichtbar zu machen. Dies ist besonders in sensiblen Bereichen wie Medizin, Finanzwesen, Justiz oder Verteidigung relevant, wo es essenziell ist, Entscheidungen nachvollziehen, begründen und prüfen zu können. Hintergrund und Notwendigkeit von XAI liegen unter anderem darin, dass KI-Systeme heute zunehmend autonom handeln und Entscheidungen mit großer Tragweite treffen – beispielsweise bei der Diagnose von Krankheiten, Kreditwürdigkeitsprüfungen oder Strafzumessungen.

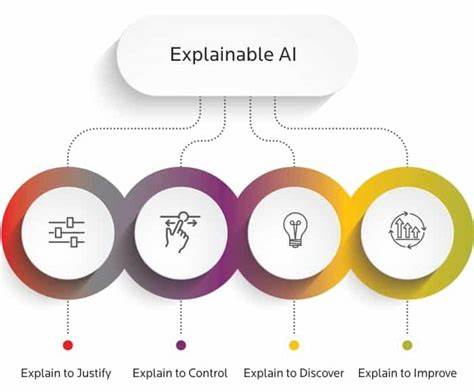

Ohne transparente Erklärungen der zugrundeliegenden Modelle können Nutzer und Betroffene keine fundierte Einschätzung der Zuverlässigkeit und Fairness der KI vornehmen. Außerdem können Fehler, Voreingenommenheiten (Bias) oder manipulative Muster in den Modellen verborgen bleiben, wenn keine Erklärungen vorliegen. Dadurch steigt nicht nur das Risiko falscher Entscheidungen, sondern auch die allgemeine Skepsis gegenüber KI-Technologien. XAI zielt somit darauf ab, diese Lücke zu schließen, indem sie Nutzern ermöglicht, die Entscheidungsfindung der KI zu verstehen, zu bewerten und gegebenenfalls zu hinterfragen. Die Prinzipien von XAI basieren wesentlich auf den drei Säulen Transparenz, Interpretierbarkeit und Erklärbarkeit.

Transparenz bedeutet, dass die Art und Weise, wie ein Modell trainiert und Entscheidungen getroffen werden, offenlegbar und nachvollziehbar ist. Interpretierbarkeit wiederum beschreibt das Maß, in dem Menschen die Funktionsweise und die Outputs eines Modells verstehen können. Erklärbarkeit schließlich bezieht sich auf das Erzeugen von nachvollziehbaren Begründungen für konkrete Vorhersagen oder Entscheidungen eines KI-Systems, oft auch angepasst an die jeweilige Fragestellung oder den Nutzer. Zusammen schaffen diese Prinzipien eine Grundlage für bessere Kontrolle, Debugging, sowie eine vertrauensvolle Zusammenarbeit zwischen Mensch und Maschine. Es gibt diverse Methoden und Techniken, um Erklärungen aus KI-Modellen zu generieren.

Eine zentrale Unterscheidung besteht zwischen intrinsisch interpretierten Modellen und post-hoc Erklärverfahren. Intrinsische Modelle, häufig auch als White-Box-Modelle bezeichnet, sind so konstruiert, dass sie von Haus aus verständlich sind – zu ihnen zählen einfache Entscheidungsbäume, lineare Modelle oder symbolische Ansätze, bei denen Eingaben und Entscheidungen transparent bleiben. Diese Modelle haben jedoch manchmal den Nachteil, dass sie in ihrer Leistungsfähigkeit begrenzt sind und komplexe Zusammenhänge weniger gut abbilden können. Demgegenüber stehen Black-Box-Modelle, wie komplexe neuronale Netze oder Ensembles, die oft bessere Genauigkeiten und Leistungen erzielen, deren innere Logik aber schwer zu durchdringen ist. Für diese Modelle kommen post-hoc Erklärmethoden zum Einsatz, die auf das bestehende Modell angewandt werden, um seine Entscheidungen im Nachhinein zu analysieren und zu erklären, ohne das Modell selbst zu verändern.

Bekannte Techniken der post-hoc Erklärbarkeit umfassen beispielsweise Partial Dependency Plots, die den Einfluss eines einzelnen Merkmals auf das Ergebnis visualisieren. SHAP (SHapley Additive exPlanations) stützt sich auf spieltheoretische Konzepte, um den Beitrag einzelner Eingabevariablen zu quantifizieren. Auch LIME (Local Interpretable Model-Agnostic Explanations) gehört zu den populären Ansätzen und erstellt lokal einfache Approximationen für komplexe Modelle. Für Bilddaten werden oft Saliency Maps genutzt, die hervorheben, welche Bereiche im Bild für die Klassifikation besonders relevant waren. Im Bereich von natürlichen Sprachmodellen entwickeln Forscher Methoden wie Attention-Analyse, Probing oder Causal Tracing, um Einblick in den „Denkprozess“ der Maschine zu erhalten.

Eine wichtige Fragestellung ist auch, wie XAI-Erklärungen für unterschiedliche Nutzergruppen gestaltet werden müssen. Die Anforderungen von Experten unterscheiden sich deutlich von denen von Laien. Während Fachleute tiefgehende, technische Analysen bevorzugen, benötigen Nutzer ohne spezielles Vorwissen verständliche und klar strukturierte Erläuterungen. Die Herausforderung besteht darin, Erklärungen adaptiv und kontextabhängig zu erzeugen, sodass sie wirklich nützlich und vertrauensfördernd sind. Historisch betrachtet ist die Idee erklärbarer KI nicht neu.

Schon in den 1970er und 1980er Jahren entwickelten Forscher symbolische Expertensysteme, die rationale Erklärungen für ihre Schlussfolgerungen boten. Systeme wie MYCIN für medizinische Diagnosen konnten Patienten oder Ärzten erläutern, auf welchen Regeln und Annahmen ihre Empfehlungen basierten. Diese frühen Systeme arbeiteten allerdings mit expliziten Regelwerken und waren bei weitem nicht so komplex wie moderne datengestützte Machine-Learning-Modelle. Mit dem Aufkommen von Deep Learning und statistischen Ansätzen wandelte sich die Herausforderung zur Erklärung hochkomplexer, nicht linearer Modelle, bei denen kein eindeutiger Regelkatalog besteht. In den letzten Jahren erfuhr das Forschungsthema XAI durch die wachsende gesellschaftliche Diskussion über Ethik, Fairness und Regulierung einen erheblichen Auftrieb.

So fordert die Europäische Union beispielsweise im Rahmen der Datenschutzgrundverordnung (DSGVO) einen „Recht auf Erklärung“ für algorithmisch getroffene Entscheidungen, zumindest in Zusammenhang mit personenbezogenen Daten. Dies hat eine verstärkte Entwicklung von Methoden angestoßen, die nachvollziehbare Begründungen für KI-Entscheidungen liefern. Gleichwohl ist das Recht auf Erklärung juristisch und technisch komplex und deckt nicht alle Facetten der KI-Nachvollziehbarkeit ab. Trotz bedeutender Fortschritte steht die erklärbare KI weiterhin vor mehreren Herausforderungen. Technische Komplexität ist einer der größten Barrieren: Die inneren Abläufe moderner Modelle sind häufig hochdimensional und nicht intuitiv erklärbar.

Eine Vereinfachung der Erklärung kann zu Informationsverlust führen und falsche Eindrücke erzeugen. Zudem besteht das Risiko, dass Erklärungen manipuliert oder missbraucht werden können, beispielsweise um bestimmte Verhaltensweisen des Modells zu verschleiern oder zu rechtfertigen. Ebenso problematisch ist das Spannungsfeld zwischen Erklärbarkeit und Vertrauen. Eine verständliche Erklärung allein sorgt nicht automatisch für mehr Vertrauen bei Nutzern. Ein zu großes Vertrauen in die KI kann riskant sein, ebenso wie ein zu geringes Vertrauen die Anwendung nützlicher Systeme verhindert.

Das Ziel muss daher die richtige Kalibrierung von Vertrauen sein, die es den Menschen erlaubt, die KI kritisch aber konstruktiv zu nutzen. Eine weitere kritische Diskussion dreht sich um die Frage, ob Erklärbarkeit immer im Vordergrund stehen muss oder ob die Effektivität und Präzision der KI dominanter sind. Einige Experten vertreten die Ansicht, dass komplexe Modelle auch ohne vollständige Transparenz sicher und effektiv eingesetzt werden können, solange sie valide Ergebnisse liefern. Andere plädieren für die verstärkte Anwendung intrinsisch interpretabler Modelle, um den Einfluss von Post-hoc-Erklärungen zu reduzieren, die nicht immer die exakte Arbeitsweise eines Modells widerspiegeln. Neben den technischen und theoretischen Aspekten gewinnt XAI auch in gesellschaftlichen Entscheidungsprozessen und der Sozialwahl an Bedeutung.

Hier helfen erklärbare Algorithmen, die Fairness und Nachvollziehbarkeit von kollektiven Entscheidungen, wie etwa beim Wählen oder Budgetzuweisung, zu stärken. Durch auf Axiomen basierende Erklärungen kann das Vertrauen in die Ergebnisse gesteigert und der demokratische Prozess unterstützt werden. Die Zukunft der erklärbaren Künstlichen Intelligenz verspricht eine noch engere Verzahnung von Technologie, Ethik und Anwenderbedürfnissen. Forschungsinitiativen, wie das DARPA XAI Programm, zielen darauf ab, „Glass-Box“-Modelle zu entwickeln, die leistungsstark und zugleich transparent sind. Parallel entsteht ein wachsendes Ökosystem aus Tools, Visualisierungen und Standards, die Entwicklern und Anwendern das Verständnis erleichtern.

Insgesamt zeigt sich, dass erklärbare KI keineswegs nur eine technische Herausforderung ist, sondern ein multidisziplinäres Thema, das Aspekte der Informatik, Statistik, Psychologie, Recht und Sozialwissenschaften umfasst. Nur durch die Kombination dieser Perspektiven kann ein umfassendes Verständnis entstehen, das KI-Systeme nicht nur intelligent, sondern auch vertrauenswürdig und ethisch verantwortbar macht. So wird XAI zu einem entscheidenden Puzzlestück in der Gestaltung der KI-getriebenen Gesellschaft von morgen.