Apache Kafka gilt als Herzstück moderner Event-Streaming-Architekturen und findet in vielen Unternehmen Anwendung, um hochskalierbare, asynchrone Datenströme zu managen. Doch trotz seiner Beliebtheit stellen Kafka-Ökosysteme viele Betreiber vor eine große Herausforderung: das sogenannte Blackbox-Problem. Dieses Problem beschreibt die Schwierigkeit, die internen Abläufe und Ursachen von Störungen innerhalb einer Kafka-basierten Event-Streaming-Kette sichtbar zu machen. In der Praxis zeigen sich oftmals unerklärliche Verzögerungen, unerwartete Lags oder unerklärte Fehler, ohne dass die herkömmlichen Monitoring-Tools verlässliche Hinweise liefern. Eine entscheidende Rolle bei der Lösung dieser Problematik spielt OpenTelemetry, ein offener Standard für Observability, der Transparenz, Nachvollziehbarkeit und Kontext in verteilten Systemen herstellt.

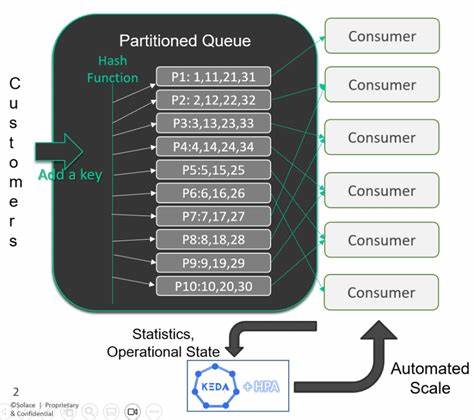

Die Kombination aus Kafka und OpenTelemetry ebnet damit den Weg für eine neue Generation von Überwachungs- und Diagnoselösungen im Event-Streaming-Umfeld. Das Blackbox-Problem von Kafka entsteht vor allem durch die asynchrone und entkoppelte Natur der Ereignisverarbeitung. In einer Kafka-Architektur kommunizieren Produzenten, Broker und Konsumenten über Nachrichten, die asynchron übertragen werden. Diese Mechanik erschwert es, den kompletten Lebenszyklus einer einzelnen Nachricht durch das System präzise nachzuvollziehen. Anders als bei synchronen Systemen gibt es keine fortlaufende Transaktion, die den Weg einer Nachricht durch alle Komponenten direkt verbindet.

Die Folge: Entwickler und Betreiber sehen nur isolierte Metriken oder Log-Daten ohne direkten Bezug aufeinander, was die Fehleranalyse sehr komplex und zeitraubend macht. Dies führt häufig zu manuellen Eingriffen, etwa das Löschen von Nachrichten in Partitionen oder trial-and-error Ansätzen, ohne die eigentliche Ursache zu erkennen. OpenTelemetry bietet hier entscheidende Lösungen. Als universelles Observability-Framework ermöglicht es die Erfassung von verteiltem Tracing, Metriken und Logs mit einheitlichen APIs und SDKs. Besonders im Kafka-Kontext spielt die automatische Kontextpropagation eine zentrale Rolle.

Dabei wird der sogenannte Trace-Kontext vom Produzenten in die Kafka-Nachrichtenheader eingefügt und bei den Konsumenten wieder extrahiert. So kann der gesamte Weg einer Nachricht von der Erzeugung über die Broker bis hin zur Verarbeitung im Konsumenten als eine durchgehende, zusammenhängende Spur dargestellt werden. Diese nahtlose Nachvollziehbarkeit beseitigt das Blackbox-Phänomen und lässt Entwickler tief in die Systemabläufe eintauchen. Die Vorteile einer solchen Beobachtbarkeit gehen weit über reine Fehlersuche hinaus. Durch die Visualisierung kompletter Nachrichtenflüsse und die verknüpfte Darstellung von Metriken und Traces entstehen neue Einblicke in Performance-Engpässe und Systemverhalten.

Beispielsweise lassen sich Verbraucher-Lags schnell erkennen und mit Netzwerk-Durchsatz oder Garbage Collection-Zeitpunkten korrelieren. Das bringt Unternehmen in die Lage, Probleme bereits präventiv durch gezielte Alarme und automatische Korrekturmaßnahmen zu handhaben. Neben dem verteilten Tracing setzt OpenTelemetry im Kafka-Umfeld auch auf eine umfassende Metrik-Erfassung. Hier kommen drei Hauptquellen ins Spiel: Instrumentierung auf Anwendungsebene mittels OpenTelemetry SDK, Java Management Extension (JMX)-Metriken und speziell entwickelte Kafka-Metrik-Empfänger innerhalb der OpenTelemetry Collector Komponente. Während die SDK-Instrumentierung allgemeine Anwendungsmetriken zu Latenzen und Fehlerraten liefert, ermöglichen die JMX-Metriken tiefe Einblicke in Broker- und Partitionszustände, wie beispielsweise in die Anzahl der unterreplizierten Partitionen oder die durchschnittliche Wartezeit von Anfragen.

Die Kafka-Metrik-Empfänger gehen sogar noch spezifischer auf Kafka-Broker, Topics, Partitionen und Consumer-Gruppen ein und decken Aspekte wie Nachrichtenraten, Replikationsstatus und Consumer-Lags ab. Eine typische Implementierung startet mit der korrekten Konfiguration des Kafka-Docker-Containers für die JMX-Metrik-Exposition. Es müssen bestimmte Umgebungsvariablen gesetzt und Ports freigegeben werden, sodass der OpenTelemetry Collector die Metriken per JMX-Schnittstelle auslesen kann. Parallel wird der Kafka-Metrik-Empfänger im Collector aktiviert und mit der Kafka-Broker-Adresse verbunden, um dort kontextspezifische Messwerte zu erfassen. Diese gesammelten Daten werden dann in das OpenTelemetry Protocol (OTLP) konvertiert und an ein Observability-Backend wie SigNoz weitergeleitet.

SigNoz bietet eine spezialisierte Oberfläche zur Analyse von Kafka-Ökosystemen. Dank leistungsfähiger Dashboards lassen sich Metriken und Traces eng verknüpfen, um schnelle Problemuntersuchungen durchzuführen. Ein Beispiel: Bei einem beobachteten Consumer-Lag konnten die Metriken eine starke Korrelation zu einem temporären Netzwerkausfall auf Seiten des Brokers aufzeigen. Obwohl die Produzenten- und Konsumentendaten stabil blieben, bewirkte eine kurzzeitige Drosselung der Broker-Netzwerkdurchsatzleistung die verspätete Nachrichtenabholung. Durch diese Erkenntnis konnten Betreiber die Ursache gezielt ausschließen und den Vorfall nachvollziehbar dokumentieren.

Von solchen Monitoring-Erfahrungen profitieren Unternehmen deutlich. Das tiefergehende Verständnis komplexer Kafka-Landschaften führt zu höherer Systemstabilität und effizienteren DevOps-Prozessen. Darüber hinaus hilft die klare Trennung und Sichtbarkeit von Komponenten, risikoreiche Situationen frühzeitig zu erkennen und Gegenmaßnahmen zu automatisieren. Die Möglichkeit, Alerts vor echten Problemen auszulösen, verhindert umfangreiche Ausfallzeiten und garantiert eine bessere Nutzererfahrung im Echtzeitbetrieb. Die Integration von OpenTelemetry in Kafka-Ökosysteme ist zudem technisch gut machbar und wird durch eine breite Sprachunterstützung erleichtert.

Die automatische Kontextpropagation funktioniert für populäre Kafka-Client-Bibliotheken in Java, Python, Node.js und .NET zuverlässig out-of-the-box. Teilweise Unterstützung bieten auch Go und PHP. Somit lässt sich die Observability nahezu unabhängig von der eingesetzten Programmiersprache realisieren.

Grundsätzlich müssen Unternehmen allerdings einige wichtige Schritte beachten. Die Erfassung der verschiedenen Metriken erfordert konfigurierbare Collector-Pipelines und entsprechende Anpassungen, etwa um JMX-Metriken zu aktivieren oder den Kafka Metrics Receiver anzubinden. Gleichzeitig ist ein leistungsfähiges Backend nötig, das sowohl Zeitreihenmetriken als auch verteilte Traces performant speichern und visualisieren kann. Lösungen wie SigNoz bilden hier eine zukunftssichere Plattform, die sowohl OpenTelemetry-Standards als auch erweiterte Funktionalitäten für Kafka-Ökosysteme unterstützt. Die Implementierung einer ganzheitlichen Kafka-Observability hat einen nachhaltigen Effekt auf die Betriebssicherheit und Skalierbarkeit moderner Event-getriebener Architekturen.

![Impossible Challenges (Google Veo 3) [video]](/images/B87AD157-9EA6-4C8F-A395-0A6E8E65D325)