In der heutigen Ära der Hochleistungsrechner sind Grafikkarten, auch bekannt als GPUs, zu unverzichtbaren Komponenten für eine Vielzahl von Anwendungen geworden. Von wissenschaftlicher Simulation über maschinelles Lernen bis hin zur Grafikgestaltung – GPUs bieten eine enorme Rechenleistung. Doch die steigende Komplexität und Verbreitung dieser Hardware bringen auch Herausforderungen mit sich, insbesondere im Bereich der Speicherkonsistenz und Synchronisation. Ein tiefgehendes Verständnis dieser Aspekte wird immer wichtiger, um Fehler zu vermeiden und bestmögliche Performance zu erzielen. Grundsätzlich beschreibt die Speicherkonsistenz, wie verschiedene Threads innerhalb der GPU auf gemeinsam genutzte Daten zugreifen und welche Auswirkungen Speicheroperationen auf die Sichtbarkeit von Daten haben.

Dabei spielen Synchronisationsmechanismen und Speicherbarrieren eine zentrale Rolle, um vorzeitige oder fehlerhafte Speicherzugriffe zu verhindern. GPUs verfügen mit ihren vielen parallelen Recheneinheiten über eine immense Anzahl von Threads, die gleichzeitig ausgeführt werden. Dieses Parallelismuslevel sorgt für Effizienz, macht aber gleichzeitig die korrekte und vorhersehbare Speicherkommunikation komplizierter. Seit der Einführung von CUDA durch NVIDIA im Jahr 2007 entwickelte sich ein einheitliches Programmiermodell für GPUs, mit dem Entwickler gezielt die vielfältigen Ebenen der Thread-Hierarchie steuern können. Threads werden in sogenannten Grids, Threadblocks und Warps organisiert, die jeweils unterschiedliche Synchronisationsmöglichkeiten und Speicherzugriffsrechte besitzen.

Dieses Konzept spiegelt sich direkt in der Spezifikation des GPU-Speichermodells wider, die den Regeln folgt, wie Speicherbefehle untereinander sortiert werden und wie deren Sichtbarkeit innerhalb der verschiedenen Threadgruppen geregelt ist. Das CUDA-Speichermodell zeichnet sich durch Offenheit und Flexibilität aus, denn es ist als ein sogenanntes „relaxed“ Memory Model ausgelegt. Das bedeutet, dass ohne spezifische Synchronisationsmechanismen oder stärkere Speicherordering-Qualifizierer Speicherzugriffe neu geordnet oder verzögert auftreten können. Während auf den ersten Blick eine solche Lockerheit Leistungsgewinne ermöglichen mag, birgt sie ohne die richtige Nutzung von Speichersperren, sogenannten Fences, auch das Risiko von subtilen Programmfehlern, die nur unter seltenen Bedingungen zum Vorschein kommen. Synchronisationsbarrieren wie __threadfence() in CUDA erzwingen beispielsweise eine bestimmte Sichtbarkeit und Reihenfolge von Speicheroperationen.

Interessanterweise variiert die Granularität solcher Barrieren, wobei Block-scoped Fences, die nur innerhalb eines Threadblocks wirken, performanter sind und deutlich weniger Overhead verursachen als Device-scoped Fences, die sich über den gesamten GPU-Grid erstrecken. Die Wahl der richtigen Synchronisationsstufe kann daher unmittelbaren Einfluss auf die Laufzeit eines Programms haben. Sicherzustellen, dass Synchronisationsoptimierungen nicht zu fehlerhaften Speicherzuständen führen, ist ein großer Teil der Herausforderung in diesem Kontext. Die Risiken liegen darin, dass durch zu aggressive Reduzierung von Synchronisationsmechanismen unerwartete Speicherzustände entstehen können, welche im Extremfall schwer auffindbare Race Conditions oder inkonsistente Datenresultate verursachen. Gerade angesichts der enormen Skalierbarkeit von GPUs, bei der Programme mit Milliarden Ausführungen laufen können, steigen die Chancen, dass solche Fehler zeitlich aufwachen und Produktionssysteme negativ beeinflussen.

Entsprechend intensiv hat sich die Forschung mit den formalen und empirischen Aspekten von GPU-Speicherkonsistenz beschäftigt. In der Anfangszeit der GPU-Programmierung war das Wissen über Speicherordnung und Synchronisation eher lückenhaft und unterdokumentiert. Entwickler waren gezwungen, sich durch experimentelle Methoden und empirische Tests an die realen Hardwaregrenzen heranzutasten. Bedeutende Fortschritte wurden durch die Adaption von CPU-Memory-Testing-Techniken auf GPUs gemacht. Durch gezielte Testmuster, sogenannte Litmus-Tests, konnten Forscher reale Speicherverhalten untersuchen und so Schwachstellen oder Fehlannahmen in den bestehenden Modellen aufdecken.

Dabei wurden unter anderem auch äußerst selten auftretende Speicherfehlverhalten identifiziert, die in echten Anwendungsszenarien schwer zu reproduzieren sind. In den letzten Jahren haben sich spezialisierte Testplattformen etabliert, etwa GPUHarbor, eine WebGPU-basierte Oberfläche, die es Anwendern ermöglicht, Speicherverhalten auf ihrer eigenen Hardware umfassend zu analysieren. Solche Tools tragen dazu bei, das Verständnis für die zugrundeliegenden GPU-Speicherarchitekturen zu vertiefen und gleichzeitig Fehler in diversen Implementierungen verschiedener Hersteller aufzudecken. Solche Ergebnisse fließen auch in offizielle Testprofile von Grafik-APIs wie Vulkan oder WebGPU ein. Parallel zur empirischen Forschung entwickelte sich auch die formale Spezifikation von GPU-Speicherkonsistenzmodellen.

Während CPU-Speichermodelle bereits seit den 2000er-Jahren formal beschrieben wurden, sind GPU-Modelle vergleichsweise jung, aber nicht weniger komplex. Offizielle Spezifikationen von großen Organisationen wie der Khronos Group oder NVIDIA existieren inzwischen für Vulkan und die PTX-Assembly-Sprache von CUDA. Dank dieser formalen Modelle können Entwickler und Forscher plangemäß prüfen, ob ein bestimmter Code Speicher-Race-Conditions enthält, oder welche Speicherzugriffe zulässig und definiert sind. Werkzeuge wie herd7, das Alloy-Modellprüfsystem oder Dartagnan sind in der Lage, Speicherzugriffe unter komplexen Parallelisierungsbedingungen zu modellieren und so formale Beweise oder Gegenbeispiele zu generieren. Diese helfen dabei, nicht nur Dokumentationen zu validieren, sondern auch konkrete Optimierungen auf Korrektheit zu überprüfen.

Ein praktisches Beispiel für die Herausforderungen und Möglichkeiten im Bereich GPU-Speicherkonsistenz liefert das MICRO 2024 Paper „Over-synchronization in GPU Programs“, das sich mit übermäßigen Synchronisationsmechanismen in CUDA-Programmen auseinandersetzt. Übermäßige Synchronisation führt zu unnötigen Performance-Einbußen und der gleichnamige Ansatz „ScopeAdvice“ zielt darauf ab, diese Redundanzen zu identifizieren und zu eliminieren. Das Paper stellte drei Varianten von überflüssiger Synchronisation vor. Zum Beispiel wird in einer Variante vorgeschlagen, Block-scoped Fences zur Synchronisation zwischen Threads aus verschiedenen Threadblocks zu verwenden, unter bestimmten Voraussetzungen wie Verwendung von volatile Variablen oder device-scoped atomaren Zugriffsarten. In der Theorie führt dies zu einer erheblichen Leistungsssteigerung, da Block-scoped Fences erheblich schneller sind als Device-scoped Fences.

Allerdings zeigte eine formale Analyse mittels Dartagnan, dass diese Vereinfachung nicht vollständig korrekt ist. Block-scoped Fences garantieren nur Ordnung innerhalb des Threadblocks, nicht jedoch zwischen unterschiedlichen Threadblöcken, die auf verschiedenen Streaming Multiprozessoren laufen und unterschiedliche Caches nutzen. Somit besteht tatsächlich das Risiko unerwarteter Speicherzustände. In der Praxis stellte sich aber heraus, dass die mitgelieferten Kontrollstrukturen und Schleifen (Kontrolldependenzen) oft eine implizite Ordnung erzwingen, so dass diese Fehler deutlich seltener auftreten oder ganz vermieden werden. Diese Diskrepanz zwischen formaler Unsoundness und praktischer Sicherheit führt zu einer spannenden Forschungsfrage, wie solche engen Zusammenhänge zwischen Mikroattributen der Architektur und den formalen Modellen berücksichtigt werden können.

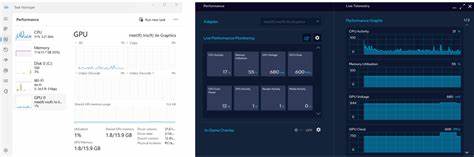

Es zeigt sich, dass das derzeitige Status quo entweder zu konservativ in der Optimierung oder zu risikoreich in der Umsetzung sein kann. Um diese Herausforderungen zu meistern, ist der Einsatz kombinierter Toolchains vielversprechend. Ein Werkzeug wie ScopeAdvice kann potentielle Optimierungen vorschlagen. Formale Prüfsysteme wie Dartagnan können diese Vorschläge auf Korrektheit überprüfen. Anschließend können empirische Tools wie GPUHarbor in realer Hardware getestet werden, ob diese Optimierungen tatsächlich sicher sind.

Solch ein ganzheitlicher Ansatz ermöglicht eine solide Basis für zukünftige Performance-Optimierungen und fördert gleichzeitig die Sicherheit in der Parallelausführung. Die GPU-Speicherkonsistenz ist ein hochkomplexes, dynamisch wachsendes Forschungsgebiet. Fortschritte in der Spezifikation, Testing-Methoden und Toolunterstützung eröffnen neue Möglichkeiten, sowohl Software- als auch Hardware-Entwickler zu befähigen, effizientere und dennoch korrekte parallele Programme zu schreiben. Zukunftsfähige Tools könnten dadurch in der Lage sein, Performance-Verbesserungen zu finden, Korrektheit formell zu garantieren und dennoch die pragmatischen Grenzen aktueller Hardware zu berücksichtigen. Abschließend ist die Verbesserung von Synchronisationsmechanismen bei GPU-Berechnungen von zentraler Bedeutung, um die riesigen Rechenkraftpotenziale moderner GPUs voll auszuschöpfen.

Ein tieferes Verständnis der Speicherkonsistenz, unterstützt durch moderne Test- und Formalisierungstechniken, ist der Schlüssel zu leistungsstarken, stabilen und skalierbaren Anwendungen. Das Zusammenspiel von Forschung, Toolentwicklung und industrieller Zusammenarbeit verspricht, dieses komplexe Feld in den kommenden Jahren weiter voranzutreiben und neue Standards in der parallelen Programmierung zu setzen.