Die rasante Entwicklung von Künstlicher Intelligenz (KI) verändert nicht nur einzelne Anwendungen, sondern auch grundlegend, wie Software konzipiert, geschrieben und gewartet wird. Inmitten dieses Wandels gewinnt ein Konzept immer mehr an Bedeutung, das bislang weniger im Rampenlicht stand: Specification Engineering. Es handelt sich dabei um einen zukunftsweisenden Ansatz, der darauf setzt, bessere Code-Generierung mit einem höheren Maß an Komplexität zu verbinden – ein Wettlauf, der die Softwareentwicklung nachhaltig beeinflussen wird. Doch was verbirgt sich hinter diesem Begriff, und warum ist er gerade in der heutigen Zeit so relevant? Im Folgenden werden die zentralen Aspekte beleuchtet, die diese spannende Schnittstelle zwischen traditioneller Programmierung und moderner KI-Technologie ausmachen. Die Welt der Softwareentwicklung war bisher stark geprägt von imperativer Programmierung.

Entwickler*innen schreiben explizite Anweisungen in Sprachen wie Python oder TypeScript, die der Computer Schritt für Schritt abarbeitet. Dieser Stil funktioniert gut, solange das System überschaubare Logik enthält und die Kernkomponenten menschlich nachvollziehbar bleiben. Dabei hat sich in den vergangenen Jahrzehnten eine klare Struktur etabliert, in der die Algorithmen meist deterministisch sind und sich Entwickler*innen auf eine eindeutige Codebasis verlassen können. Doch die Einführung von KI-Systemen hat diese Dynamik deutlich verändert. In Anwendungen, bei denen KI-Modelle nur eine kleine Rolle spielen, beispielsweise als Ergänzung zu klassischen Funktionen, stellt der Mix aus imperativem Code und KI-Elementen kaum ein Problem dar.

Die ursprünglichen Codebestandteile dominieren und die KI-Komponenten sind klar abgegrenzt, sodass deren Verhalten zumindest ungefähr verstanden und kontrolliert werden kann. Die Herausforderung entsteht jedoch, wenn der Anteil der KI-Komponenten exponentiell wächst – manche komplexe Systeme bestehen mittlerweile zu über 90 Prozent aus KI-Elementen, während der klassische Python-Code nur noch einen kleinen Bruchteil ausmacht. In dieser neuen Realität bleibt der imperative Ansatz unzureichend. Das liegt daran, dass die spezifischen Abläufe in den Künstlichen Intelligenzen häufig schwer oder gar nicht deterministisch und nachvollziehbar sind. Aufmerksamkeitsmechanismen, neuronale Netzwerke und die interaktiven Prozesse, die Sprachmodelle erzeugen, sind weniger als lineare Programme zu verstehen, sondern vielmehr als probabilistische, dynamische Systeme.

Die traditionellen Möglichkeiten, mit expliziten Befehlen und prozeduralen Logiken zu arbeiten, stoßen hier an ihre Grenzen. Ein weiteres Problem ist, dass das entscheidende Wissen oft ausschließlich im Kopf der Entwickler*innen liegt. Die Konfigurationen, Feinabstimmungen und das Zusammenspiel verschiedener KI-Komponenten sind häufig Resultate intensiver Zusammenarbeit, Whiteboard-Sitzungen und zeitaufwändiger Versuche, die sich kaum noch sinnvoll in den Programmcode übertragen lassen. Dokumentation und Code spiegeln diese komplexen Zusammenhänge nicht zuverlässig wider. Eine solche Situation ist riskant und ineffizient, denn wenn wesentliche Systemdetails nur mental gespeichert sind, geraten sie schnell in Vergessenheit, veralten oder werden falsch interpretiert.

Außerdem erschwert das die Zusammenarbeit im Team, da jedes Mitglied eigene Annahmen trifft und die Skalierung der Produktivität darunter leidet. Wer jetzt denkt, dass mit verstärktem Einsatz von Test-Cases und Evaluationen das Problem gelöst werden kann, wird enttäuscht sein. Zwar sind automatisierte Tests ein wichtiges Element zur Sicherstellung von Softwarequalität, doch bei hochkomplexen KI-Systemen verstreuen sich die Anforderungen häufig über hunderte oder gar tausende einzelner Tests mit unterschiedlicher Relevanz. Das führt zu Fragmentierung und erschwert es, ein kohärentes, gesamtheitliches Verständnis der Systemziele und Garantien zu bewahren. Genau an diesem Punkt setzt Specification Engineering an.

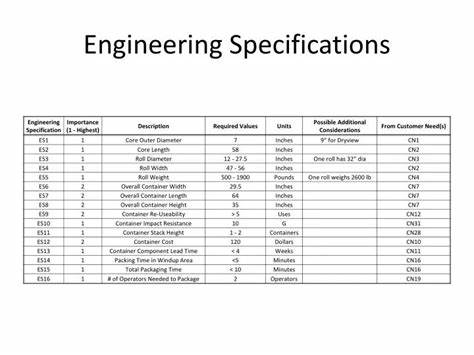

Es geht dabei um die Entwicklung und Pflege klarer, deklarativer Spezifikationen, die das Verhalten und die Anforderungen eines Systems in abstrahierter Form festhalten. Statt den Fokus auf imperativen Code zu legen, der genau vorgibt, wie etwas zu geschehen hat, liegt der Schwerpunkt auf dem „Was“ – also die Zielvorgaben, Restriktionen und Garantien, die das System erfüllen soll. Diese Form der Spezifikation ist keine Erfindung der modernen KI-Ära. Schon immer hat Softwareentwicklung von klaren Vereinbarungen und Dokumentationen profitiert, die sicherstellen, dass ein System konsistent und verlässlich funktioniert. Was sich jedoch grundlegend ändert, ist die Art und Weise, wie diese Spezifikationen mit der eigentlichen Implementierung interagieren können.

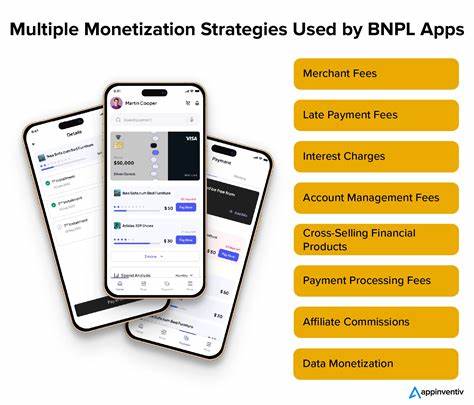

Neue Intelligenzsysteme unterstützen Entwickler*innen zunehmend dabei, aus diesen abstrakten Vorgaben automatisch ausführbaren Code zu generieren, Testfälle abzuleiten und sogar aufwändige Evaluationsprozeduren zu erstellen. So entsteht eine durchgängige Synchronisation zwischen Spezifikation und Implementation – ein lebendiger Prozess, der die Wartbarkeit verbessert und menschliche Fehler reduziert. Das Konzept ist keineswegs idealistisch. Völlige Automatisierung wird kurzfristig nicht möglich sein, und imperative Codeteile werden weiterhin eine Rolle spielen. Doch die Vision eines Gleichgewichts, in dem Spezifikationen und Code sich wechselseitig ergänzen und anpassen, stellt einen bedeutenden Fortschritt im Umgang mit Komplexität dar.

Die Integration von KI-gesteuerter Code-Generierung kann beispielsweise bei der Einführung neuer Anforderungen sofort umfangreichen Programmcode, Testszenarien und Subagenten erzeugen, ohne dass Entwickler*innen jeden Schritt manuell ausführen müssen. Gleichzeitig können Evaluationen laufend prüfen, ob neue Änderungen bestehende Garantien verletzen – und so für mehr Stabilität und Vorhersehbarkeit sorgen. Damit tritt ein Paradigmenwechsel ein, der die Art und Weise verändert, wie Software langfristig gepflegt wird. Anstelle eines starren, von Menschen verwalteten Code-Bases mit verstreuten Tests entsteht eine dynamische Umgebung, in der Spezifikationen zum Dreh- und Angelpunkt der Entwicklung werden. Teams können so effizienter zusammenarbeiten, da das Wissen nicht mehr fragmentiert im Kopf Einzelner liegt, sondern formal erfasst und durch intelligente Werkzeuge verwaltet wird.

Die Herausforderungen sind dennoch erheblich. Das Finden geeigneter Abstraktionen, die für spezifische Anwendungsszenarien sinnvoll sind, erfordert Zeit, experimentelles Lernen und Disziplin. Jede Spezifikation ist zwangsläufig unvollkommen und kann „lecken“ – also nicht alle Details erfassen oder sich im Laufe der Zeit von der tatsächlichen Implementierung entfernen. Daher ist ein nachhaltiger Prozess zur Synchronisation zwischen Spezifikationen und Code entscheidend, um die Vorteile auszuschöpfen. Insgesamt ist Specification Engineering eine strategische Antwort auf die Komplexität, die moderne KI-Software mit sich bringt.

Es ist gleichzeitig ein Appell an Entwickler*innen und Engineering-Teams, jetzt die Grundlagen für eine neue Art der Softwareentwicklung zu legen, die deklarative Spezifikationen als Kern nutzt und diese mithilfe smarter Automatisierung lebendig hält. Wer diesen Wandel annimmt, profitiert von mehr Transparenz, besserer Zusammenarbeit und letztlich von deutlich effizienteren Entwicklungszyklen. Das Potenzial, das Specification Engineering bietet, ist enorm und wird die Softwarebranche nachhaltig prägen. Es geht um eine neue Perspektive, die unsere Beziehung zu Code, zur Zusammenarbeit im Team und selbst zum Verständnis von Software als technischem System neu definiert – ein Meilenstein auf dem Weg zu intelligenteren, robusteren und skalierbaren Anwendungen im KI-Zeitalter.