Die Leistung von Datenbanksystemen entscheidet in vielen Anwendungen über den Erfolg der gesamten IT-Infrastruktur. Gerade PostgreSQL hat sich in den letzten Jahren als eine der führenden Open-Source-Datenbanken etabliert, die nicht nur leistungsfähig, sondern auch kosteneffizient und flexibel ist. Allerdings stellt sich bei Vergleichen mit anderen Datenbanksystemen, etwa Oracle oder Microsoft SQL Server, häufig die Frage, wie ein fairer und realistischer Benchmark durchgeführt werden kann. Unoptimierte PostgreSQL-Instanzen gegen optimierte kommerzielle Anbieter zu setzen, führt oft zu irreführenden Ergebnissen. Um dies zu vermeiden, ist es wichtig, eine sorgfältige Methodik zu nutzen, die sowohl realistische Arbeitslasten simuliert als auch die Leistungsschübe moderner Tuning-Tools nutzt.

Die Kombination aus HammerDB als Benchmark-Tool und DBtune als intelligentes Tuning-Werkzeug bietet hierfür eine hervorragende Lösung und sorgt für aussagekräftige Performancevergleiche sowie Optimierungen, die ohne Hardwareänderungen erreicht werden können. HammerDB ist eines der etabliertesten Open-Source-Werkzeuge für Datenbanktests und Benchmarking. Es bietet zwei Hauptarten von Benchmarks, die in der Praxis am häufigsten verwendet werden: TPCC, das transaktionale OLTP-Workloads simuliert, und TPCH für analytische Workloads. Für die Praxisrelevanz bei vielen geschäftskritischen Anwendungen liegt der Fokus auf TPCC, welches eine realistische Umgebung darstellt, in der viele Benutzer gleichzeitig Transaktionen ausführen. Die Benchmark simuliert dabei etwa den Ablauf eines Großhandels, inklusive Kundenbestellungen, Zahlungen, Lieferungen und Lagerbestandsprüfungen.

Ein wichtiges Element für faire Benchmarking-Ergebnisse ist die Einrichtung eines realistischen Testaufbaus. Ein bewährtes Vorgehen ist die Trennung von Lastgenerator und Datenbankserver auf zwei identische virtuelle Maschinen. Dies verhindert Ressourcenengpässe und stellt sicher, dass die gemessene Leistung tatsächlich den Fähigkeiten der Datenbank entspricht, ohne durch Benchmark-Tools beeinträchtigt zu werden. Die Netzwerkverbindung zwischen diesen Instanzen spiegelt zudem typische Produktionsszenarien wider und ermöglicht belastbare Messungen des tatsächlichen Datenverkehrs und der Reaktionszeiten. Für eine realistische Simulation der TPCC-Workload ist der Parameter der Anzahl der Lagerhäuser entscheidend.

Diese Einstellung beeinflusst direkt die Datenbankgröße und die Verteilung der Datenzugriffe. Werden zu wenige Lagerhäuser gewählt, kann die Last künstlich konzentriert werden, was zu unnatürlichen Engpässen führt. Bei 500 Lagerhäusern, passend zur CPU-Socket-Anzahl der eingesetzten VMs, lässt sich eine Datenbankgröße von rund 52 Gigabyte erzeugen, die ausreichend Last und Datenvielfalt für aussagekräftige Tests bietet. Gleichzeitig wird so vermieden, dass sich künstliche Konflikte auf die Messergebnisse auswirken. HammerDB ermöglicht dabei flexible Anpassungen, die über Standardbenchmarks hinausgehen.

So wurde beispielsweise die Anzahl der virtuellen Benutzer auf 285 erhöht, abgestimmt auf die maximale Datenbankverbindungsanzahl von 300, was auf einer 8-Kern-Maschine eine hohe gleichzeitige Belastung und damit die Offenlegung von Systemengpässen ermöglicht. Außerdem wurde die Dauer der Tests auf 24 Stunden verlängert, um den Cachedurchlauf und die Stabilisierung von Puffer- und Statistikinformationen zu gewährleisten. Diese langen Laufzeiten sind entscheidend, um signifikante und reproduzierbare Ergebnisse zu erhalten, da Datenbankleistung insbesondere in den ersten Stunden große Schwankungen zeigt. Nach der Etablierung einer stabilen Ausgangsbasis aus dem unoptimierten Zustand erfolgt das eigentliche Tuning mit DBtune. Dieses AI-gestützte Tool analysiert automatisiert die spezifische Workload und passt anhand moderner Machine-Learning-Techniken konfigurationsrelevante Parameter der PostgreSQL-Instanz an.

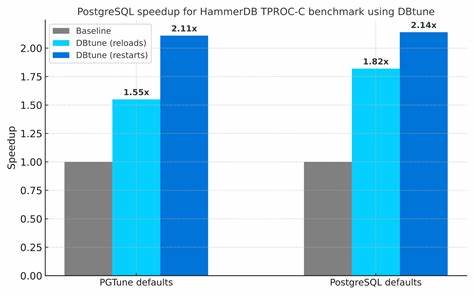

DBtune fokussiert sich dabei auf Metriken wie Transaktionen pro Sekunde (TPS) oder durchschnittliche Antwortzeit (AQR) und optimiert schrittweise mithilfe sicherer Feedbackmechanismen, um möglichst hohe Performancewerte ohne Risiken zu erzielen. Die beeindruckenden Ergebnisse zeigen, wie wichtig maßgeschneiderte Optimierungen sind: Im Vergleich zu den PostgreSQL-Standardeinstellungen oder selbst vordefinierten Tools wie PGTune wurden Leistungssteigerungen von bis zu 114 Prozent bei TPS und mehr als das Vierfache an Beschleunigung bei der durchschnittlichen Antwortzeit erreicht. Dabei wurden sowohl Änderungen an durchgängigen Parametern wie shared_buffers und max_worker_processes als auch an kritischen Settings zur WAL-Verwaltung (Write-Ahead Logging) durchgeführt. Gerade die Erhöhung der max_wal_size und min_wal_size erlaubte eine effektive Reduktion der Checkpoint-Frequenz und damit eine gleichmäßigere Systembelastung mit weniger I/O-Spitzen. Ein weiterer wesentlicher Vorteil von DBtune liegt in seiner Sicherheitstechnik.

Während des automatisierten Tuning-Zyklus erkennt das Tool Konfigurationen, die etwa den verfügbaren Arbeitsspeicher überlasten würden, und verwirft diese unmittelbar. Somit können auch komplexe und umfangreiche Optimierungen ohne Gefahr von Instabilitäten oder Downtimes durchgeführt werden. Die Option, entweder mit Datenbank-Neustarts oder nur mit Service-Reloads zu arbeiten, bietet Flexibilität im Betriebsalltag und erlaubt das Abwägen zwischen maximaler Performance und maximaler Verfügbarkeit. Die Kombination aus HammerDB und DBtune bildet daher eine moderne und bewährte Benchmarking-Methodik, die für alle gilt, die ihre PostgreSQL-Datenbanken nicht nur fair testen, sondern auch intelligent verbessern wollen. Wer hierbei auf die typischen Default-Parameter vertraut oder einfache Tools nutzt, verschenkt oft erhebliches Potenzial, das moderne datengetriebene Unternehmen jedoch dringend benötigen.

Die richtige Parametrierung kann bei gleichbleibender Hardware die Kapazität nahezu verdoppeln und damit Investitionskosten deutlich reduzieren. Für Unternehmen und Entwickler, die in datenbankgestützten Anwendungen Spitzenperformance erreichen möchten, gilt insbesondere: Ein fairer und nachvollziehbarer Benchmark benötigt passende Testumgebungen, realistische Arbeitslasten und intelligente Tuningmethoden. Nur so lassen sich valide Vergleichswerte generieren, die die tatsächliche Leistungsfähigkeit einer Datenbank widerspiegeln. Mit den genannten Werkzeugen steht ein ganzheitlicher Ansatz zur Verfügung, der nicht nur Benchmark-Ergebnisse verbessert, sondern auch das Verständnis und die Steuerbarkeit der PostgreSQL-Leistung im Produktivbetrieb erheblich steigert. Die Zukunft des PostgreSQL-Optimierens liegt in der Nutzung solcher automatisierter, KI-gestützter Tools gekoppelt mit bewährten Testverfahren.