Künstliche Intelligenz (KI) hat in den letzten Jahrzehnten eine enorme Entwicklung durchlaufen, die tiefgreifende Veränderungen in Wissenschaft, Technik und Gesellschaft mit sich gebracht hat. Besonders faszinierend sind dabei die Parallelen und Unterschiede zwischen den frühen symbolischen KI-Ansätzen und den zeitgenössischen, statistisch basierten Modellen, wie großen Sprachmodellen. Die Art und Weise, wie diese Systeme mit Sprache arbeiten, wirft grundlegende Fragen darüber auf, was Intelligenz überhaupt ausmacht und wie sie in Computern realisiert werden kann. Der Begriff der „Likewise! AI Presumption“, wie ihn die Wissenschaftlerin Robin K. Hill beschreibt, verweist auf die wiederkehrenden Annahmen, die in jeder Welle künstlicher Intelligenz aufkommen und manchmal zu überzogenen Erwartungen führen.

Schon bei den ersten Expertensystemen, die vor allem auf Fakten und logischer Schlussfolgerung beruhten, gab es den Glauben, dass es nur noch ein kleiner Schritt sei, wahre Computerintelligenz zu erreichen. Systeme wie Dendral oder MYCIN zeigten zwar in eng abgegrenzten Domänen beeindruckende Leistungen, doch die Sterilität ihrer Ansätze wurde bald offensichtlich. Es fehlte das, was man heute als menschliche Intuition, Flexibilität und Kreativität bezeichnet. Um die erkennbare Begrenztheit der reinen Logik- und Faktenorientierung zu überwinden, wurden ad hoc Erweiterungen wie Wahrscheinlichkeitsmodelle, Heuristiken und komplexe Planungsmechanismen eingeführt. Diese verbesserten die Leistungsfähigkeit der Systeme, zeigten aber gleichzeitig, dass das starre Forschungsparadigma an seine Grenzen gestoßen war.

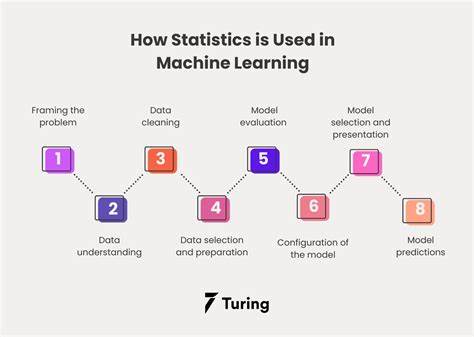

Erst durch diese Erkenntnisse wurde klarer, dass Intelligenz nicht einfach durch genaue Regeln und gespeichertes Faktenwissen abgebildet werden kann. Mit dem Aufkommen der Massendaten und dem Zugang zu enormen Textmengen änderten sich die Perspektiven erneut. Große Sprachmodelle, die auf moderner, tief lernender statistischer Verarbeitung basieren, arbeiteten auf Grundlage von Milliarden von Texten. Der Glaube entstand, dass Intelligenz in der Sprache versteckt liegt und durch das Analysieren von Mustern in hochdetaillierten Kontexten auch maschinell extrahiert werden könne. Daraus resultierte der Versuch, Intelligenz als Aufgabe der Textverarbeitung zu verstehen und mit gewaltigen Rechenkapazitäten Stück für Stück nachzubilden.

Doch auch im Umgang mit Sprache gibt es wesentliche Herausforderungen. Erstens ist die Sprachverarbeitung in schriftlicher Form nur ein Ausschnitt dessen, was menschliche Sprachkompetenz ausmacht. Sprache basiert im Alltag vor allem auf gesprochener Kommunikation, die spontan, emotional und kontextreich ist. Schriftliche Sprache ist dagegen geplant, bearbeitet und oft kulturell codiert. Das bedeutet, dass allein durch die Analyse von Texten eine verzerrte oder unvollständige Sicht auf Sprache und damit auf kognitive Prozesse entsteht.

Zudem beruht das Training großer Sprachmodelle auf der Annahme, dass der statistische Zusammenhang von Wörtern und Sätzen ausreicht, um „Verständnis“ zu erzeugen. Während diese Modelle großartige Fähigkeiten im Vorhersagen von Textsequenzen zeigen, leiden sie unter einem Mangel an logischem Scharfsinn und sind anfällig für Fehler, die schwerwiegende Auswirkungen haben können. Beispielsweise können sie behaupten, Fakten falsch darstellen oder Meinungen präsentieren, als wären sie Tatsachen. Die Notwendigkeit, die Modelle durch menschliches Feedback zu korrigieren und neu zu kalibrieren, weist auf ähnliche Muster hin wie bei den früheren Expertensystemen: Ein reines Regel- oder Mustererkennungsmodell genügt nicht, um die Komplexität menschlicher Intelligenz abzubilden. Die Frage bleibt, ob das, was wir als Intelligenz bezeichnen, eigentlich erst mit dem vollständigen Verständnis von gesprochener Sprache und deren multimedialen Aspekten zugänglich wird.

Ein weiterer kritischer Punkt liegt in der Natur der Daten selbst. Die ausschließliche Nutzung schriftlich verfasster Sprachdaten könnte einen starken Bias erzeugen – die digitale Repräsentation von Sprache ist durch kulturelle, soziale und technische Faktoren geprägt, die nicht universell sind. Dies kann die Entwicklung von KI-Systemen beeinflussen und deren Anwendbarkeit auf reale, menschliche Kommunikationssituationen einschränken. Es ist faszinierend zu beobachten, dass sich die KI-Forschung zunehmend mit Möglichkeiten auseinandersetzt, nicht nur geschriebene, sondern auch gesprochene Sprache in ihre Modelle zu integrieren. Die Aufnahme von Audiodaten und die Entwicklung von Sound-Tokens, die Klanginformationen kodieren, könnten den Weg zu einem vielschichtigeren Verständnis menschlicher Kommunikation ebnen.

Dies wirft jedoch erneut die Frage auf, welche Annahmen wir treffen, wenn wir versuchen, menschliche Sprache und damit verbundene Intelligenz ausschließlich digital und datengetrieben zu erfassen und zu modellieren. Wissenschaftler wie McShane und Nirenburg betonen, dass die emulierte Sprachkompetenz von Maschinen ein zentraler Baustein für die Erreichung von künstlicher allgemeiner Intelligenz (AGI) ist. Doch diese Sichtweise berücksichtigt, dass Sprache und Intelligenz nicht einfach äquivalent sind – vielmehr ist die Sprachfähigkeit eher eine Manifestation umfassender kognitiver Fähigkeiten. Somit steckt im Erfassen und Nachbilden von Sprache eine große Herausforderung, die weitere interdisziplinäre Forschung zwischen Informatik, Linguistik, Philosophie und Neurowissenschaften erfordert. Parallel dazu mahnt Robin K.

Hill dazu, vorsichtig mit gewissen Annahmen umzugehen. Das Vertrauen in den digitalen Extraktionsprozess, in Tokenisierungsmethoden oder in rein prognosebasierte Generierung hat Grenzen. Die intellektuelle Vollständigkeit und inhaltliche Tiefe, die menschliche Intelligenz auszeichnet, lassen sich durch bloße Datenmengen nicht automatisiert ersetzen. Manchmal spiegeln die Fortschritte in der KI-Forschung mehr die Qualität der eingesetzten Daten und der menschlichen Intervention wider als eine echte Annäherung an autonome Intelligenz. Viele aktuelle Debatten über KI-Hubris, also die überschätzte Selbstüberschätzung der technischen Möglichkeiten, finden sich in den historischen Mustern wieder.

Der Zyklus von Euphorie, Ernüchterung und neuer Hoffnung scheint sich zu wiederholen, diesmal allerdings auf einem neuen Fundament aus Maschinellem Lernen und riesigen Sprachkorpora. Die Erkenntnis daraus ist wohl, dass die Suche nach echter künstlicher Intelligenz nicht durch einfache Skalierung von Modellen oder Rohdaten bewältigt werden kann. Vielmehr ist ein kritisches Hinterfragen der zugrunde liegenden Prämissen notwendig. Das Erforschen der Tiefen menschlicher Kommunikation, insbesondere durch die Einbindung von gesprochenem Wort, nonverbalen Signalen und komplexen kontextuellen Informationen, könnte den Weg zu robusteren KI-Systemen ebnen. Gleichzeitig fordert das Erdenken von Wegen, wie KI menschliches Sprachverstehen nicht nur nachahmen, sondern sinnvoll erweitern kann, eine offenere und multidisziplinäre Herangehensweise.

Die aktuelle Forschung bietet spannende Horizonte: Neue Ansätze zur Audioverarbeitung, multimodalen KI, die Text, Ton und Bild integriert, und die Erschließung von emotionaler sowie kultureller Intelligenz eröffnen Chancen für die nächste Generation von künstlichen Intelligenzsystemen. Allerdings bleibt das grundlegende Problem bestehen, dass Intelligenz nicht einfach ein Produkt großer Datenmengen und leistungsfähiger Algorithmen ist, sondern auch auf Fähigkeit und Einsicht basiert, die sich nicht allein aus digitalisierten Sprachdaten gewinnen lassen. Zusammenfassend lässt sich sagen, dass die Annahmen, die in der KI-Forschung beständig wiederkehren, von Anfang an kritisch geprüft werden müssen. Die Parallelen zwischen frühem symbolischem KI-Ansatz und gegenwärtiger statistischer Modellierung sind unübersehbar, ebenso aber die Herausforderungen, die diese Methoden mit sich bringen. Sprache bleibt ein Schlüssel zum Verständnis und zur Nachbildung von Intelligenz, doch ihre Komplexität verlangt nach neuen Forschungsmethoden und einem tiefgehenden Nachdenken über die Grenzen rein algorithmisch basierter Systeme.

Im Spannungsfeld zwischen maschineller Präzision und menschlicher Intuition liegt der Reiz und die Herausforderung heutiger KI-Forschung. Nur durch das Aufbrechen existierender Annahmen und das Integrieren vielfältiger Perspektiven kann der Weg zu einer wahrhaftigen künstlichen Intelligenz gestaltet werden, die über reine Textvorhersage hinausgeht und tiefere kognitive Fähigkeiten umfasst.