Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren auch die chemische Forschung und das chemische Wissen tiefgreifend beeinflusst. Diese Modelle, die auf umfangreichen Textdaten trainiert werden, zeigen erstaunliche Fähigkeiten, Sprache zu verstehen, zu generieren und auf Fragen zu antworten, für die sie nicht explizit trainiert wurden. Doch wie stehen diese maschinellen Systeme im direkten Vergleich zur Expertise erfahrener Chemiker? Welche Grenzen und Potenziale weisen sie auf? Dieser Artikel beleuchtet die Unterschiede und Gemeinsamkeiten zwischen den aktuellen LLMs und menschlichen Chemikern anhand neuester Forschungsergebnisse und stellt die Bedeutung für Wissenschaft, Bildung und Sicherheit dar. Große Sprachmodelle: Ein Überblick LLMs beruhen auf komplexen neuronalen Netzwerkarchitekturen, die durch das Training auf immensen Mengen schriftlicher Daten eine Art von implizitem Wissen aufbauen. Sie können Texte vervollständigen, Fragen beantworten oder sogar komplexe wissenschaftliche Erklärungen generieren.

Einige Modelle haben durch ihre Größe und Architektur sogar professionelle Prüfungen in anderen Fachgebieten bestanden, darunter das US-amerikanische Medizinexamen. Das Potential dieser Modelle, Wissen aus Texten verschiedenster Art zu extrahieren, macht sie auch im Bereich der Chemie äußerst interessant. Chemie als Domäne stellt jedoch besondere Anforderungen. Die Sprache der Chemie ist geprägt von Fachbegriffen, symbolischen Darstellungen (z. B.

molekulare Strukturen, Formeln), mathematischen Berechnungen und logischen Schlussfolgerungen. Aus diesem Grund wurden spezifische Benchmarks entwickelt, um die Fähigkeiten großer Sprachmodelle im chemischen Kontext genauer zu erfassen und bewerten zu können. ChemBench: Das Benchmarking-Framework für Chemie-LLMs Um die Fähigkeiten von LLMs gezielt in Chemiefragen zu messen, wurde das ChemBench-Framework geschaffen. Es umfasst einen umfangreichen Korpus aus mehr als 2.700 Fragen und Antworten, die vielfältige Themen und Fertigkeiten aus der Chemie abdecken.

Dabei werden sowohl Multiple-Choice-Fragen als auch offene Fragen berücksichtigt, um die Vielfalt realer Fragestellungen abzubilden. Ein besonderes Merkmal von ChemBench ist die Klassifizierung der Fragen nach erforderlichen Kompetenzen wie Wissen, Berechnung, logischem Denken und Intuition sowie eine Bewertung der Schwierigkeit. Somit lässt sich die Leistung der Modelle differenziert in verschiedenen Subdisziplinen der Chemie analysieren. Vergleich mit menschlichen Experten Zur Einordnung der Modellleistungen wurde eine Gruppe von erfahrenen Chemikern mit unterschiedlichem wissenschaftlichem Hintergrund eingeladen, dieselben Fragen unter realistischen Bedingungen zu beantworten. Die Experten durften dabei auch unterstützende Hilfsmittel wie Webrecherche oder chemische Zeichnungsprogramme verwenden, um die Vergleichbarkeit mit den computergestützten Systemen zu erhöhen.

Beeindruckende Leistungen und zugleich erkennbare Grenzen Die Ergebnisse zeigen, dass führende große Sprachmodelle wie etwa das Modell "o1-preview" bei der Gesamtbewertung der Fragen oft besser abschnitten als die beste menschliche Chemikerin oder der beste Chemiker in der Studie. Auch viele andere Modelle erzielten eine Leistung, die über dem Durchschnitt der Experten lag. Dies verdeutlicht ein enormes Potential, LLMs als unterstützende Werkzeuge in der chemischen Forschung und Lehre einzusetzen. Dennoch offenbaren die Modelle Schwächen, insbesondere bei Fragen, die tiefes Faktenwissen erfordern, das über allgemein verfügbare wissenschaftliche Publikationen hinausgeht. Hier scheitern auch Modelle mit aktiver Literaturrecherche, wenn sie keinen Zugriff auf spezialisierte Datenbanken haben, die von menschlichen Experten häufig genutzt werden, wie z.

B. PubChem oder Gestis. Mangel an zuverlässiger Selbsteinschätzung Ein weiteres Problem, das aufgedeckt wurde, ist die mangelhafte Fähigkeit der Modelle, ihre eigene Unsicherheit einzuschätzen. Während Chemiker häufig intuitiv erkennen, bei welchen Fragen sie unsicher sind, zeigen LLMs oft übermäßiges Selbstvertrauen bei falschen Antworten. Diese übermäßige Sicherheit birgt Risiken in praktischen Anwendungen, gerade im Hinblick auf Sicherheit und Gefahrenbeurteilung bei chemischen Substanzen.

Die Bedeutung von chemischer Intuition Chemische Intuition ist ein komplexes Phänomen, das wesentlich auf Erfahrungswissen, Mustererkennung und heuristischen Entscheidungsstrategien basiert. Bei der Aufgabe, Präferenzen zwischen zwei chemischen Verbindungen zu bewerten, konnten die Modelle die Entscheidungen erfahrener Chemiker kaum reproduzieren, ihre Ergebnisse lagen oft nahe am Zufallsniveau. Dies zeigt, dass Intuition und tiefes Domain-Verständnis für den erfolgreichen Einsatz in der Chemie auch in Zukunft eine wichtige Rolle spielen. Unterschiede in Leistung je nach Thema und Aufgabenform Die Auswertung nach Chemiethemen offenbart, dass Modelle in Bereichen wie allgemeiner und technischer Chemie besonders gute Ergebnisse erzielen. Hingegen bleiben Felder wie Toxikologie, Sicherheitsbewertung und analytische Chemie deutlich hinter den menschlichen Leistungen zurück.

Beispielsweise fällt es den Modellen schwer, bei komplexen Aufgaben wie der Vorhersage der Anzahl von Signalen in einem NMR-Spektrum korrekte Ergebnisse zu liefern, obwohl die gleiche Frage für menschliche Chemiker leichter zugänglich ist, da sie visuelle Darstellungen nutzen können – ein Vorteil, der den Modellen bislang weitgehend fehlt. Auswirkungen auf Chemie-Ausbildung und Forschung Angesichts der Tatsache, dass LLMs in vielen Bereichen menschliche Experten übertreffen oder zumindest erreichen, stellt sich die Frage, wie die Chemieausbildung und der Prüfungsprozess angepasst werden müssen. Während das reine Faktenwissen künftig immer stärker von automatisierten Systemen abgedeckt wird, wächst die Bedeutung von kritischem, kreativem und reflektierendem Denken. Die traditionellen Lehrmethoden sollten mehr Fokus auf das Verständnis von Zusammenhängen, komplexen Problemlösungen und dem Umgang mit Unsicherheiten legen. Solche Kompetenzen sind für die Interaktion mit KI-Systemen erforderlich, um diese sinnvoll als Werkzeuge zu integrieren.

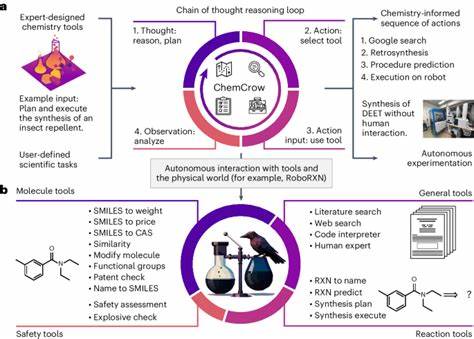

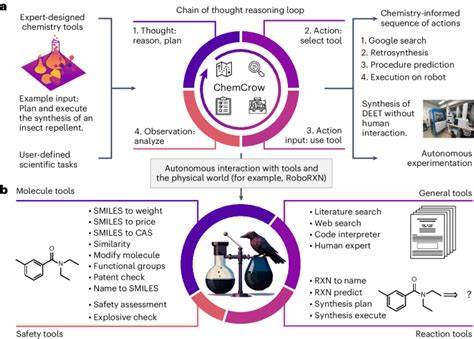

Sicherheitsaspekte und ethische Überlegungen Ein weiterer wichtiger Punkt betrifft die Sicherheit: Die Verfügbarkeit von spitzzulaufenden Modellen, die Chemieaufgaben lösen können, führt auch zu Risiken des Missbrauchs, beispielsweise bei der Entwicklung toxischer Substanzen. Da die Modelle keine ethische Einordnung ihrer Antworten vornehmen, ist es unabdingbar, angemessene Schutzmechanismen und Kontrollsysteme zu etablieren. Idealerweise sollten KI-Systeme für die Chemie um Module ergänzt werden, die Sicherheitshinweise geben und kritisch hinterfragen, wenn nach potenziell gefährlichen Produkten gefragt wird. Zudem bedarf es einer breiten gesellschaftlichen Diskussion über den verantwortungsvollen Einsatz dieser Technologien. Technologische Perspektiven und künftige Entwicklungen Die Forschung zeigt deutlich, dass die Leistungsfähigkeit von LLMs mit zunehmender Modellgröße und externer Integration von spezialisierten Datenquellen weiter steigen kann.

So könnten zukünftige Versionen besser in der Lage sein, verlässliche Fakten aus Datenbanken abzurufen, komplexe chemische Strukturen zu interpretieren und eine bessere Unsicherheitseinschätzung abzugeben. Die Kombination von LLMs mit spezialisierten chemischen Tools, die Molekülvisualisierungen, Simulationen und Reaktionsplanungen ermöglichen, verspricht eine neue Generation intelligenter Assistenten für Chemiker. Solche Systeme könnten die Experimentplanung optimieren, Literaturrecherchen beschleunigen und die Stoffentwicklung revolutionieren. Fazit Große Sprachmodelle haben einen beachtlichen Fortschritt im Verständnis und der Verarbeitung chemischen Wissens erzielt und können teilweise sogar menschliche Expertenleistungen übertreffen. Dennoch zeigen sich wesentliche Limitationen, insbesondere bei der Tiefe des Faktenwissens, einer verlässlichen Selbsteinschätzung und der chemischen Intuition.