Im Zeitalter der Digitalisierung gewinnen automatisierte Werkzeuge immer mehr an Bedeutung, insbesondere im Bereich der Softwareentwicklung. Künstliche Intelligenz (KI) verspricht dabei eine Revolution der traditionellen Arbeitsweisen, indem sie Prozesse effizienter und qualitativ hochwertiger gestaltet. Ein besonders spannendes Feld stellt die Anwendung von KI in der Code-Review dar. Code-Reviews sind essenziell, um Fehler frühzeitig zu identifizieren, Qualitätsstandards sicherzustellen und Software langfristig wartbar zu machen. Angesichts der Vielzahl an angebotenen KI-Code-Review-Tools stellt sich die Frage, welche Lösungen den höchsten Mehrwert bringen und worauf Entwicklerinnen und Entwickler bei der Nutzung achten sollten.

Im Rahmen eines jüngsten Vergleichs wurden acht aktuelle Tools eingehend getestet und bewertet. Dabei handelte es sich um Greptile, GitHub Copilot, CodeAnt, Ellipsis, Sourcery, CodeRabbit, CloudAEye und Kypso. Die Erkenntnisse bieten wertvolle Einblicke in die gegenwärtigen Möglichkeiten und Grenzen dieser Technologien. Das Ziel war, herauszufinden, ob und wie diese Tools den Review-Prozess unterstützen können, welche Fehler sie zuverlässig erkennen und wie präzise sowie hilfreich ihre Kommentare ausfallen. Die Grundlage der Tests bildete eine praxisnahe Pull Request (PR), die eine React-Anwendung integrierte, welche als Markdown-Editor fungiert und über eine Bild-Upload-Funktionalität in eine AWS S3-Bucket verfügte.

Diese Implementierung enthielt bewusst eingebettete Fehler unterschiedlicher Schweregrade – von einem schwerwiegenden Bug bis zu kleineren inkorrekten Parametern –, um die Fähigkeit der Tools zur Fehlererkennung realistisch zu prüfen. Auffällig war, dass keiner der Tests eine der schwerwiegendsten Fehler erkannte, der die korrekte Konfiguration der Region für den S3-Datei-Upload betraf. Dies legt nahe, dass KI-Systeme derzeit noch Schwierigkeiten haben, subtile, aber kritische Probleme über mehrere Codeseiten hinweg zu identifizieren. Bei moderaten und kleineren Fehlern zeigte sich ein differenziertes Bild: Einige der Tools konnten Fehler in der API-Route entdecken, während andere diese entweder verfehlten oder nur nebensächliche Hinweise gaben. Besonders interessant wurde die Abwägung zwischen Sensitivität und Präzision der Tools.

So zeigte sich, dass Tools mit einer höheren Fehlererkennungsquote – beispielhaft Greptile – auch eine stärker ausgeprägte Neigung zu falsch positiven Meldungen aufwiesen. Diese sogenannten False Alarms sind problematisch, da sie eine unnötige Überprüfung erfordern und somit den Workflow verlangsamen können. Auf der anderen Seite gab es Systeme wie GitHub Copilot, die zwar wenig Fehlalarme erzeugten, aber auch deutlich weniger tatsächliche Fehler signalisieren konnten. Ein weiteres wichtiges Qualitätsmerkmal ist die Verständlichkeit und Nutzbarkeit der generierten Kommentare. Hier punkteten einige Anbieter mit klaren Erklärungen und Lösungsvorschlägen, während andere oftmals nur oberflächliche Hinweise oder gar keine konkreten Handlungsvorschläge lieferten.

CodeRabbit beispielsweise fiel durch seine exzellenten visuellen Zusammenfassungen der PR auf, die für ein ganzheitliches Verständnis sehr hilfreich sein können, jedoch war die Qualität der eigentlichen Review-Kommentare eher schwach und von vielen Fehlalarmen begleitet. Die Geschwindigkeit und Zuverlässigkeit der Tools waren weitere entscheidende Faktoren. Gerade im professionellen Entwicklungskontext ist es wichtig, dass automatisierte Reviews zügig und ohne technische Ausfälle durchgeführt werden. GitHub Copilot überzeugte hierbei durch die schnellsten Antwortzeiten, während andere Anbieter wie CodeAnt eher langsam waren und zum Teil Probleme mit der Verfügbarkeit hatten. Einige Tools – darunter CloudAEye und Kypso – konnten im Test wegen technischer Schwierigkeiten überhaupt keine Reviews liefern, was der Nutzererfahrung deutlich abträglich ist.

Ein weiterer Aspekt, der aus den Tests hervorging, ist die noch geringe Fähigkeit der KI-Systeme, architektonische oder strategische Beratung zu leisten. Die Tools beschränkten sich überwiegend auf die Identifikation von syntaktischen Fehlern, Code-Smells oder kleineren Bugs. Eine ganzheitliche Perspektive, die beispielsweise alternative Implementierungsansätze oder Verbesserungen im Design vorschlägt, fand sich kaum. Hier bleibt derzeit die Kompetenz erfahrener Entwickler unersetzlich. Insgesamt lässt sich festhalten, dass KI-Code-Review-Tools zwar die Qualitätssicherung unterstützen und insbesondere repetitive oder langweilige Code-Abschnitte effizient prüfen können, jedoch nicht als Ersatz für menschliche Reviews gedacht sind.

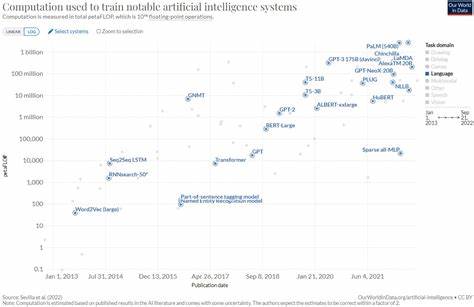

Dank ihrer Spezialisierung können sie Wissen über spezielle APIs oder seltene Fehlerszenarien ergänzen, die ein menschlicher Reviewer eventuell übersieht. Dennoch empfiehlt es sich, Sensibilität und Genauigkeit der Tools immer im Blick zu behalten und die automatische Review stets kritisch zu hinterfragen. Die Entwicklung im Bereich KI für Softwarequalität wird rasant voranschreiten. Neue Versionen und Updates können bestehende Schwächen beseitigen und die Qualität der Analysen verbessern. Entwicklerinnen und Entwickler sollten regelmäßig prüfen, welche Tools aktuell die besten Ergebnisse liefern und ihre Workflows entsprechend anpassen.

Ein interessanter Nebeneffekt der Nutzung solcher Systeme ist die gewonnene Zeitersparnis für die Entwicklerteams. Indem zunächst einfache Checks automatisiert ablaufen, kann mehr Zeit auf komplexere oder kreative Aufgaben verwendet werden. Zusammenfassend sind KI-Code-Review-Tools ein wertvolles Hilfsmittel für moderne Softwareprojekte, allerdings mit klaren Limitationen. Die Auswahl des richtigen Tools hängt wesentlich von den individuellen Anforderungen, der Projekttypologie und den gewünschten Features ab. Greptile empfiehlt sich durch seine hohe Findungsrate echter Probleme trotz vieler Fehlalarme, während GitHub Copilot vor allem durch seine Geschwindigkeit und geringe Fehlalarme überzeugt.

CodeRabbit glänzt als Ergänzung durch seine anschaulichen Visualisierungen, die den Gesamtüberblick erleichtern. An die Zukunft gerichtete Entwicklungen könnten proaktivere Vorschläge, bessere Integration in bestehende Entwicklungsumgebungen und eine vertiefte architektonische Beratung bieten. Für alle, die sich mit der Zukunft der KI in der Softwareentwicklung beschäftigen, ist die Beobachtung dieser Tools spannend und vielversprechend. Hier wird ein Teil der Art und Weise, wie Software künftig gewartet und verbessert wird, neu definiert. Die Kombination aus menschlicher Expertise und KI-Assistenz könnte letztlich den Weg zu stabileren, sichereren und effizienter entwickelten Anwendungen ebnen.

Parallel dazu bietet sich für Bildungseinrichtungen und Ausbilder eine Gelegenheit, Entwickler hinsichtlich des sinnvollen Umgangs mit KI im Entwicklungsprozess zu schulen. Das Verständnis der aktuellen Tool-Landschaft sowie der jeweiligen Vor- und Nachteile schafft eine solide Basis für den kompetenten Einsatz automatisierter Code-Review-Systeme. Schließlich besteht auch ein gewisser gesellschaftlicher Nutzen darin, dass KI-unterstützte Werkzeuge Fehler im Code schneller aufdecken und somit die Zuverlässigkeit von Software erhöhen. Gerade bei Anwendungen mit sicherheitskritischen Anforderungen kann dies entscheidend sein. Insgesamt zeigt der Vergleich der acht KI-Code-Review-Tools den gegenwärtigen Stand der Technik auf und gibt klare Hinweise darauf, welche Potenziale und Herausforderungen bei der Verknüpfung von Mensch und Maschine im Bereich der Softwarequalität bestehen.

Die spannende Entwicklung in diesem Segment bleibt garantiert ein zentrales Thema für Entwickler, Unternehmen und Forscher gleichermaßen.