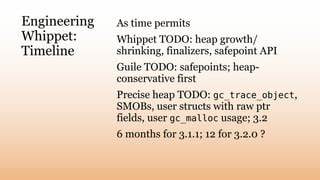

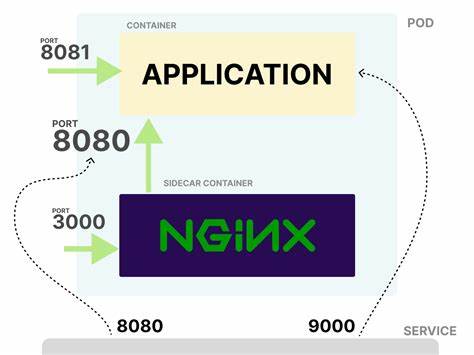

Die effiziente Verwaltung von Speicherressourcen ist eine der größten Herausforderungen moderner Programmiersprachen und Laufzeitsysteme. Insbesondere bei Sprachen wie Guile, die auf Scheme basieren, spielt die Garbage Collection (GC) eine entscheidende Rolle, um Speicherlecks zu verhindern, Programmleistung zu erhöhen und gleichzeitig die Entwicklerfreundlichkeit sicherzustellen. Ein besonders interessantes Projekt in diesem Kontext ist der Whippet GC, ein modernes Speichermanagementsystem, das in Kombination mit Guile eingesetzt wird. Im Mittelpunkt der aktuellen Entwicklungen stehen Fragen rund um Heuristiken zur Heap-Größenanpassung, das Problem der Fragmentierung und damit verbundene Herausforderungen bei der dynamischen Verwaltung wachsender Heaps. Guile unterstützt mittlerweile verschiedene Garbage Collector, darunter auch sogenannte Nofl-basierte Sammler, die konservativ alle Verbindungskanten (Edges) im Heap scannen.

Die Aktivierung erfolgt unkompliziert über Build-Parameter, was den Entwicklungsprozess erheblich erleichtert. Trotz der Benutzerfreundlichkeit gibt es komplexe technische Fragestellungen besonders im Bereich der Heap-Größenstrategie, die noch im Fokus der Forschung und Optimierung stehen. Das Speichermanagement im Whippet-System nutzt drei hauptsächliche Strategien zur Heap-Größenbestimmung. Neben einer starren Fixgröße besteht die Möglichkeit, den Heap dynamisch wachsen zu lassen – die sogenannte growable Policy. Darüber hinaus existiert eine adaptive Policy namens MemBalancer, die auf Laufzeitdaten basiert und den Heap bedarfsgerecht anpasst.

Die adaptive Methode ist langfristig das Ziel, da sie das Wachstum und Schrumpfen des Heaps flexibel und effizient steuern kann. Ein Problem bei der praktischen Umsetzung ist jedoch, dass dafür präzises Tracing der Heap-Verbindungen notwendig ist, um Speicherblöcke effizient umzuorganisieren und defragmentieren zu können. Da adaptive Heuristiken aktuell noch in der Entwicklung stecken, setzt Guile im Moment auf den growable Heap-Ansatz. Dieses Verfahren versucht, die Heap-Größe so zu wählen, dass diese mindestens dem Faktor 1,75 der Größe der lebenden (live) Objekte entspricht. Dieser Multiplikator ist variabel konfigurierbar und lässt sich über Umgebungsvariablen am Build- oder Laufzeitprozess anpassen.

Die Flexibilität bietet den Vorteil, den Heap bedarfsorientiert auszulegen, jedoch birgt sie Risiken im Zusammenhang mit einer unterschätzten Fragmentierung, die das System in einen livelock führen kann. Fragmentierung ist das Kernproblem, das die Speicherverwaltung vor erhebliche Schwierigkeiten stellt. In einem demonstrierten Szenario bei einer 10 MB großen Heap mit einem doppelten Multiplikator werden beispielsweise aufeinanderfolgende 16-Byte-Objekte alternierend mit 16-Byte-Lücken abgelegt. Wenn dann ein neues Objekt von 32 Byte zugewiesen werden soll, lässt sich dieses nicht in den vorhandenen Fragmenten platzieren. Die Garbage Collection startet, doch der Heuristik zufolge wird ein Wachstum des Heaps nicht vorgesehen, da dieser bereits als ausreichend groß eingestuft wird.

Dieses Verhalten führt zu wiederholten Aufräumzyklen (Sweep), ohne dass eine echte Speicherzuweisung gelingt – der bekannte livelock. Dieses praktische Problem wurde bereits bei der Initialisierung von Guile beobachtet und verdeutlicht, wie relevant und dringend die Verbesserung der Heuristiken ist. Einer der theoretisch idealen Lösungswege wäre die Eliminierung von Fragmentierung durch semi-space oder Copying-Collector-Methoden, die Speicherblöcke aktiv umorganisieren, um freie kontinuierliche Flächen zu schaffen. Im Fall von Guile sind solche Konzepte jedoch aufgrund der konservativen Erfassung von Zeigern und Edges schwieriger umzusetzen. Somit bleiben Heuristiken und andere praktikable Mittel zunächst wichtige Ansatzpunkte.

Eine vereinfachte Möglichkeit zur Minderung der Fragmentierung besteht darin, den Heap-Multiplikator stark zu erhöhen, so dass mehr leerer Raum und damit auch größere Lücken entstehen. Allerdings zeigt die Praxis, dass dafür bei sehr kleinen Objekten in Kombination mit häufigen Lücken multiplikative Faktoren im dreistelligen Bereich notwendig wären. Ein solches Vorgehen ist auf Grund des hohen Speicherbedarfs und ineffizienten Nutzung nicht tragfähig. Alternativ wären organisatorische Änderungen an der Heapstruktur denkbar. Viele etablierte Mark-Sweep-Collector teilen den Heap in sogenannte Blocks auf, in denen die Objekte strikt nach Größe gruppiert werden.

So können beispielsweise eigene Blöcke für 16-Byte-Objekte existieren, unabhängig von größeren Objekten. Doch auch hier kann theoretisch eine ähnliche Fragmentierung trotz Blockgrößenmanagement auftreten, insbesondere wenn die Blöcke selbst überproportional groß sind und nur sehr wenige Objekte enthalten. Die daraus resultierende Erkenntnis verdeutlicht, dass ohne Mechanismen zur aktiven Speicherdefragmentierung eine Heuristik alleine nicht ausreicht, um den Heap effizient zu dimensionieren. Das vermeintlich einfache Verhalten „Heap wächst proportional zur Anzahl lebender Objekte“ wird durch dynamische Fragmentierung entscheidend gestört. Dies macht die vorhersehbare Planung der maximalen Heap-Größe kompliziert bis unmöglich, besonders in Multithread-Umgebungen, in denen die Speicherbelegung sich jederzeit ändern kann.

Im Whippet GC-Projekt arbeiten Entwickler aktuell daran, pragmatische heuristische Lösungen zu finden, die diese Probleme mildern. Eine Überlegung ist etwa, nach jeder Garbage Collection eine Mindestanzahl an vollständig leeren Blöcken zu reservieren, auch wenn dies bedeutet, dass der Heap die in der Heuristik vorgegebene Größe überschreiten darf. Das Ziel ist es, ausreichende Allokationsflächen bereitzuhalten, um nicht in Endlosschleifen festzustecken. Dabei wird auf Erfahrungswerte bezüglich der Blockgröße (typischerweise 64 KB) und der maximalen Objektgröße (bis zu 8 KB für kleine Objekte) zurückgegriffen, um geeignete Reservierungsmengen abzuschätzen. Zusätzlich ist geplant, das Suchverhalten nach freien Löchern innerhalb des Heaps intelligenter zu gestalten.

Statt die gesamte Heapspeicher-Blöcke sequenziell abzusuchen, soll die Untersuchung proportional zur Größe der gewünschten Zuweisung begrenzt werden. Dies könnte durch logarithmische Funktionen oder durch einschränkende Blockmengen realisiert werden, um hohe Suchkosten und Verzögerungen bei der Speicherallokation zu vermeiden. Ein weiteres Vorbild sind Collector wie Immix, die speziell für mittelgroße Objekte arbeitsoptimierte Strategien einsetzen, indem sie Overflow-Blöcke reservieren, um fragmentierungsbedingte Zuweisungsverweigerungen zu umgehen. Nofl-basierte Sammler wie Whippet könnten ein ähnliches Konzept übernehmen, um die Verteilung und Zuordnung von Speicherblöcken feingranularer und leistungsfähiger zu machen. Trotz der noch bestehenden Herausforderungen zeigen erste Erfahrungen mit dem Nofl-basierten Whippet GC ein grundsätzlich vielversprechendes Potenzial.

Allerdings sind bisher häufige livelocks durch Fragementierung beobachtet worden, was sicherstellendere Heuristiken und strengere Policies im Heap-Wachstum erfordert. Im Vergleich zu etablierten Sammlern wie dem BDW-GC wirkt das Speichermanagement derzeit manchmal restriktiver und vorsichtiger, was sich langfristig jedoch durch präzisere Tracing-Methoden und Defragmentierungstechniken verbessern soll. Die Steuerung des Heaps ist nicht nur eine technische, sondern auch eine philosophische Frage der Garbage Collection. Wie kann ein System verlässlich und effizient wissen, wie groß sein Speicherpool wirklich werden muss? Die Realität mit Fragmentierung und konkurrierenden Threads macht sachlich exakte Antworten schwer möglich. Daher ist die Überlegung, ob Komponenten wie Defragmentierung und Evakuierung von Netzen (Evacuation) zwingend notwendig sind, um das „Gedächtnis“ eines Programms in geordneten Bahnen zu halten.

Die Community rund um Guile und Whippet ist sich bewusst, dass der aktuelle Entwicklungszeitplan stark von begrenzten Ressourcen geprägt ist. Verbesserungen im Jahr 2025 konzentrieren sich auf das präzise Tracing von Referenzen in Heaps mit konservativer Pointeranalyse. Dies ist entscheidend, um später Defragmentierungsmechanismen einzuführen, die die Fragmentierung deutlich verringern und das Wachstumsverhalten besser kontrollierbar machen. Abschließend lässt sich festhalten, dass die Fortschritte bei der Heap-Verwaltung von Guile mittels Whippet GC ein wichtiger Schritt in Richtung effizientere, zuverlässigere und skalierbare Laufzeitsysteme sind. Die Auseinandersetzung mit Heuristiken, Fragmentierung und dynamischer Heap-Anpassung demonstriert exemplarisch die Komplexität moderner Garbage Collection und die Bedeutung innovativer wissenschaftlicher Ansätze.

Mit einer Kombination aus theoretischen Einsichten und empirischen Tests arbeiten Entwickler kontinuierlich an Lösungen, die die Performance, Stabilität und Ressourcennutzung von Scheme-Systemen wie Guile grundlegend verbessern werden.