Künstliche Intelligenz (KI) hat in den letzten Jahren enorme Fortschritte gemacht. Von der Verarbeitung natürlicher Sprache bis zur Bild- und Spracherkennung entwickeln sich KI-Modelle in rasantem Tempo weiter. Doch trotz dieses beeindruckenden Fortschritts bleibt eine fundamentale Schwäche bestehen: Die meisten heute eingesetzten KI-Systeme hören grundsätzlich auf zu lernen, sobald sie nach einer Trainingsphase „ausgerollt“ werden. Dieses Phänomen stellt einen erheblichen Engpass dar, der das volle Potenzial intelligenter Maschinen noch stark begrenzt. Das grundsätzliche Problem heutiger KI-Modelle liegt in der strikten Trennung zwischen der Trainingsphase und der Anwendungsphase, auch als Inferenz bezeichnet.

Während der Trainingsphase werden die Modelle mit großen Mengen an Daten gefüttert und verändern ihre internen Parameter, um komplexe Aufgaben zu lernen. Diese Phase ist äußerst kostenintensiv und zeitaufwändig. Danach werden die Modelle in der Inferenzphase eingesetzt, in der sie Aufgaben erledigen, Fragen beantworten oder Vorhersagen treffen, ohne ihre internen Parameter weiter zu verändern. Das bedeutet, dass das modellierte Wissen fixiert ist und auf keine neuen Informationen reagieren kann, die nach dem Deployment auftauchen. Im Gegensatz dazu lernt der Mensch kontinuierlich.

Unser Gehirn verändert und erweitert sein Wissen permanent, passt sich dynamisch an neue Situationen an und integriert Erfahrungen fortwährend in sein Verständnis der Welt. Diese Fähigkeit zur lebenslangen oder kontinuierlichen Lernfähigkeit bleibt für heutige KI nur ein langfristiges Ziel. Solange KI-Systeme nicht in der Lage sind, neues Wissen während der Nutzung zu akkumulieren und ihren internen Zustand entsprechend anzupassen, bleiben sie in ihrer Adaptivität stark eingeschränkt. Ein zentrales Hindernis auf dem Weg zu kontinuierlich lernenden KI-Modellen ist das Problem des sogenannten „katastrophalen Vergessens“. Dabei handelt es sich um eine fundamentale Herausforderung, die auftritt, wenn ein KI-Modell neue Informationen aufnimmt und dabei alte Kenntnisse überschreibt oder vergisst.

Das Gleichgewicht zwischen Stabilität (dem Bewahren bereits gelernter Informationen) und Plastizität (der Fähigkeit, neue Informationen aufzunehmen) ist schwer zu finden. Ist ein Modell zu stabil, bleibt es unflexibel; ist es zu plastisch, geht wichtiges Wissen verloren. In der Forschung wurden verschiedene Ansätze entwickelt, um katastrophales Vergessen zu minimieren. Eine Methode ist das sogenannte „Replay“, bei dem alte Daten immer wieder mit neuen Daten zusammen trainiert werden, um verlorene Informationen zu erhalten. Eine andere Strategie setzt auf Regularisierungstechniken, die wichtige Modellparameter schützen, damit sie beim Lernen neuer Aufgaben nicht verändert werden.

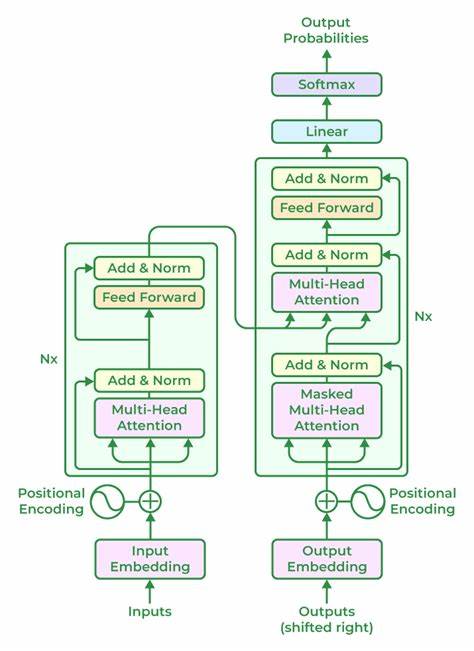

Architekturbasierte Lösungsansätze versuchen zudem durch dynamische Erweiterung des Modells neue Wissensgebiete in separaten Netzwerken zu integrieren. Trotz dieser Fortschritte scheitern alle Methoden bisher daran, in großem Maßstab praktikabel, effizient und langlebig zu funktionieren. Diese Limitierungen haben immense praktische Konsequenzen. KI-Modelle, die nach dem Deployment in ihrem Wissen statisch sind, können sich nicht an sich ändernde Umstände oder individuelle Nutzer anpassen. Dadurch entwickeln sich keine personalisierten Anwendungen, die auf spezifische Präferenzen und Abläufe des Nutzers eingehen.

Im umkämpften KI-Markt bedeutet dies auch, dass viele KI-Dienste funktional austauschbar bleiben – das senkt die Kundenbindung und erschwert es Unternehmen, dauerhafte Wettbewerbsvorteile zu schaffen. Es gibt jedoch auch Zwischenlösungen, die heute bereits Anwendung finden. Modella finetuning etwa ermöglicht es, ein vortrainiertes Modell auf neuen Daten nachzuschulen. Dieser Prozess ist zwar aufwändiger als reine Inferenz, schafft aber zumindest eine gewisse Aktualisierung der Fähigkeiten. Allerdings ist er ebenfalls kostenintensiv, komplex und kann bei stark veränderten Aufgaben zu katastrophalem Vergessen führen.

Eine weitere Technik ist in-context learning, bei der das Modell kurze Informationen im Eingabekontext berücksichtigt, ohne seine Struktur zu verändern. Diese Lernmethode ermöglicht flexible Anpassungen während einer Sitzung, doch das Gelernte bleibt nur temporär und geht bei einer neuen Sitzung verloren. Aktuelle Forschungs- und Entwicklungsarbeiten richten ihr Augenmerk auf sogenannte selbst-evolvierende Modelle beziehungsweise self-adaptive KI, die kontinuierliches Lernen ermöglichen. Diese Systeme sind in der Lage, ihre internen Zustände dynamisch zu verändern, neue Daten einzubeziehen und dabei gezielt Wissen zu speichern, ohne wichtige vorherige Fähigkeiten zu verlieren. Beispiele hierfür sind innovative Modelle, die durch eine Kombination aus Echtzeit-Reflexion, speicherbasiertem Lernen und verstärkendem Training eine ständige Selbstverbesserung anstreben.

Unternehmen und Forschungsinstitute wie Writer und Sakana AI setzen neue Maßstäbe, indem sie Architekturen entwickeln, die mithilfe modularer Komponenten oder flexibler Gewichtungsmechanismen eine task-spezifische Anpassung erlauben. Sowohl das im Januar 2025 vorgestellte Transformer²-Modell von Sakana als auch Writers selbst-evolvierende Produktionstechnologie zeigen, dass sich KI zunehmend in Richtung lebendiger, anpassungsfähiger Systeme entwickelt. Solche Anwendungen können sich auf den Kontext des Nutzers einstellen, Wissen über verschiedene Aufgaben hinweg bewahren und dabei skalierbar bleiben. Die Möglichkeit, KI so zu gestalten, dass sie kontinuierlich lernt, hat weitreichende Implikationen. In der Arbeitswelt könnten solche Systeme beispielsweise juristische Fachanwendungen, Recruiting-Tools oder medizinische Assistenzsysteme entwickeln, die über Monate und Jahre hinweg immer individueller und präziser werden.

Dies erhöht nicht nur die Effizienz, sondern schafft auch persönliche Bindungen zwischen Nutzer und Anwendung, die mit heutigen statischen KI-Systemen nicht möglich sind. Zudem ermöglichen selbstlernende KI-Modelle neue wirtschaftliche Chancen. Statt dass alle Nutzer dieselbe Version eines Modells verwenden, könnten personalisierte KI-Agenten entstehen, die maßgeschneiderte Problemlösungen bieten. Dies führt dazu, dass KI-Produkte langlebiger und weniger austauschbar werden – ein bedeutender Wettbewerbsvorteil in einem Markt mit zunehmender Produktähnlichkeit. Doch obwohl der Fortschritt beeindruckend ist, darf man die Herausforderungen nicht unterschätzen.

Kontinuierliches Lernen erfordert eine feine Balance, eine effiziente Verwaltung von Gedächtnisinhalten und flexible Modelle, die sich intelligent weiterentwickeln können. Aktuelle Verfahren müssen robust genug sein, um mit Veränderungen in Daten, Nutzungsumgebungen und Aufgabenvielfalt umzugehen, ohne an Genauigkeit oder Leistung einzubüßen. Zusammenfassend lässt sich sagen, dass die statische Natur heutiger KI-Modelle eine der größten Hemmnisse auf dem Weg zu echter, menschlich vergleichbarer Intelligenz darstellt. Die Forschung und Entwicklung hin zu kontinuierlich lernenden KI-Systemen steht jedoch kurz vor einem Durchbruch, der die Art und Weise, wie wir mit Maschinen interagieren und welche Rolle diese in unserem Alltag spielen, fundamental verändern wird. Die nächste Generation der KI wird nicht mehr nur stur Antworten berechnen, sondern dynamisch reagieren, sich selbst verbessern und sich an uns persönlich anpassen.

Diese Fähigkeit wird neue Märkte erschließen, bestehende Produkte revolutionieren und maßgeblich dazu beitragen, die Visionen einer künstlichen allgemeinen Intelligenz greifbar zu machen. Die Zukunft der KI ist lebendig, lernfähig und ständig im Wandel – und sie beginnt genau jetzt.