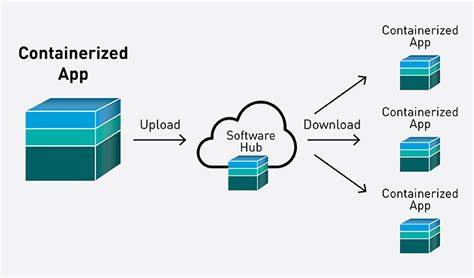

In der heutigen Softwareentwicklung sind Container-basierte Anwendungen durch ihre leichte Skalierbarkeit, Portabilität und Konsistenz beliebter denn je. Gerade bei kleinen Projekten, Hobby-Apps oder Side-Projects, stellen sich viele Entwickler die Frage, wie sie ihre containerbasierten Anwendungen am besten bereitstellen können, um sowohl einfache Bedienung als auch spätere Erweiterbarkeit sicherzustellen. In diesem Kontext bieten sich verschiedene Ansätze an, die auf die jeweiligen Bedürfnisse und Erfahrungsstände zugeschnitten sind. Ein gängiger Startpunkt für die lokale Entwicklung und das Testen ist Docker Compose. Dieses Tool erlaubt es, sämtliche Container, wie Python-Anwendungen, Datenbanken wie Postgres oder Services zur Datenbereinigung als einzelne, miteinander verknüpfte Instanzen zu starten.

Die Handhabung ist relativ einfach, zudem können sensible Daten über .env-Dateien verwaltet werden, wobei zur weiteren Absicherung auch Docker Secrets zum Einsatz kommen können. Allerdings ist diese Lösung meist nur lokal und nicht für die produktive Bereitstellung auf externen Servern ausgelegt. Für das Hosting kleiner Projekte gibt es heute zahlreiche Möglichkeiten, die sich hinsichtlich Komplexität, Wartungsaufwand, Skalierbarkeit und Kostenunterschiede deutlich unterscheiden. Ein häufiger Gedanke ist die Nutzung eines klassischen virtuellen Servers (vServer) bei Providern wie DigitalOcean oder Hetzner.

Ein vServer bietet die volle Kontrolle über das System, jedoch setzen Installation und Betrieb einige Infrastrukturkenntnisse voraus. Die Einrichtung umfasst neben der Grundkonfiguration des Servers auch die Installation von Docker, das Aufsetzen eines Reverse Proxys wie Nginx oder Caddy für SSL/TLS-Termination und zum Routen des Traffics. Für die automatisierte Verwaltung der Container kann weiterhin ein Orchestrierungstool oder einfache Skripte hinzugezogen werden. Alternativ rücken Managed Kubernetes-Services immer mehr in den Fokus, auch für kleine Projekte. Anbieter wie DigitalOcean, GCP oder AWS machen es möglich, Kubernetes Cluster bereitzustellen, ohne sich selbst mit dem kompletten Ökosystem auseinanderzusetzen.

Kubernetes bietet ein mächtiges Framework für das automatisierte Deployment, Skalierung und Management von Containern. Jedoch kann die Komplexität und der anfängliche Lernaufwand für Einsteiger abschreckend sein. Für kleine Projekte stellt sich daher die Frage, ob der administrative Aufwand gerechtfertigt ist oder ob leichtere Lösungen bevorzugt werden sollten. Hier kommen Plattformen wie Dokku oder Dokploy ins Spiel. Diese Werkzeuge basieren auf einfachen Konzepten, die das Deployment von Container-basierten Anwendungen stark vereinfachen.

Dokku beispielsweise verwendet Docker unter der Haube und ermöglicht eine Git-basierte Bereitstellung, ähnlich wie bei Plattformen wie Heroku, jedoch läuft es eigenständig auf einem eigenen Server. Durch einfache CLI-Kommandos können Anwendungen deployed, verwaltet und skaliert werden. Dennoch berichten Nutzer, dass das Tingeln durch Shell-Skripte bei Dokku mit der Zeit unübersichtlich wird, besonders wenn man das System längere Zeit nicht verwendet. Dokploy ist eine weitere Lösung, die etwas weniger Bekanntheit genießt, aber mit dem Vorteil punktet, dass das Tool auf dem Host installiert wird und dadurch einfache Deployments von Git-Repositories ermöglicht. Die Flexibilität birgt allerdings auch einen Nachteil, da der Wechsel auf größere Server oder andere Umgebungen mit einem gewissen Mehraufwand verbunden ist.

In jüngerer Zeit entstehen zudem neue Plattformen, die genau diese Schwachstellen adressieren wollen. DollarDeploy zum Beispiel positioniert sich als leichtgewichtige Plattform, die einfache Deployments vom GitHub-Repository aus ermöglicht, automatische HTTPS-Zertifikate generiert, Hosts verwaltet und Sicherungen übernimmt – und das zu einem vergleichsweise günstigen Preis. Solche Cloud-nativen Lösungen erleichtern den Einstieg in die Container-Bereitstellung mit Fokus auf Benutzerfreundlichkeit und geringen administrativen Aufwand. Eine weitere interessante Alternative für kleine Projekte ist es, externe Datenbankdienste zu verwenden. Durch das Auslagern der Postgres-Datenbank in einen Managed Service kann man den komplexen Betrieb auf eigenen Systemen umgehen und sich auf die Skalierung der eigentlichen Applikationen konzentrieren.

Dies erlaubt beispielsweise, die sogenannten Worker-Services horizontal zu skalieren, wenn die Last steigt. So wird Flexibilität bei gleichzeitig überschaubarem Wartungsaufwand möglich. Bei der Auswahl der Infrastruktur für ein kleines Projekt ist es essenziell, den eigenen technischen Erfahrungshintergrund zu berücksichtigen. Wer wenig Erfahrung im Infrastrukturmanagement hat, ist mit Managed Solutions oder Plattform-as-a-Service (PaaS)-Anbietern meist besser bedient als mit der selbstgebauten Kubernetesschmiede. Für erfahrene Entwickler kann hingegen die eigene vServer-Lösung Vorteile in der Flexibilität und den laufenden Kosten bieten, wenn sie sorgfältig automatisiert wird.

Neben der Infrastruktur spielt auch die Wahl des Reverse Proxys eine bedeutende Rolle. Tools wie Nginx oder Caddy übernehmen als Frontend die Traffic-Verteilung, Sicherheitsfunktionen wie TLS-Verschlüsselung und können die Last zwischen mehreren Instanzen verteilen. Caddy hebt sich besonders durch die eingebaute automatische HTTPS-Zertifizierung dank Let’s Encrypt hervor, was die Einrichtung deutlich vereinfacht. Wer Wert auf ein Dashboard oder eine Weboberfläche für die Verwaltung seiner Container legt, findet mit Projekten wie Webserver, einem Node.js-basierten Tool, eine praktische Lösung.

Anwendungen und Docker-Compose-Instanzen können so per Webbrowser gestartet und überwacht werden – ideal für Entwickler, die eine einfache und visuelle Kontrolle über ihre Deployments wünschen. Nicht zuletzt sollte man auch zukünftige Skalierbarkeit und Wartbarkeit im Blick haben. Die ausufernde Nutzung von Shell-Skripten oder komplexe Orchestrierungsstrukturen können kleine Projekte schnell überfordern. Daher empfiehlt sich, von Anfang an klare Strukturen zu schaffen, die jederzeit erweiterbar sind, ohne dass die Komplexität unüberschaubar wird. Dokumentationen und die Verwendung etablierter Community-Tools erleichtern zudem die langfristige Pflege und Weiterentwicklung.