Die Cloud-Technologie hat die Art und Weise, wie Unternehmen Rechenressourcen einsetzen, revolutioniert. Besonders in Bereichen wie Künstlicher Intelligenz, maschinellem Lernen und datenintensiven Anwendungen sind virtuelle Ressourcen wie GPUs (Grafikprozessoren) unverzichtbar geworden. Doch der dynamische Cloud-Markt ist einem ständigen Wandel unterworfen – Preise schwanken, Kapazitäten verändern sich und Anforderungen von Nutzern variieren stark. Vor diesem Hintergrund gewinnt die lineare Programmierung als mathematisches Werkzeug zunehmend an Bedeutung, um diese Herausforderungen effizient zu meistern und dabei sowohl Kosteneffizienz als auch Skalierbarkeit sicherzustellen. Lineare Programmierung (LP) ist eine Methode aus der Optimierung, die dabei hilft, ein Ziel – etwa Kostenminimierung oder Gewinnmaximierung – unter Berücksichtigung bestimmter linearer Nebenbedingungen zu erreichen.

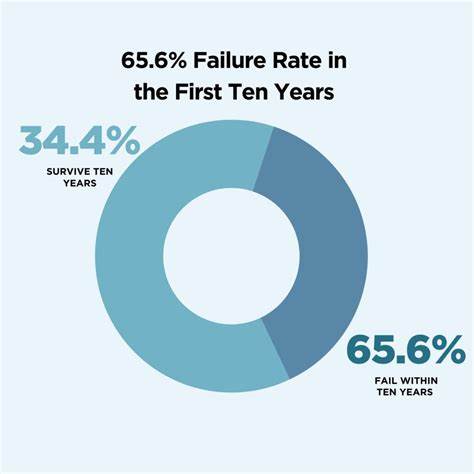

Im Cloud-Bereich bedeutet das, dass verschiedenste Ressourcen wie GPUs, CPUs und Arbeitsspeicher (RAM) optimal verteilt werden können, um den Bedarf von Nutzern präzise zu erfüllen. Die rasante Entwicklung und Volatilität der GPU-Märkte, bei der beispielsweise NVIDIA immer wieder neue Architekturen vorstellt, macht manuelles Kapazitätsmanagement oft zum Albtraum. Preise steigen vorübergehend, Engpässe entstehen und das problemlose Bereitstellen von Rechenleistung gerät schnell aus der Balance. Moderne Cloudanbieter wie Modal setzen genau hier an und nutzen LP-Algorithmen, um ihre Ressourcen intelligent zu steuern. Ein Kernstück ist der sogenannte „Resource Solver“ – ein Algorithmus, der in Echtzeit Daten über aktuelle Preise, Verfügbarkeit und Performance verschiedenster Cloud-Instanztypen nutzt, um die kostengünstigste und gleichzeitig leistungsfähigste Kombination zusammenzustellen.

Das Ergebnis ist eine optimale Strategie, die nicht nur den Bedarf deckt, sondern auch kurzfristige Preisvorteile und Marktineffizienzen ausnutzt. So konnten schon beträchtliche Einsparungen erzielt werden, indem leistungsfähigere GPUs zu günstigeren Preisen bevorzugt wurden. Ein einfaches Beispiel verdeutlicht die Idee: Wenn Kunden ausschließlich eine bestimmte GPU-Art benötigen, können diese Anfragen summiert und der günstigste Anbieter mit ausreichender Kapazität ausgewählt werden. Dieser einfache Fall lässt sich mit einem kleinen Skript lösen, das nach aufsteigendem Preis die GPUs zuteilt, bis der Bedarf gedeckt ist. Doch sobald weitere Dimensionen hinzukommen – verschiedene GPU-Typen, zusätzliche CPU- und RAM-Anforderungen, regionale Einschränkungen und schwankende Nachfrage – wächst die Komplexität exponentiell.

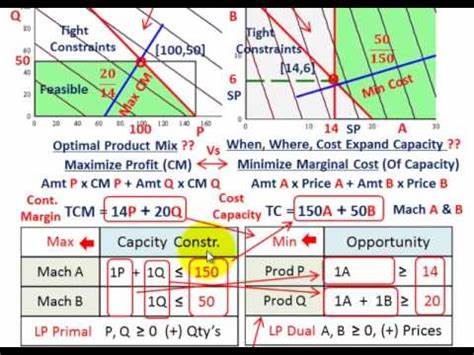

Die herkömmliche manuelle oder heuristische Planung stößt hier rasch an Grenzen und ist fehleranfällig. Genau hier entfaltet die lineare Programmierung ihre Stärke: Das komplexe Ressourcenallokationsproblem lässt sich als mathematisches Modell formulieren, dessen Ziel es ist, die Gesamtkosten zu minimieren. Constraints repräsentieren dabei verfügbare Kapazitäten, Nutzeranforderungen und technische Einschränkungen. Die hierfür eingesetzten Solving-Algorithmen durchsuchen effizient die Lösungsmengen und finden in kurzer Zeit optimale oder nahe optimale Verteilungen. Dabei kommt häufig der Simplex-Algorithmus zum Einsatz, eine Methode, die in den 1940er Jahren von George Dantzig entwickelt wurde und seitdem als Standard in der LP gilt.

Ein charakteristisches Problem bei der Anwendung in Cloud-Umgebungen ist der Balanceakt zwischen Skalierbarkeit und Reaktionsgeschwindigkeit. Nutzer erwarten, dass ihre Container oder Aufgaben unmittelbar gestartet werden können, während das Hochfahren neuer Instanzen mehrere Minuten dauern kann. Daher ist es sinnvoll, eine Pufferzone an Ressourcen vorzuhalten, um kurzfristige Lastspitzen abzufangen. Diese Puffer bedeuten jedoch zusätzliche Kosten. Die Herausforderung besteht darin, durch geschicktes LP-Modellieren diese Kosten zu minimieren, ohne die Qualität des Nutzererlebnisses zu beeinträchtigen.

In der Praxis bedeutet das, dass der Resource Solver nicht nur den aktuellen Bedarf abdeckt, sondern auch prognostiziert, wie sich Nachfrage verändern wird. Er berücksichtigt dabei temporäre Preisnachlässe und Engpässe bei Cloud-Anbietern. Wenn etwa Anbieter A wegen hoher Nachfrage keine weiteren Instanzen bereitstellen kann, lernt das System aus bisherigen Fehlschlägen und berücksichtigt diese Limitierungen in Folge-Solve-Durchläufen. Über diese Feedbackschleife wird mit der Zeit die gesamte Ressourcenzuteilung immer robuster, schneller und kostengünstiger. Herausforderungen gibt es dennoch.

Große und vielseitige Inventare von Maschinen verschiedener Anbieter und Regionen können die LP-Probleme komplex machen und Lösungszeiten unnötig in die Länge ziehen. Zu lange Lösezeiten würden die Skalierbarkeit zugunsten der Optimalität gefährden. Hier helfen Vorverarbeitungs- und Heuristik-Methoden, irrelevante oder suboptimale Optionen schon vorab auszuschließen. Obwohl dadurch die Genauigkeit minimal leidet, wird die Reaktionsgeschwindigkeit deutlich gesteigert und die Zufriedenheit der Endanwender steigt. Die Integration von LP in Automatisierungssysteme ermöglicht zudem eine strikte Trennung zwischen Optimierungslogik und operativer Ausführung.

So generiert der Optimierer Vorschläge, welche Instanzen hinzu- oder heruntergefahren werden müssen, während ein Hintergrundsystem diese Entscheidungen umsetzt, den Status der Cloud-Ressourcen überwacht und bei Fehlern eingreift. Dies entspricht modernen Ansprüchen an Skalierbarkeit und Ausfallsicherheit in Cloud-Architekturen. Ein weiterer Vorteil von LP-basierten Systemen liegt in ihrer Flexibilität. Neue Anforderungen, wie zusätzliche Ressourcenarten, Nutzerpräferenzen oder Preismodell-Änderungen, können relativ einfach ins Modell eingebaut werden. Das macht LP für Unternehmen besonders attraktiv, die sich in einem dynamischen Marktumfeld bewegen und bei gleichzeitiger Komplexität schnelle, datengetriebene Entscheidungen treffen müssen.

Obwohl die Ursprünge der linearen Programmierung tief in der Mathematik und militärischen Logistik liegen, hat sich ihre Anwendung in der IT und speziell im Cloud Management als wegweisend erwiesen. Sie ermöglicht es Unternehmen, das ständige Auf und Ab der Preise und Verfügbarkeiten nicht als Problem, sondern als Chance zu sehen. Statt mit durchschnittlichen Regeln und heuristischen Ansätzen zu arbeiten, werden reale Marktgegebenheiten exakt modelliert und daraus ein klarer Handlungsplan abgeleitet. Zusammenfassend lässt sich festhalten, dass LP ein Schlüsselelement moderner Cloud-Ressourcenverwaltung geworden ist. Es ist das Werkzeug, mit dem Unternehmen in der Lage sind, komplexe Nachfrageprofile zu bedienen, Betriebskosten zu senken und dabei einen reaktionsschnellen Service für ihre Nutzer sicherzustellen.

Die Kombination aus bewährten mathematischen Algorithmen, heuristischen Vorverarbeitungsschritten und intelligentem Feedbackmanagement sorgt dafür, dass Cloud-Ressourcen heute effizienter genutzt werden können als je zuvor. Für Unternehmen, die sich in einem schnell wandelnden IT-Umfeld beweisen wollen, bieten LP-basierte Systeme eine nachhaltige und zukunftsfähige Lösung. Die Zukunft der Cloud gehört denen, die ihre Ressourcen mit mathematischer Präzision optimieren und ihre Nutzer mit maximaler Schnelligkeit und minimalen Kosten bedienen können.