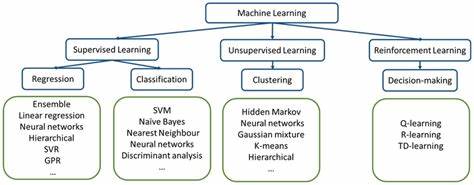

Die Entwicklung von maschinellen Lerntechnologien steht an einem entscheidenden Wendepunkt, da immer komplexere Modelle wie Transformer die Forschung und Anwendung von künstlicher Intelligenz grundlegend verändern. Dennoch herrscht Uneinigkeit darüber, welche Ansätze den größten Erfolg versprechen: Setzt man auf das emergente Verhalten bestehender Architekturen, oder sind gezielte, ingenieurmäßige Eingriffe notwendig, um neue Fähigkeiten zu ermöglichen? Ein genauer Blick auf beide Paradigmen schafft Klarheit und hilft einzuschätzen, wo die Zukunft des maschinellen Lernens liegen könnte. Eine einflussreiche Denkrichtung im Bereich der KI-Entwicklung ist die sogenannte Skalierungsthese. Anhänger dieser Schule vertreten die Auffassung, dass vor allem das Signalisieren von geeigneten Anreizen sowie das schiere Vergrößern der Modellparameter und des Trainingsdatensatzes ausreichen, um fortschrittliche Intelligenzsysteme zu schaffen. Diese Sichtweise fußt auf Erkenntnissen aus der Verstärkungslern-Policy-Optimierung und wird von Forschern unterstützt, die davon ausgehen, dass die bloße Ausweitung von Datenmenge und Modellgröße signifikant bessere Ergebnisse hervorbringen wird.

In extremen Varianten, wie die von Geoffrey Hinton vertretene Haltung, gilt die Vorhersage des nächsten Tokens – also das unüberwachte Pre-Training basierend auf Text – als der entscheidende Faktor, auf dem sich künftige Durchbrüche gründen lassen. Dem gegenüber steht die Ingenieursparadigma, die davon ausgeht, dass reine Skalierung nicht zum Ziel führt und stattdessen neue Architekturen und wissenschaftliche Innovationen erforderlich sind. Befürworter argumentieren, dass beispielsweise spezialisierte Weltmodelle oder andere neuartige Netzwerktypen notwendig sind, um die KI-Systeme auf eine höhere Stufe kognitiver Fähigkeiten zu heben. Bedeutende Experten wie Yann Le Cun zählen zu denjenigen, die diese Sichtweise vertreten und auf komplexere, gezielt entworfene Systemstrukturen setzen. Eine hilfreiche Leitlinie zur Orientierung in diesem Meinungsstreit bilden drei zentrale Prinzipien, die darüber entscheiden, ob ein maschinelles Lernmodell einer Fähigkeit durch gezielte Architekturentwicklung oder durch emergentes Verhalten zur Verfügung gestellt werden sollte.

Erstens gilt: Man sollte nichts architektonisch vorwegnehmen, was sich durch Lernprozesse selbst herausbilden kann. Dies bedeutet, dass sich viele komplexe Verbindungen und Muster innerhalb eines Netzwerks von selbst entwickeln, so dass es unnötig oder sogar kontraproduktiv wäre, diese vorab zu erzwingen. Zweitens empfiehlt es sich, gezielt jene Komponenten zu entwerfen, die ohne explizite Strukturierung nicht von alleine entstehen können, wobei die natürliche Freiheit zur Adaptation und Emergenz möglichst erhalten bleiben sollte. So bleibt Raum für unvorhergesehene, komplexe Funktionalitäten innerhalb der gewünschten Verhaltensweisen. Drittens sollten ingenieurmäßige Eingriffe nur dann stattfinden, wenn sie klar messbar zu besseren Leistungen führen und ansonsten auf emergente Entwicklungen vertraut werden sollte.

Dies ist beispielsweise beim Selbstaufmerksamkeitsmechanismus der Fall, der sich als bahnbrechend in der Modellarchitektur etabliert hat. Ein Beispiel, das das erste Prinzip illustriert, ist die Analogie zum biologischen Connectome. Im menschlichen Gehirn bilden sich hochkomplexe, flexible Netzwerkverbindungen aus. Entsprechend ist es nicht sinnvoll, künstliche Netzwerke mit vorgegebenen spezialisierten Knotenpunkten oder Verbindungsstellen zu konstruieren, sondern besser, dem System durch Lernalgorithmen die Freiheit zur Entfaltung solcher Strukturen zu lassen. Ähnliche Überlegungen gelten für bestimmte modulare Architekturen, die sich durch dynamische Verbindungen und flexible Rückkopplungen auszeichnen können.

Das zweite Prinzip bringt die Notwendigkeit von Wiederholungen oder Rekurrenz in der Tiefe von Netzwerken zur Sprache. Um eine zuverlässige Komposition von Wissensrepräsentationen zu ermöglichen, ist ein Modell theoretisch halb unendlich tief erforderlich, da die Anzahl der möglichen Kombinationsoperationen enorm groß ist. Aktuelle Ansätze, die sogenanntes „Reasoning“ oder „Denken“ modellieren wollen, implementieren Rekurrenz oft auf relativ grobe Weise, indem die letzten Schichten nach der Verarbeitung eines Eingangs wieder als Input für die ersten Schichten verwendet werden. Diese Art der Rückkopplung ist zwar funktional, aber in ihrer Modularität und Feinfühligkeit eingeschränkt. Wesentlich eleganter wäre es, wenn einzelne Schichten dynamisch wählen könnten, zu welchen anderen Schichten sie Verbindungen aufbauen und wann sie ihren Prozess beenden.

Dadurch könnten sich Subnetzwerke oder Module bilden, die sich miteinander kombinieren lassen und so eine höhere Flexibilität bieten – ähnlich der Art und Weise, wie Rückkopplungen im menschlichen Gehirn rund 60 Prozent der Verbindungen darstellen. Dieser Ansatz ist auch eine Chance, den Fokus weg von der Sprache und hin zu latenten Repräsentationsräumen zu verschieben. Sprachbasierte Modelldarstellungen sind in ihrer Ausdruckskraft limitiert, während latentere Denkweisen potenziell deutlich tiefgreifendere und vielseitigere Strukturen erlauben. Das dritte Prinzip eröffnet einen interessanten Diskussionspunkt in Bezug auf die derzeit vorherrschende Praxis der aufeinanderfolgenden Stapelung von Selbstaufmerksamkeits- und Feedforward-Netzwerken in Transformer-Modellen. Die verbreitete Begründung dafür ist, dass jede Schicht abstraktere Darstellungen erzeugt als die vorherige, womit eine schrittweise Verallgemeinerung der Informationen erreicht wird.

Doch es ist plausibel, dass ein einziges rekurrentes Netzwerk in der Tiefe ausreichen könnte, wenn es die Möglichkeit hätte, nach eigenem Ermessen jederzeit auf eine Aufmerksamkeits-Schicht zuzugreifen. Dieses Konzept ähnelt der menschlichen Fähigkeit, Passagen in Texten wiederholt zu lesen, wenn dies zur besseren Verarbeitung beiträgt, ohne dass dies zum Automatismus wird. Ein weiterer interessanter Fall sind sogenannte Mixture-of-Experts-Modelle (MoE). Anstatt ein großes einzelnes Netzwerk zu verwenden, setzen diese auf mehrere kleinere, spezialisierte Teilnetzwerke („Experten“), die über ein sogenanntes Router-Netzwerk selektiv aktiviert werden. Obwohl dieses Konzept Skalierbarkeit ermöglicht und auf den ersten Blick eine bessere Spezialisierung verspricht, weisen MoE-Modelle eine breitere Aktivierung einzelner Experten auf, was zu erhöhtem Rechenaufwand führt.

Zudem beschränkt sich die Aktivierung meist auf lediglich zwei Experten pro Token, wodurch die Spezialisierung auf Makro-Themen potenziell leidet. Somit widersprechen MoE-Modelle dem ersten Prinzip, da sie zu festgelegte und nicht spontan emergente Netzwerkstrukturen erzwingen. Interessanterweise zeigt aktuelle Forschung, dass die Input-Dimensionen eines Modells negativ mit dessen Fähigkeit zur Null-Schuss-Generalisation korrelieren. Das bedeutet, höhere Eingabedimensionen können die Flexibilität in unbekannten Aufgaben erschweren. Modelle wie Variational Autoencoder, die eine Dimensionenreduktion erzwingen, könnten daher Vorteile bringen.

Allerdings ist unklar, ob diese Einschränkungen eher durch festgelegte Architektur-Designs entstehen (also ingenieurmäßige Eingriffe) oder ob man besser darauf vertraut, dass sich nützliche Komprimierungen im Modell selbst entwickeln. Tatsächlich wäre eine solche Dimensionseinschränkung vergleichbar mit einer Gestaltung des Connectomes und deshalb möglicherweise besser der Emergenz zu überlassen. Ein außergewöhnliches Konzept, das derzeit noch selten in mainstream ML-Architekturen Anwendung findet, ist das episodische Gedächtnis. Dieses ist im menschlichen Gehirn eine Grundlage für die Ausbildung von semantischem Wissen und wesentlich für effizientes Lernen. In KI-Modellen wurde episodisches Gedächtnis bislang kaum implementiert und bleibt überwiegend ein Forschungsgebiet.

Ein wichtiger Grund hierfür ist, dass ein „aktives“ Lernen – das heißt Lernen außerhalb reiner Fehler-Backpropagation – wahrscheinlich auf spezielle Lernalgorithmen angewiesen ist. Diese könnten etwa ein dediziertes Feedback- oder Lernnetz umfassen, das möglicherweise auch von neuromodulatorischen Mechanismen unterstützt wird. Hier zeigt sich ganz klar, dass ein rein emergenter Ansatz nicht ausreichen kann und ingenieurmäßige Gestaltung gefragt ist. Interessanterweise stellt Curriculum Learning eine Ausnahmestellung dar und fällt nicht direkt unter eines der drei Prinzipien für Architekturentwicklung. Als Trainingsstrategie, bei der das Modell schrittweise mit zunehmend komplexeren Daten konfrontiert wird, verbessert es die Leistung oft deutlich im Vergleich zu einer Mischung unterschiedlich komplexer Daten bereits zu Beginn.

Daher sollte Curriculum Learning – unabhängig von der Architektur – konsequent zur Anwendung kommen. Abschließend zeigt die Analyse, dass es keineswegs nur um das Entweder-Oder von Emergenz und Engineering geht. Vielmehr gilt es, die einzelnen Techniken und Komponenten differenziert zu betrachten und jeweils auf Basis ihrer Eigenschaften und Leistungsfähigkeit zu entscheiden. Manche Strukturen – etwa flexible Hub-Netzwerke – entfalten sich am besten aus sich selbst heraus, andere – insbesondere solche, die aktive Lernmechanismen oder tiefergehende modularisierte Rekurrenz erfordern – müssen bewusst und gezielt entworfen werden. Darüber hinaus bietet die Vereinfachung von strukturellen Wiederholungen durch dynamische Netzwerkverbindungen neue Möglichkeiten, Modelle kompakter und gleichzeitig leistungsfähiger zu gestalten.

Die Zukunft der KI liegt somit in einem sensiblen Zusammenspiel zwischen gezielter Ingenieurskunst und der Nutzung der natürlichen Kreativität, die in emergenten Lerndynamiken verborgen liegt. Um das volle Potenzial moderner Transformer-Architekturen auszuschöpfen, ist es essenziell, diese Balance zu verstehen und für jede neue Herausforderung eine maßgeschneiderte Strategie zu entwickeln.