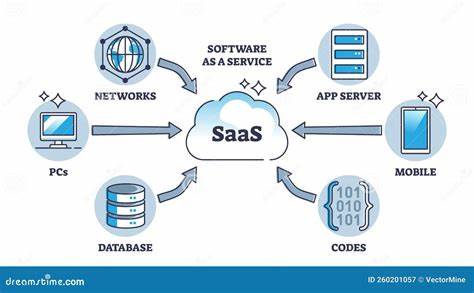

Künstliche Intelligenz hat in den letzten Jahren enorme Fortschritte gemacht, was sich vor allem an der Verbreitung großer Sprachmodelle wie GPT zeigt. Diese Modelle erzielen beeindruckende Leistungen in der Verarbeitung natürlicher Sprache, beim Verfassen von Texten und bei der Beantwortung von komplexen Fragen. Gleichzeitig offenbaren sich jedoch auch fundamentale Grenzen, besonders wenn es um das Gedächtnis der KI geht. Die sogenannten generativen Sprachmodelle vergessen oft Informationen aus vorangegangenen Interaktionen, sobald die Sitzung beendet wird. Das wirkt sich gerade bei Anwendungen aus, die auf kontinuierliche oder kontextsensitive Dialoge setzen, etwa bei AI-gesteuerten Software-as-a-Service (SaaS)-Plattformen.

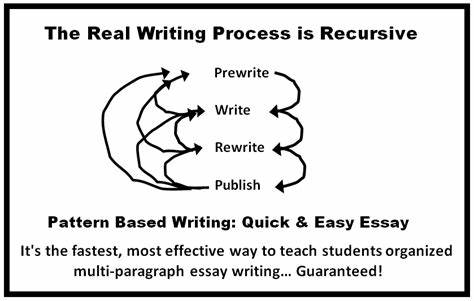

Hier setzen moderne Ansätze wie Plug-and-Play Scoped Memory an, um eine nachhaltige Speicherfunktion für KI-Systeme bereitzustellen. Doch wie wertvoll ist dieser Ansatz tatsächlich, welche Herausforderungen werden damit adressiert und was macht ihn für Entwickler und Endnutzer interessant? Um diese Fragen umfassend zu beantworten, lohnt sich zunächst ein Blick auf die Schwachstellen aktueller KI-Modelle im Gedächtnisbereich und die Anforderungen im SaaS-Kontext. Die meisten großen Sprachmodelle sind so konzipiert, dass sie maximal eine bestimmte Menge an Textinformationen – den sogenannten Kontext – verarbeiten können. Sobald die Sitzung beendet ist, gehen alle darin „gelernten“ Details verloren. Das bedeutet, dass eine KI beispielsweise bei einem wiederholten Kundengespräch nicht mehr weiß, welche Präferenzen oder individuellen Einstellungen der User zuvor angegeben hat, ohne dass die Entwickler eine eigene Speicherschicht programmieren.

Dies führt zu frustrierenden Nutzererfahrungen und reduziert den Mehrwert, den KI-basierte Anwendungen generieren können. Für Entwickler entsteht die Herausforderung, eine eigene Gedächtnisschicht zu entwerfen und implementieren, die Informationen zuverlässig speichert, angemessen strukturiert, sicher verwaltet und einfach abrufbar macht. Das ist allerdings aufwendig, kostet Zeit und Ressourcen, die in der Regel besser in die Produktentwicklung gesteckt wären. Gerade im Zeitalter von SaaS-Anwendungen, die möglichst schnell und kosteneffizient skalierbar sein sollen, ist die Suche nach flexiblen und zugleich leistungsfähigen Speicherlösungen ein wesentlicher Schritt, um KI-Dienste konkurrenzfähig und benutzerfreundlich zu machen. Plug-and-Play Scoped Memory tritt hier als potenzielle Lösung auf den Plan.

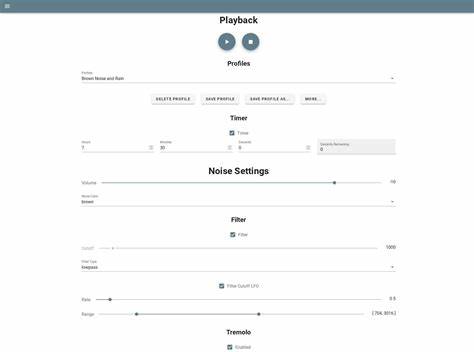

Dabei handelt es sich um eine modulare Gedächtnisschicht, die sich über einfache APIs in eine bestehende Anwendung integrieren lässt, ohne dass Entwickler eine komplexe Backend-Logik oder Datenbankinfrastruktur selbst aufbauen müssen. Der Begriff „scoped“ beschreibt die Fähigkeit, Speicherinhalte gezielt auf Benutzer, Projekte oder individuelle Agenten zu beschränken. So behalten KI-Modelle den für den jeweiligen Anwendungsfall relevanten Kontext und können damit wesentlich intelligentere und persönlichere Antworten liefern. Diese Art von Gedächtnis ist nicht statisch, sondern lebt mit Funktionen wie Time-to-Live (TTL), die den automatischen Ablauf und die Bereinigung von Daten ermöglichen. Zudem bieten solche Dienste oftmals Exportfunktionen an, die einen Plattformwechsel oder ein Back-up der gespeicherten Informationen erleichtern.

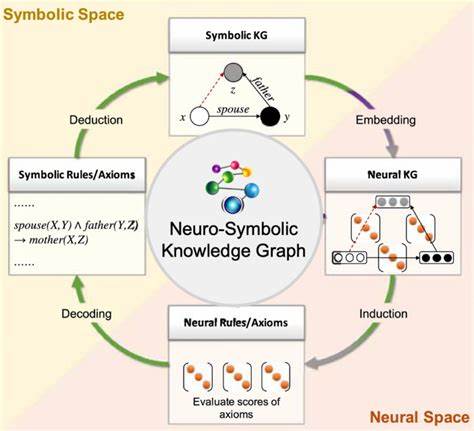

Die Vorteile liegen auf der Hand: Entwickler erhalten eine sofort nutzbare Gedächtnis-Infrastruktur, mit der sie die künstliche Intelligenz nachhaltiger machen und individuellere Benutzererlebnisse kreieren können. Dabei sparen sie Zeit und Ressourcen ein, die für die Implementierung eigener Datenbanken und Erinnerungslogiken notwendig wären. Doch wie sieht die technische Realität hinter Plug-and-Play Scoped Memory aus? Viele aktuelle Ansätze basieren auf Vektor-Datenbanken, die es erlauben, Informationen als numerische Repräsentationen (Embeddings) im Raum zu speichern und durch Ähnlichkeitssuche schnell abzurufen. Diese Technik ist besonders geeignet, um natürliche Sprache semantisch sinnvoll zu speichern. Projekte wie Pinecone oder Faiss sind Beispiele bekannter Vektor-DBs, die von vielen KI-Entwicklern genutzt werden.

Plug-and-Play-Dienste bauen oftmals auf solchen Technologien auf, ergänzen sie jedoch um speziell optimierte Schnittstellen, Speicherautomatisierungen und Scope-bezogene Datenmanagement-Funktionen. Dadurch wird die Nutzung beschleunigt und gleichzeitig die Komplexität verringert. Dennoch gibt es auch kritische Stimmen. Einige Anwender bemängeln mangelnde Transparenz hinsichtlich den genauen Mechanismen und der Performance solcher Dienste. Die Frage, ob sie einfach nur die bestehende Komplexität hinter einer HTTP-API verbergen und dadurch potenziell Latenzen erhöhen, wird häufig gestellt.

Zudem ist der konkrete Nutzen von KI-Gedächtnissen mit Scope in vielen kommerziellen Anwendungen noch nicht endgültig bewiesen, da die Integration solcher Komponenten sich oft noch in einem frühen Stadium befindet. Die Quantifizierung des Mehrwerts ist deshalb schwierig. Ein weiterer kritischer Aspekt betrifft die Sicherheit und den Datenschutz der gespeicherten Informationen. Gerade bei personenbezogenen Daten in intelligenten SaaS-Anwendungen sind klare Richtlinien und Compliance-Anforderungen zu erfüllen. Ein Plug-and-Play Gedächtnis-Service muss daher auch transparent machen, wie und wo die Daten gespeichert werden, wie lange sie verfügbar sind und welche Mechanismen zur Absicherung der Daten eingesetzt werden.

Aus Sicht der Entwickler ist eine solche Speicherlösung besonders dann wertvoll, wenn sie flexibel, skalierbar und gut dokumentiert ist. Die Möglichkeit, das Gedächtnis granular zu steuern – also etwa nur bestimmte Daten für einzelne Agenten oder Nutzer zugänglich zu machen und andere Informationen wieder zu löschen – ist essenziell, um den Nutzen einer KI nachhaltig zu steigern. Gleichzeitig sollte ein solcher Service die Infrastruktur-Last reduzieren und entwirrenden Entwicklungsaufwand deutlich abnehmen. Ebenso ist es gewünscht, dass dieser Speicher nicht an eine bestimmte Plattform oder Wirtschaftlichkeit bindet, um Lock-In-Effekte zu vermeiden. Für die Zukunft lässt sich voraussagen, dass Plug-and-Play Scoped Memory im KI-SaaS-Bereich eine immer wichtigere Rolle spielen wird.

Mit wachsender Verbreitung intelligenter Systeme steigen die Anforderungen an eine effiziente und verlässliche Kontexterkennung innerhalb von Applikationen. Die Fähigkeit, früher erlangtes Wissen dynamisch und kontextspezifisch abzurufen, wird Nutzererfahrungen entscheidend verbessern und neue Anwendungsszenarien ermöglichen. Somit ist die Verknüpfung von KI und nachhaltig gestalteter Speichermöglichkeiten ein zentraler Baustein hin zu tatsächlich intelligenten digitalen Assistenten. Abschließend gilt es zu betonen, dass Plug-and-Play Scoped Memory keine alleinige Wunderwaffe ist, sondern als wertvolles Werkzeug im Werkzeugkasten vieler KI-Entwickler verstanden werden sollte. Ihre Stärke liegt vor allem in der Reduzierung von Entwicklungsaufwand und in der Schaffung flexibler und skalierbarer Gedächtnisschichten.

Ob sich somit der gesamte KI-Markt nachhaltig verändert, hängt von der weiteren Entwicklung der Technologie, der Akzeptanz bei Entwicklern und vom konkreten Einsatz in kommerziellen Projekten ab. Bis dahin bleibt es spannend zu beobachten, wie sich Erinnerung in künstlichen Systemen als Wettbewerbsfaktor etabliert und welche innovativen Lösungen dabei entstehen werden.