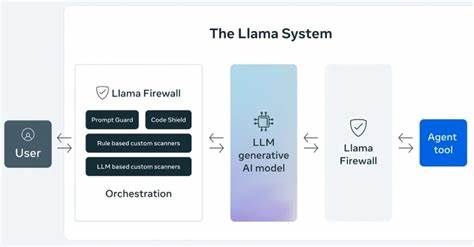

Im digitalen Zeitalter, in dem künstliche Intelligenz (KI) und Large Language Models (LLMs) immer mehr an Bedeutung gewinnen, rücken auch die Sicherheitsherausforderungen verstärkt in den Fokus. Angriffe wie Jailbreaks, Prompt-Injektionen oder das Einspeisen unsicherer Codes stellen eine ernste Bedrohung für den verantwortungsvollen Einsatz von KI-Systemen dar. Meta, als einer der führenden Technologieanbieter weltweit, reagiert auf diese Herausforderungen mit der Einführung des LlamaFirewall Frameworks – einer revolutionären open-source Lösung zum Schutz vor solchen cyberkriminellen Angriffen. Das Framework wurde konzipiert, um Echtzeit-Sicherheitsmaßnahmen entlang der gesamten Interaktionskette von KI-Systemen zu ermöglichen und bietet damit eine neue Dimension der Verteidigung im Bereich der künstlichen Intelligenz. LlamaFirewall beruht auf einer modularen Architektur und umfasst drei Hauptkomponenten, die zusammen eine robuste Schutzbarriere bilden.

Die erste ist PromptGuard 2, eine Technologie, die speziell entwickelt wurde, um direkte Jailbreak- und Prompt-Injektionsversuche in Echtzeit zu erkennen. Sie überwacht eingehende Anfragen und blockiert verdächtige Manipulationen, bevor diese das KI-Modell erreichen können. Die zweite Komponente heißt Agent Alignment Checks. Sie überprüft die Handlungen autonomer KI-Agenten auf mögliche Zielentführungen oder verdeckte Injektionsversuche, die indirekt die Funktionsweise des Systems stören könnten. Auf diese Weise wird sichergestellt, dass die Ausgaben der AI den beabsichtigten Richtlinien und Sicherheitsvorgaben entsprechen.

Die dritte Säule des Frameworks ist CodeShield, ein Online-Analyse-Tool, das statische Code-Analysen durchführt, um die Erstellung unsicheren oder potenziell gefährlichen Codes durch KI-gestützte Agenten frühzeitig zu verhindern. Gerade in einem Umfeld, in dem AI zunehmend zur Codeerstellung und -optimierung verwendet wird, ist eine solche präventive Sicherheitstechnik von enormer Bedeutung. Meta beschreibt LlamaFirewall als „flexibles, Echtzeit-Guardrail-Framework“, das es Sicherheitsteams und Entwicklern ermöglicht, mehrschichtige Schutzmaßnahmen zu implementieren. Dies reicht vom Rohdaten-Input bis hin zu den finalen Ausgaben komplexer autonomer Agenten oder einfacher Chatbots. Durch diesen ganzheitlichen Ansatz sollen Sicherheitslücken frühzeitig erkannt und ausgenutzt werden, bevor sie Schaden anrichten können.

Neben LlamaFirewall hat Meta zudem aktualisierte Versionen zweier weiterer Sicherheitswerkzeuge veröffentlicht. LlamaGuard wurde weiterentwickelt, um verschiedenste Formen von Verstößen gegen Inhaltsrichtlinien besser erkennen zu können. CyberSecEval 4 bietet jetzt eine ausgefeiltere Messung der Verteidigungsfähigkeit von KI-Systemen gegen gängige Angriffe. Besonders bemerkenswert ist der neue Benchmark AutoPatchBench, der in CyberSecEval 4 integriert wurde. Dieses Evaluationsinstrument prüft, wie effektiv AI-Agenten vulnerablen Code automatisch erkennen und beheben können.

Der Fokus liegt dabei auf C/C++-Anwendungen, die mittels Fuzzing auf Schwachstellen untersucht wurden. AutoPatchBench liefert damit eine standardisierte Methodik, um die Fortschritte und Limitationen verschiedener AI-basierter Reparaturmechanismen nachvollziehbar zu machen. Dieser Schritt unterstreicht Metas Engagement, KI nicht nur gegen Angriffe zu schützen, sondern zugleich Werkzeuge zu fördern, die die Sicherheit und Qualität von Software durch automatisierte Reparaturen signifikant steigern. Darüber hinaus hat Meta ein neues Programm namens Llama for Defenders gestartet. Dieses soll Partnerorganisationen und KI-Entwicklern Zugang zu offenen, vorab verfügbaren und geschlossenen KI-Lösungen ermöglichen, die speziell dafür ausgelegt sind, Sicherheitsbedrohungen wie Betrug, Phishing und scam-basierte Attacken zu erkennen.

Das Programm unterstützt somit die proaktive Verteidigung gegen die zunehmende Missbrauchsgefahr durch KI-generierte Inhalte. Das Thema Datenschutz spielt bei Meta ebenfalls eine zentrale Rolle. Parallel zu LlamaFirewall und den weiteren Sicherheitsinitiativen kündigte WhatsApp die Einführung von Private Processing an. Dieses neue Konzept ermöglicht es den Nutzern, KI-Funktionen zu nutzen, ohne dabei Kompromisse bei der Privatsphäre einzugehen. Die Anfragen werden in einem geschützten, vertraulichen Umfeld verarbeitet, was das Risiko von Datenlecks oder unerwünschter Überwachung minimiert.

Meta arbeitet hier eng mit der Sicherheitsgemeinschaft zusammen, um die Architektur kontinuierlich zu überprüfen und zu optimieren. Insgesamt zeigt Meta mit der Vorstellung von LlamaFirewall und den ergänzenden Lösungen, wie wichtig ein ganzheitlicher, kollaborativer Ansatz für die Absicherung von KI-Systemen ist. In einer Zeit, in der KI immer tiefgreifender in kritische Anwendungen integriert wird und zugleich Ziel von immer raffinierteren Angriffen ist, setzen diese Frameworks neue Maßstäbe für sichere, vertrauenswürdige AI-Anwendungen. Für Unternehmen, Entwickler und Sicherheitsexperten eröffnen sich dadurch neue Möglichkeiten, die Potenziale von KI sicherer zu nutzen und Angriffen wirksam vorzubeugen. Zudem stechen die Transparenz durch Open Source und die modulare Bauweise hervor, die es erlauben, individuelle Sicherheitskonzepte umzusetzen und an die jeweiligen Anforderungen anzupassen.