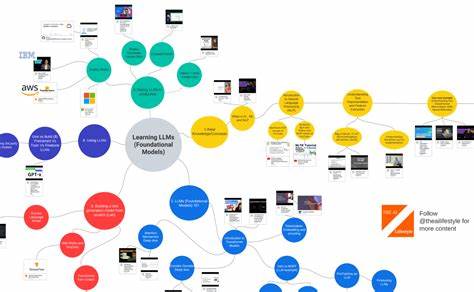

In der heutigen digitalen Ära spielen große Sprachmodelle (Large Language Models, LLMs) eine zentrale Rolle bei der Verarbeitung und Generierung von Sprache. Mit dem rasanten technologischen Fortschritt haben sich diese Modelle von einfachen Textgeneratoren zu komplexen Systemen entwickelt, die nicht nur Worte verstehen, sondern auch komplexe Zusammenhänge logisch erfassen und analysieren können. Diese Entwicklung wird unter dem Begriff Reasoning LLMs zusammengefasst, was die Fähigkeit solcher Modelle beschreibt, über reine Textverarbeitung hinauszugehen und reasoning – also Schlussfolgerungen und logisches Denken – umzusetzen. Reasoning LLMs sind darauf ausgelegt, nicht nur Text zu generieren, sondern auch komplexe Zusammenhänge zu durchdringen, Probleme zu lösen und kohärente Argumentationen aufzubauen. Diese Fähigkeit stellt eine bedeutende Erweiterung bisheriger Sprachmodelle dar, deren Leistungsfähigkeit vor allem in der Verarbeitung großer Datenmengen lag.

Durch den Einsatz spezieller Trainingsmethoden, Architekturen und Daten ist es gelungen, Modelle zu entwickeln, die zunehmend in der Lage sind, auch abstraktes und kritisches Denken zu simulieren. Die Entwicklung von Reasoning LLMs beruht auf der Kombination von tiefen neuronalen Netzen und traditionellen Ansätzen der künstlichen Intelligenz. Während die Modelle zunächst auf umfangreichen Textkorpora trainiert werden, fokussieren sie sich im nächsten Schritt auf Aufgaben, die ein Verständnis von Ursache und Wirkung, Mustererkennung oder logischen Schlussfolgerungen erfordern. So können diese LLMs komplexe Aufgaben bewältigen, die über bloße Textgenerierung hinausgehen, wie zum Beispiel das Lösen mathematischer Probleme, Analyse von Argumenten oder das Treffen von informierten Entscheidungen. Ein zentraler Bestandteil der Reasoning-Fähigkeit von LLMs ist das so genannte „Chain of Thought“-Training.

Hierbei werden Modelle darauf trainiert, ihre Argumentation schrittweise zu entwickeln und offenzulegen, anstatt lediglich auf eine Eingabe eine einzige Antwort zu geben. Diese Technik verbessert nachweislich die Genauigkeit und Nachvollziehbarkeit der Modelle, da sie den Prozess des logischen Denkens quasi transparent macht und Fehlerquellen leichter identifizierbar werden. Damit entwickeln Reasoning LLMs ein tieferes Verständnis für den Kontext und können komplexe Fragestellungen besser bewältigen. Die Anwendungsmöglichkeiten von Reasoning LLMs sind vielfältig und erstrecken sich über zahlreiche Branchen. Im Bildungsbereich bieten sich neue Chancen für personalisierte Lernprogramme und interaktive Tutorensysteme, die nicht nur Antworten liefern, sondern Lernprozesse begleiten und erklären.

In der Medizin ermöglichen diese Modelle etwa die Analyse komplexer Patientendaten, um Diagnosen zu unterstützen oder Behandlungsoptionen zu bewerten. Auch in der Rechtswissenschaft können Reasoning LLMs bei der Interpretation komplexer Gesetzestexte oder der Entwicklung von Argumentationsstrategien behilflich sein. Ein weiteres vielversprechendes Einsatzfeld ist die Forschung und Entwicklung in Unternehmen. Reasoning LLMs helfen dabei, große Datenmengen zu analysieren, relevante Informationen herauszufiltern und strategische Entscheidungen zu unterstützen. Dabei tragen sie dazu bei, Innovationsprozesse zu beschleunigen und die Wettbewerbsfähigkeit zu steigern.

Insbesondere in der automatisierten Kundenbetreuung oder im technischen Support verbessern diese Modelle die Qualität der Antworten und erhöhen die Kundenzufriedenheit durch effiziente Problemlösung. Trotz der vielfältigen Vorteile bringen Reasoning LLMs auch Herausforderungen mit sich. Die Komplexität der Modelle führt zu einem hohen Compute-Bedarf, der Energieaufwand und Kosten verursacht. Darüber hinaus sind die Erklärbarkeit und Transparenz der Entscheidungen weiterhin zentrale Forschungsthemen, um Vertrauen in die Technologie aufzubauen. Ein weiteres Problem liegt in der ethnischen und kulturellen Voreingenommenheit der Trainingsdaten, welche die Neutralität und Fairness der Modelle beeinträchtigen kann.

Hier ist eine bewusste und sorgfältige Auswahl sowie Nachbearbeitung der Daten essentiell. Zukünftige Entwicklungen werden daher verstärkt auf die Verbesserung der Effizienz, Erklärbarkeit und Ethik der Reasoning LLMs ausgerichtet sein. Forschungsansätze beschäftigen sich mit hybriden Modellen, die tiefes neuronales Lernen mit symbolischem Wissen verbinden. Solche multimodalen Ansätze versprechen eine noch präzisere und kontextsensitivere Verarbeitung komplexer logischer Fragestellungen. Gleichzeitig wird die Integration von Domänenwissen maßgeblich dazu beitragen, die Anwendungsspektren dieser Modelle weiter zu erweitern.

Die Bedeutung von Reasoning LLMs für die Gesellschaft und Wirtschaft ist kaum zu überschätzen. Sie verändern grundlegend, wie Wissen verarbeitet wird und schaffen neue Möglichkeiten für die Automatisierung komplexer Denkprozesse. Unternehmen und Institutionen, die frühzeitig auf diese Technologie setzen, können sich einen Wettbewerbsvorteil sichern und innovative Lösungen schneller umsetzen. Gleichzeitig erfordert der verantwortungsvolle Umgang mit dieser Technologie klare ethische Richtlinien und regulatorische Rahmenbedingungen. Zusammenfassend sind Reasoning LLMs ein bedeutender Schritt in der Evolution künstlicher Intelligenz.

Sie erweitern die Fähigkeiten von Sprachmodellen von reiner Textverarbeitung hin zu tiefgreifendem logischem Denken und Problemlösen. Mit den richtigen Voraussetzungen haben sie das Potenzial, viele Lebensbereiche zu revolutionieren und neue Standards in Effizienz und Qualität zu setzen. Die laufende Forschung und Entwicklung sowie der bewusste Umgang mit Chancen und Risiken werden entscheidend sein, um das volle Potenzial dieser Technologie zu entfalten.