Die Debatte um die Nutzung von urheberrechtlich geschützten Inhalten für das Training von Künstlicher Intelligenz (KI) ist so alt wie die Technologie selbst, doch ein kürzlich veröffentlichter Forschungsbericht bringt frischen Wind in diese Diskussion. Forscher führender Universitäten und Institute haben ein KI-Modell trainiert, das komplett ohne Copyright-geschützte Materialien auskommt. Dieses Ergebnis entkräftet die häufig gehörte Behauptung, dass es unmöglich oder zumindest extrem schwierig sei, leistungsstarke KI-Systeme ohne den Einsatz von urheberrechtlich geschütztem Content zu entwickeln. Der Weg dahin ist zwar mit Herausforderungen verbunden, doch die praktische Umsetzbarkeit ist ein bedeutender Meilenstein auf dem Weg zu mehr ethischer Verantwortung in der KI-Entwicklung. Normalerweise beruhen die leistungsfähigsten Sprachmodelle auf gewaltigen Datenmengen, die oft aus dem gesamten Internet gesammelt werden, inklusive Seiten, die urheberrechtlich geschützte Texte, Bilder oder sonstige Medieninhalte enthalten.

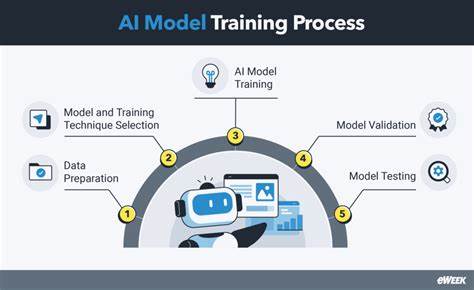

Unternehmen in der KI-Branche argumentieren seit langem, dass diese Daten unverzichtbar seien, um Modelle mit einer hohen Leistungsfähigkeit zu entwickeln. Im Jahr 2024 etwa erklärte OpenAI vor einem britischen Parlamentsausschuss, es sei quasi unmöglich, Modelle wie ihre GPT-Serie ohne urheberrechtlich geschützte Materialien effizient zu trainieren. Auch Anthropic wurde in diesem Zusammenhang zitiert, dass eine verpflichtende Lizenzierung der genutzten Werke das Entstehen moderner KI-Modelle faktisch verhindern würde. Die jüngste Studie von Forschenden aus Institutionen wie dem MIT, Carnegie Mellon University, der University of Toronto und Forschungszentren wie dem Vector Institute und dem Allen Institute for AI zeigt jedoch ein deutlich anderes Bild. Ihr sieben Milliarden Parameter großes Sprachmodell basiert ausschließlich auf Daten, die entweder gemeinfrei sind oder unter offenen Lizenzen stehen.

Die Datenmenge umfasste stolze acht Terabyte, darunter 130.000 Bücher aus der Library of Congress, die alle rechtlich sicher verwendet werden konnten. Das Ergebnis ist beeindruckend: Obwohl das Modell nicht die Top-Leistungsfähigkeit aktueller Spitzenmodelle erreicht, liegt es in der gleichen Größenordnung wie Meta’s Llama 2-7B, ein Modell von 2023. Dieses vergleichbare Leistungsniveau beweist, dass Datenschutz und Lizenzfreiheit kein unüberwindbarer Kompromiss für KI-Leistung sein müssen. Dennoch war die Erstellung dieses ethisch sauberen Datensatzes keine einfache Aufgabe.

Ein enormer Aufwand entfiel auf die Datenaufbereitung, die nicht automatisiert realisiert werden konnte. Häufig war es notwendig, die Daten manuell zu sichten und zu annotieren, da nicht alle Inhalte maschinenlesbar waren. Die rechtliche Prüfung der vorhandenen Lizenzen stellte ein weiteres Hindernis dar. Die beteiligten Forschenden mussten akribisch herausfinden, welche Websites und Werke in welchem Umfang verwendet werden dürfen. Dieser Prozess ist deutlich arbeitsintensiver als das bloße Sammeln großer Datenmengen mit unklaren Lizenzstandards.

Die Bedeutung dieses Projekts liegt nicht nur darin, ein neues, ethisch vertretbares Modell zu präsentieren, sondern auch darin, eine längst überfällige Diskussion über die Rechte der Urheber und die Verantwortung der KI-Entwickler anzustoßen. Immer mehr Stimmen fordern klare Regelungen und Transparenz bei der Verwendung von Trainingsdaten. In Analogie zur Musik- oder Filmindustrie, die seit Jahrzehnten Urheberrechte streng schützt, könnte auch die KI-Branche von einer solchen Regulierung profitieren, um langfristig rechtliche Konflikte zu vermeiden und das Vertrauen der Öffentlichkeit zu stärken. Mit Blick auf die Zukunft stellt sich die Frage, ob solche Modelle, die auf Public-Domain- und offen lizenzierten Materialien basieren, das Potenzial haben, eine entscheidende Rolle in der Professionalisierung und Demokratisierung von KI zu spielen. Während die gegenwärtigen Industriemodelle vor allem das Optimum aus intransparent gesammelten Datensätzen herausholen, könnte die alternative Herangehensweise ein Beispiel für Nachhaltigkeit und ethische Klarheit sein.

Dies kann insbesondere für akademische Einrichtungen und gemeinnützige Organisationen von Bedeutung sein, die nicht denselben kommerziellen Zwängen wie große Konzerne unterliegen. Weiterhin werfen diese Entwicklungen auch Fragen zu den Kosten und dem ökologischen Fußabdruck der KI-Entwicklung auf. Das manuelle Sichten und Prüfen von Daten benötigt Zeit und menschliche Ressourcen – beides sind Faktoren, die sich in höheren Kosten niederschlagen können. Allerdings könnten in Zukunft effizientere Methoden der Datenkennung und -validierung entstehen, die die manuelle Arbeit minimieren. Künstliche Intelligenz könnte sich also selbst als Werkzeug einsetzen, um die Trainingsbasis für nachfolgende Modelle stärker zu kontrollieren und juristisch einwandfrei vorzubereiten.

Auf regulatorischer Ebene deuten die Ergebnisse darauf hin, dass ein Kurswechsel auf der Agenda stehen sollte. Die aktuelle Unsicherheit bezüglich des Einsatzes geschützter Werke wird zunehmend zu einem Problem, das nicht nur einzelne Unternehmen, sondern die gesamte Branche betrifft. Rechtsstreitigkeiten und politische Debatten zeigen, dass der derzeitige Zustand keine Dauerlösung darstellt. Der Nachweis, dass KI auch ohne Copyright-Material robust trainiert werden kann, ist ein Argument für strengere Lizenzregelungen und faire Vergütungsmodelle für Kreative. Zusammenfassend lässt sich sagen, dass die Zukunft der KI nicht zwangsläufig von der Ausbeutung urheberrechtlich geschützter Werke abhängt.

Der innovative Ansatz, ausschließlich auf gemeinfreie und offen lizenzierte Daten zu setzen, erfordert zwar mehr Aufwand und führt derzeit noch zu Modellen mit etwas geringerem Leistungsniveau, zeigt jedoch, dass es Alternativen gibt. Diese Alternativen könnten in der öffentlichen Wahrnehmung und im regulatorischen Umfeld dazu beitragen, dass KI nachhaltiger, nachvollziehbarer und ethisch verantwortlicher entwickelt wird. Letztendlich kann diese Entwicklung sowohl den Schutz von Urhebern stärken als auch das Vertrauen der Nutzer in KI-Systeme verbessern – zwei Faktoren, die für eine langfristige Akzeptanz und sinnvolle Integration der Technologie unerlässlich sind.