Im April 2025 hat Meta eine neue KI-basierte Chatbot-Plattform lanciert, die auf den ersten Blick mit innovativen Funktionen und einem interaktiven Ansatz besticht. Schon kurze Zeit nach der Markteinführung wurde jedoch deutlich, dass die App nicht nur technische Fortschritte zeigt, sondern auch erhebliche Datenschutzrisiken birgt. Die Meta AI App bietet unter anderem eine sogenannte „Discover“-Funktion, die es Nutzern erlaubt, öffentliche Chatverläufe anderer Personen mit dem Chatbot einzusehen. Diese scheinbar offene und soziale Nutzungsmöglichkeit wirft erhebliche Fragen hinsichtlich Privatsphäre, Sicherheitsbewusstsein und regulatorischen Rahmenbedingungen auf – nicht nur in Deutschland, sondern weltweit. Während viele Kommunikationsplattformen darauf ausgelegt sind, vertrauliche Konversationen zu schützen, schafft die Meta AI App mit ihrem Ansatz eine neue Dynamik.

Nutzer, die auf der Plattform in einen Dialog mit dem KI-Chatbot treten, haben die Möglichkeit, ihre Gespräche freiwillig öffentlich zu teilen. Theoretisch soll so ein sozialer Mehrwert entstehen: Inspiration und Ideenfindung etwa beim Planen von Reisen oder beim Teilen von Rezepten. In der Praxis sieht die Lage jedoch ganz anders aus. Neben harmlosen Unterhaltungen tauchen auf dem „Discover“-Feed von Meta immer wieder persönliche Anfragen auf, die medizinische Probleme, rechtliche Belange oder sogar potenziell strafrechtlich relevante Informationen beinhalten – und das unter Angabe von vollständigen Namen, Ortsangaben und teilweise Telefonnummern. Diese Offenlegung sensibler Inhalte ist kritisch, wie Experten aus dem Datenschutz- und Sicherheitsbereich betonen.

Calli Schroeder vom Electronical Privacy Information Center weist darauf hin, dass viele Anwender offenbar nicht vollständig verstehen, was es bedeutet, persönliche Daten in einem KI-System zu teilen. Vielmehr wird fälschlicherweise davon ausgegangen, dass der Austausch mit einem Chatbot privat bleibt. Die Tatsache, dass Menschen Informationen zu ihrer Gesundheit, laufenden Gerichtsverfahren, persönlichen Wohnadressen oder sogar steuerrechtlichen Fragen öffentlich zugänglich machen, zeigt ein grundlegendes Missverständnis der Plattformnutzung und der zugrundeliegenden Technologie. Das Problem ist noch verstärkt dadurch, dass nicht bei allen Benutzern klar ist, welche Inhalte öffentlich sind und welche nicht. Die Plattform arbeitet nach dem Prinzip, dass die Konversationen standardmäßig privat bleiben, sofern der Nutzer nicht ausdrücklich entscheidet, sie in den „Discover“-Feed hochzuladen.

Dennoch zeigt ein Blick auf die veröffentlichten Chats, wie oft Menschen mutmaßlich unbewusst oder aus Unwissenheit private Details preisgeben. Einige Fragen wirken stark persönlich und sind eindeutig nicht für eine breite Öffentlichkeit bestimmt - sie offenbaren so einen signifikanten Mangel an Datenschutzbewusstsein. Meta selbst reagiert auf die Kritik bislang eher zurückhaltend. In einer Stellungnahme eines Unternehmenssprechers hieß es, dass alle Inhalte nur dann öffentlich sichtbar werden, wenn Nutzer durch mehrere Bestätigungsschritte ausdrücklich ihre Zustimmung geben. Offene Fragen bezüglich möglicher Schutzmaßnahmen für Nutzer, die versehentlich oder unwissentlich sensible Daten freigeben, blieben jedoch unbeantwortet.

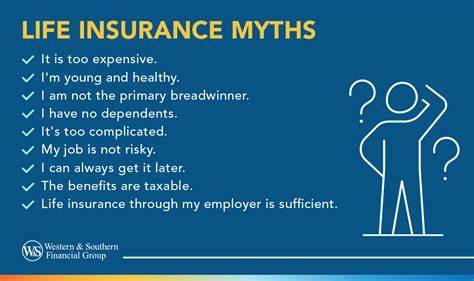

Die Herausforderung besteht darin, dass ein KI-basierter Chatbot zwar hilfreiche Antworten bietet, die Komplexität des Datenschutzes für Menschen aber nicht immer leicht nachvollziehbar bleibt – gerade bei der Integration einer sozialen Komponente, in der Inhalte geteilt werden können. Eine weitere Problematik liegt im Umgang mit der Speicherung und Nutzung der Daten durch Meta selbst. Während die User theoretisch Kontrolle darüber haben sollten, welche Informationen sie mit der App teilen und öffentlich machen, greift die KI auf alles zu, was innerhalb der Meta-Produktwelt veröffentlicht wurde oder mit ihr verknüpft ist. Informationen aus Instagram-Profilen, Likes oder Interaktionen fließen in die Antworten des Chatbots mit ein, was zusätzlich das Risiko birgt, mehr persönliche Details preiszugeben, als dem Nutzer bewusst ist. Diese Art des Umgangs mit Nutzerdaten weckt berechtigte Sorgen, zumal ehemalige und aktuelle Studien zur KI-Sicherheit immer wieder darauf hinweisen, wie schnell Informationen in solchen Systemen von Dritten eingesehen oder gar missbraucht werden können.

Die Besorgnis ist nicht nur auf einzelne Nutzer beschränkt, sondern hat auch größere gesellschaftliche Dimensionen, da sensible Daten in falsche Hände geraten, zu Diskriminierung oder sogar zu Rechtsverletzungen führen können. Der gesellschaftliche Diskurs über den Datenschutz bei KI-Anwendungen wie der Meta AI App zeigt exemplarisch, wie sich technologische Innovationen in einem Spannungsfeld zwischen Fortschritt und ethischer Verantwortung bewegen. Viele Nutzer nehmen die komplexen Implikationen der neuen Technologien nicht ausreichend wahr, was die Bedeutung von Aufklärung und klaren, nutzerfreundlichen Datenschutzrichtlinien erhöht. Ein transparenter Umgang mit den Datennutzungspraktiken und mehr Kontrolle auf Seiten der Nutzer wären elementar, um das Vertrauen in solche innovativen Plattformen zu stärken. Darüber hinaus zeigt das Beispiel der Meta AI App, dass regulatorische Rahmenwerke mit der rasanten Entwicklung von KI-Anwendungen Schritt halten müssen.

Datenschutzbehörden weltweit rufen bereits seit längerer Zeit zu strengeren Vorgaben für KI-Systeme auf, die persönliche Daten verarbeiten oder speichern. Gesetzgeber könnten die Notwendigkeit sehen, klare Regeln für die Offenlegung und den Schutz persönlicher Informationen in Chatbot-Plattformen festzulegen, um Missbrauch vorzubeugen. Aus Nutzerperspektive bedeutet das vor allem, sich der Risiken bewusst zu sein und vorsichtig mit der Preisgabe persönlicher Inhalte umzugehen. Die Erwartung, dass eine KI-Anwendung oder soziale Plattform automatisch für Sicherheit sorgt, ist trügerisch. Individuelle Verantwortung kombiniert mit technischen Schutzmaßnahmen ist der Schlüssel.