Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat die Art und Weise, wie wir mit Maschinen kommunizieren und Informationen verarbeiten, revolutioniert. Dabei eröffnet sich eine Vielzahl von neuen Anwendungsmöglichkeiten, von der automatisierten Textgenerierung bis hin zu komplexen Dialogsystemen. Jedoch bringt die Nutzung dieser Technologien auch Herausforderungen mit sich, insbesondere im Hinblick auf die Zuverlässigkeit und Genauigkeit der generierten Inhalte. Ein zentrales Problem stellt die sogenannte Halluzination von Sprachmodellen dar, bei der das Modell falsche oder irreführende Informationen produziert, ohne dass dies offensichtlich erkennbar ist. Genau hier setzt das Projekt UQLM an, welches sich auf die Unsicherheitsquantifizierung für Sprachmodelle spezialisiert hat und damit einen wichtigen Beitrag zur Verbesserung der Vertrauenswürdigkeit von KI-Systemen leistet.

UQLM ist eine Python-basierte Bibliothek, die zahlreiche innovative Methoden zur Quantifizierung der Unsicherheit in Antworten von LLMs bereitstellt. Die Fähigkeit, Unsicherheiten präzise zu erfassen, ist entscheidend, um potenzielle Fehlerquellen, insbesondere Halluzinationen, frühzeitig zu erkennen und zu minimieren. Das System arbeitet dabei mit verschiedenen Arten von Scorern, die darauf ausgelegt sind, eine Konfidenz als Maß für die Zuverlässigkeit der generierten Antworten anzugeben. Höhere Konfidenzwerte signalisieren eine geringere Wahrscheinlichkeit von Fehlern und Halluzinationen. Diese Ansicht bietet Entwicklern und Forschern ein mächtiges Werkzeug zur Verbesserung der Interaktion mit Sprachmodellen.

Die Kernidee von UQLM beruht auf der Kategorisierung der Bewertungsmethoden in vier Haupttypen, die jeweils unterschiedliche Ansätze und Vorteile mitbringen. Zum einen existieren die sogenannten Black-Box-Scorer, die ausschließlich auf den generierten Antworten basieren, ohne Zugriff auf die internen Funktionsweisen der Modelle zu benötigen. Diese Methode zeichnet sich durch ihre Universaltauglichkeit aus, da sie mit praktisch jedem Sprachmodell kompatibel ist. Die Black-Box-Methoden beurteilen die Konsistenz der Antworten, indem sie mehrere Ausgaben zu demselben Prompt generieren und diese miteinander vergleichen. Unterschiede oder Widersprüche in den Antworten werden als Indikator für Unsicherheit betrachtet.

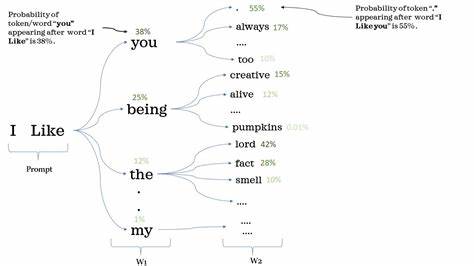

Ein Beispiel hierfür ist der Non-Contradiction Probability Scorer, der die Wahrscheinlichkeit bewertet, dass Antworten sich nicht widersprechen. Im Gegensatz dazu greifen White-Box-Scorer auf interne Informationen der Sprachmodelle zurück, vor allem auf die Wahrscheinlichkeit der einzelnen Tokens, mit denen das Modell seine Antworten zusammensetzt. Diese token-basierte Unsicherheitsmessung bietet eine erheblich schnellere und kostengünstigere Methode, da keine mehrfachen Abfragen an das Modell nötig sind. Allerdings setzt diese Technik voraus, dass der Nutzer Zugang zu solchen probabilistischen Informationen hat, was nicht bei allen Sprachmodellen oder APIs gegeben ist. Die White-Box-Scorer liefern trotzdem wertvolle Einblicke in die Zuverlässigkeit der generierten Inhalte, beispielsweise indem sie die minimale Token-Wahrscheinlichkeit oder die längennormalisierte gemeinsame Token-Wahrscheinlichkeit untersuchen.

Ein weiterer innovativer Ansatz, den UQLM verfolgt, sind die LLM-as-a-Judge-Scorer. Hierbei kommen zusätzliche Sprachmodelle zum Einsatz, um die Antworten des ursprünglichen Sprachmodells zu bewerten. Diese Methode ermöglicht eine flexible, benutzerdefinierbare Bewertung, da verschiedene Richter-Modelle mit speziell angepassten Aufforderungen eingesetzt werden können, um unterschiedliche Aspekte der Antwortqualität zu beurteilen. Die Verwendung mehrerer unabhängiger LLMs als ein sogenanntes Jury-System erhöht die Genauigkeit und Robustheit der Bewertung, indem Schwächen eines einzelnen Modells abgefedert werden. Die Richter-Modelle können entweder kategorisch bewerten, also eine klare Ja-Nein-Entscheidung treffen, oder kontinuierliche Bewertungen abgeben, die feiner abgestufte Unsicherheitsgrade liefern.

Neben den einzelnen Scorern bietet UQLM auch die Möglichkeit, mehrere Methoden zu kombinieren und so sogenannte Ensemble-Scorers zu erstellen, die eine gewichtete Aggregation verschiedener Unsicherheitsmetriken nutzen. Dieses Verfahren erhöht die Verlässlichkeit der Ergebnisse und erlaubt eine Anpassung an spezielle Anwendungsfälle durch Feinabstimmung der Gewichtungen. Insbesondere für komplexe Anwendungen, bei denen unterschiedliche Unsicherheitsaspekte zusammen betrachtet werden müssen, stellt die Ensemble-Methode eine praktische und leistungsfähige Lösung dar. UQLM bietet sowohl fertige Ensembles für den schnellen Einstieg als auch die Möglichkeit zur individuellen Konfiguration und Feinjustierung. Die Installation von UQLM gestaltet sich unkompliziert und erfolgt bequem über den Python-Paketmanager pip.

Die Bibliothek ist offen zugänglich und nach dem Apache-2.0-Lizenzmodell lizenziert, was sowohl professionelle als auch akademische Nutzung fördert. UQLM ist kompatibel mit unterschiedlichen Sprachmodell-Frameworks, darunter auch die populäre LangChain Library, was den nahtlosen Einsatz in bestehenden Entwicklungsumgebungen erleichtert. Zur Veranschaulichung der Anwendung liefert UQLM aussagekräftige, praxisnahe Codebeispiele für jede der wichtigsten Scorer-Gruppen. Der Einsatz ist sowohl für Einsteiger im Bereich der Unsicherheitsquantifizierung als auch für fortgeschrittene Anwender mit speziellen Anforderungen ausgelegt.

Beispielsweise demonstriert die Black-Box-Klasse, wie durch mehrfache Antwortgenerierung und Anwendung von Konsistenzmetriken zuverlässige Konfidenzwerte ermittelt werden können. Analog dazu dokumentieren White-Box- und LLM-Richter-Module ihren praktischen Gebrauch, was eine schnelle Implementierung und Anpassung an individuelle Projekte ermöglicht. Darüber hinaus stellt UQLM umfassendes Begleitmaterial in Form von Demos und Notebooks zur Verfügung, die Anwendungsfälle vom einfachen Halluzinationserkennungs-Workflow bis hin zu komplexen Tuning-Prozessen für Ensemble-Scorer abdecken. Anwender erhalten somit eine fundierte Grundlage, um die Möglichkeiten und Grenzen der verschiedenen Verfahren kennenzulernen und sie sicher in eigene Systemlandschaften zu integrieren. Die Bedeutung der Unsicherheitsquantifizierung in Sprachmodellen wächst stetig mit immer breiteren Einsatzszenarien, insbesondere in kritischen Bereichen wie der Medizin, dem Recht oder bei automatisierter Entscheidungsfindung.

Hier sind Vertrauen und Verlässlichkeit essenziell, und Tools wie UQLM leisten einen entscheidenden Beitrag, diese Kriterien besser zu erfüllen. Die Erforschung und Entwicklung solcher Technologien spiegelt sich auch in wissenschaftlichen Veröffentlichungen wider, die die theoretische Fundierung und experimentelle Evaluation der eingesetzten Metriken dokumentieren. Durch die Verfügbarkeit von UQLM als Open-Source-Projekt bietet sich der Weg, diese Erkenntnisse praxisnah anzuwenden und kontinuierlich zu verbessern. Insgesamt ist UQLM ein wegweisendes Werkzeug für alle, die mit großen Sprachmodellen arbeiten und deren Ergebnisse auf ihre Vertrauenswürdigkeit hin einschätzen möchten. Es kombiniert modernste Forschung mit benutzerfreundlicher Implementierung und unterstützt Entwickler dabei, qualitativ hochwertige, nachvollziehbare und sichere KI-Anwendungen zu realisieren.

Durch die verschiedenen Scorer-Mechanismen und das flexible Ensemble-System bietet UQLM einen umfassenden Ansatz zur Bewältigung der Herausforderungen, die die zunehmende Komplexität von Sprachmodellen mit sich bringt. Zusammenfassend lässt sich sagen, dass die Unsicherheitsquantifizierung mit UQLM nicht nur ein technisches Hilfsmittel, sondern ein unverzichtbarer Baustein für das verantwortungsvolle und nachhaltige Nutzen von künstlicher Intelligenz im Bereich der Sprachverarbeitung ist. Die Möglichkeit, gezielt Halluzinationen zu erkennen und zu mindern, stellt einen wichtigen Schritt hin zu vertrauenswürdigen, transparenten und robusten KI-Systemen dar. Entwickler, Forscher und Anwender können durch Integration von UQLM die Qualität ihrer Systeme verbessern und den Weg in eine KI-Zukunft ebnen, in der Unsicherheiten bewusst gesteuert und interpretiert werden – für mehr Sicherheit, Effizienz und Vertrauen in automatisierte Sprachsysteme.