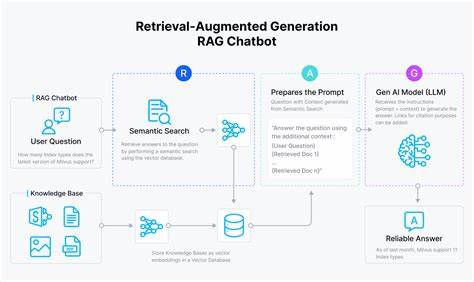

Mit dem rasanten Fortschritt der Künstlichen Intelligenz und der Verbreitung großer Sprachmodelle (LLMs) stehen Entwickler und Unternehmen vor neuen technischen und ethischen Herausforderungen. Besonders im Bereich der Retrieval-Augmented Generation (RAG), bei dem Chatbots Wissensdatenbanken und externe Datenquellen anzapfen, um präzise und kontextsensitive Antworten zu liefern, gewinnt die Frage nach dem sicheren Umgang mit Drittanbieter-Berechtigungen zunehmend an Bedeutung. Die Kernfrage lautet: Wie können diese Systeme die komplexen Zugangskontrollen externer Dienste respektieren, ohne die Performance zu beeinträchtigen oder Datensicherheitsrisiken einzugehen? Eine sensible und effiziente Lösung ist essenziell, um den wachsenden Ansprüchen an Datenschutz, Compliance und Nutzererfahrung gerecht zu werden. Das Problem rührt aus der Tatsache, dass Anwendungen wie Chatbots häufig auf persönliche oder firmeninterne Daten zugreifen – etwa Google Drive, Notion oder Jira – und gleichzeitig gewährleisten müssen, dass sensible Informationen nicht unbefugt offengelegt werden. Die Herausforderung liegt darin, die Berechtigungen dieser Drittanbietersysteme korrekt zu interpretieren und durchzusetzen.

Andernfalls drohen Datenlecks und Vertrauensverluste. Im Kern stehen Entwickler vor drei strategischen Vorgehensweisen: Sie können die Zugriffsrechte zur Laufzeit über APIs der Drittanbieter abfragen, die entsprechenden Zugriffslisten in ihre eigenen Systeme synchronisieren oder die Berechtigungslogik der Fremdsysteme nachbauen und lokal überprüfen. Jede Methodik bringt eigene Vorteile und Einschränkungen mit sich, die in Größe, Komplexität und Sicherheitsanforderungen der Anwendung abgewogen werden müssen. Die erste Möglichkeit, Zugriffsrechte zur Laufzeit mittels Drittanbieter-APIs zu prüfen und Ergebnisse entsprechend zu filtern, ist in ihrer Einfachheit verlockend. Dabei werden zunächst dokumentähnliche Inhalte in einer Vektordatenbank gespeichert und dann bei einer Nutzeranfrage die Zugriffsliste in Echtzeit vom Drittanbieterdienst abgefragt.

So lässt sich theoretisch sicherstellen, dass nur berechtigte Inhalte angezeigt werden. Der Nachteil dieses Ansatzes manifestiert sich allerdings schnell, wenn es um große Datenbestände oder zeitkritische Anwendungen geht. Die Abhängigkeit von der Geschwindigkeit und Ausdruckskraft der fremden APIs führt zu Latenzen die in Szenarien mit tausenden Dokumenten die Nutzererfahrung erheblich beeinträchtigen können. Zudem stellt sich die Frage nach der Verfügbarkeit einer solchen Berechtigungs-API überhaupt. Nicht alle Plattformen bieten eine robuste, zentrale und schnelle Berechtigungsabfrage.

Daraus resultiert, dass diese Methode vor allem für Prototypen oder nicht-performanzkritische Anwendungen geeignet ist. Eine zweite Alternative besteht darin, die Zugangskontrolllisten (ACLs) vollständig in das eigene System zu übernehmen, das in der Regel auch für die semantische Suche zuständig ist. Indem man Rechteinformationen direkt in der Vektordatenbank speichert, lassen sich Berechtigungsprüfungen beim Abruf der Dokumente sehr schnell durchführen, ohne mehrfach auf externe Systeme zugreifen zu müssen. Dadurch lassen sich enorme Performancegewinne erzielen und die Kontrolle über Berechtigungen liegt vollständig in der Hand des jeweiligen Anbieters. Allerdings bringt dieses Vorgehen allein schon wegen des Datenvolumens und der Komplexität der Berechtigungen große Herausforderungen mit sich.

Umfangreiche ACLs von großen Organisationen sind schwer zu verwalten, viele Drittanbieter-APIs geben keine vollständigen oder zentralen Berechtigungsdaten preis, und Gruppenzugehörigkeiten oder verschachtelte Verzeichnisstrukturen erschweren eine zuverlässige Synchronisation. Hinzu kommt, dass ständig Änderungen der Rechte überwacht und synchronisiert werden müssen, was den Wartungsaufwand deutlich erhöht. Die dritte Strategie verfolgt einen deutlich anspruchsvolleren und zugleich zukunftsfähigen Ansatz. Hierbei wird versucht, die Berechtigungslogik der Drittanbieter nachzubilden und in das eigene System zu integrieren. Statt alle Berechtigungsdaten zu importieren, synchronisiert man nur die erforderlichen Metadaten wie Gruppenkonstellationen, Ordnerhierarchien oder Besitzverhältnisse.

Die eigentliche Berechtigungsprüfung erfolgt dann lokal anhand einer präzise definierten und auditierbaren Policy, die idealerweise mit einer bewährten Policy-Sprache wie Oso's Polar formuliert wird. Dieser Ansatz bietet mehrere Vorteile. Durch den selektiven Datenimport wird die Menge der zu synchronisierenden Informationen begrenzt, während die Ausführung der Prüfungen durchweg performant, nachvollziehbar und testbar ist. Allerdings ist die Reverse-Engineering-Arbeit, um die fremde Berechtigungslogik korrekt abzubilden, kein triviales Unterfangen. Die ständige Weiterentwicklung der Drittanbietersysteme verlangt zudem kontinuierliche Pflege der implementierten Policies.

Dadurch entsteht ein gewisser technischer und organisatorischer Mehraufwand, der aber durch die bessere Kontrolle und Skalierbarkeit ausgeglichen wird. Ein wichtiger Aspekt, der in jeder der beschriebenen Herangehensweisen berücksichtigt werden muss, ist die eindeutige und konsistente Identifikation der Nutzer. Drittanbietersysteme verwenden jeweils eigene Nutzerkennungen, Gruppenstrukturen und Zugangsattribute. Ohne ein robustes Identitäts-Mapping lassen sich Berechtigungen niemals korrekt validieren. Somit ist das Identitätsmanagement das Fundament jeder sicheren Berechtigungsarchitektur.

Die Unterscheidung zwischen Authentifizierung und Autorisierung ist theoretisch klar, in der Praxis jedoch eng verknüpft. Werden Nutzer nicht eindeutig verifiziert und korrekt den richtigen Berechtigungen zugeordnet, entstehen Sicherheitslücken am laufenden Band. Letztlich hängt die Wahl der optimalen Architektur stark von der konkreten Anwendung, dem Umfang der Daten, den zu integrierenden Drittanbietersystemen und den Anforderungen an Geschwindigkeit und Sicherheit ab. Ein Universallösung existiert nicht. Entwickler müssen basierend auf ihrem Tech-Stack, der Nutzerzahl, der Datenmenge und den verfügbaren Schnittstellen eine wohlüberlegte Entscheidung treffen.

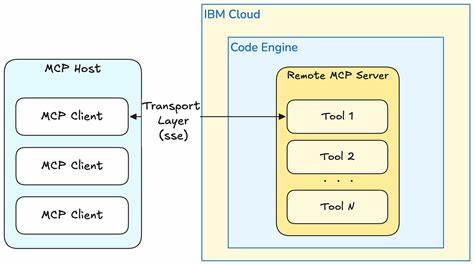

Besonders in Unternehmen mit strengen Datenschutzvorgaben und Compliance-Richtlinien wird eine technisch robuste und auditable Lösung unerlässlich. Gleichwohl zeigt sich, dass die Bewegung hin zu lokalem Policy-Management und selektivem Synchronisieren in der Praxis an Dynamik gewinnt. Parallel wächst die Forderung nach besseren, klar definierten Berechtigungs-APIs seitens der Drittanbieter, um die Integration gängiger und wartbarer zu gestalten. Ein weiterer Blick in die Zukunft offenbart spannende Erweiterungen dieses Themenkomplexes. Plattformen wie Perplexity diskutieren bereits die nächste Evolutionsstufe von RAG-Systemen: Die Verbindung von LLMs mit „Aktionen“.

Hier sollen Sprachmodelle nicht nur lesen und Antworten generieren, sondern eigenständig Aufgaben ausführen – wie Anfragen genehmigen, Rechnungen versenden oder Kalendereinträge löschen. Dieses Szenario verschärft die Anforderungen an Zugangskontrolle, weil neben der reinen Datenfreigabe auch Validierung von Nutzerabsichten notwendig wird. Dadurch verschmilzt Autorisierung eng mit der Intent-Erkennung, was neue Sicherheits- und Usability-Probleme mit sich bringt. Insgesamt ist die Verwaltung von Drittanbieter-Berechtigungen in RAG-Chatbots eine Herausforderung von hoher Komplexität, die Disziplin, technische Kreativität und kontinuierliche Anpassung verlangt. Entwickler müssen ein Gleichgewicht finden zwischen Sicherheit, Performance und Skalierbarkeit.

Nur so lassen sich vertrauenswürdige KI-Anwendungen bauen, die sensible Daten respektieren und den Nutzern zugleich einen reibungslosen und effektiven Service bieten. Die Diskussion um geeignete Architekturen wird weitergehen und von der Entwicklung neuer Standards, APIs und Best Practices geprägt sein. Die Zukunft gehört jenen Systemen, die flexibel, nachvollziehbar und sicher auf die vielfältigen Anforderungen der realen Welt reagieren können. Ein intensiver Austausch der Community und ein gutes Verständnis der zugrundeliegenden technischen sowie organisatorischen Prinzipien sind dabei unerlässlich.