PostgreSQL gilt als eine der zuverlässigsten, robustesten und funktionsreichsten Open-Source-Datenbanken weltweit. Dennoch gehören große Versionsupgrades zu den Aufgaben, die viele Administratoren und Entwickler als besonders mühsam und komplex empfinden. Anders als bei manchen anderen Systemen können Nutzer nicht einfach den Server austauschen und danach mit der neuen Version weiterarbeiten. Ursache dafür ist vor allem die Inkompatibilität der Datenverzeichnisformate zwischen den Hauptversionen, was die Upgrade-Prozesse technisch anspruchsvoll macht. Doch warum ist das so? Warum ist es nicht möglich, die Datenformate zwischen Versionen durchgehend kompatibel zu halten? Antworten auf diese Fragen liegen tief in der Architektur von PostgreSQL begründet und sind eng mit historischen Designentscheidungen verknüpft.

Ein genauer Blick auf die Abläufe und Hintergründe zeigt die Gründe für die Herausforderungen auf und lässt Verständnis für den Upgrade-Prozess wachsen. Der wichtigste Punkt, um das Upgrade-Problem zu verstehen, ist die Unterscheidung zwischen den gespeicherten Daten und der Art und Weise, wie diese Daten in der Datenbank organisiert und beschrieben werden. Die reinen Tabellen- und Indexdaten, die sogenannte Heap-Daten, sind über die Versionen hinweg erstaunlich stabil geblieben. Das bedeutet, dass einzelne Tabellenzeilen und Indexstrukturen grundsätzlich zwischen verschiedenen Hauptversionen kompatibel sind. Dies ist einer der Gründe, warum Tools wie pg_upgrade überhaupt möglich sind.

Pg_upgrade arbeitet mit der Kombination aus dem Kopieren der Datenverzeichnisse und dem Wiederherstellen der Datenbankschemata mittels eines Dumps. Während die Rohdaten also kompatibel sind, finden sich die größten Schwierigkeiten im Bereich der Metadaten – den Systemkatalogen. PostgreSQL speichert alle Informationen über die Struktur der Datenbank, also über Tabellen, Spalten, Indizes, Rechte und viele weitere systemrelevante Details, in sogenannten Systemkatalogen. Diese Kataloge selbst sind ganz normale Tabellen, aber ihre Struktur und ihr Aufbau sind fest in den PostgreSQL-Servercode eingebettet. Um die Datenbank effizient starten zu können, verlässt sich das System auf fest kodierte Offset-Werte und fixe Layouts, um bestimmte Informationen schnell zu finden.

Beispielsweise könnte der Name einer Spalte an einer bestimmten Byteposition im pg_attribute-Katalog stehen. Dieses 'Hardcoding' ist notwendig, weil der Server diesen Metadaten nicht auf herkömmliche Weise bei jedem Start abfragen kann – die Daten müssen beim Initialisieren des Systems unmittelbar verfügbar sein. Wenn nun eine neue Postgres-Hauptversion herauskommt und neue Features implementiert werden, müssen häufig zusätzliche Informationen in den Systemkatalogen abgespeichert werden. So kann es passieren, dass neue Felder in vorhandene Katalogtabellen eingefügt werden müssen. Ein aktuelles Beispiel ist die Einführung eines neuen Failover-Flags für Subscriptions in Version 17.

Weil das System für bestimmte Tabellen eine festgelegte, harte Struktur hat, bedeutet das Einfügen eines neuen Feldes eine Änderung der Layouts, die sich auf die Positionen und Größen der vorhandenen Spalten auswirken. Man kann nicht einfach neue Felder ans Ende der Tabelle hängen, da einige Abhängigkeiten und Optimierungen das verhindern. Die Konsequenz daraus ist, dass viele Teile des PostgreSQL-Codes, die mit den Systemkatalogen arbeiten, an die jeweilige Version angepasst sein müssen. Hieraus ergibt sich eine komplexe Wartungsaufgabe, denn es existieren hunderte, wenn nicht tausende Stellen im Quellcode, die diese katalogbezogenen Strukturen direkt referenzieren. Die Implementierung und Pflege von bedingtem Code für unterschiedliche Kataloglayouts aus früheren Versionen würde eine enorme und lang andauernde Entwicklungsarbeit erfordern.

Dies macht es für die Core-Entwickler schwierig, einen durchgehenden Abwärtskompatibilitätsmodus für die Systemkataloge einzuführen. Ein weiteres Problem ist, dass Änderungen am Datenlayouts der Systemkataloge auch eine Migration der Kataloginhalte selbst erfordern. Nach einem Upgrade auf eine neue Version müssten alle Systemkatalogeinträge umgewandelt werden, um die neuen Strukturen zu reflektieren. Ohne ein solches Upgrade wären neue Funktionen, die auf den neuen Feldern basieren, nicht einsetzbar. Das Fehlen automatischer oder gut integrierter Werkzeuge zur Aktualisierung und Verwaltung dieser Metadaten führt dazu, dass Major-Version-Upgrades keine einfache Plug-and-Play-Sache sind.

In einem idealeren Design wären die Metadatenstrukturen so konzipiert, dass sie sowohl Kompatibilität als auch einfache Anpassbarkeit erlauben. PostgreSQLs Ansatz, Systemkataloge als reguläre Tabellen zu behandeln, ist historisch vom Berkeley Postgres-Projekt inspiriert. Dies bringt viele Vorteile mit sich, insbesondere ermöglicht es die Umsetzung von transaktionalem Data Definition Language (DDL), also das sichere und konsistente Ändern der Datenbankschemata innerhalb von Transaktionen. Allerdings ist diese Flexibilität auf Kosten der Upgrade-Kompatibilität erkauft: Die Notwendigkeit, das interne Katalogformat streng zu kontrollieren und zu hardcoden, macht größere strukturelle Änderungen schwer umsetzbar. Neben der Komplexität mit den Systemkatalogen gibt es auch weitere, wenn auch weniger bedeutende, technische Hürden bei Hauptversion-Upgrades.

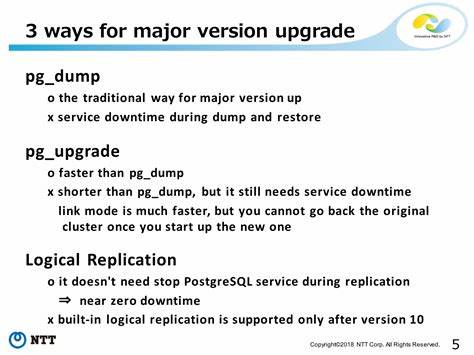

Zum Beispiel ist das interne Serialisierungsformat für einige gespeicherte Ausdrücke, wie zum Beispiel gespeicherte Views oder Default-Werte, nicht unveränderlich kompatibel über Versionen hinweg. Dies hat sich bislang nicht als großes Problem herausgestellt, weil bei einem Major-Upgrade oft ein Daten-Dump und Restore erfolgt, wodurch diese Formate quasi neu generiert werden. Ebenso ist das Write-Ahead-Log (WAL)-Format zwischen Hauptversionen nicht kompatibel, was aber keinen direkten Einfluss auf die Upgrade-Methoden hat, da diese normalerweise die WAL nicht mitnehmen. Die gängigen Methoden zum Upgrade von PostgreSQL auf eine neue Hauptversion lassen sich grob in drei Konzepte unterteilen. Zunächst gibt es das klassische pg_dump/pg_restore-Verfahren, bei dem die gesamte Datenbankstruktur und -inhalte in ein hoch konvertierbares, textbasiertes Format exportiert und anschließend in eine neue Datenbankversion eingespielt werden.

Dieser Prozess ist sehr robust, wird von allen PostgreSQL-Versionen unterstützt, aber er ist zeitintensiv und bei sehr großen Datenbanken oft unpraktisch. Alternativ gibt es das Werkzeug pg_upgrade, das das Schema mittels eines Dump-Rebuilds behandelt, aber die eigentlichen Datenfiles direkt kopiert. Dies nutzt aus, dass die Speicherung der Daten in den Dateien über Hauptversionen hinweg meist kompatibel bleibt. pg_upgrade spart dadurch eine Menge Zeit und Aufwand, allerdings setzt es voraus, dass die Quell- und Zielsysteme sehr ähnlich konfiguriert sind und die Dateiformate kompatibel bleiben. Gleichzeitig muss das Datenbankschema durch eine Dump/Restore-Prozedur angepasst werden, was wiederum bei großen Umgebungen aufwändig sein kann.

Ein dritter Weg besteht darin, logische Replikation zu verwenden, um Daten Stück für Stück von einem Altsystem in ein Neusystem zu übertragen. Dieses Verfahren ist flexibel und erlaubt einen fließenden Übergang, eignet sich besonders für hochverfügbare Systeme oder komplexe Umgebungen. Allerdings ist auch hier ein gewisser Aufwand für die initiale Einrichtung und Überwachung notwendig. In der Summe stehen Administratoren und Entwickler bei großen PostgreSQL-Upgrades vor der Herausforderung, eine Balance zwischen technischer Machbarkeit, Ausfallzeit, Risiko und Aufwand zu finden. Die tief verwurzelten Architekturentscheidungen, insbesondere die starre Katalogstruktur, verhindern einfache und nahtlose Upgrades.

Gleichzeitig sichern diese Konzepte die Integrität, Konsistenz und Erweiterbarkeit von PostgreSQL als Datenbank ab. Langfristig könnten neue Ideen und technische Konzepte dazu beitragen, die Problemfelder zu entschärfen. Beispielsweise wären ein modulareres Systemkatalog-Design mit Versionierungsschichten denkbar, das die Aufrechterhaltung älterer Strukturen nebeneinander mit neuen Feldern erlaubt, ohne massiven Wartungsaufwand im Quellcode zu provozieren. Aber eine solch grundlegende Umgestaltung ist ein langwieriger Prozess, der tiefgreifende Änderungen am PostgreSQL-Kern erfordern würde. Bis es soweit ist, ist die beste Praxis, sich auf die vorhandenen Upgrade-Verfahren zu verlassen, sorgfältig zu planen und insbesondere große Updates ausgiebig vorab auf Testsystemen zu prüfen.

Zudem hilft es, immer gut dokumentierte Konzepte und Skripte für das Upgrade zu pflegen, um die Prozesssicherheit zu erhöhen. Die PostgreSQL-Community bietet umfangreiche Dokumentationen und Hilfestellungen zu den Upgrade-Möglichkeiten und bekannten Fallstricken. Zusammenfassend lässt sich sagen, dass die Komplexität von großen Versionsupgrades bei PostgreSQL vor allem in den Systemkatalogen begründet ist. Deren fest verdrahtete Speicherformate und der damit verbundene Wartungsaufwand verhindern eine einfache Abwärtskompatibilität. Gleichzeitig bieten diese architektonischen Entscheidungen erhebliche Vorteile bei der Handhabung von Schemas und ermöglichen leistungsfähige Funktionen wie transaktionales DDL.

Die Herausforderung für die Zukunft liegt darin, diesen Spagat zwischen Flexibilität, Erweiterbarkeit und Upgrade-Freundlichkeit noch besser zu meistern. Für Anwender bedeutet dies vor allem, sich der Herausforderungen bewusst zu sein, die verflochtenen Systemkomponenten zu verstehen und die existierenden Tools und Abläufe bestmöglich zu nutzen, um ihre PostgreSQL-Systeme sicher und effizient auf den neuesten Stand zu bringen.