Die Orthogonalisierung von Matrizen stellt eine fundamentale Aufgabe in vielen Bereichen der Mathematik, Physik und Informatik dar. Eine effiziente Methode zur Herstellung orthonormaler Strukturen innerhalb von Matrizen bildet die Basis zahlreicher Anwendungen, von der Bildverarbeitung bis hin zur Optimierung in neuronalen Netzen. Der Newton-Schulz Iterationsalgorithmus bietet eine leistungsfähige und zugleich elegante Möglichkeit, Matrizen iterativ zu orthogonalisieren und wird zunehmend als Werkzeug in der modernen numerischen Analyse eingesetzt. Bei der Orthogonalisierung geht es darum, eine gegebene Matrix so zu transformieren, dass ihre Zeilen oder Spalten orthonormal sind. Klassische Verfahren wie Gram-Schmidt-Algorithmen orientieren sich dabei an sequentieller Orthogonalisierung einzelner Vektoren, was insbesondere bei großen Matrizen und in hochdimensionalen Anwendungen zu Einschränkungen führen kann.

Im Gegensatz dazu verfolgt der Newton-Schulz Algorithmus einen symmetrischen Ansatz, der keine spezielle Rolle für einzelne Vektoren innerhalb der Matrix vorsieht. Das Grundprinzip des Newton-Schulz Verfahrens basiert auf der Approximation der Funktion, die eine Matrix auf ihre orthogonale Komponente abbildet. Formal gesprochen wird eine Matrix M mit der Singulärwertzerlegung M=UΣVᵀ auf die Matrix UVᵀ abgebildet. Dabei erhalten alle singulären Werte den Wert eins, außer jene, die bereits null sind. Diese Operation wird als symmetrische Orthogonalisierung bezeichnet, da weder die Zeilen noch die Spalten der Ausgangsmatrix bevorzugt behandelt werden.

Ein zentraler Aspekt des Algorithmus sind sogenannte ungerade Polynomiterationsverfahren. Diese bestehen aus Matrixpolynomen ungerader Ordnung, die so konstruiert sind, dass sie direkt auf die Singulärwerte der Matrix angewandt werden können. Durch Anwendung eines ungeraden Polynoms p auf eine Matrix X resultiert eine Operation, welche in der Form p(X) = aX + bX Xᵀ X + c (X Xᵀ)² X + ...

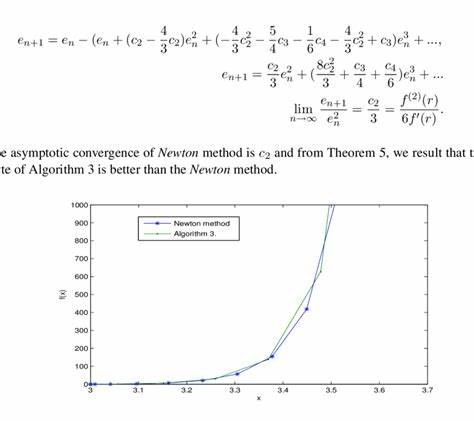

dargestellt wird. Üblicherweise lassen sich derartige Polynome auf die Diagonalelemente der Singulärwertmatrix Σ übertragen, was den Prozess der Orthogonalisierung erheblich vereinfacht und beschleunigt. Die erste Variante des Newton-Schulz Algorithmus verwendet ein kubisches Polynom f(x) = (3/2)x - (1/2)x³. Dass dieses Polynom bei ausreichend vielen Iterationen die Signumfunktion approximiert, lässt sich durch eine Analyse der iterierten Abbildung zeigen. Die Signumfunktion spielt in diesem Kontext eine wichtige Rolle, da sie Betrachtungen für singuläre Werte unterstreicht, die auf +1 oder -1 abgebildet werden, und somit die Normierung gewährleisten.

Damit der Algorithmus zuverlässig funktioniert, müssen alle Singulärwerte der Ausgangsmatrix in einem bestimmten Intervall liegen. Dies wird durch eine Vorverarbeitung der Matrix, etwa durch eine Normierung mittels Frobenius-Norm, sichergestellt. Praktisch bedeutet dies, dass die Matrix vor der Anwendung des Newton-Schulz Iterationsschritts normiert wird, um Stabilität und Konvergenz zu garantieren. Neben dem kubischen Polynom gibt es auch höhergradige Varianten wie die quintische Iteration mit f(x) = 3x - 16.5 x³ + 6.

5 x⁵. Diese Variante hat die Fähigkeit, schneller gegen die Signumfunktion zu konvergieren, zeigt jedoch in der Nähe des Ursprungs oszillierende Verhaltensweisen. Diese Oszillationen stellen eine Herausforderung dar, welche bei der Auswahl der Polynomkoeffizienten besondere Aufmerksamkeit erfordert. Ein bemerkenswerter und ungewöhnlicher Fall ist der sogenannte "verfluchte" quintische Iterationsschritt, der im Rahmen des Muon-Optimierers für neuronale Netze entwickelt wurde. Das Besondere an diesem Algorithmus ist, dass er bewusst auf die Konvergenz verzichtet, um stattdessen eine schnellere Verzerrung kleiner Singulärwerte zu erreichen.

Dies wird durch die Modifikation der Polynomkoeffizienten erreicht, wobei beispielsweise f(x) = 3.4445 x - 4.7750 x³ + 2.0315 x⁵ zum Einsatz kommt. Trotz offensichtlicher Oszillationen und fehlender Konvergenz erweist sich dieses Verfahren in bestimmten Trainingsszenarien als wirkungsvoll, insbesondere wenn Geschwindigkeit höher gewichtet wird als Genauigkeit.

Eine weitere innovative Erweiterung der Newton-Schulz Iteration wurde durch den Forscher You Jiacheng eingeführt. Seine Methode verzichtet darauf, für jede Iteration dasselbe Polynom zu verwenden, und setzt stattdessen eine Abfolge verschiedener Quintikpolynome ein. Dieses Vorgehen erhöht den Freiheitsgrad bei der Anpassung des Iterationsprozesses erheblich und führt zu einer verbesserten Stabilität und Genauigkeit, wodurch die Oszillationen effektiv geglättet werden. Die Implementierung erfolgt häufig unter Verwendung effizienter numerischer Bibliotheken wie JAX in Python, wodurch die Methode für praktische Anwendungen gut zugänglich ist. Die Flexibilität bei der Entwicklung eigener Iterationspolynome bietet dabei die Möglichkeit, auf spezifische Anforderungen einzugehen.

Wichtige Überlegungen dabei sind die Wahl des Polynomgrades, die Sicherstellung der Konvergenzbedingungen sowie die Option, verschiedene Polynomkoeffizienten in unterschiedlichen Iterationsschritten zu verwenden. Die Gestaltung der Koeffizienten kann hierbei spielerisch mit Tools wie Desmos erfolgen, um das Verhalten der Iteration anschaulich zu visualisieren und zu optimieren. Historisch gesehen lässt sich die Newton-Schulz Iteration bis in die 1970er Jahre zurückverfolgen. Die Arbeiten von Kovarik und Björck & Bowie legen den Grundstein für diese Themengebiete. Die Methode wurde zunächst zur Verbesserung der Orthonormalität und zur Schätzung orthogonaler Matrizen verwendet.

Später fand sie Anwendung in atomaren und molekularen Orbitalberechnungen, speziell durch Per-Olov Löwdin, sowie in Optimierungsalgorithmen wie dem Frank-Wolfe-Verfahren für spektrale Normbälle. In jüngerer Zeit hat sich der Newton-Schulz Algorithmus als wertvolles Werkzeug im Bereich des maschinellen Lernens etabliert. Zum Beispiel im Kontext von Gewichtsorthogonalisierung bei neuronalen Netzwerken tragen solche iterativen Verfahren zur Stabilität beim Training und zur Kontrolle von Netzwerkeigenschaften bei. Darüber hinaus sind Verbindungen zu anderen Optimierungsalgorithmen ersichtlich, etwa in Preconditioned Spectral Descent oder in der Anpassung von Lipschitz-Funktionen. Zusammenfassend stellt der Newton-Schulz Iterationsalgorithmus eine vielseitige Methode zur effizienten Orthogonalisierung von Matrizen dar.

Die Nutzung von odd-polynomial basierten Iterationen, die Möglichkeit zur Anpassung der Polynomkoeffizienten und die historische Verwurzelung in numerischer Mathematik machen ihn zu einem bedeutenden Instrument in aktuellen Forschungs- und Anwendungsgebieten. Die Kombination aus mathematischer Eleganz und praktischer Leistungsfähigkeit sorgt dafür, dass diese Methode auch in Zukunft eine zentrale Rolle in der numerischen Analyse und in modernen Optimierungsverfahren spielen wird.