Die zunehmende Digitalisierung und der Einsatz von künstlicher Intelligenz (KI) gewinnen weltweit immer mehr an Bedeutung – auch in staatlichen Institutionen. Besonders die US-Regierung unter der Trump-Administration setzte verstärkt auf technologische Lösungen, um Verwaltungen zu optimieren und Kosten zu senken. Ein bemerkenswertes Beispiel dafür ist das sogenannte „Munchable“-Tool, entwickelt von DOGE, einer Abteilung des Department of Government Efficiency (DOGE), das im Jahr 2025 Schlagzeilen machte. Dieses KI-basierte System sollte dabei helfen, ineffiziente oder angeblich überflüssige Verträge beim Department of Veterans Affairs (VA), der Behörde für Veteranenangelegenheiten, zu identifizieren und zu kürzen. Doch der Einsatz des Tools offenbarte erhebliche Fehler und brachte zahlreiche Probleme ans Licht, die einen verantwortungsvollen Umgang mit KI in der Verwaltung in Frage stellen.

Die Ursprünge des „Munchable“-Tools liegen in der Forderung der Trump-Regierung, innerhalb von nur 30 Tagen eine umfassende Überprüfung von über 90.000 VA-Verträgen durchzuführen. Angesichts der enormen Menge an Verträgen und der knappen Frist schien der Einsatz von KI als schnelle Lösung verlockend. Ein Softwareingenieur namens Sahil Lavingia, der zuvor vor allem als Unternehmer bekannt war und keine spezifische Erfahrung im Gesundheits- oder Regierungssektor besitzt, wurde beauftragt, das Programm zu entwickeln. Innerhalb von nur zwei Tagen entstand somit die erste Version des Tools, das speziell darauf programmiert war, Verträge zu klassifizieren und solche als „munchable“, also kürzbar oder streichbar, zu kennzeichnen.

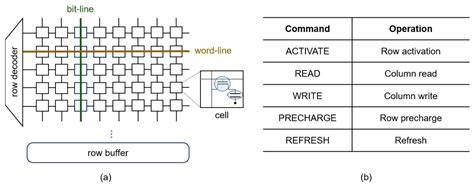

Die Grundlage für die Bewertung lag in der Analyse von jeweils rund 2.500 Wörtern aus den ersten Seiten eines Vertrags. Jedoch entsprachen diese Textabschnitte eher einer groben Zusammenfassung und enthielten kaum detaillierte Informationen über die tatsächliche Bedeutung und Nutzung der Vertragsinhalte. Das Tool nutzte veraltete und kostengünstige KI-Modelle, die nicht für die komplexe Aufgabe qualifiziert waren. Dies führte schnell zu Fehlinterpretationen, etwa bei der Feststellung von Vertragswerten.

Es kam vor, dass das System niedrig bewertete Verträge fälschlicherweise auf Summen von bis zu 34 Millionen US-Dollar schätzte, obwohl manche tatsächlich nur Werte von 35.000 Dollar hatten. Auch essenzielle Verträge, die für die direkt Versorgung von Veteranen essenziell sind, wurden teilweise als streichbar eingestuft. Eines der größten Probleme lag in der simplifizierenden Prämisse, die dem Algorithmus vorgegeben wurde: Verträge würden danach beurteilt, ob sie direkte Patientenversorgung gewährleisten (nicht kürzbar) oder ob sie mehrere Stufen von der Versorgung entfernt sind (kürzbar). Ebenfalls als „munchable“ galten unter anderem Verträge, die Diversity- beziehungsweise Gleichstellungsprogramme unterstützen–Maßnahmen, die vielfach als integraler Bestandteil moderner Institutionen betrachtet werden.

Die Problematik dieser Herangehensweise zeigte sich schnell. Unterstützende Dienste, beispielsweise die Wartung hochspezialisierter medizinischer Geräte, Laboranalysen oder die Bereitstellung von Werkzeugen für die Pflegequalität, wurden falsch eingeschätzt und gekürzt. Dabei wurde deutlich, dass die VA auf ein funktionierendes Netzwerk von Drittanbietern angewiesen ist, dessen Leistung nicht allein durch Klinikpersonal ersetzt werden kann. Zugleich kritisierten Experten, dass die Automation hier an professionelle menschliche Expertise nicht herankommt. Professor Cary Coglianese von der University of Pennsylvania, Experte für den behördlichen Einsatz von KI, zweifelte vor allem das Nutzenpotenzial von allgemein gehaltenen großen Sprachmodellen für derart komplexe und sensible Aufgaben an.

Darüber hinaus war der Prozess hinsichtlich der Transparenz denkbar mangelhaft. VA-Mitarbeiter berichteten davon, dass Entscheidungen über Vertragsstreichungen häufig ohne ausreichende Mitwirkung und mit stark eingeschränkter Zeit zur Rechtfertigung fielen. Manche Mitarbeiter hatten nur wenige Stunden, um darzulegen, warum ein Vertrag nicht gestrichen werden sollte. Zudem war für viele unklar, wer am Ende die endgültige Entscheidung traf, da der gesamte Vorgang hinter einer Black Box verborgen blieb. Die Öffnung des Quellcodes des „Munchable“-Tools durch Lavingia auf der Plattform GitHub sollte mehr Transparenz schaffen und anderen ermöglichen, die Arbeit des VA besser nachzuvollziehen und zu verbessern.

Zwar stimmte man bei DOGE und Elon Musk, der zu dieser Zeit die Abteilung leitete, dem Vorgehen zu, doch der Schritt sorgte intern für Kontroversen. Lavingia wurde Berichten zufolge nach einem Interview über seine Arbeit entlassen. VA-Sprecher verteidigten die KI-gestützte Überprüfung als einen neuartigen, sinnvollen Ansatz, der in jedem Fall durch mehrere menschliche Entscheidungsebenen ergänzt werde. Gleichzeitig räumten sie ein, dass Verträge, die wichtige Dienstleistungen für Veteranen beinhalten oder gesetzlich bindend sind, nicht ohne Weiteres gekürzt würden. Dennoch kritisierten viele, dass die Zustände an der Basis, etwa die Kürzungen kleineren Umfangs, bereits spürbare negative Auswirkungen auf die Versorgung für Veteranen haben könnten.

Auch bleibt ungeklärt, wie der von Lavingias Tool vorgeschlagene Plan, viele Services intern durch festangestellte Mitarbeiter zu ersetzen, mit den gleichzeitigen Personalabbauten bei der VA in Einklang gebracht werden soll. Gleichzeitig stellt der Fall des „Munchable“-Tools eine warnende Beispielhaftigkeit dar, wie riskant der unreflektierte Einsatz von KI im öffentlichen Dienst sein kann. Der Fall ruft wichtige Fragen nach ethischen Standards, fachlicher Kompetenz bei der Entwicklung von Algorithmen sowie einer notwendigen menschlichen Kontrolle auf. Während KI für einfache Prozesse geeignete Automatisierungen ermöglicht, so sprechen hier Komplexität, Tragweite und soziale Bedeutung der Entscheidungen gegen eine alleinige Abhängigkeit von automatisierten Systemen. Der Einsatz solcher KI-Anwendungen sollte folglich stets begleitet werden von Transparenz, klaren Verantwortlichkeiten und der Einbindung fachkundiger Experten.

![What Type of [] Are You?](/images/44B43147-26B4-48A8-8753-DCCDD0585B39)