Der technologische Fortschritt im Bereich autonomer Systeme hat mit der erfolgreichen Entwicklung eines KI-gesteuerten Drohnensystems namens Swift einen beachtlichen Meilenstein erreicht. Swift demonstriert, dass autonome Flugroboter nicht nur mit menschlichen Spitzensportlern mithalten, sondern in manchen Situationen sogar deren Leistungen übertreffen können. Das System basiert auf der Kombination von Deep Reinforcement Learning (deep RL) mit realweltlichen Daten und Sensorinformationen, was eine neue Ära für den mobilen Robotikbereich und den Einsatz künstlicher Intelligenz in physischen Wettbewerben einläutet. First-Person-View (FPV) Drohnenrennsport ist eine Disziplin, die hohe Geschicklichkeit und schnelles Reaktionsvermögen verlangt. Dabei steuern menschliche Piloten Quadrotor-Drohnen durch komplexe dreidimensionale Hindernisparcours, indem sie die Perspektive der Onboard-Kamera in Echtzeit über eine Headset-Brille verfolgen.

Die Geschwindigkeit, die während solcher Rennen erzielt wird, übersteigt oftmals 100 km/h, gekoppelt mit extremen Beschleunigungen und dynamischen Flugmanövern in beengten Umgebungen. Das erfordert von den Piloten nicht nur eine exzellente Hand-Auge-Koordination, sondern auch die Fähigkeit, Flugzustand und Position der Drohne präzise und schnell einzuschätzen. Die Herausforderung lag bislang darin, KI-gesteuerte Drohnen auf ein Niveau zu bringen, das mit erfahrenen menschlichen Piloten vergleichbar ist. Dies scheiterte lange an der Komplexität der Flugdynamik, unvollständigen und verrauschten Sensordaten sowie der Schwierigkeit, ein exaktes Umgebungsmodell zu erhalten. Zahlreiche frühere Ansätze profitierten daher von externen Motion-Capture-Systemen, die die Position und Bewegung der Drohne äußerst genau registrierten – ein Hilfsmittel, das menschlichen Piloten fehlt und somit einen unfairen Wettbewerbsvorteil darstellt.

Swift hingegen zeigt in realen Kopf-an-Kopf-Rennen gegen drei menschliche Weltmeister, dass eine Drohne lediglich durch onboard gemessene Daten und fortgeschrittene Algorithmen auf Weltmeisterniveau fliegen kann. Die Forscher haben eine innovative Architektur entwickelt, die in zwei Hauptmodule unterteilt ist. Das erste Modul ist das Wahrnehmungssystem, das visuelle und inertiale Sensordaten in eine aussagekräftige, niedrigdimensionale Zustandsrepräsentation überführt. Es integriert Visual-Inertial Odometry (VIO), das mittels Kamera- und Beschleunigungssensorinformationen die Position und Orientierung der Drohne zuverlässig schätzt. Zusätzlich erkennt ein neuronales Netzwerk die Ecken der Rennstreckentore, wodurch eine präzisere Lokalisierung durch Fusion von VIO und Karteninformationen erfolgt.

Das zweite Element ist die Steuerungsstrategie, umgesetzt als ein Feedforward-Neuronales Netz, das die aufbereiteten Beobachtungen in Steuerbefehle übersetzt. Diese Steuerkommandos umfassen die kollektive Schubkraft sowie die Körperwinkelgeschwindigkeiten, identisch zu jenen, die von menschlichen Piloten verwendet werden. Das Besondere ist, dass das Netz in einer hochrealistischen Simulation trainiert wurde, die auf empirischen Daten beruht und kontinuierlich verbessert wurde, indem reale Flugdaten zur Simulationserweiterung genutzt wurden. Diese Kombination aus simuliertem Deep Reinforcement Learning und realweltlichen Daten ermöglichte den nahtlosen Transfer der Steuerungsstrategie von der virtuellen Welt in die Realität. Durch sogenannte residuale Modellierung von Wahrnehmungs- und Dynamikfehlern, verstanden als Differenzen zwischen simuliertem und realem Verhalten, konnte die Steuerungspolitik an physische Besonderheiten angepasst werden.

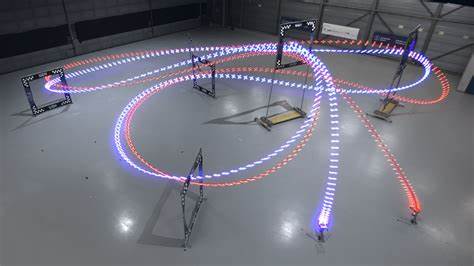

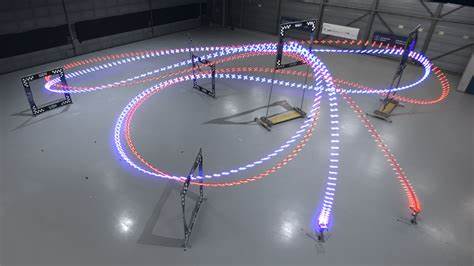

Die Residualmodelle basieren auf Gaussian Processes und k-nearest neighbour Regression, die Stochastizität und Determinismus der jeweiligen Fehler abbilden. Die Rennstrecke selbst besteht aus sieben quadratischen Toren, die in einem begrenzten Raum von 30 mal 30 mal 8 Metern verteilt sind. Um zu gewinnen, gilt es, drei volle Runden in Folge schneller zu absolvieren als der Gegner. Die physischen Drohnen, die von Swift verwendet wurden, sind baugleich mit den von menschlichen Piloten gesteuerten Fahrzeugen, einschließlich Gewicht, Form und Antrieb. So wird gewährleistet, dass Leistungsvorteile nicht durch Hardwareunterschiede verursacht werden.

Die Ergebnisse der Rennen sind beeindruckend. Swift besiegte in mehreren Duellen alle drei menschlichen Weltmeister und konnte die schnellste bisher aufgezeichnete Rundenzeit aufstellen. Mithilfe detaillierter Analyse zeigte sich, dass Swift vor allem bei Starts und komplexen Flugmanövern, wie dem sogenannten „Split-S“, deutliche Geschwindigkeitsvorteile erzielte. Dies ist vermutlich darauf zurückzuführen, dass das KI-System die Flugbahn über längere Zeiträume optimal plant, während menschliche Piloten meist nur den nächsten Schritt im Blick haben. Auch bei der Reaktionszeit profitierte Swift von strukturellen Vorteilen der KI.

Der Systemlatenz betrug nur etwa 40 Millisekunden, verglichen mit durchschnittlich 220 Millisekunden bei den Experten. Gleichzeitig nutzte Swift inertiale Messdaten als zusätzliche Informationsquelle, einem Sinnesorgan ähnlich dem vestibulären System des Menschen, das Piloten aufgrund der getrennten Körperposition fehlt. Trotz dieser Vorteile zeigt Swift im Umgang mit Umgebungsveränderungen und nach Abstürzen Schwächen. Menschen können aufgrund jahrzehntelanger Erfahrung dynamisch auf wechselnde Lichtverhältnisse und Beschädigungen reagieren, während Swift bisher nur in stabilen, bekannten Umgebungen zuverlässig agiert. Dieses Defizit kann aber zukünftig durch robustes Training mit vielfältigen Daten verbessert werden.

Das Swift-Projekt markiert einen bedeutenden Schritt in der autonomen mobilen Robotik und legt den Grundstein für zahlreiche Anwendungen außerhalb des Drohnenrennsports. Die Kombination von lernbasierter Wahrnehmung, empirischer Modellierung und leistungsfähigem Deep Reinforcement Learning erwies sich als Schlüssel für Wettbewerbsfähigkeit in einem anspruchsvollen, dynamischen Realweltumfeld. Diese Forschung eröffnet vielfältige Perspektiven für weitere physische Systeme, darunter autonome Fahrzeuginfrastrukturen, persönliche Robotikanwendungen sowie andere Flug- und Fahrroboter, bei denen Echtzeitreaktionen bei hoher Präzision und Geschwindigkeit verlangt sind. Neben sportlichen Herausforderungen können solche hybriden Lern-basierenden Steuerungssysteme zu effizienteren, widerstandsfähigeren und sichereren autonomen Mobilitätssystemen beitragen. Zukünftige Arbeit wird sich auf die Verbesserung der Wahrnehmungsrobustheit und die Entwicklung von Crash-Erholungsstrategien konzentrieren, um die Autonomie weiter zu steigern.

Auch der Einsatz von KI als Trainings- und Analysewerkzeug für menschliche Piloten bietet spannende Möglichkeiten, die Grenzen des Möglichen im Luftsport oder in industriellen Anwendungen zu erweitern. Insgesamt beweist Swift eindrucksvoll, dass Deep Reinforcement Learning nicht nur theoretisch in simulierten Umgebungen Spitzenleistungen erzielen kann, sondern bei entsprechender Integration und Feinabstimmung auch reale physische Herausforderungen meistern kann. Die Zeiten, in denen autonome Systeme nur assistierend tätig sind, sind vorbei – heute konkurrieren sie direkt auf Weltmeisterniveau mit den Besten ihres Fachs.