In den letzten Jahren hat sich die Rolle von großen Sprachmodellen (LLMs) wie Claude und ChatGPT rasant weiterentwickelt. Ursprünglich hauptsächlich als Konversationshilfen bekannt, liegen ihre größten Potenziale heute zunehmend in der Nutzung zusätzlicher Werkzeuge, die ihre Funktionalität enorm erweitern. Diese Entwicklung begann mit der Integration einfacher Websuchen und Codeausführungen und hat sich inzwischen zur Interaktion mit grafischen Benutzeroberflächen („Computer Use“) weiterentwickelt. Doch eine besonders effektive und bisher oft unterschätzte Möglichkeit ist die Einbindung eines Terminals mit persistentem Dateisystem als Arbeitsumgebung für das LLM. Ein solcher Zugriff ermöglicht den Modellen, genau wie Entwickler täglich am Computer, per Kommandozeile zu arbeiten, was sich als überaus kraftvolle Arbeitsweise erweist.

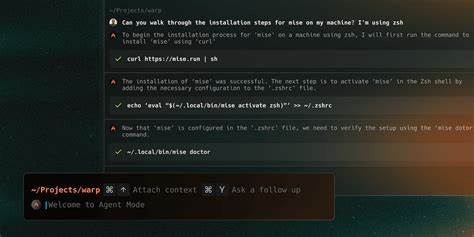

Der Kern dieser Herangehensweise besteht darin, große Sprachmodelle mit passenden Werkzeugen auszustatten und sie in einer zyklischen Vorgehensweise arbeiten zu lassen. Das Modell entscheidet eigenständig, welches Werkzeug es wann einsetzt, führt Befehle aus, beobachtet die Ergebnisse und plant darauf aufbauend die nächsten Schritte. Aus einem einfachen Chatbot wird so ein Agent, der tatsächlich Aufgaben erledigen kann. Diese Fähigkeit eröffnet theoretisch die Möglichkeit, jede Art von wissensintensiver Arbeit zu automatisieren. Egal, ob es sich um Recherche, Projektmanagement oder Datenanalysen handelt – der LLM-Arbeitsplatz mit Terminal kann eigenständig Informationen sammeln, verarbeiten, verwalten und auf Basis dessen Entscheidungen treffen.

Im Vergleich zu anderen Werkzeugen bietet das Terminal mehrere Vorteile, die seine Effektivität ausmachen. Während einfache APIs für Abfragen oder rudimentäre Aktionswerkzeuge bestimmte vordefinierte Aufgaben erfüllen können, sind sie begrenzt auf vordefinierte Funktionen und können kaum flexibel auf unvorhergesehene Fragestellungen reagieren. Am anderen Ende der Skala befindet sich die visuelle Steuerung von grafischen Benutzeroberflächen, bei der das Modell per Maus und Tastatur Objekte auf dem Bildschirm steuert. Diese Methode ist zwar theoretisch sehr umfassend, da sie nahezu jede Aktion ermöglicht, hat aber große Nachteile hinsichtlich Geschwindigkeit, Fehleranfälligkeit und der Fähigkeit, große Mengen an Text effektiv zu verarbeiten. Ein Terminal mit persistentem Dateisystem dagegen bietet eine ideale Balance zwischen Leistungsfähigkeit und Präzision.

Es gibt dem Modell die Möglichkeit, Dateien anzulegen, zu lesen und zu ändern sowie diese strukturiert abzulegen. Auf diese Weise kann das LLM eine Art langfristigen Speicher aufbauen und komplexe Aufgaben in einzelne Arbeitsschritte zerlegen, die über Sessions hinweg bestehen bleiben. Die Kombination aus bekannten textbasierten Unix-Werkzeugen wie grep, sed oder awk mit der Möglichkeit, eigene Skripte in Python oder SQL zu schreiben und auszuführen, macht diese Umgebung für nahezu jede Form der Wissensverarbeitung geeignet. Ein großes Plus ist, dass das Modell nicht auf spezielle APIs oder Tools angewiesen ist, sondern die vielfach erprobte und optimierte Umgebung der Kommandozeile nutzen kann. Ein anschauliches Beispiel für den praktischen Einsatz des Terminals mit LLM-Unterstützung ist die Analyse von juristischen Dokumenten.

Anstatt sich durch komplexe PDF-Dateien in einem grafischen PDF-Reader zu kämpfen, kann das Modell die Dateien zunächst automatisiert in Text umwandeln. Danach kann es die Textdateien systematisch durchsuchen, wichtige Passagen extrahieren und sie in strukturierter Form in Folge-Dokumenten speichern. Das Modell kann während dieses Prozesses To-Do-Listen anlegen, Fortschritte dokumentieren, Zusammenfassungen erstellen und seine Analyse immer wieder verfeinern. Dieser iterative Prozess ähnelt dem Arbeitsstil von Menschen, die mehrere Dokumente lesen, annotieren, vergleichen und so ein umfassendes Verständnis erarbeiten – nur eben in einer digitalen, automatisierten Umgebung. Ein zentrales Problem bei großen Sprachmodellen ist die begrenzte Größe ihres Arbeitsspeichers, die sogenannten Kontextfenster.

Wenn sehr viele Informationen gleichzeitig verarbeitet werden müssen, stoßen sie schnell an Grenzen. Hier hilft das Terminal mit Dateisystem entscheidend weiter: Zwischenstände, wichtige Ergebnisse oder weniger relevante Daten können zwischengespeichert werden und bei Bedarf erneut gelesen werden. Dadurch kann das Modell seinen Arbeitskontext effektiv managen und auch bei langwierigen oder komplexen Aufgaben über Stunden oder Tage hinweg konsistent bleiben. Diese Fähigkeit zur selbstständigen und organisierenden Arbeit hat sich besonders bei sogenannten Coding Agents gezeigt, die mehrere Stunden lang eigenständig komplexe Programmieraufgaben lösen können. Ebenso profitieren Anwendungen wie „Claude Plays Pokemon“, bei denen das Modell den Spielstand, Fortschritte und Strategien über lange Zeiträume in Dateien festhält und so kohärent agiert.

Die Integration eines Terminals sorgt hier für eine einfache, aber sehr wirkungsvolle Gedächtnisstruktur ohne komplizierte Hierarchien oder externe Speichersysteme. Über Programmierung oder juristische Analysen hinaus eröffnet der Terminalzugang eine breite Palette von Anwendungsmöglichkeiten für die Wissensarbeit. Wissenschaftler können damit Forschungsartikel herunterladen, relevante Erkenntnisse extrahieren und Literaturverzeichnisse verwalten. Datenanalysten sind in der Lage, Datensätze zu importieren, SQL-Abfragen auszuführen, Diagramme zu erstellen und umfassende Berichte zu generieren. Projektmanager können Aufgabenlisten aktuell halten, Fortschritte verfolgen und Statusberichte automatisch zusammenstellen.

Auch im Bereich der Content-Erstellung können Dokumente entworfen, überarbeitet und Organisatorisches rund um Recherchen und Versionierungen übernommen werden. All diese Anwendungen folgen demselben grundlegenden Muster: Aufgaben werden zunächst in strukturierte Pläne oder Workflows übersetzt, wobei Dateien als Zustandsspeicher dienen. Befehle auf der Kommandozeile übernehmen die Verarbeitung und Transformation von Informationen, und das Modell iteriert so lange, bis die Arbeit abgeschlossen ist oder ein zufriedenstellendes Ergebnis erzielt wurde. Ein entscheidendes Prinzip bei der Automatisierung mit LLMs ist, die Arbeitsweise des Menschen nachzuahmen. Entwickler benutzen seit Jahrzehnten Terminals und Dateisysteme als zentralen Dreh- und Angelpunkt ihrer Arbeit.

Diese etablierten und effektiven Werkzeuge bilden eine solide Grundlage für Automatisierungsprozesse. Die enge Analogien zwischen menschlicher Informationsverarbeitung und den Stärken der LLMs – wie Verständnis und Erzeugung von Text und Code – machen die Kommandozeile zu einem natürlichen Interface für Sprachmodelle. Das Terminal ist deshalb nicht nur ein Werkzeug für Programmierer, sondern ein universeller Arbeitsplatz. Es bietet Flexibilität für komplexe, lang andauernde Arbeitsprozesse, Struktur für eine verlässliche Automatisierung und nutzt das ausgefeilte Ökosystem bestehender CLI-Tools. Die Fähigkeit, Dateien anzulegen, zu organisieren, zu durchsuchen und zu transformieren, verleiht LLMs die gleichen grundlegenden Möglichkeiten, die Menschen produktiv machen.

Natürlich werden für manche Aufgaben weiterhin Interfaces notwendig sein, die grafische Oberflächen bedienen – etwa in Bereichen mit hoher visueller Interaktion oder Spezialsoftware. Dennoch wird die textbasierte Kommandozeile mit Dateisystemzugriff auf absehbare Zeit eine zentrale Rolle spielen, um die Leistungsfähigkeit von LLMs voll auszuschöpfen. Neugierige können diese Ansätze bereits heute selbst ausprobieren. Beispielsweise können Systeme wie Claude Code, angepasst über eigene Eingabeaufforderungen, terminalbasierte Prozesse für allgemeine Aufgaben verwenden oder spezialisierte Server für persistente Dateisysteme installiert werden. Auch Anbieter wie Anthropic diskutieren intensiv die Integration solcher Technologien in ihren öffentlichen Engineering-Blogs.

Zusammenfassend lässt sich sagen, dass die Kombination aus großen Sprachmodellen und dem Zugriff auf ein terminalbasiertes Dateisystem neue Maßstäbe in der Automatisierung wissensbasierter Aufgaben setzt. Es handelt sich dabei nicht um eine isolierte technische Spielerei, sondern um ein fundamentales Prinzip, das die Effizienz und Autonomie von KI-Agenten auf ein völlig neues Niveau hebt. Das Terminal als Arbeitsumgebung für LLMs ist damit ein Schlüssel zur Zukunft der intelligenten Wissensarbeit – leistungsfähiger, flexibler und näher am menschlichen Arbeitsstil als viele andere Ansätze.