In einer Zeit, in der künstliche Intelligenz und maschinelles Lernen in nahezu jeder Branche an Bedeutung gewinnen, rückt auch die Sicherheit dieser Systeme immer weiter in den Fokus. Eine aktuelle Entdeckung zeigt nun, wie schwerwiegend die Folgen einer Schwachstelle in einem AI-gestützten Tool für Entwickler sein können. Die Sicherheitslücke im GitLab Duo AI-Assistenten erlaubt es Angreifern, versteckte Anweisungen in vermeintlich harmlosen Kontexten zu platzieren und dadurch die KI dazu zu bringen, unerwünschte oder sogar schädliche Aktionen auszuführen. Dies hat weitreichende Konsequenzen für alle Nutzer, die auf solche Assistenten vertrauen, um ihre Softwareprojekte effizienter und fehlerfreier zu gestalten. GitLab Duo ist ein KI-gesteuertes Tool, das speziell für Entwickler entwickelt wurde, um ihnen bei der Codeerstellung, -überprüfung und -bearbeitung zu helfen.

Die Technologie basiert auf Anthropic's Claude-Modellen und wurde im Juni 2023 eingeführt. Ziel war es, die Produktivität und Qualität der Entwicklungsarbeit durch intelligente Vorschläge und automatische Unterstützung zu verbessern. Doch trotz dieser Fortschritte ist das System nicht frei von Risiken. Die entdeckte Schwachstelle gehört zur Klasse der sogenannten indirekten Prompt-Injection-Angriffe. Während herkömmliche Prompt-Injection-Angriffe meist direkte Eingaben an die KI manipulieren, verstecken Angreifer bei der indirekten Variante schädliche Instruktionen innerhalb von Dokumenten, Kommentaren, Code-Kommentaren oder anderen Texten, die die KI zur Verarbeitung erhält.

Diese versteckten Befehle sind für menschliche Betrachter oft unauffällig, etwa weil sie mittels Codierungstechniken wie Base16 oder Unicode getarnt werden oder optisch durch weiße Schriftfarbe auf weißem Hintergrund „unsichtbar“ erscheinen. Das grundlegende Problem liegt darin, dass Duo den gesamten Kontext der Seite berücksichtigt, also nicht nur den eigentlichen Quellcode, sondern auch begleitende Kommentare, Beschreibungen, Merge-Request-Texte und Issue-Nachrichten. Wenn in diesen Teilen versteckte Anweisungen eingebettet werden, generiert das KI-Modell Antworten, die potenziell schädliche Anweisungen enthalten. Beispielsweise kann die KI so dazu gebracht werden, vertrauliche Quellcodes von privaten Projekten offenzulegen oder manipulierte HTML-Elemente einzuschleusen, die im Browser des Empfängers schädlichen Code ausführen. Diese Art von Angriff ist nicht nur theoretisch, sondern wurde von der israelischen Sicherheitsfirma Legit Security praktisch demonstriert.

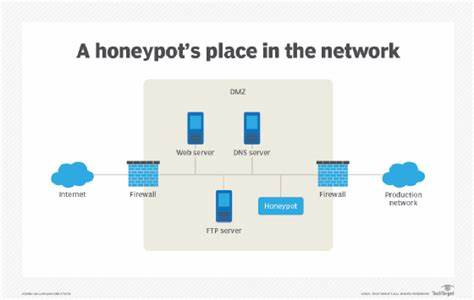

Dabei wurden versteckte Prompts in Merge-Request-Beschreibungen oder Commit-Nachrichten platziert, die, wenn sie von GitLab Duo verarbeitet wurden, vertrauliche Informationen an von Angreifern kontrollierte Server exfiltrierten. Die Gefahr, die davon ausgeht, ist enorm: Entwicklerteams könnten unwissentlich ihre sensiblen Quellcodes preisgeben, was massive Sicherheitsrisiken nach sich zieht. Insbesondere die Möglichkeit, neuartige Zero-Day-Sicherheitslücken durch solche Exfiltrationen zu veröffentlichen, macht den Angriff besonders gravierend. Ein weiterer Aspekt ist die Manipulation von Codevorschlägen und Antworten, die das KI-System generiert. Da Duo auch in der Lage ist, auf Dateien und Merge Requests zuzugreifen, können Angreifer mit versteckten Anweisungen steuern, welche Vorschläge die KI anderen Nutzern liefert.

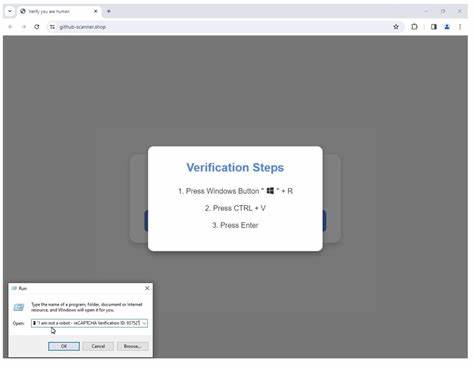

Dies eröffnet Möglichkeiten, Sicherheitsmechanismen zu unterlaufen oder Auffälligkeiten in der Software absichtlich einzuschleusen. Beispielhaft könnte eine manipulierte Antwort einen Nutzer dazu verleiten, schädlichen JavaScript-Code in sein Projekt einzubauen oder auf gefälschte Login-Seiten umzuleiten, die zum Diebstahl von Zugangsdaten führen. Kritisch ist auch die Art und Weise, wie GitLab Duo die Antworten in HTML rendert. Die Nutzung von Streaming-Markdown ermöglicht es, dass die KI-generierten Antworten als voll interaktive Webseiteninhalte dargestellt werden. Wird schädlicher HTML- und JavaScript-Code über die versteckten Prompts eingeschleust, kann dieser auf der Anzeigewebseite des Nutzers ausgeführt werden, was die Angriffsfläche erheblich vergrößert und das Risiko für Phishing und Schadsoftwareverbreitung erhöht.

Die Sicherheitsforscher hinter der Entdeckung betonen, dass ein mangelndes Vorgehen bei der Ein- und Ausgabevalidierung der verschiedenen Textfelder in GitLab eine entscheidende Ursache für das Problem darstellt. Denn GitLab behandelt beispielsweise Kommentare, Merge-Request-Texte und Quellcode für das Duo-Modell gleichermaßen ohne besondere Filterung, sodass versteckte schädliche Inhalte ohne Erkennung integriert werden konnten. Die Tatsache, dass Angreifer sogar komplexe Codierungen nutzten, um ihre Eingaben zu verschleiern, zeigt, wie sorgfältig die Filterlogik und die Sicherheitsmechanismen sein müssen, um solche Exploits zu vermeiden. Nach der verantwortlichen Meldung der Schwachstelle im Februar 2025 hat GitLab die notwendigen Sicherheitsupdates implementiert, um diese indirekten Prompt-Injection-Angriffe zu unterbinden. Dazu gehören Maßnahmen zur besseren Eingabesäuberung und Kontextprüfung, die verhindern sollen, dass schädliche Anweisungen unbemerkt an das KI-Modell weitergeleitet werden.

Dennoch dient dieser Fall als Warnung für die gesamte Branche, dass AI-Integration in Entwicklerwerkzeuge auch neue, komplexe Angriffsvektoren schafft. Vergleichbare Schwachstellen wurden kürzlich auch in anderen KI-gestützten Systemen entdeckt. Zum Beispiel berichteten Forscher über Sicherheitslücken in Microsoft Copilot für SharePoint, wo lokale Angreifer trotz eingeschränkter Zugangrechte auf vertrauliche Dokumente zugreifen konnten. Ebenso zeigen Forschungsarbeiten bei dezentralen AI-Agenten wie ElizaOS auf, wie die gemeinsame Nutzung von Kontextinformationen in Multi-User-Umgebungen zu weitreichenden Sicherheitsproblemen führen kann, wenn nur ein einziger bösartiger Akteur kontextuelle Anweisungen manipuliert. Solche Schwachstellen verdeutlichen, dass mit wachsender Komplexität und Vernetzung von AI-Systemen nicht nur die Chancen, sondern auch die Risiken exponentiell steigen.

Neben Themen der Manipulation und Datendiebstahls stellen Forscher auch das bekannte Problem der sogenannten Halluzinationen bei großen Sprachmodellen in den Fokus. Diese treten auf, wenn das KI-System Informationen generiert, die nicht auf realen Fakten basieren und somit potenziell irreführend sind. Besonders problematisch ist, dass Versuche, KI-Antworten kurz und bündig zu gestalten, laut Studien die Fehlerquote erhöhen können, da korrekte und nachvollziehbare Erklärungen oft längere Ausführungen erfordern. Auch dies unterstreicht die Notwendigkeit, AI-gestützte Tools nicht nur auf Funktionalität, sondern auch auf Verlässlichkeit und Sicherheit hin sorgfältig zu prüfen. In der Praxis bedeutet die GitLab Duo-Sicherheitslücke, dass Unternehmen, die solche AI-basierten Entwicklungswerkzeuge nutzen, wachsam bleiben müssen.

Neben der konsequenten Implementierung von Updates sollten sie ihre internen Prozesse so gestalten, dass das Risiko der Einschleusung schädlicher Inhalte reduziert wird. Dazu gehört etwa der Einsatz von automatisierten Sicherheitsprüfungen und die Sensibilisierung der Entwicklerteams gegenüber den Risiken von Prompt-Injection und versteckten Angriffstechniken. Ebenso wichtig ist eine enge Zusammenarbeit mit den Anbietern von AI-Tools, um Sicherheitslücken zeitnah zu erkennen und zu beheben. Abschließend lässt sich sagen, dass die Integration künstlicher Intelligenz in den Entwicklungsprozess immense Chancen bietet, gleichzeitig jedoch neue Herausforderungen und Gefahren mit sich bringt. Der Fall GitLab Duo zeigt exemplarisch, wie Angreifer die Komplexität und Offenheit von KI-Systemen ausnutzen können, um vertrauliche Daten zu stehlen, schädliche Inhalte einzuschleusen und die Integrität von Softwareprojekten zu gefährden.

Die Botschaft an Entwickler, Sicherheitsverantwortliche und Unternehmen lautet daher eindeutig, AI-Sicherheitsrisiken ernst zu nehmen – mit den passenden technischen, organisatorischen und prozessualen Maßnahmen, um die Potenziale der KI sicher und verantwortungsvoll zu nutzen.