In den letzten Jahren hat die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) die Art und Weise verändert, wie wir Wissen verarbeiten und nutzen – auch in wissenschaftlichen Disziplinen wie der Chemie. Durch die Fähigkeit, natürliche Sprache zu verstehen und auf komplexe Fragestellungen zu antworten, eröffnen LLMs neue Möglichkeiten für den wissenschaftlichen Fortschritt. Doch wie gut sind diese Modelle tatsächlich im Vergleich zu erfahrenen Chemikerinnen und Chemikern? Und welche Chancen und Herausforderungen ergeben sich daraus für Forschung, Lehre und Praxis? Große Sprachmodelle wie GPT-4, Claude-3.5 oder spezialisierte Systeme wie Galactica werden aufgrund ihrer Fähigkeit, enorme Textmengen zu verarbeiten und komplexe Zusammenhänge zu erfassen, zunehmend in der Chemie eingesetzt. Sie können nicht nur Fragen beantworten, sondern sogar chemische Reaktionen vorschlagen, Moleküle entwerfen und Daten aus wissenschaftlichen Publikationen extrahieren.

Dabei zeigt sich: Einige Modelle übertreffen in bestimmten Bereichen die Leistungsfähigkeit von erfahrenen Fachleuten. Die Grundlage für einen fairen Vergleich bildet ein eigens entwickeltes Evaluationssystem namens ChemBench. Dabei handelt es sich um einen umfassenden Benchmark mit fast 2800 Frage-Antwort-Paaren, die verschiedenste Bereiche der Chemie abdecken, von Grundlagen bis zu Spezialgebieten wie anorganischer oder technischer Chemie. Die Fragen werden nach unterschiedlichen Fähigkeiten wie Wissen, Berechnung, logischem Denken und Intuition kategorisiert und bieten so eine vielfältige Testumgebung. Ein Teil davon lässt sich automatisch auswerten, während ein anderer offener gestaltet ist, um freiere Antworten zu ermöglichen.

Erwähnenswert ist, dass die Tests nicht nur klassische Multiple-Choice-Aufgaben beinhalten, die in der Chemieausbildung häufig genutzt werden, sondern auch offene Fragen, die komplexeres Denken erfordern. Die Einbeziehung solcher Fragen ist wichtig, da reines auswendig Lernen heutzutage durch leistungsfähige Sprachmodelle leicht übertroffen wird. Viele Modelle sind bereits in der Lage, einfache Wissensfragen besser zu beantworten als durchschnittliche Chemiker mit akademischem Hintergrund. Die Evaluierung mit ChemBench offenbarte zahlreiche interessante Ergebnisse. Das beste Sprachmodell im Test, genannt o1-preview, erzielte fast doppelt so viele richtige Antworten wie der beste menschliche Teilnehmer im Vergleich.

Auch andere Modelle, inklusive einiger Open-Source-Varianten wie Llama-3.1, erzielten Ergebnisse, die in Teilen mit privaten, proprietären Systemen konkurrieren konnten. Dieses Leistungsniveau ist keineswegs trivial und zeigt, wie weit die Technologie bereits gediehen ist. Dennoch sind diese Erfolge nicht uneingeschränkt. Trotz der starken Leistung bei vielen Kenntnisfragen und technischen Themen gibt es dennoch Bereiche, in denen die Modelle deutlich hinter den Menschen zurückbleiben.

Dann, wenn zum Beispiel tiefere chemische Intuition oder komplexe strukturelle Analysen gefragt sind, etwa bei der Vorhersage von Anzahl und Art von Signalen in der Kernspinresonanz (NMR) oder bei der Erkennung molekularer Symmetrien, fallen die Modelle zurück. Hier fehlt ihnen offenbar ein wirkliches Verständnis für die dreidimensionale Struktur von Molekülen, die für Chemiker selbstverständlich ist. Ein weiteres Problem ist die Überschätzung der eigenen Fähigkeiten seitens der LLMs. Trotz zahlreicher Bemühungen, die Zuverlässigkeit der Modelle einzuschätzen, zeigen sich in den meisten Fällen unzulänglich kalibrierte Sicherheitsmechanismen. Modelle geben oft sehr selbstsicher Antworten ab, auch wenn diese falsch sind.

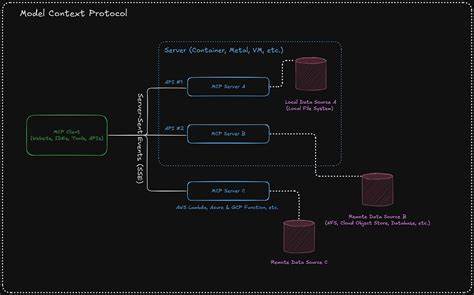

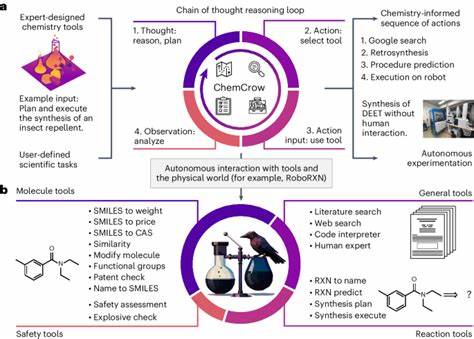

Dies ist besonders problematisch bei Sicherheitsfragen oder bei der Bewertung toxischer Substanzen, bei denen falsche Empfehlungen ernsthafte Folgen haben könnten. Interessant ist zudem die Erkenntnis, dass gute Leistungen in standardisierten Prüfungsfragen nicht automatisch bedeuten, dass die Modelle auch in realistischen, praxisnahen oder komplexeren Szenarien überzeugen. Textbuchhafte Fragestellungen sind weitgehend vorhersehbar und oft in Trainingsdaten enthalten, während innovative oder seltene Fragestellungen, die kritisches Denken und Vernetzung von Wissen erfordern, ein größeres Problem darstellen. Die Nutzung von externen Hilfsmitteln ist ebenfalls ein Kriterium, das die Zukunft solcher Systeme prägen wird. Während menschliche Chemiker webbasierte Werkzeuge, Datenbanken und chemische Zeichenprogramme verwenden können, sind LLMs darauf angewiesen, ob und wie solche Hilfen integrierbar sind.

Systeme wie PaperQA2 versuchen dies, indem sie Zugriff auf wissenschaftliche Literatur erhalten, aber der direkte Zugriff auf spezialisierte Datenbanken wie PubChem oder GESTIS könnte noch deutlich bessere Ergebnisse ermöglichen. Neben reinem Wissensabruf und logischem Schlussfolgern ist das Thema der 'chemischen Präferenz' oder Intuition von großem Interesse. In der Praxis entscheiden Chemiker oft basierend auf Bauchgefühl oder Erfahrung, welches Molekül im Forschungsprozess vielversprechender ist. Aktuelle Modelle scheitern jedoch daran, diese subtilen Präferenzen nachzuvollziehen oder vorherzusagen. Das bedeutet, die Entwicklung von Methoden zur besseren Ausrichtung der KI auf menschliche Entscheidungen bleibt ein offenes Forschungsfeld.

Das Forschungsprojekt und die Entwicklung von ChemBench sind zudem wichtige Meilensteine für die Gemeinschaft, weil sie einen standardisierten Maßstab schaffen, der es erlaubt, Fortschritte bei Chemie-bezogenen LLMs transparent und vergleichbar zu machen. Dies ist entscheidend, um Vertrauen in KI-gestützte Systeme aufzubauen und sie effektiv in Lehre und Forschung einzusetzen. Eine der Erkenntnisse aus dem Vergleich von menschlicher Expertise und KI ist die Notwendigkeit, die Chemieausbildung neu zu denken. Während das reine Faktenwissen zunehmend von LLMs übernommen wird, bleibt die Fähigkeit, kritisch zu denken, komplexe Probleme zu lüften und Unsicherheiten richtig einzuschätzen, unverzichtbar. Lehrpläne sollten entsprechend angepasst werden, um den Fokus stärker auf das Interpretieren von Ergebnissen, kreative Problemlösung und ethische Bewertung zu legen.

Ein weiterer wichtiger Aspekt betrifft die Sicherheit und verantwortungsvolle Nutzung dieser Technologie. Da Sprachmodelle auch für Laien zugänglich sind, besteht das Risiko von Missverständnissen, insbesondere im Umgang mit gesundheits- oder sicherheitsrelevanten Inhalten. Falschinformationen über chemische Gefahren oder Toxizität können gefährlich sein. Deshalb sind robuste Schutzmechanismen und klare Hinweise auf Unsicherheiten zwingend erforderlich. Aus technischer Sicht zeigt die Untersuchung, dass die Modellgröße und die Vielfalt der Trainingsdaten eine große Rolle spielen.

Größere Modelle neigen dazu, besser zu performen, allerdings steigt auch der Rechenaufwand sowie der Preis für den Betrieb erheblich. Zudem versprechen die Autoren von ChemBench, dass eine Einbindung spezialisierter Datenbanken und chemiespezifischer Werkzeuge die Resultate weiter verbessern kann. In der Zukunft wird erwartet, dass LLMs in der Chemie nicht nur als einfache Frage-Antwort-Systeme agieren, sondern als verstärkte Assistenten oder sogenannte 'Copiloten', die den Forschenden bei der Informationsbeschaffung, Hypothesengenerierung, experimentellen Planung und Dokumentation helfen. Die enge Verzahnung von KI und menschlicher Kompetenz kann den Innovationszyklus erheblich beschleunigen. Insgesamt stellen große Sprachmodelle also keinen Ersatz für menschliche Chemiker dar, sondern vielmehr ein ergänzendes Werkzeug, das besondere Stärken in der Verarbeitung großer Informationsmengen mitbringt.

Die Grenzen der Modelle – vor allem beim tiefen Verständnis, bei der Handhabung von Sicherheitsfragen und bei der Einschätzung von Unsicherheiten – müssen aktiv adressiert werden, um die Nutzung sicher und effektiv zu gestalten. Die Entwicklung und Evaluierung von ChemBench ist ein entscheidender Schritt in diesem Prozess. Sie hilft dabei, die Fähigkeiten und Schwächen bestehender Systeme transparent zu machen und leitet die Wege für zukünftige Verbesserungen ein. Die Chemie steht an der Schwelle zu einer neuen Ära, in der Sprache, Daten und intelligente Algorithmen zusammenfließen, um Forschung und Ausbildung zu transformieren. Dabei bleibt die kritische Reflektion durch Experten unverzichtbar, um sowohl Potenziale zu nutzen als auch Risiken zu minimieren.

Zusammenfassend lässt sich sagen, dass große Sprachmodelle bereits das Niveau von menschlichen Experten in vielen Bereichen der Chemie erreichen oder übertreffen können. Gleichzeitig zeigen sich deutliche Defizite gerade in Bereichen, die tiefes Verständnis und Erfahrung erfordern. Die Zukunft der Chemie wird daher geprägt sein von einer symbiotischen Zusammenarbeit zwischen KI und menschlicher Expertise, bei der beide Seiten ihre Stärken einbringen und gemeinsam komplexe wissenschaftliche Herausforderungen bewältigen.

![Ceramic optical diamond turning machine: design and development 1999 [pdf]](/images/889EACD6-B5FE-43BF-A5B7-E605B82C905B)