Die Wahl der passenden Datenbanktechnologie ist für viele Unternehmen eine strategische Entscheidung, die maßgebliche Auswirkungen auf die Performance, Skalierbarkeit und Kosten der IT-Infrastruktur hat. Insbesondere wenn Anwendungen wachsen und komplexer werden, stehen Unternehmen vor der Herausforderung, ihre Datenbanken zu migrieren, um langfristig wirtschaftlich und technisch effizient zu bleiben. Ein aktuell viel diskutiertes Thema ist die Migration von verteilten Datenbanksystemen wie CockroachDB hin zu klassischen SQL-Datenbanken wie PostgreSQL. Der folgende Text bietet eine praxisorientierte Einsicht in einen solchen Migrationsprozess, beleuchtet Herausforderungen, Performanceunterschiede und strategische Überlegungen. Dabei stützt sich die Darstellung auf konkrete Erfahrungen eines Unternehmens, welches diese Migration erfolgreich durchgeführt hat und somit wertvolle Erkenntnisse teilen kann.

Zu Beginn des Migrationsprozesses stand bei dem betrachteten Unternehmen die Nutzung von CockroachDB, einer verteilten SQL-Datenbank, die sich durch einfache horizontale Skalierbarkeit, hohe Verfügbarkeit und Unterstützung für Multi-Region-Setups auszeichnet. Gerade im Hinblick auf Datenschutzstandards wie die Datenschutz-Grundverordnung (DSGVO) erschien eine verteilte Architektur für geplante globale und multi-regionale Deployments attraktiv. Gleichzeitig war die Datenbank mit einer ORM (Object-Relational Mapping) Technik angebunden, die vergleichsweise einfach verschiedene Datenbanksysteme ansteuern konnte. Mit zunehmender Unternehmensgröße und wachsendem Datenvolumen zeigten sich jedoch erste Schwachstellen. Die laufenden Kosten für CockroachDB sind erheblich gestiegen und erreichten nach etwa zwei Jahren einen fünfmal höheren Betrag als zuvor, was im mittleren sechsstelligen Bereich lag.

Zudem gab es noch keine Anforderungen seitens der Kunden, die eine Datenlokalisierung oder Multi-Region-Szenarien erforderlich gemacht hätten. Somit stellte sich die Frage, ob die komplexe verteilte Datenbank den hohen Preis unter den existierenden Nutzungsbedingungen rechtfertigte. Ein zentraler, praktischer Knackpunkt waren die Migrationsprozesse innerhalb von CockroachDB. Bei wachsender Datenbasis kam es häufig zu Timeouts beim Ausführen von Datenbankmigrationen über das Prisma ORM. Diese Migrationen, zum Beispiel das Hinzufügen neuer Spalten, führten zu blockierenden Phasen bei Deployments, die bis zu zwei Stunden dauerten.

Entwicklern blieb oft nichts anderes übrig, als manuell Migrationen direkt auf der Datenbank auszuführen, was den automatisierten Workflow erheblich störte. Im direkten Vergleich zur Migration auf PostgreSQL zeigte sich ein deutlicher Unterschied. Tests mit ähnlich großen Datenbeständen ergaben, dass das Einspielen von Migrationen in PostgreSQL nur wenige Sekunden benötigte, was einen großartigen Zugewinn an Effizienz und Zuverlässigkeit bedeutete. Neben den Migrationen wirkten sich die Timeouts auch negativ auf die ETL-Prozesse (Extract, Transform, Load) aus. ETL-Prozesse sind für die Datenaufbereitung und -migration essenziell.

Das Unternehmen verwendete für diese Aufgaben Airbyte, ein Open-Source-Datenintegrationswerkzeug, welches allerdings im Kontext von CockroachDB nur eine Alpha-Version eines Connectors zur Verfügung stellte. Aufgrund von Speicherlecks und Instabilitäten kam es oft zu Ausfällen oder besonders langen Laufzeiten, die den Betrieb weiterhin beeinträchtigten. Im Gegensatz dazu bietet das PostgreSQL-Ökosystem eine größere Auswahl an ausgereiften ETL-Tools und Datenintegrationslösungen, die zuverlässig und performant arbeiten. Ein weiterer wichtiger Aspekt betrifft Abfragegeschwindigkeiten. Während CockroachDB durch seinen ausgefeilten Abfrageoptimierer in bestimmten Einzelfällen geringfügig bessere Ergebnisse erzielte, zeigten die meisten realen Abfragen, die mittels Prisma ORM generiert wurden, deutliche Vorteile von PostgreSQL.

Die SQL-Statements waren häufig durch viele Joins und verschachtelte Bedingungen besonders komplex und wurden von CockroachDB oft mit vollem Tabellenscan beantwortet, was zu bis zu zwanzigfach höheren Latenzzeiten im Vergleich zu PostgreSQL führte. PostgreSQL dagegen konnte dank seiner bewährten Optimierungsstrategien und Indizierung die Performance deutlich verbessern, was sich unmittelbar in einer spürbaren Beschleunigung von Anwendungen niederschlug. Neben technischen Aspekten gab es auch Herausforderungen auf der Nutzer- und Supportseite. Die Nutzererfahrung mit CockroachDB war aufgrund eingeschränkter Möglichkeiten, beispielsweise das Abbrechen langer Queries, sowie einer schwachen Indizierungsübersicht und umständlichem Supportprozess, oft frustrierend für Entwickler. Ein zusätzliches Problem stellten Netzwerkausfälle durch VPC- und VPN-Verbindungsprobleme dar, die sich über die gesamte Nutzungsdauer von CockroachDB immer wieder zeigten und auch in verschiedenen Umgebungen reproduzierbar waren.

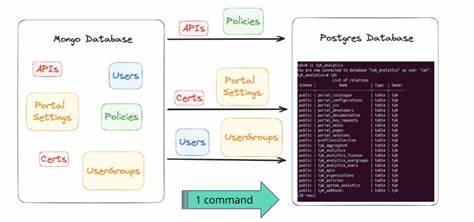

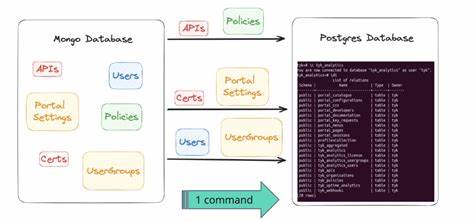

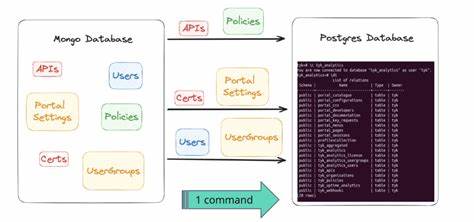

Diese Instabilitäten traten bei PostgreSQL nicht auf und erlaubten so einen deutlich stabileren Betrieb. Die eigentliche Migration eines umfangreichen Systems mit mehr als 100 Millionen Datensätzen war ausgeklügelt und erforderte individuelles Engineering. Aufgrund der fehlenden stabilen ETL-Tools für CockroachDB baute der verantwortliche Ingenieur ein eigenes Skript mit der JavaScript-Laufzeitumgebung Bun. Dieses Skript konnte den Datenbankschema-Zustand erfassen, Tabellendaten als CSV-Dateien ablegen und diese mittels parallel ausgeführter Prozesse in die PostgreSQL-Datenbank übertragen. Dabei wurde eine besondere Herausforderung sichtbar: Unterschiede in der Byte-Kodierung bei JSON- und Array-Datentypen zwischen den beiden Systemen erforderten eine speziell programmierte Transformation, um Datenintegrität sicherzustellen und Kompatibilität zu garantieren.

Am Abend der Umstellung wurde dann mit einem leistungsstarken virtuellen Cloud-Server der ganze Datenbestand in etwa 15 Minuten übertragen. Um das Risiko zu minimieren und einen stabilen Übergang zu gewährleisten, wurde die Produktivumgebung für gut eine Stunde in den Wartungsmodus versetzt. Im Ergebnis konnte die Migration ohne Datenverlust durchgeführt werden, was ein essenzieller Erfolg war. Nach der Umstellung ergaben sich unmittelbar weitere Vorteile. Durch die Nutzung des PostgreSQL-Ökosystems, insbesondere mit Tools wie PGAnalyze, konnten in kurzer Zeit auch eine Reihe von ineffizienten Abfragen identifiziert und verbessert werden.

Diese Nachjustierungen führten zu einer weiteren signifikanten Reduktion der Antwortzeiten und entlasteten die Infrastruktur nachhaltig. Wichtig war dabei, dass trotz konservativer Skalierung des PostgreSQL-Clusters die anfallenden Betriebskosten allein durch die technische Migration um mehr als 110.000 US-Dollar pro Jahr gesenkt werden konnten. Dabei ist zu erwähnen, dass durch weiteres Wachstum des Systems der Kostenvorteil noch stärker ausfallen wird. Dieses Praxisbeispiel verdeutlicht, dass die Entscheidung für eine Datenbankmigration nicht nur eine technische Herausforderung darstellt, sondern auch finanzielle, organisatorische und menschliche Faktoren berücksichtigt werden müssen.

Der Umstieg von hochverteilten Datenbanken wie CockroachDB zu bewährten, weniger komplexen Systemen wie PostgreSQL lohnt sich insbesondere dann, wenn keine zwingenden Anforderungen an Multi-Region-Deployments oder skalierbare Verfügbarkeit bestehen und sich die Workloads hauptsächlich im Bereich von einfachen Transaktionen und umfangreicher Abfrageoptimierung bewegen. Zusammenfassend zeigt die Migration zu PostgreSQL, dass durch eine wohlüberlegte Planung, den Einsatz geeigneter Werkzeuge und das Verständnis der systeminternen Unterschiede große Datenbestände ohne Datenverlust und mit minimaler Ausfallzeit erfolgreich migriert werden können. Die Performance-Verbesserungen und Kosteneinsparungen sprechen für sich, während die Stabilität und Entwicklerfreundlichkeit von PostgreSQL die tägliche Arbeit nachhaltig erleichtern. Unternehmen, die ähnliche Herausforderungen meistern wollen, sollten frühzeitig die individuelle Datenbankarchitektur genau analysieren, kritische Workloads identifizieren und Testmigrationen durchführen, um Last und Engpässe zu verstehen. Die Wahl eines kompatiblen ORMs und die frühzeitige Entwicklung zuverlässiger ETL-Skripte sind essenziell.

Wichtig ist auch, ausreichend Puffer für Ausfallzeiten einzuplanen und das Team für den Change vorzubereiten. PostgreSQL bleibt dank seiner bewährten Performance, breiten Tool-Unterstützung und aktiven Community eine der attraktivsten Optionen für Unternehmen mit wachsenden Datenanforderungen. Gerade in Zeiten, in denen Kostenoptimierung und Performance unverzichtbar sind, können solche Migrationen ein zentraler Erfolgsfaktor für nachhaltiges Wachstum und technologische Wettbewerbsfähigkeit sein.