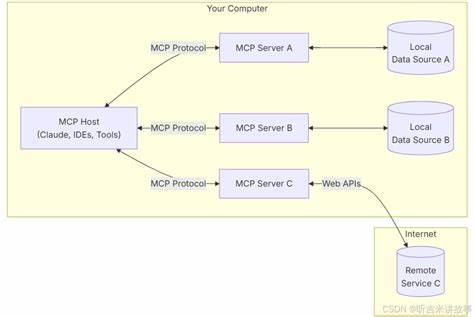

Das Internet hat seit seiner Entstehung stetige Veränderungen erfahren, doch der Wandel, der heute im Fokus steht, ist revolutionär. Während die klassische Webentwicklung eng an menschliche Nutzer mit Browsern, Tastaturen und Mäusen gebunden war, eröffnet das Zeitalter der Künstlichen Intelligenz eine völlig neue Perspektive. Große Sprachmodelle, sogenannte Large Language Models (LLMs), sind keine traditionellen Nutzer. Sie interagieren nicht mit Webseiten durch visuelles Rendering und Klicks, sondern benötigen eine maschinenlesbare, strukturierte Form des Internets – eine Art Hypertext, der über reine Optik hinausgeht und Inhalte als ausführbare Funktionen anbietet. Dabei spielt das Model Context Protocol (MCP) eine zentrale Rolle.

MCP ermöglicht es LLMs, direkt mit Werkzeugen in strukturierter JSON-Form zu interagieren, anstelle der üblichen HTML-Inhalte. So kann das LLM präzise Tools anfragen, Ergebnisse erhalten und sogar Werkzeuge hinzufügen oder entfernen. Dieses Konzept über die gesamte Weblandschaft hinauszudenken, führt zur Idee von Web 2.1 – einer evolutionären Stufe des Internets, in der Hypertext zu Hypertools wird. Die heutige Webentwicklung setzt überwiegend auf HTML, CSS und JavaScript, um Seiten für Menschen ansprechend darzustellen.

Dabei übermitteln Browser den Inhalt, der visuell aufbereitet wird. Für Maschinen bedeutet dies jedoch, dass die relevanten Informationen häufig schwer extrahierbar sind. Große Sprachmodelle könnten theoretisch die Rohdaten interpretieren, doch die verschachtelten Strukturen der DOM (Document Object Model), Stylesheets und dynamischen Skripte erhöhen die Komplexität enorm. Hinzu kommen SPAs (Single Page Applications) und PWAs (Progressive Web Apps), die zwar interaktive Nutzererlebnisse schaffen, aber weiterhin von einem menschzentrierten Paradigma ausgehen. Hier setzt die Idee an, das Internet zunächst als eine Maschine-first-Plattform zu denken, in welcher die Daten und Funktionen in klar definierten JSON-Schemata organisiert sind.

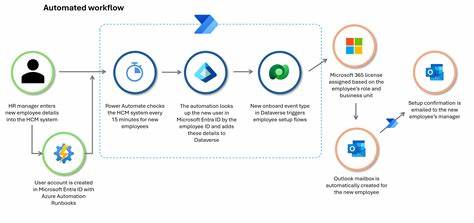

Der Wechsel weg von der HTML-basierten Struktur hin zu einem JSON-basierten Werkzeugkatalog revolutioniert die Internetnutzung durch LLMs. Statt einer verschachtelten Baumstruktur erhält das Modell eine Liste von aufrufbaren Tools, ergänzt um Parameter und Informationen zu deren Zweck und Funktion. Diese Werkzeugsammlungen ersetzen die traditionelle Seitenstruktur und eröffnen völlig neue Möglichkeiten der Navigation und Interaktion. Ein LLM ruft beispielsweise Werkzeuge zum Suchen von Benutzern, Erstellen von Beiträgen oder zur Navigation auf, und erhält als Antwort stets eine aktualisierte Liste verfügbarer Tools. Die kontinuierliche Anpassung dieser Liste macht Navigation zu einer Folge von Werkzeugaufrufen.

Im Kern bedeutet das eine Abkehr von der klassischen Seitenidee und stattdessen eine Transformation in eine Werkzeugumgebung, die sich dynamisch an die Bedürfnisse des Nutzers anpasst – oder in diesem Fall der KI. Dieses Modell bringt erhebliche Vorteile im Vergleich zu heutigen Ansätzen mit sich. Klassischerweise implementieren Websites eine riesige Anzahl von REST-APIs und Endpunkten, die selten explizit dokumentiert oder miteinander konsistent sind. Für ein großes Sprachmodell stellen diese unübersichtlichen und teilweise redundanten Schnittstellen eine enorme Fehlerquelle dar. Die Folge sind sogenannte Halluzinationen, bei denen das Modell versucht, Werkzeuge oder API-Endpunkte aufzurufen, die nicht existieren oder nicht für die aktuelle Nutzung relevant sind.

Im Web 2.1-Ansatz wird die Aktionsebene stark beschränkt. Je nach Kontext werden nur die tatsächlich sinnvollen Werkzeuge angeboten, sodass der Handlungsspielraum des Modells geschärft und die Fehlerrate signifikant reduziert wird. Die Navigation innerhalb von Web 2.1 ist im Vergleich zu herkömmlichen Webseiten radikal vereinfacht.

Herkömmliche Seiten laden bei jeder Navigation eine neue HTML-Datei oder manipulieren dynamisch den DOM, was für Maschinen oft schwer nachvollziehbar ist. Bei Web 2.1 erfolgt die Navigation durch den Wechsel der Werkzeuglisten. Jedes Mal, wenn ein Tool aufgerufen wird, erhält das Modell die neu auf den Kontext angepasste Toolliste zurück. Selbst die sogenannte Zurück-Funktion ist als Werkzeug implementiert, wodurch sie die historische Werkzeugliste wiederherstellt und somit ein nachvollziehbares Navigationsmodell schafft, das sich für die maschinelle Verarbeitung wesentlich besser eignet.

Ein wesentlicher Aspekt in dieser Neuerung ist, dass APIs, die Daten bereitstellen – wie Wetterabfragen, Preisangebote oder Grafikerzeugung – zu vollständig erklärbaren Funktionen werden. Sie liefern ihre Daten in anonymen JSON-Streams, die direkt in Konversationen integriert oder durch benutzerfreundliche Komponenten auf der Oberfläche visualisiert werden können. Da die Verträge zwischen Modell und Dienst explizit sind und sich in klaren JSON-Schemata ausdrücken, wird die Einhaltung von Richtlinien, Sicherheitsprüfungen und Compliance wesentlich erleichtert und weniger fehleranfällig. Auch im Hinblick auf Echtzeitdaten, Personalisierung und Interaktivität ergeben sich durch Web 2.1 neue Chancen.

Werkzeuge können kontextsensitiv aktiviert, deaktiviert oder dynamisch angepasst werden. Die ständige Kontrolle über den Werkzeugbestand ermöglicht eine präzise Steuerung der Anwendungsfälle und der Interaktionen ohne unnötige Ablenkung durch irrelevante Funktionen. Die neue Internetarchitektur zeigt vor allem eines: Das Versprechen des Hypertexts – also die Möglichkeit, Informationen und Interaktionen nahtlos, logisch und direkt miteinander zu verknüpfen – kann mit Web 2.1 und MCP neu gestaltet werden. Der Inhalt des Internets wird vergleichbar mit einer Bibliothek von Werkzeugen, die beim Aufruf eine neue Welt aus Funktionalitäten eröffnen und klar definierte Möglichkeiten bieten.

Dabei wird der Fokus von einer visuellen Präsentation auf Handlungskompetenz verlagert. Aus Sicht der Suchmaschinenoptimierung ergibt der Ansatz erhebliche Vorteile. Websites, die klare, strukturierte Schnittstellen für KI-Anwendungen anbieten, können nicht nur von LLMs effizient genutzt werden, sondern auch von Suchmaschinen besser interpretiert werden. Explizite JSON-Strukturen helfen dabei, die Inhalte und deren semantische Bedeutung zu erschließen, was für die zunehmende KI-basierte Analyse des Internets essenziell ist. Die Zukunft der Web-Entwicklung wird also nicht nur durch nutzerfreundliche Oberflächen, sondern vor allem durch maschinenverständliche und interoperable Strukturen bestimmt.

Wer heute auf Web 2.1 setzt, sichert sich einen Wettbewerbsvorteil im digitalen Zeitalter. Die Herausforderung liegt jedoch in der Umsetzung und der Akzeptanz. Bestehende Webseiten sind überwiegend auf traditionelle Technologien ausgerichtet, und ein Wandel hin zu einem vollständig toolbasierten Internet erfordert Umdenken bei Entwicklern, Firmen und Anbietern gleichermaßen. Zudem müssen Standards und Protokolle wie MCP weiterentwickelt und verbreitet werden, um die Grundlage für eine breite Nutzung zu schaffen.

Die Komplexität der heutigen Weblandschaft ist hoch, doch genau diese Komplexität macht eine maschinenlesbare und klar strukturierte Alternative so wertvoll. Abschließend lässt sich festhalten, dass das Internet mit Web 2.1 und MCP eine neue Stufe seiner Evolution erreicht. Die Konzentration auf ausführbare Funktionseinheiten statt auf visuelle Layouts schafft einen Mehrwert, der nicht nur die Effizienz von KI-Systemen verbessert, sondern auch neue Formen der Interaktion ermöglicht. Indem das Internet wieder hypertextueller wird – diesmal in Form von Hypertools – entsteht eine symbiotische Beziehung zwischen Mensch und Maschine, bei der die Stärken beider Seiten optimal genutzt werden.

Die Ära des Internet als bloße Oberfläche neigt sich dem Ende zu, und eine Ära der intelligenten, funktional orientierten Vernetzung beginnt.